Ensemble Learning

이미 사용하고 있거나 개발한 알고리즘의 간단한 확장

- Supervised learning task에서 성능을 올릴 수 있는 방법

Ensemble = 함께, 동시에, 한꺼번에 협력하여라는 의미

머신러닝에서 알고리즘의 종류에 상관 없이 서로 다르거나, 같은 매커니즘으로 동작하는 다양한 머신러닝 모델을 묶어 함께 사용하는 방식

장점:

1. 예측 성능을 안정적으로 향상

다양한 여러 개의 model의 결정으로 최종 예측 결과를 제공을 하기 때문에 noise 등으로부터 보다 안정적

2. 쉽게 구현이 가능

여러개의 model을 학습하고 거의 직접적으로 연합하여 적용을 하기 때문에 간편하게 사용을 할 수가 있다.

3. 모델 파라미터의 튜닝이 많이 필요없다

bagging & boosting

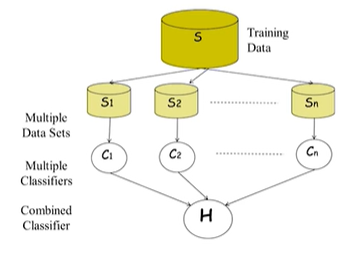

bagging

- 학습 과정에서 training sample을 랜덤하게 나누어 선택해 학습

보다 lowervariance의 안정적인 성능을 제공하는데 유용한 방법

Bootstrapping

다수의 sample data set을 생성해서 학습하는 방식

- 같은 model을 사용한다면 model parameter가 서로 달라져야 할 것이기 때문에 sample을 random하게 선택해야할 것. but!! 서로 다른 model이라면 어차피 서로 다른 model형태로 다르게 동작하기 때문에 같은 sample을 이용해도 될 것

Boosting

사용된 결과가 연속적으로 다음 클래스에 사용된다.

weak classifie

: Bias가 높은 classifier - strong classifier에 비해서 성능이 낮아서 혼자서는 무엇을 하기 어려운 모델

Random Forest

bagging과 boosting을 활용하는 대표적인 알고리즘

- improving decision tree

- by bagging -> random forest- by boosting -> gradient boosting machine as generalized adaboost

model 성능을 평가 evaluation하는 방식

accuracy 측정

model의 정확도

confusion matrix

각 경우에 대해 오차가 얼마 있었는지 표현하는 방법

ROC curve

서로 다른 classifier의 성능을 측정하는데 사용하는 커브

왼쪽으로 휘어질 수록 성능이 좋다.

recall

본래 내가 가진 실제 Positive 중에서 얼마나 내 알고리즘이 진짜를 잘 찾았는지의 비율을 의미

F1 스코어

Precision과 Recall의 조화평균이 F1 스코어

Precision-Recall Curve

x축은 Recall이 되고, y축은 Precision이 된다. 그리고 그 아래의 면적이 ACU-PR이 된다