부스팅과 배깅 정리

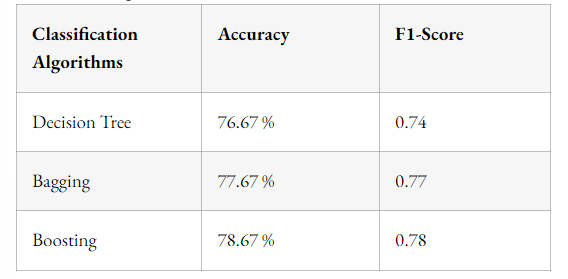

이전에 학습했던 배깅의 경우 앙상블 기법 중 하나이고, 배깅의 결과로 예컨대 하나의 의사결정나무를 사용했을 때보다 편향은 조금 증가하더라도 분산을 낮출 수 있다고 하였다. (과적합 방지) 그리고 또다른 앙상블 기법으로 부스팅이 등장하는데, 여러 부스팅 기법을 알아보기 이전에 부스팅과 배깅을 큰 틀에서 각각 정리하고, 둘 사이의 차이를 알아보자.

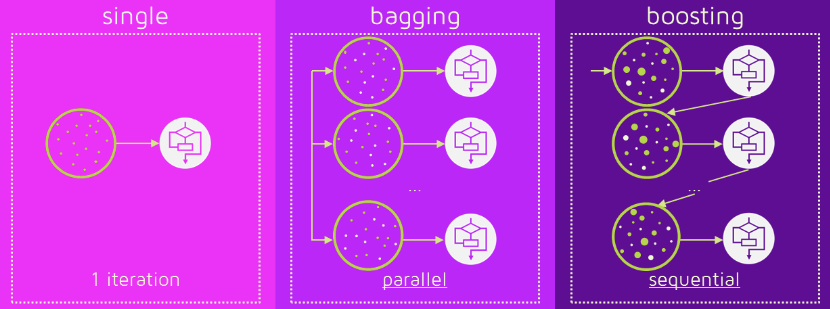

기본적으로 배깅은 모델을 앙상블할 때, 앙상블 할 시에 데이터셋을 반복해서 추출하는 것을 말한다. 따라서 모델은 고정이며 데이터셋은 뽑을 때마다 랜덤이므로 변화한다.

부스팅은 모델을 앙상블 하면서도, 모든 모델을 만들어 놓고 시작하는 것이 아닌 모델1, 모델2, ... 처럼 학습을 진행하며 모델을 점진적으로 변화시켜 나간다. 따라서 모델은 계속해서 변화하지만 데이터셋은 고정이다.

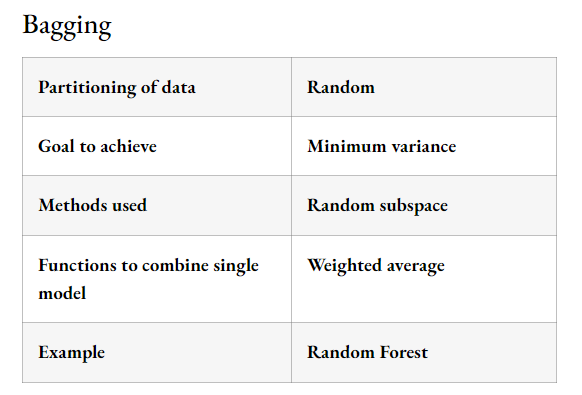

배깅의 특징

- 분산을 감소시킬 목적으로 사용한다

- 데이터셋에 대해 복원 + 랜덤 추출한다

- 대표적으로 Randomforest

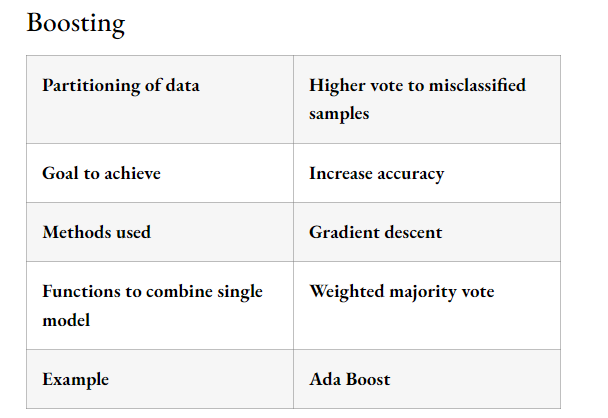

부스팅의 특징

- 반복문을 돌며 예측이 틀린 데이터에 가중치를 부여한 다음 모델을 생성하며 예측력을 높인다

- 따라서 편차를 감소시킬 목적으로 사용한다

- 데이터셋은 고정이다

- 대표적으로 XGBoost, Gradient Boost, AdaBoost, CatBoost 등이 있다.

따라서 배깅은 기본적으로 병렬 학습 기법이고, 부스팅은 모델 자체를 변화시키는 기법이다.

배깅의 결과는 과소적합이, 부스팅의 결과는 과대적합이 될 가능성이 존재한다.

다음 문서 를 참고하고 정리한 글입니다.