Regression

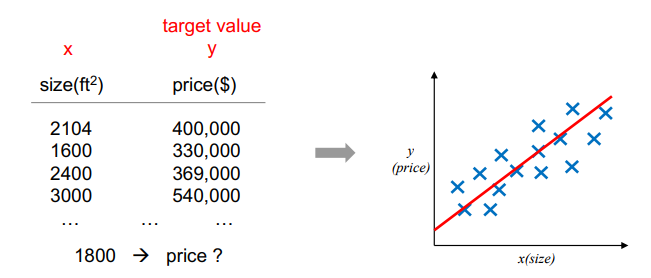

From x (input) => predict y (output, continuous)

이전과 다르게 continuous 한 예측을 하는 것을 회귀분석, Regression 이라 이해할 수 있다. 정확히는 다음과 같이 표시한다.

Regression: constructing a model y = f(x), using training data (x, y)

혈압, 집값 예측 등을 생각하면 이해가 쉽다.

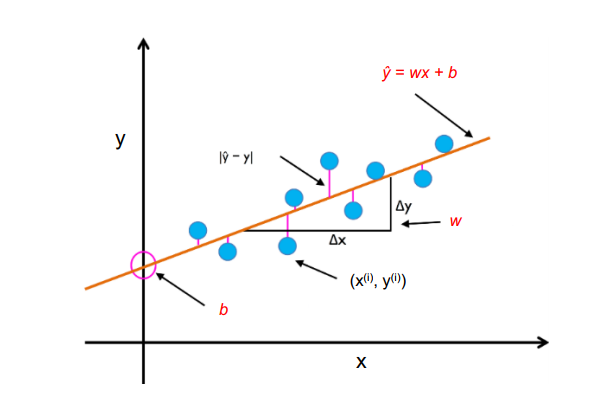

y = f(x) 라고 하는 것은 linear function 이며 wx + b 와 같이 표시할 수도 있다. - w: weight

- b: bias

또한 이때의 prediction error를 이용해 이러한 비용함수를 최소화하는 것이 목표이다. (최소화하는 w, b를 찾는 것.) 이 과정을 살펴보자.

prediction error 은 실제 y와 예측값 y' 에 대한 거리로 정의했다.

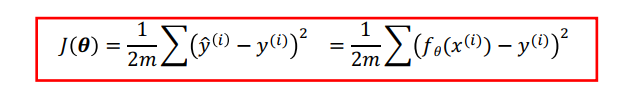

Cost Function

Cost, loss Function 을 무엇으로 정의했냐는 항상 중요한 점이고, 이를 어떻게 최소화할 지 방법도 중요하다.

지금은 MSE cost Function 을 보자.

기울기가 양수면 그만큼 왼쪽으로, 음수면 그만큼 왼쪽으로 이동하는 Gradient Descent 방법을 이용하자. (Just 차를 구해주자.)

이때 얼만큼 이동할지는 Learning Rate 라고 하는 것이 결정했다.

Multiple Linear Regression

y = f(x) = wx_1 + wx_2 + b

인풋과 가중치가 2개씩이므로 면이 생성된다.

따라서 비용함수와 Gradient 는 다음과 같다.