Chapter 11 현대적인 인공신경망

GAN(Generative Adversarial Network)

-

Generative: 생성적

-

Adversarial: 적대적

-

기계 학습 역사상 가장 독창적인 아이디어로 평가받는 생성 기법

-

인공지능이 비로소 예술적인 결과물을 만들기 시작한 효시

-

영상을 출력하는 다양한 기존 네트워크에 적용되어 시각적 성능 향상

-

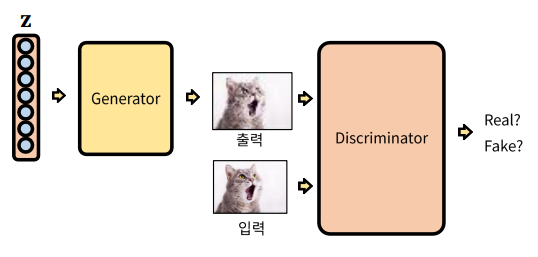

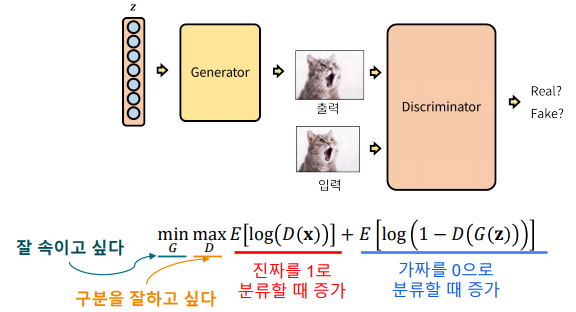

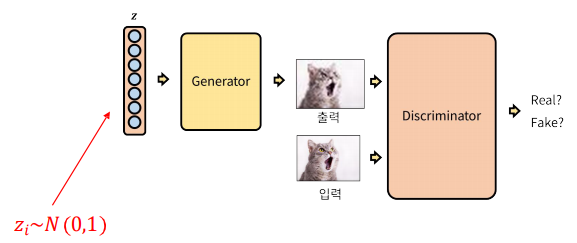

GAN의 원리: 최대한 진짜처럼 “위조”하는 Genearator와 가짜/진짜를 구분하는 Discriminator의 경쟁 구도로 학습

-

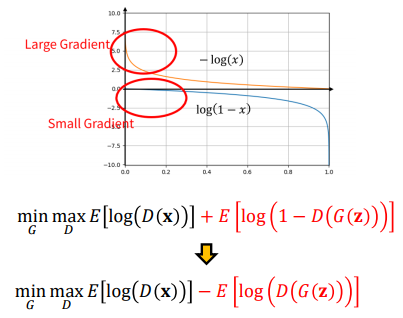

Mini-Max 문제

-

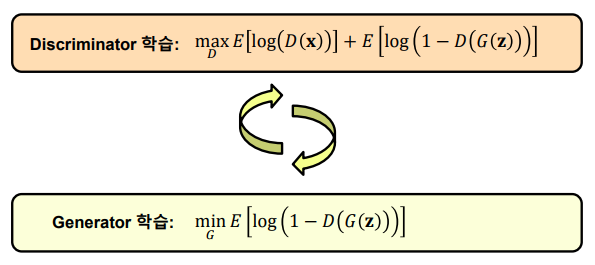

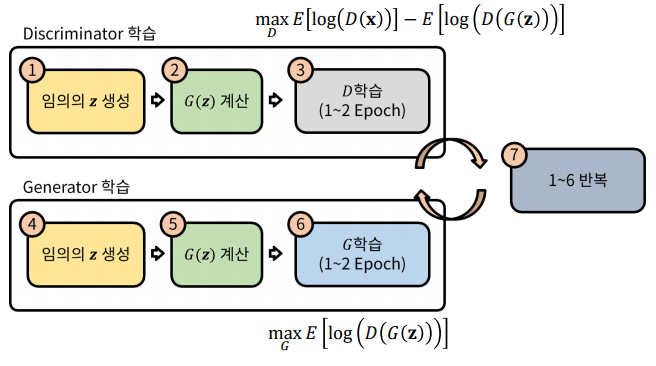

Mini-Max 최적화의 구현: Mini-Max 문제는 두 문제를 반복해서 풀이하는 방법으로 구현

-

GAN의 잠재 변수

-> 𝐳 벡터는 잠재 변수(latent variable)로, 생성을 위한 random seed라고 볼 수 있음

-> 학습 시 임의의 값을 샘플링하여 넓은 domain을 커버하도록 함

-

손실 함수 트릭: 𝐆의 성능이 좋지 않을 때 학습이 빠르게 이루어지도록 손실 함수에 트릭 적용

-

GAN의 학습

-

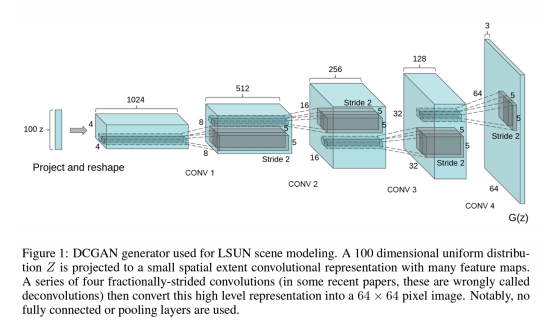

GAN의 활용: DCGAN(Deep Convolutional GAN)

-

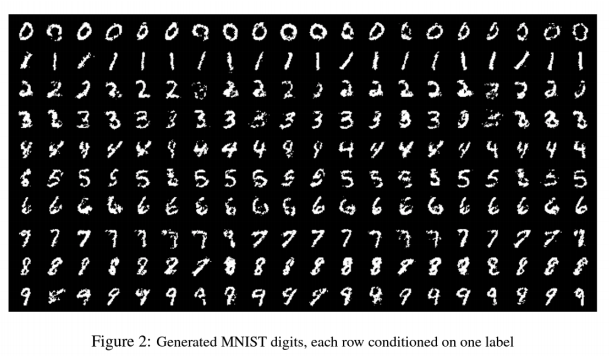

cGAN (Conditional GAN)

-

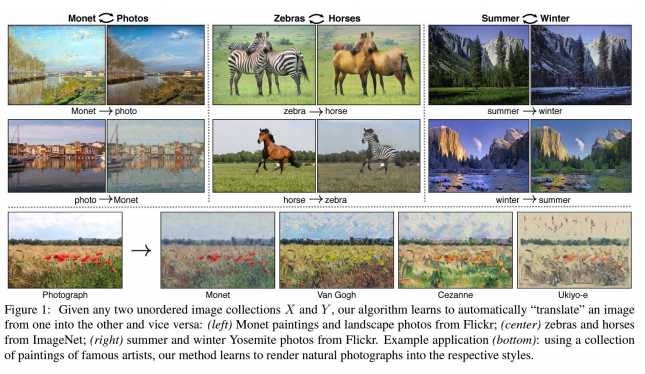

Cycle GAN

Stable Diffusion

-

오픈 소스 이미지 생성 프로젝트로, text-to-image방식의 서비스 제공

-

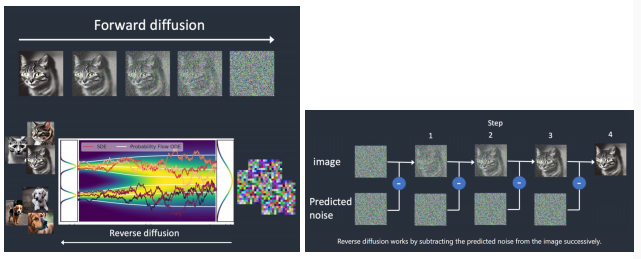

Diffusion Model: 임의의 시작점으로부터 목표로 하는 도메인으로 확산(diffusion)된 것을 역추적하는 모델

-> 확산 모델: 순차적으로 노이즈가 추가되는 확산 프로세스를 역으로 추정하여 원본 데이터를 추정하는 모델

-

Stable Diffusion(Latent Diffusion) Model

-> 영상에서 직접 확산 모델을 구현 시 복잡도가 너무 높음

-> 이를 해결하기 위해 잠재변수(latent variable)에서 확산 모델을 구현

-

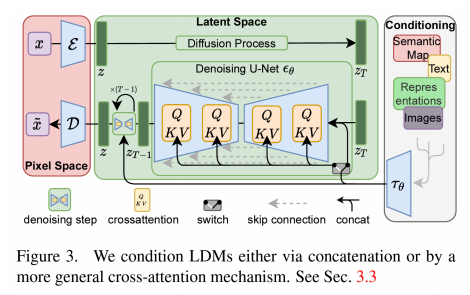

Stable Diffusion Model 구조

-> 단순 하나의 모델이 아닌, 다양한 모델을 결합하여 전체 시스템 구성

-> Transformer, U-Net, VAE, Attention Module 활용

ChatGPT

-

GPT(Generative Pre-trained Transformer)

-

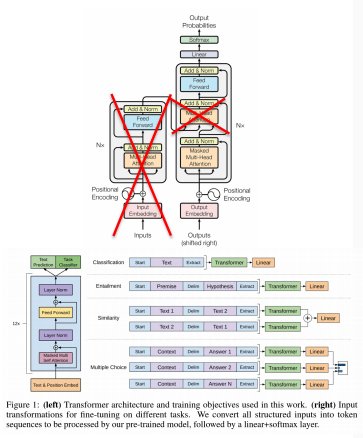

GPT-1: 기반의 마련

-> 2018년 OpenAI에 의해 소개됨

-> Transformer 아키텍처 기반

-> 언어 모델링을 통한 비지도 학습

-> 주요 구성 요소

--> 셀프 어텐션 메커니즘

--> 멀티헤드 어텐션

--> 위치 인코딩

-

GPT-2: NLP 기능의 비약적 발전

-> 2019년 OpenAI 출시

-> 모델 크기 증가: 15억 매개 변수

-> "미세 조정" 개념 도입

-> 향상된 언어 이해 및 생성

-> 잠재적인 오용으로 인해 논란이 되는 초기 릴리스

-> 주요 발전 사항

--> 제로샷 학습

--> 고품질 텍스트 생성

--> 향상된 지식 보존 -

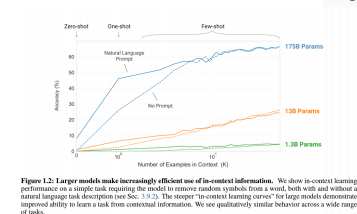

GPT-3: 탁월한 NLP 성능

-> 2020년 OpenAI 출시

-> 대규모 확장: 1,750억 개의 매개 변수

-> 훨씬 더 나은 언어 이해 및 세대

-> 퓨샷 학습이 가능

-> 개발자를 위한 API 및 애플리케이션 통합

-> 주요 성과

--> 작업 불가지론적 모델

--> 인간과 같은 텍스트 생성

--> 창의적 문제 해결

--> 문맥 내 학습

-

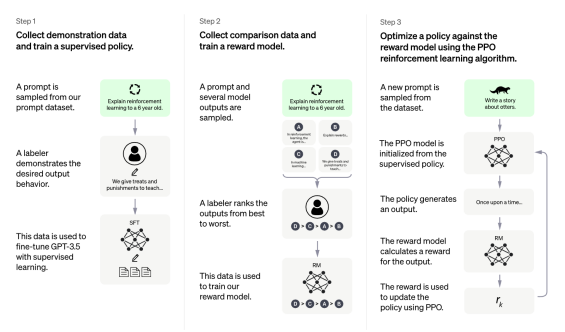

ChatGPT의 학습: 아주 복잡하고, 많은 비용이 투자되는 학습 과정 필요

이 글은 제로베이스 데이터 취업 스쿨의 강의 자료 일부를 발췌하여 작성되었습니다