Chapter 7 학습 일반화

과소적합과 과대적합

-

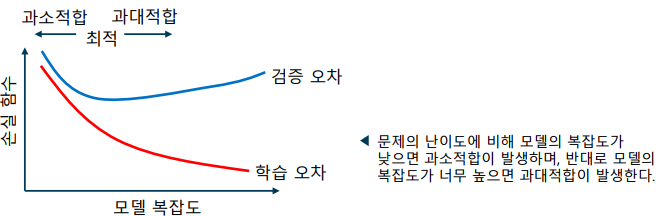

모델의 학습이 적절하게 이루어지지 않아, 성능이 하락하는 문제

-> 과소적합(underfitting) – 모델이 학습 데이터를 충분히 표현하지 못하는 경우 (높은 분산)

-> 과대적합(overfitting) – 모델이 학습 데이터를 표현하는 데에 지나치게 집중되어, 다른 데이터를 풀지 못하는 경우 (높은 편향)

-

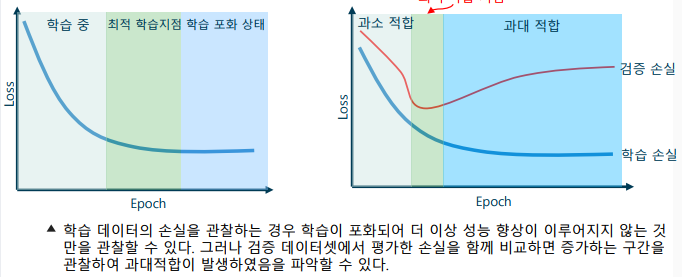

학습 데이터만으로는 과대적합을 파악하기 어려워, 검증 데이터에서도 손실 함수를 평가하여 비교

드롭 아웃 일반화 이론

-

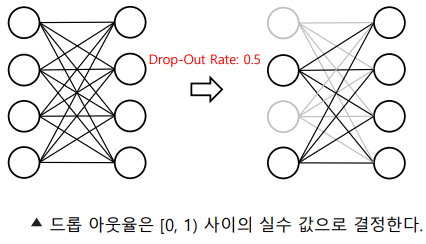

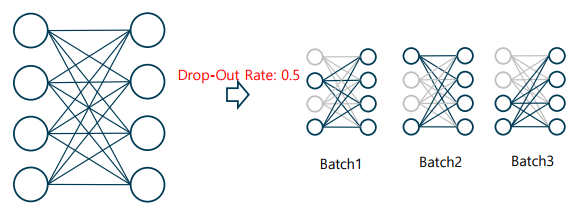

드롭 아웃 (Drop-out)

-> 학습 시 일정 확률로 전결합계층의 뉴런을 제거하는 기법

-> 드롭 아웃율(drop-out rate) – 각 뉴런이 제거될 확률로, 초매개변수에 해당

-

드롭 아웃의 학습 단계: 미니 배치 학습 수행 시, 각 배치 별로 매번 새로운 드롭 아웃을 적용하여 학습을 수행

-

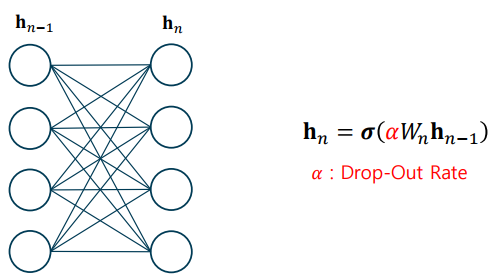

드롭 아웃의 테스트 단계: 테스트 단계에서는 모든 뉴런을 사용, 단, 출력 값에 스케일링을 적용하여 총 합이 커지지 않도록 조절

-

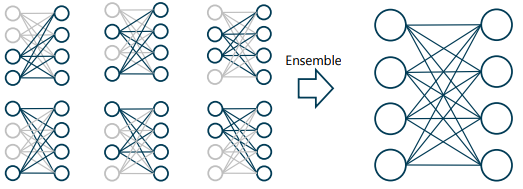

드롭 아웃의 의미

-> 학습 시 일부의 특징만을 사용해도 좋은 성능이 나올 수 있도록 함

-> 테스트 시에는 여러 가능성에 대해 학습된 결과를 앙상블한 균형 있는 결과를 사용하여 과대적합 방지

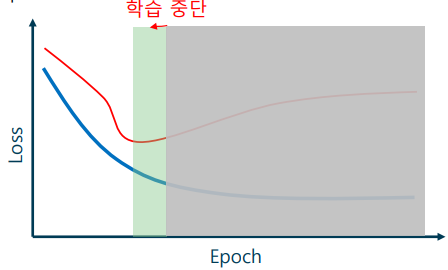

조기 종료 일반화

- 모델과 관계없이 사용 가능함

- 학습 조기 종료 (Early stopping)

-> 손실 함수의 경향을 통해 최적의 모델을 선택하는 방법

-> 과대적합이 발생한 것으로 판단되면 학습을 종료하고, 최적 모델을 선택

이 글은 제로베이스 데이터 취업 스쿨의 강의 자료 일부를 발췌하여 작성되었습니다