이번에는 Linear Regression을 위한 Gradient Descent를 여러 변수가 있을 때 어떻게 쓰는지 알아보려고 한다.

Hypothesis : hθ(x)=θ0+θ1x+θ2x2+...+θnxn=θTX

Parameters : θ0,θ1,θ2,...,θn. 하지만, 우리는 이것을 그냥 θ(n+1dim.) 라고만 표현하기로 하자.

Cost Function : J(θ0,θ1,...,θn)=J(θ)=2m1i=1∑m(hθ(x)−y)2

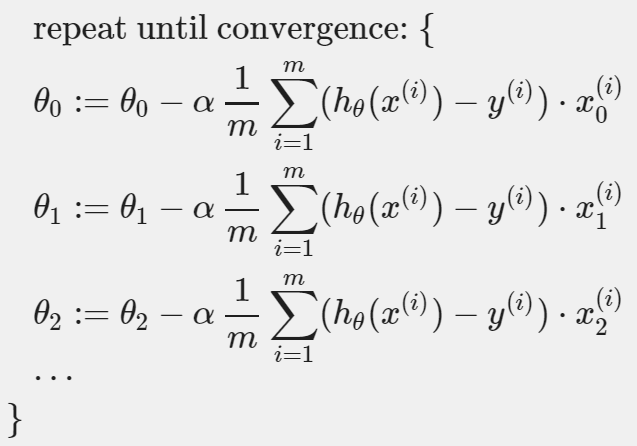

Gradient Descent : Repeat { θj:=θj−α∂θj∂J(θ0,...,θn)=θj−α∂θj∂J(θ) } (simultaneously update for every j=0,...,n)

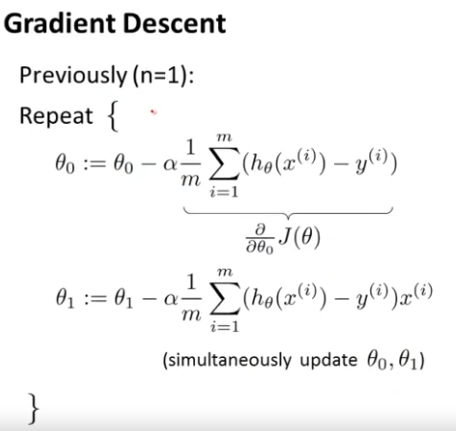

Gradient Descent에 Cost Function을 대입한 이전의 Gradient Descent는 다음과 같았다.

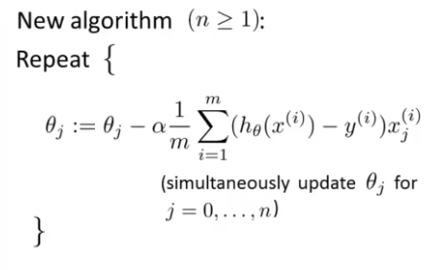

하지만 n이 1보다 같거나 클 때는 다음과 같다.