MetaPrompting: Learning to Learn Better Prompts

COLING 2022

분야 및 배경지식

- meta-learning

- 직접 학습하는 것이 아니라 한 단계 더 높은 차원(=meta)에서의 학습을 이용하는 방법

- 굉장히 다양한 연구 분야를 포괄하는 용어이나, 해당 논문의 경우 다양한 태스크에 대해 학습한 이후 학습하지 않은(=unseen) 태스크에 대해 적응하는 단계를 거침

- metric-based

- 유사한 샘플들은 모으고 다른 샘플들은 분리하는 metric space를 학습

- model-based

- 모델의 예측을 지원하기 위해 추가적인 meta learner를 사용

- optimization-based

- 모델의 최적화를 개선시키는 방법을 학습

- prompt

- hard prompt

- 사람이 이해할 수 있는 자연어로 만들어진 프롬프트로, discrete prompt라고도 불림

- soft prompt 대비 search space가 한정적

- soft prompt

- 학습가능한 벡터로 구성된 프롬프트로, continuous prompt라고도 불림

- hard prompt

문제

- soft prompt를 활용한 방법들은 효과를 보기 위해 좋은 시작점(initialization)에 크게 의존

- 좋은 시작점은 일반적으로 새로운 태스크에 따라 새롭게 학습되어야 하며, 또한 쉽게 찾을 수 없음 (task-bounded)

해결책

MetaPrompting

- 새로운 프롬프트 태스크에 빠르게 적응할 수 있는 좋은 프롬프트 초기점(initialization)을 자동으로 찾는 알고리즘

- soft prompt embedding과 MLM(Masked Language Model) 파라미터를 학습

- optimization 기반의 meta-learning 이용

- meta-train 태스크와 meta-test 태스크는 동일한 데이터셋 내의 다른 도메인으로부터 샘플링

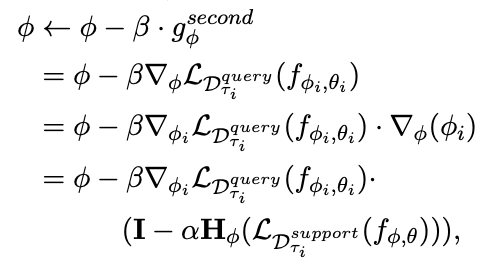

- second-order gradient

- L_D^query 부분은 meta loss, L_D^support 부분은 adapt loss

- H는 Hessian matrix를 의미

평가

- 모델

- BERT (bert-base-uncased)

- P-tuning과 유사하게 transformation layer를 추가 (soft prompting model)

- 2 layer biLSTM

- 2 layer MLP

- 데이터셋

- HuffPost headlines, Amazon product data, 20 Newsgroups, Reuters

의의

- 최적화 기반의 meta-learning을 프롬프트에 사용한 최초의 사례

한계

- 동일한 데이터셋 내의 다른 도메인 태스크를 이용해 meta-train을 진행

- out-of-domain 태스크에 대해 meta-train을 수행하였을 때는 그다지 큰 성능 향상이 일어나지 않음

- 동일한 데이터셋 내의 다른 도메인 태스크를 이용한 것이 진정한 meta-learning이라고 볼 수 있을지 의문

- 도메인이 달라도 같은 데이터셋인만큼 데이터셋의 distribution이 유사할 것임