Total Recall: a Customized Continual Learning Method for Neural Semantic Parsers

continual-learning

목록 보기

7/16

Total Recall: a Customized Continual Learning Method for Neural Semantic Parsers

EMNLP 2021

분야 및 배경지식

Continual Learning, Semantic Parsing

- Semantic Parsers

- 자연어 발화(natural language utterances)를 실행 가능한 프로그램이나 논리적인 형태로 매핑시키기 위해 대화 시스템에 널리 사용

- Continual Learning

- 태스크들을 연속적으로(순서대로) 학습하는 방법

- 많은 경우 이전의 학습 데이터를 모두 포함한 전체 데이터에 대한 접근은 불가능하다고 가정하여, computational resource의 효율성과 privacy/security 보안을 달성하고자 함

- regularization-based, dynami architecture, memory-based 방식 등이 존재

문제점

- 태스크의 숫자가 빠르게 증가함에 따라 semantic parser를 재학습하는 것은 경제적(economical), 연산적으로(computational) 비용이 많이 들기 때문에 이에 대한 대안으로 비용 효과적인 continual learning 필요

- 하지만 기존의 SOTA 연속학습 방식은 semantic parser에 의해 만들어진 구조화된 결과값이라는 특별한 속성을 고려하지 않아, 이에 대해 뛰어난 성능을 내지 못함

해결책

Total Recall

- Customized Sampling method for Memory Replay

- DLFS(Diversified Logical Form Selection)라는 새로운 알고리즘 제시

- 다양한 논리적인 형식 템플릿을 저장해 이후 학습에 사용, catastrophic forgetting 해결하고자 함

- 메모리 안의 parse action의 분포 entropy를 최대화(balance)하는 방향으로 대표적인 instances 선택

- 논리적인 형식과 action distribution에 관련하여 balanced memory를 유지할 수 있도록 함

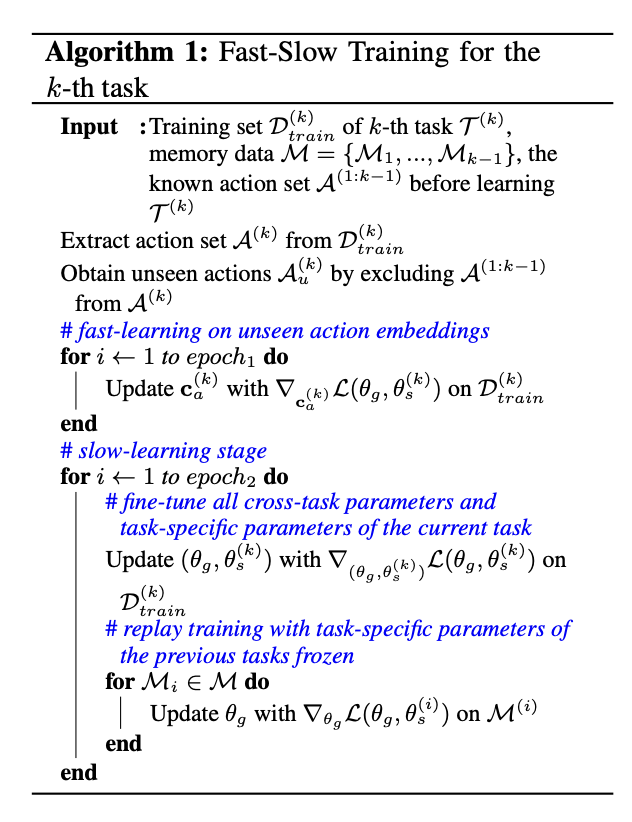

- Two-stage Training method

- cognitive neuroscience의 발견에서 영감을 얻어, Fast Slow Continual Learning(FSCL)라는 새로운 학습방법 제시

- 태스크들 사이의 지식 전이를 용이하게 만들어 여러 태스크들에 대해 parser의 일반화 성능을 개선

- fast-learning 단계에서는 학습하지 않은 action의 embeddings만을 업데이트, 그 다음 단계에서는 모든 모델 파라미터를 업데이트

- fast-learning이 학습하지 않은 action에 대해 좋은 초기 임베딩을 제공함으로써 새로운 태스크에 대한 일반화 성능에 도움을 주며, 또한 태스크 특화 패턴을 위한 파라미터에 최소한의 변화를 줌으로써 이전 지식을 까먹는 위험성을 줄여줌

평가

- 3가지 시나리오

- 1) 다른 태스크들은 다른 도메인에 속함, LF(logical form)에 태스크 특화 술부(predicate)와 개체(entity)가 존재

- 2) 같은 도메인, LF에 태스크 특화 술부 존재

- 3) 같은 도메인, LF에 태스크 특화 개체 존재

- datasets

- Overnight, NLMapV2

- metrics

- 일치하는 LF의 정확성(accuracy) 기반

한계

- memory replay 방식을 응용, 해당 방법은 분포의 discrepancy(불일치, 차이)가 작을수록 효과가 떨어짐.

- 또한 action의 수가 굉장히 많아질수록 메모리에 포함된 instance들로 모든 action을 포함하기에는 불충분하며, 학습 epoch이 커질수록 이전 태스크에 대한 catastrophic forgetting이 심화됨

의의

- semantic parsing에 특화된 새로운 연속학습 방법 제시 (novel)

- task-specific action과 cross-task action을 분리하는 것이 중요함을 밝힘

- fast-learning에서 첫번째 태스크의 좋은 최적화가 이어지는 태스크의 학습에 중요함을 보임