Towards Continual Knowledge Learning of Language Models

ICLR 2022

분야 및 배경지식

- Continual Learning

- 연속적으로 일련의 데이터(task, domain, or class)를 학습하는 문제

- 다양한 task의 데이터를 한번에 학습하는 multitask learning과는 달리, 급변하는 사회라는 현실적인 조건에 더욱 초점을 둔 문제

- catastrophic forgetting

- 과거에 학습한 지식을 잊어버리는 것

- knowledge transfer

- 이전에 배운 지식을 바탕으로 새로운 태스크를 더욱 잘 학습하거나, 새로운 태스크를 통해 이전에 학습한 태스크를 더욱 잘 해결하는 것

- Factual Knowledge

- 대량의 corpora를 기반으로 학습한 pretrained language model은 downstream task에 유용한 factual knowledge를 내포하고 있음

문제

- Language Model이 갖고 있는 세상에 대한 지식은 급변함 (outdated)

- 기존의 factual knowledge에 관한 연구들은 LM에 특정한 지식을 주입하거나 수정하는 데에 집중

- 새로운 지식을 학습함으로써 생기는 기존 지식의 catastrophic forgetting에 대한 연구는 미비

해결책

- Continual Knowledge Learning이라는 새로운 문제 정의

- 새로운 corpora를 연속적으로 pre-train함으로써 LM에 담긴 internal world knowledge를 갱신하고자 하는 문제

- CKL을 위한 새로운 benchmark

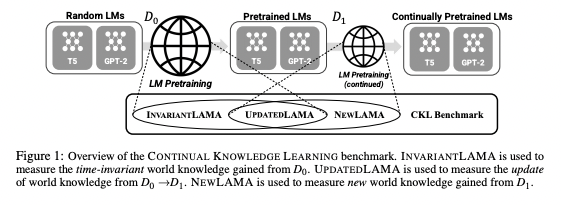

- 시간과 무관한 time-invariant world knowledge, 수정이 필요한 knowledge, 기존 LM이 갖고 있지 않던 새로운 knowledge를 측정하기 위해 InvariantLAMA, UpdatedLAMA, NewLAMA 제시

- CKL을 위한 새로운 metric

- FUAR (Forgetten / (Updated + Acquired) 비율)

- 1보다 작을 경우 좋으며, 0이 가장 좋은 경우

의의

- 기존 continual learning method에 대한 다양한 실험 (rehearsal, regularization, parameter-isolation)

- replay가 좋은 성능을 보이는 전통적인 CL과는 달리, CKL에서는 replay보다 parameter expansion의 성능이 가장 좋음을 밝힘

- 동일 데이터를 반복적으로 pretrain하거나, multiple phase를 학습할 시 성능이 현저히 떨어짐을 밝힘

- LM should be pretrained with just a few epochs on less duplicating data for efficiency

한계

- 문제 정의가 과하게 단순화된 경향이 있음 (oversimplified)

- real-world scenario에서 어떤 지식이 new이며 어떤 지식이 updated인지 판단하기 모호

- LAMA probing에 국한

- LM의 knowledge에만 초점을 맞춘 연구로 실제 downstream application에 대한 성능 고려 미비

- 2-phase setting만 고려 (multiple updates에 대한 실험 부족)