1. ResNet

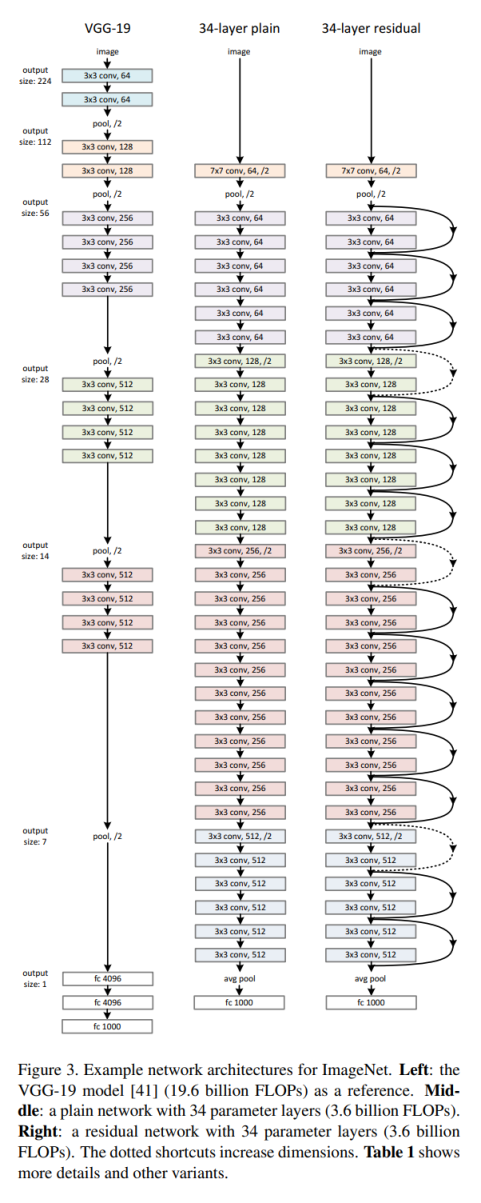

2015년 마이크로소프트 연구팀이 발표한 ResNet은 딥러닝 모델이 너무 깊어질 경우 학습이 어려워지는 기울기 소실 문제(Vanishing Gradient Problem)를 해결한 모델로 잔차 연결(Residual Connection == Skip Connection)을 도입하여 더 깊은 네트워크를 쉽게 학습할 수 있도록 한다.

1-1. 잔차 연결 (Residual Connection)

일반적인 CNN은 단순히 한 층씩 학습하는데, ResNet은 이전 층의 출력을 다음 층으로 바로 연결(Skip Connection)하여 학습이 쉽게 이루어지도록 함

1-2. Residual Block의 기본 구조

- 기존 출력에 원본 입력을 더해주는 방식으로 학습 안정화

- 깊은 네트워크에서도 기울기 소실(Vanishing Gradient) 문제 해결

- 더 깊은 모델(ResNet-50, ResNet-101, ResNet-152)에서도 성능 유지 가능

- Residual Block의 구조 (Identity Block)

- 입력 를 첫 번째 합성곱 층으로 전달: 1x1 합성곱, 활성화 함수(ReLU)

- 두 번째 합성곱 층: 3x3 합성곱, 활성화 함수(ReLU)

- 세 번째 합성곱 층: 1x1 합성곱, 활성화 함수 없음

- 입력 와 합성곱 층을 통과한 출력 를 더함:

- 합한 결과에 활성화 함수(ReLU) 적용

2. 현대 CNN 모델

2-1. InceptionNet

Google에서 개발한 CNN 모델로, 2014년 ImageNet 대회에서 우승하였고, Inception Module이라는 독창적인 구조를 사용하여 기존 CNN보다 연산량을 줄이면서도 더 깊고 강력한 특징을 학습할 수 있도록 설계됨

InceptionNet의 주요 특징

- 다양한 크기의 필터(1×1, 3×3, 5×5)를 동시에 사용하여 특징 추출

- 연산량을 최적화하기 위해 1×1 합성곱(Conv) 적용 → 연산량 감소 효과

- 잔차 연결(Residual Connection) 이전의 혁신적인 모델

2-2. DenseNet

DenseNet(Dense Convolutional Network)은 ResNet을 개선한 모델로, 모든 층을 연결하여 더 효율적인 학습이 가능함. 모든 층이 서로 연결되는 구조를 도입하여 기울기 소실 문제를 더 효과적으로 해결함

DenseNet의 특징

- 모든 레이어가 이전 레이어의 출력을 공유 → 정보 손실 최소화

- 더 적은 파라미터 수로도 높은 성능 가능

- 연산량이 적고 메모리 효율적

- ResNet보다 더 적은 연산량으로 높은 성능을 내는 모델

2-3. MobileNet (2017)

MobileNet은 모바일 및 임베디드 기기에서 사용할 수 있도록 설계된 경량 CNN 모델로 Depthwise Separable Convolution이라는 기법을 사용하여 계산량을 크게 줄임

MobileNet의 특징

- 연산량이 적고, 모바일 환경에서도 사용 가능

- 경량화된 CNN 구조 (MobileNetV1 → MobileNetV2 → MobileNetV3)

- Face Recognition, Object Detection, Edge AI 등에 활용

- 저사양 환경에서도 강력한 성능을 내는 CNN 모델