Abstract

few-shot 학습에 대해 information-theoretic regularization을 적용하였다. 제안된 접근방식은, 각 ray에 밀도의 엔트로피 제약(entropy constraint of the density in each ray)을 가함으로써 부족한 viewpoints로 인한 문제를 최소화하였다. 그리고 거의 중복된 viewpoint에서의 학습데이터로 인한 문제를 완화하기 위해 비슷한 viewpoints에서의 정보 이득을 제한하였다.

알고리즘의 주요 아이디어는 재구성된 scenes를 개별 ray를 따라 콤팩트하게 만들고 주변의 ray들에 걸쳐 일관성 있게 만드는 것이다. (? 아직 무슨말인지 모르겟음)

1. Introduction

이 논문에서는 few-shot prior-free novel view synthesis task에 대해 다룬다. 학습 이미지가 매우 적고, 타겟 장면에 대한 geomatric / semantic prior 정보가 없을 때에 대해 다루고 있다.

이미 있는 방식들은 추가적인 모듈을 사용하거나, object classes 또는 features 같은 prior knowledge를 사용한다. PixelNeRF는 관찰한 이미지에서 추출한 features를 사용한다.

InfoNeRF는 각 ray의 엔트로피 최소화를 통해 estimated scene에 희소성을 부여하여 reconstruction inconsistency를 완화한다. overfitting문제는 비슷한 viewponts에서 얻은 정보를 최소화함으로써 제어한다.

Summarize

novel information-theoretic approach

두가지 효과적인 regularization 방식을 소개한다.- ray entropy minimization

- ray information gain reduction

- 제안된 regularization방식은 단순하지만 과적합으로 인한 퇴화된 솔루션을 방지하고 multi-views에서의 reconstruction 불일치(inconsistency)를 완화하는데 효과적이다.

- Prior-free few-shot novel view synthesis

2. Related Work

3. Preliminaries: NeRF

4. Proposed Method

이 논문에서는 부족한 input views로 인한 reconstruction inconsistency와 과적합으로 인한 퇴보를 완화하는데 집중하고 잇다.

4.1 Motivation

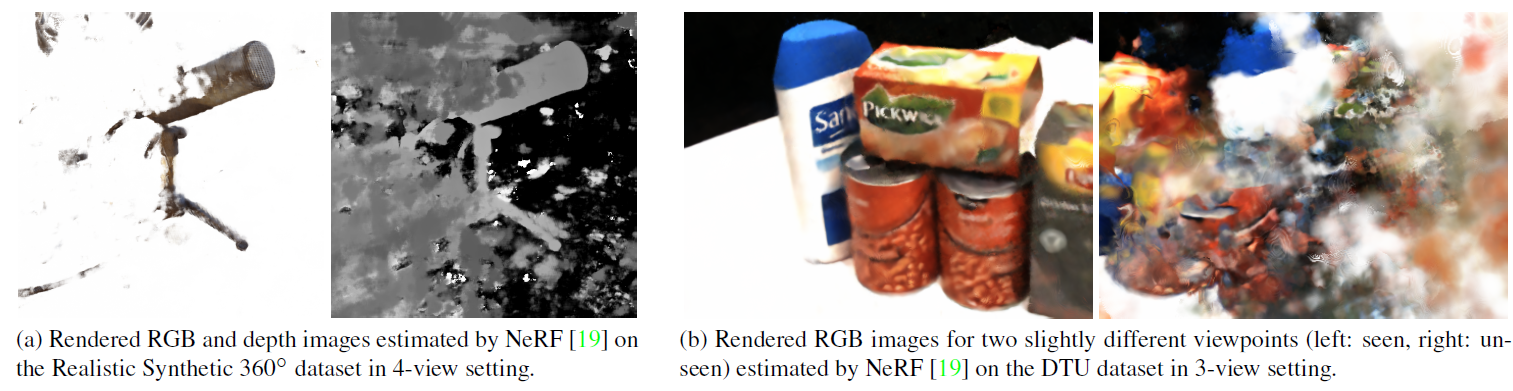

적은 viewpoint와 input데이터는 많은 노이즈 등을 만든답니다.

4.2 Regularization by Ray Entropy Minimization

Reconstruction inconsistency를 완화하기 위해 reconstructed scene에 sparsity constraint를 준다. 이는 각 ray의 entropy를 최소화함으로써 달성된다.

구체적으로, ray의 밀도가 낮은 entropy를 갖도록 loss fn에 regularization term를 추가하였다. ray의 sampled points의 작은 부분집합만 객체 또는 장면의 배경을 적중하고 나머지 points는 노이즈를 관찰할 가능성이 높기 때문에 이는 합리적이다.

-

Ray density

ray entropy minimization term을 논의하기 전, normalized ray density 를 소개한다.

은 ray의 sampled point이고, 는 에서 관측된 density이다. 는 주변의 샘플링 간격에 있다.

-

Ray entropy

-

Disregarding non-hitting rays

Ray entropy minimization은 몇 rays가 scene 내부의 객체를 적중하지 않았음에도 작은 entropy를 갖게 되는 문제점이 있다. 이를 해결하기 위해 낮은 density의 rays를 무시한다.where

이는 축적된 ray density이다.

-

Ray entropy loss

는 training 이미지에서의 set of rays이고, 는 unseen 이미지에서의 set of randomly sampled rays이다. 은 element-wise multiplication이다.

NeRF는 gt가 없기 때문에 unseen 이미지에서의 rays를 이용할 수 없지만, 이 논문의 모델은 gt를 요구하지 않는다.

Comparison with existing methods

4.3 Regularization by Information Gain Reduction

few-shot 세팅에서 training 이미지가 충분히 다양한 viewpoints를 가진다면, 위의 entropy regularization은 매우 유용하다.

그러나 만약 서로 비슷한 viewpoints를 갖는 이미지들을 받는다면, 그 이미지에 과적합되고, unseen views를 일반화하는데 실패하게 된다. 이러한 한계를 완화하기 위해 논문에서는 이웃한 rays에 걸쳐 일관된 밀도 분포를 보장하기 위한 추가적인 regularization term을 도입하였다.

observed ray 이 주어졌을 때, 아주조금 다른 viewpoint에서의 ray인 을 샘플링하고, 이 두 rays의 density function 사이의 KL-divergence를 최소화한다.

Regularization loss for information gain reduction

는 ray 에서 샘플링된 point. 논문의 구현에서는 -5 ~ 5 도사이에서 카메라를 회전시켜 조금다른 viewpoint를 얻었다.

4.4 Overall Objective

Total loss function

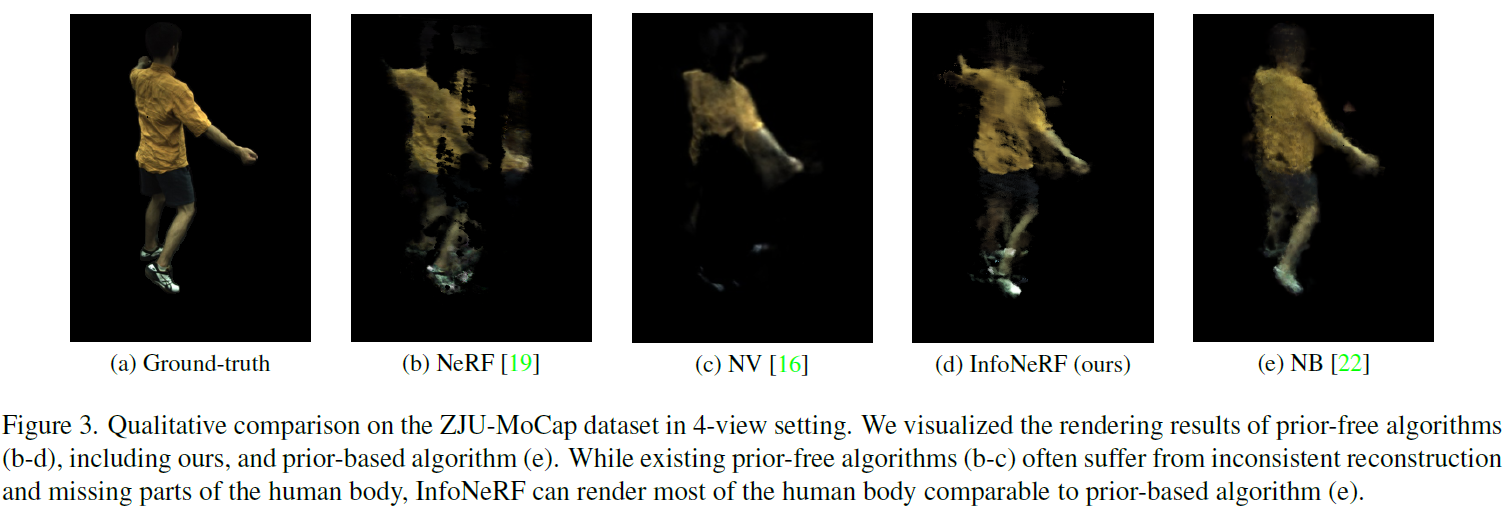

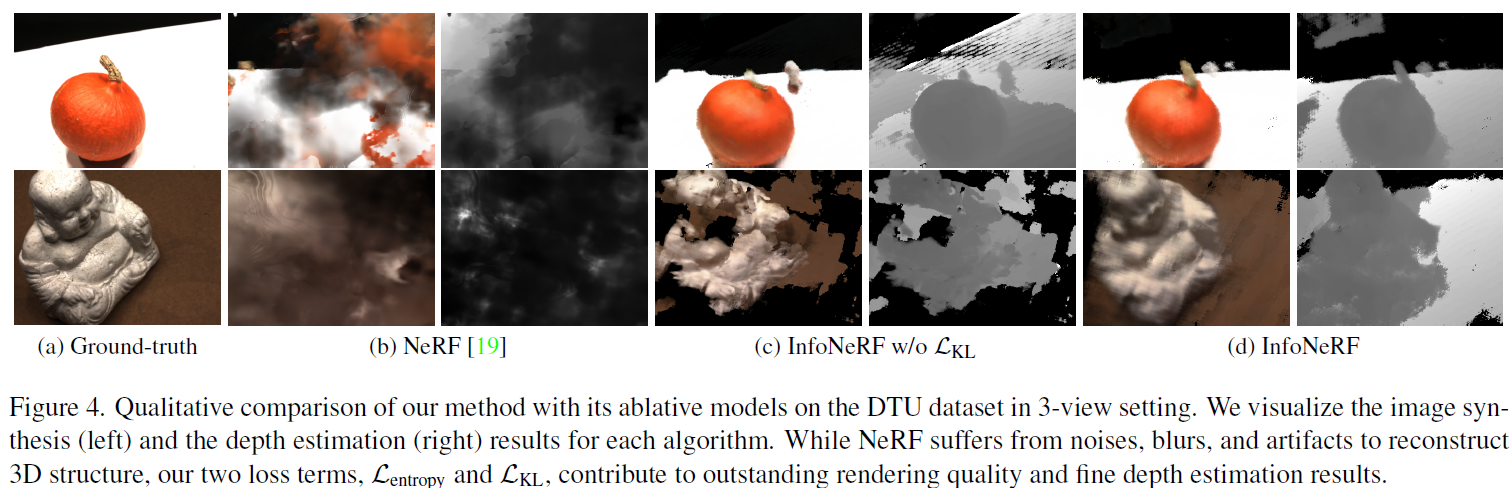

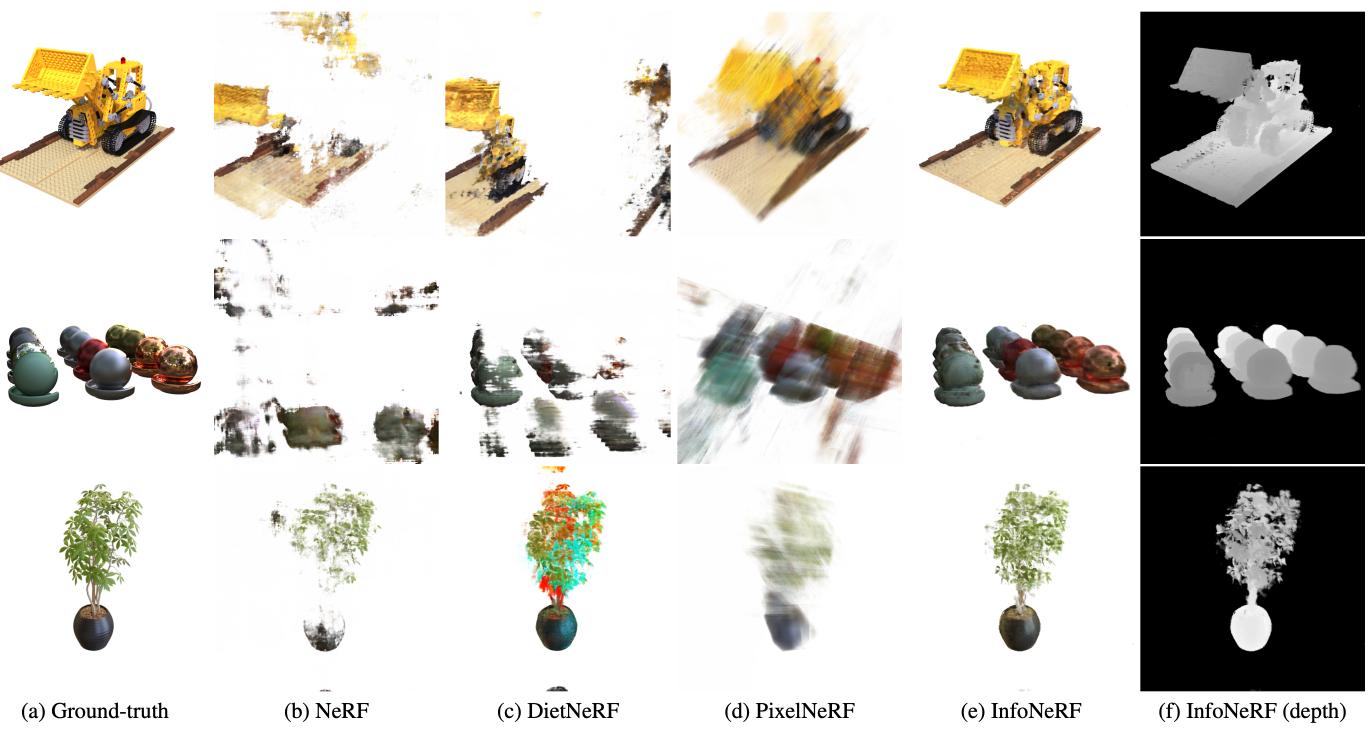

5. Experiments