Neural Network?

- 계층적 표현학습(Hierarchical Representation Learning)->층을 깊게 쌓으면서 학습

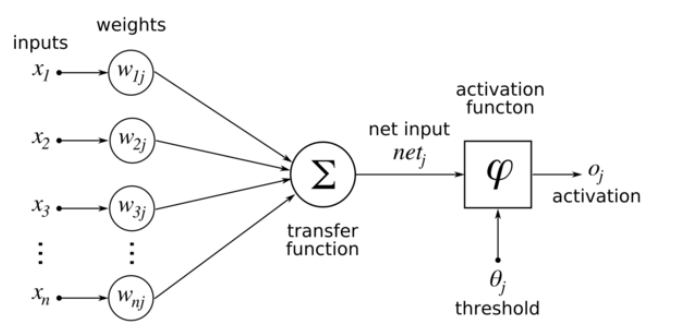

- 초기엔 가중치를 랜덤으로 작은 값으로 지정해주고, 그 뒤로는 스스로 학습하고 가중치를 업데이트하여 가장 적절한 가중치를 찾아내어 가장 좋은 Model 을 찾는 것

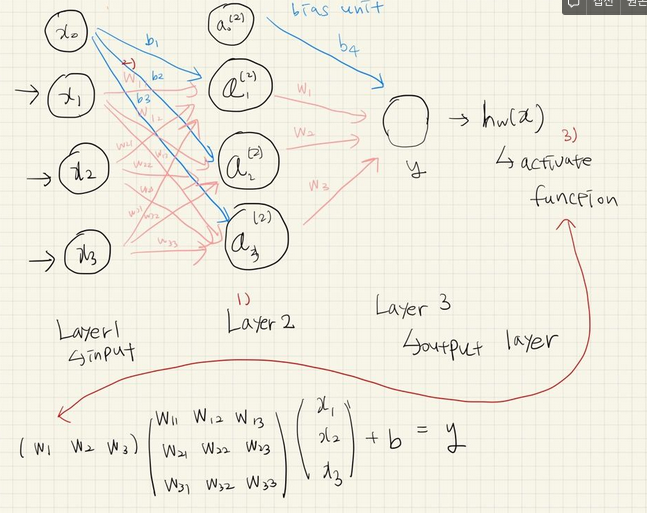

1) 층을 쌓는 이유?

input인 x값들을 층을 쌓으면서 다양한 x가 의미하는 값들을 추상적으로 분류할 수 있게됨

2) 가중치를 각각 다루게 두는 이유?

모든 노드를 다 연결한 후 내가 원하는 output을 얻기 위해 가중치를 다르게 조정함

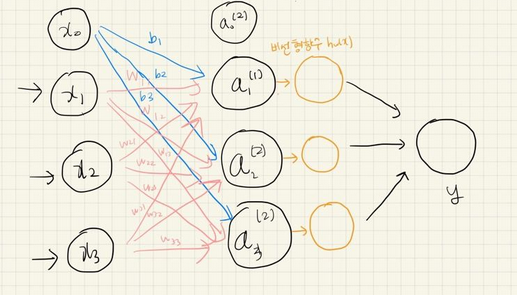

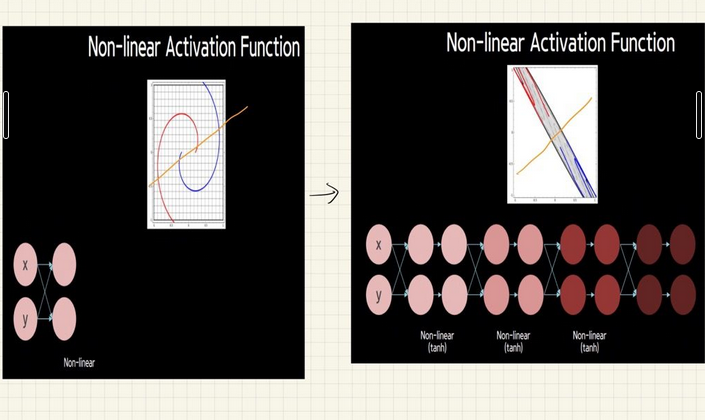

3) 비선형변환인 activate function을 사용하는 이유?

선형변환만 하게 된다면 의미없이 층을 쌓게 됨->위의 식처럼 층을 계속해서 쌓아도 한 번에 계산이 됨

-

위의 Neural Network에 비선형 변환을 적용

-

so, 아래와 같이 층을 쌓으면서 linear변환과 non-linear 변환을 계속해서 하다보면 처음엔 잘 분류가 되지 않던 게 2개로 분류가 됨

activate function 에 대한 내용은 후에 작성할 것임