0. Abstract

- Labeled data에 비해 Unlabeled text 말뭉치의 양은 방대하여 모델 훈련과 수행에 어려움이 있음

- 따라서 Unlabeled text를 활용한 language model의 Generative Pre-Training과 각 task에 맞는 Discriminative fine-tuning을 통해 이를 해결하고자 함

- 과제 인식 입력 변환을 사용해 최소한의 모델 구조 변경으로 효과적인 전이를 달성

- 12개 task 중에서 9개 task에서 최첨단 성능을 크게 향상

1. Introduction

-

원시 텍스트로부터 효과적으로 학습하는 능력은 자연어 처리(NLP)에서 지도 학습에 대한 의존성을 줄이는 데 매우 중요

-

딥러닝 방법은 많은 수작업 라벨링 데이터를 필요로 하지만, 라벨링되지 않은 데이터로부터 학습할 수 있는 모델은 비용과 시간을 절약

-

충분한 지도 학습 데이터가 있을 때도 비지도 학습으로 좋은 표현을 학습하면 성능이 크게 향상될 수 있다.

-

사전 훈련된 단어 임베딩의 사용이 이를 뒷받침하는 주요 증거

-

라벨링되지 않은 텍스트에서 단어 수준 이상의 정보를 활용하는 것은 두 가지 주요 이유로 어려운 과제

- 어떤 유형의 최적화 목표가 전이 학습에 유용한 텍스트 표현을 학습하는 데 가장 효과적인지 명확하지 않다.

- 학습된 표현을 목표 과제에 가장 효과적으로 전이하는 방법에 대한 합의가 없다.

- 이 논문에서는 비지도 사전 훈련과 지도 미세 조정을 결합한 반지도 학습 접근 방식을 탐구

- 목표는 적은 적응으로 다양한 과제에 전이될 수 있는 보편적인 표현을 학습하는 것

- 라벨링되지 않은 대규모 텍스트 말뭉치와 수작업으로 주석이 달린 여러 데이터셋(목표 과제)에 접근할 수 있다고 가정

2 단계의 훈련 절차를 사용

1. 라벨링되지 않은 데이터에서 언어 모델링 목표를 사용하여 신경망 모델의 초기 매개변수를 학습

2. 이 매개변수를 해당하는 지도 목표를 사용하여 목표 과제에 맞추어 조정

- 우리의 모델 아키텍처로는 Transformer를 사용

- 텍스트의 장기 종속성을 처리하는 데 더 구조화된 메모리를 제공하여 다양한 과제에서 견고한 전이 성능을 발휘

- 전이 과정에서는 구조화된 텍스트 input을 단일 연속 token sequence로 처리하는 트리순회 방식에서 파생된 task별 입력 조정을 활용함 (task마다 text 입력 방식이 다른데 이를 바꿔준다고 보면 됨)

- 모델 아키텍처를 최소한으로 변경하면서 효과적으로 미세조정 가능

2. Related Work

Semi-supervised learning for NLP

- 연구자들은 라벨링되지 않은 말뭉치에서 학습된 단어 임베딩을 사용하여 다양한 과제의 성능을 향상시킬 수 있음을 입증

- 이러한 접근법은 주로 단어 수준의 정보를 전이하는 데 중점, 더 높은 수준의 의미를 포착하는 것을 목표

- 라벨링되지 않은 말뭉치를 사용해 학습된 phrase-level이나 sentence-level embeddings을 시도

Unsupervised pre-training

-

Unsupervised pre-training은 지도 학습 목표를 수정하는 대신 좋은 초기화 지점을 찾는 것을 목표로 하는 semi-supervised learning의 특별한 경우

-

이 접근법은 이미지 분류, 회귀 과제, 음성 인식, 기계 번역 등 다양한 분야에서 사용되며 모델의 일반화 능력을 향상

-

기존 방법들은 사전 훈련된 모델의 숨겨진 표현을 보조 특징으로 사용하여 각 목표 과제에 맞춰 많은 매개변수를 추가해야 함

-

하지만, 이 연구는 전이 과정에서 최소한의 구조 변경만으로도 효과적인 성능을 발휘

Auxiliary training objectives

- 보조 학습 목적함수를 추가하는 것은 semi-supervised learning의 대안

- 본 연구에서도 보조 학습 목표를 사용하지만, 비지도 사전 훈련이 이미 목표 과제와 관련된 여러 언어적 측면을 학습한다는 점

3. Framework

2 stage 로 구성

대규모 말뭉치에서 language model 학습

labeled data를 활용하여 fine-tuning

3.1 Unsupervised pre-training

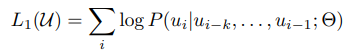

비지도 말뭉치 U = 𝑢1,𝑢2,…,𝑢𝑛 다음과 같은 목표를 최대화

- 𝑘는 컨텍스트 윈도우의 크기

- 조건부 확률 P는 신경망을 사용하여 모델링

- 매개변수 θ는 SGD

ex ) I love you라는 문장이 있고 I, love가 주어졌을 때 you를 예측하는 확률값

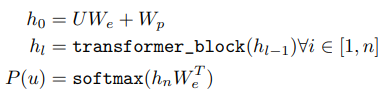

- 언어 모델로 다층 Transformer 디코더를 사용

- 입력 컨텍스트 토큰에 대해 다중 헤드 자기 주의(multi-headed self-attention) 연산을 적용한 후, 위치별 피드포워드 레이어(position-wise feedforward layers)를 통해 타겟 토큰에 대한 출력 분포를 생성

- U = ( u_i-k,....u_i-1) 는 토큰의 컨텍스트 벡터

- W_e 토큰의 임베딩 행렬

- W_p 위치 임베딩 행렬

- h0 : 임베딩(W_e) 후 position embedding matrix(W_p) 더하기

- hl : layer개수(n=12)만큼 decoder block을 통과하고

- P(u) : position-wise layer(W^T_e)를 거쳐 softmax로 확률값 구하기

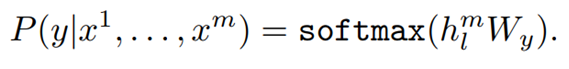

3.2 Supervised fine-tuning

- 모델을 목표로 훈련한 후, 우리는 매개변수를 지도 학습 목표에 맞게 조정

- labeled 데이터셋 C가 있다고 가정, C는 x^1, ... , x^m으로 이루어진 input token 시퀀스와 label인 y로 구성

- 입력은 사전 훈련된 모델을 통과하여 최종 Transformer 블록의 활성화 h^l_m를 얻고, 이를 추가된 선형 출력 레이어 W_y에 입력하여 y를 예측

이로 인해 다음과 같은 목적함수를 최대화

-

우리는 또한 언어 모델링을 보조 목표로 추가하는 것이 지도 학습 모델의 일반화를 개선하고, 수렴 속도를 가속화하는 데 도움이 되었다고 발견

-

다음의 목적함수 최적화 (여기서 𝜆는 가중치):

-

전반적으로, 미세 조정 동안 필요한 추

가 매개변수는 W_y와 구분 기호 토큰에 대한 임베딩

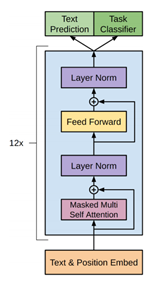

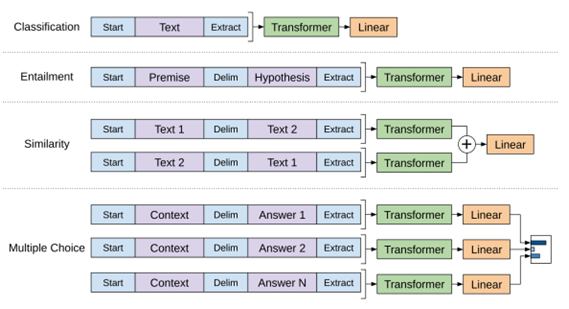

- (왼쪽) 이 연구에서 사용된 Transformer 아키텍처와 훈련 목표.

- (오른쪽) 다양한 과제에 대한 미세 조정을 위한 입력 변환. 모든 구조화된 입력을 토큰 시퀀스로 변환하여 사전 훈련된 모델로 처리한 후, 선형 + 소프트맥스 레이어를 적용.

3.3 Task-specific input transformation

-

일부 작업, 예를 들어 텍스트 분류와 같은 경우, 위에서 설명한 대로 모델을 직접 미세 조정할 수 있다

-

그러나 질문 응답이나 텍스트 추론과 같은 특정 작업은 정렬된 문장 쌍이나 문서, 질문, 답변의 삼중항과 같은 구조화된 입력을 필요, 이러한 작업에 적용하기 위해서는 약간의 수정

-

이전 연구는 전이된 표현 위에 작업 특정 아키텍처를 학습하는 방법을 제안했으나, 이는 상당한 작업 맞춤화가 필요하며 이러한 추가 아키텍처 구성 요소에 대해 전이 학습을 사용하지 않는다.

-

하지만 본 논문에서는 구조화된 입력 → pre-trained 모델이 처리할 수 있는 ordered sequence로 변환하는 순회 스타일(traversal-style) 접근 방식을 사용한다. 이 변환을 통해 아키텍쳐를 광범위하게 변경하는 것을 피할 수 있다.

텍스트 추론 (Textual Entailment)

- 전제(p)와 가설(h) 토큰 시퀀스를 연결하고, 그 사이에 구분 기호 토큰($)을 추가

유사성 (Similarity)

- 비교하는 두 문장 간에는 본래의 순서가 없기 때문에, 입력 시퀀스를 두 문장 순서의 모든 가능한 조합을 포함하도록 수정 (구분 기호를 사이에 추가)

- 각각 독립적으로 처리하여 두 시퀀스 표현 h_m을 생성하고, 이를 요소별로 더한 후 선형 출력 레이어에 입력

질문 응답 및 상식 추론 (Question Answering and Commonsense Reasoning)

- 컨텍스트 문서 z , 질문 q, 그리고 가능한 답변 집합 {a_k}이 주어짐

- 문서 컨텍스트와 질문을 각각 가능한 답변과 연결하고, 그 사이에 구분 기호 토큰을 추가하여 [z; q; $; ak] 형태로 만듬

- 이러한 시퀀스 각각을 모델을 통해 독립적으로 처리하고, 소프트맥스 레이어를 통해 가능한 답변에 대한 출력 분포를 생성

본 논문에서는 과제별로 아키텍쳐를 만드는 것이 아닌 Generative Pre-Training과 discriminative fine-tuning을 통해 단일 framework를 제안했다.