Study

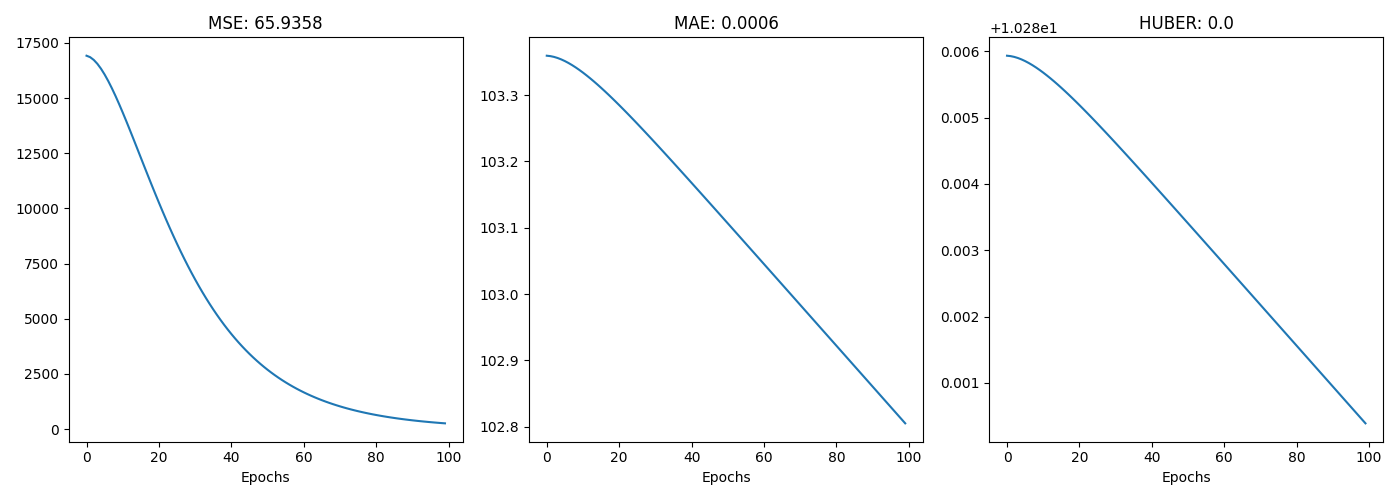

1.[Study] Loss Functions

5가지 Loss Function NotebookLoss 함수 numpy 구현목적그 동안 아무 생각 없이 회귀 함수와 분류 함수를 사용한 것 같다특히 내부적으로 어떻게 구현되어 있는지 모른채 회귀는 mse, 분류는 cross entropy를 사용하였다이번 기회에 어떻게

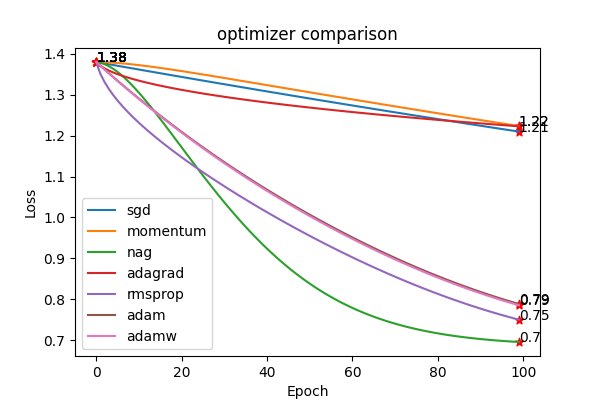

2.[Study] Optimizer Functions

7가지 Optimizer Function NotebookOptimizer 함수 numpy 구현목적그 동안 아무 생각 없이 최적화 함수를 사용한 것 같다특히 Adam만 default로 사용하고 그 의미를 깊이 고민해본 적 없었다이번 기회에 다른 optimizer를 공부하

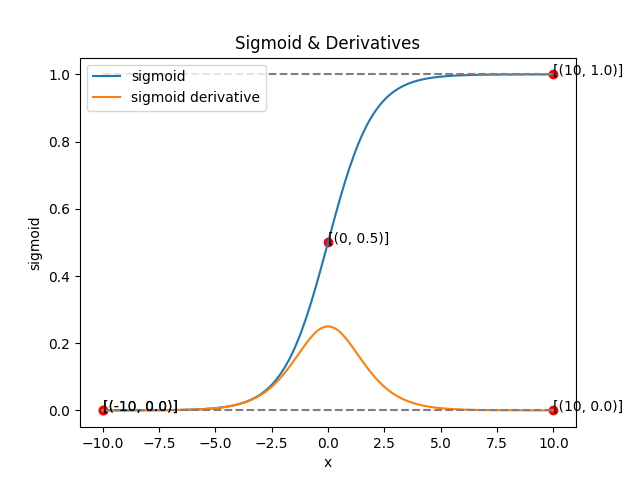

3.[Study] Activation Functions

6가지 activation function notebookActivation 함수 numpy 구현목적그 동안 아무 생각 없이 활성함수를 사용한 것 같다특히 relu만 default로 사용하고 그 의미를 깊이 고민해본 적 없었다이번 기회에 다른 기본이 되는 sigmoid

4.[Study] Augmentation(vision)

Augmentation 실습 Notebook목적Image 관련 모델을 학습할 때, 강견한 모델 학습을 위해서 Augmentation은 필수이다어떤 Augmentation이 존재하고 정의와 동작원리 그리고 실제 모습을 확인해보자Pytorch의 torchvision에 구현

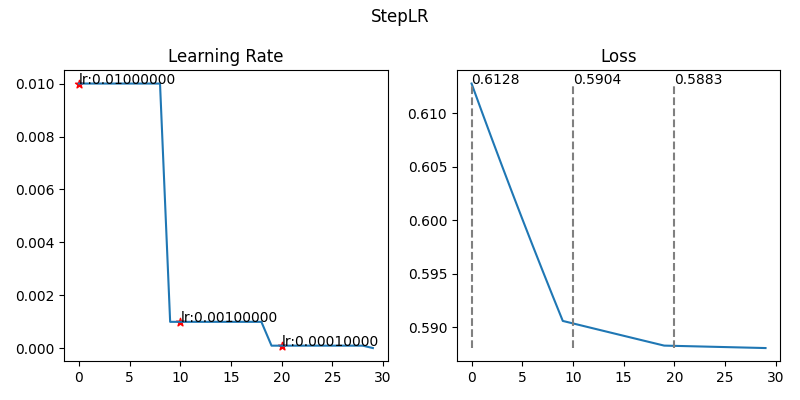

5.[Study] Learning Scheduler

Learning Rate 실습 Notebook목적학습에서 가장 중요한 hyper parameter인 Learning Rate와 이를 조절하는 Learning Rate Scheduler, WarmUp에 대한 필요성 및 작동 방식, 효과에 대해 공부Learning Rate

6.[Study] Tokenizers(nlp)

목적자연어 처리 모델들의 토크나이저들의 원리를 파악하여 장점, 단점을 확인 및 어떠한 방식으로 사용하는지 파악해보자한국어 토크나이저는 어떻게 발전했는지 알아보자현재 LLM에서 가장 많이 쓰이는 tokenizer는 Subword 기반(BPE, WordPiece, Sent