1. Cost Function

- 모든 input dataset에 대하여 오차를 계산하는 함수

- 모든 input dataset에 대해 계산한 Loss Function의 평균값

출처: 목표함수, 손실함수, 비용함수의 차이

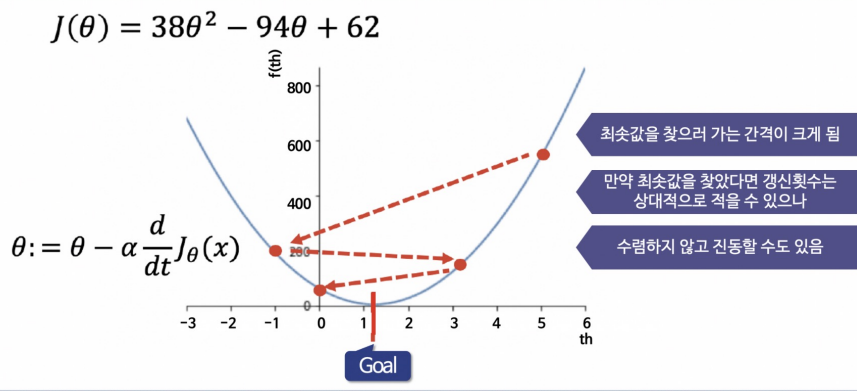

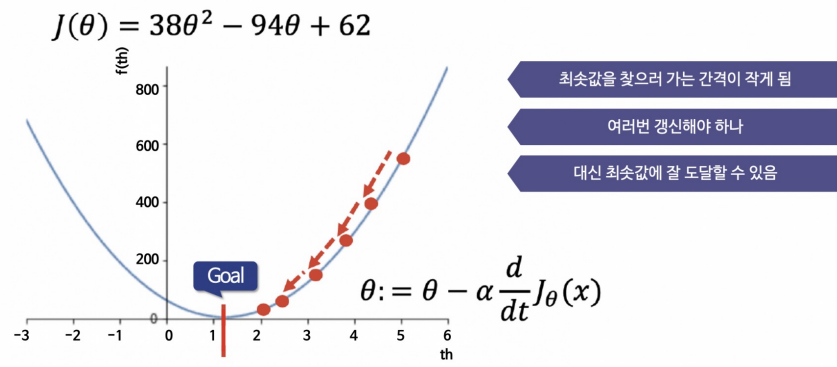

2. Gradient Descent(경사하강법)

-

함수 값이 낮아지는 방향으로 독립변수 값을 변형시켜가면서 최종적으로 최소 함수값을 갖도록 독립변수 값을 찾는 방법

-

미분계수가 0인 지점을 찾는 것을 컴퓨터가 구현하기 어려울 정도로 함수의 형태가 복잡할 때(ex: 비선형함수) 활용

-

다음 값 = 현재값 - 미분값(현재값) : 최소값으로 수렴하게 된다.

-

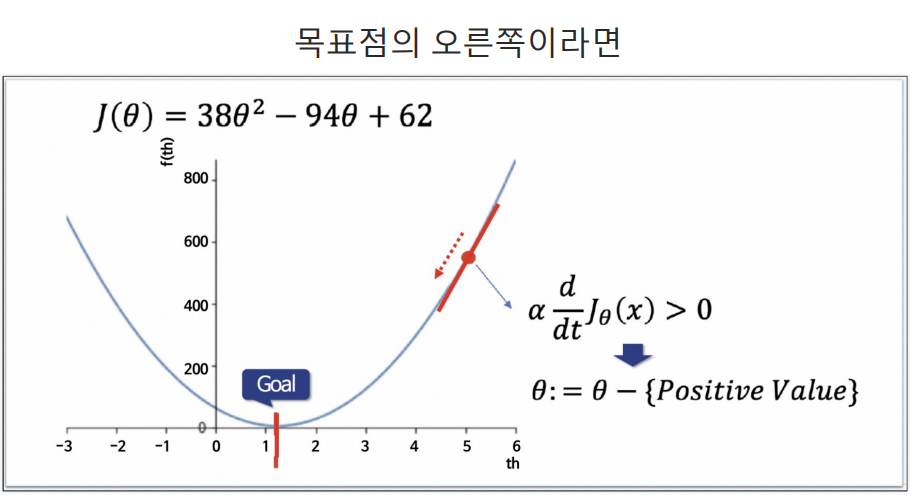

경사 상승중일 때: 미분값(세타) (+) -> 왼쪽으로 이동

-

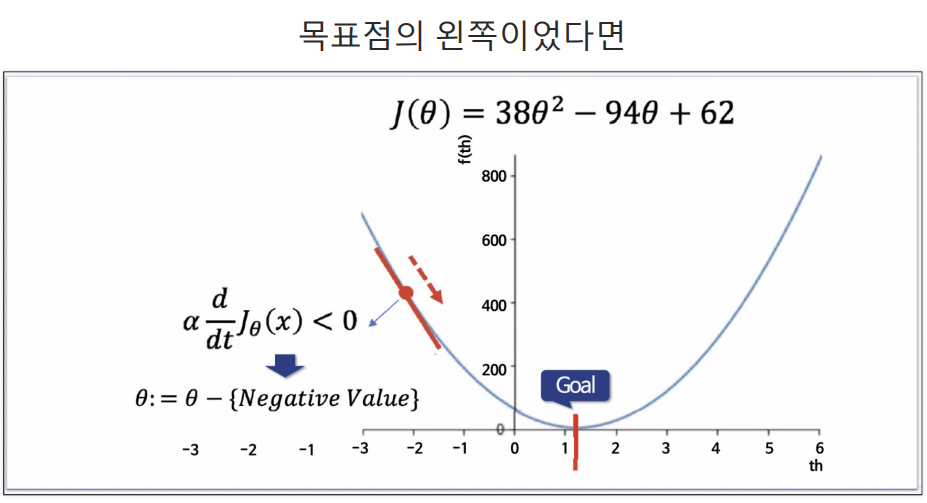

경사 하강중일 때: 미분값(세타) (-) -> 오른쪽으로 이동

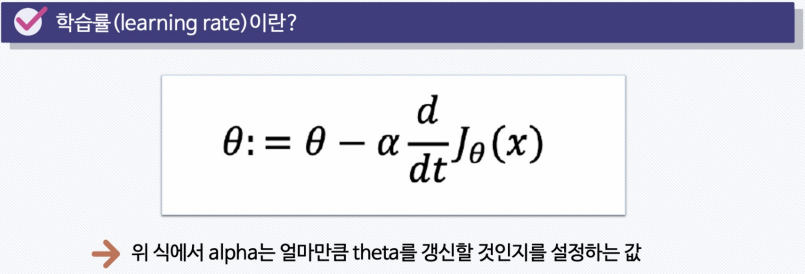

3. 경사하강법의 학습률

- 경사 하강하는 정도를 학습률을 통해 조절할 수 있다.

- 학습률이 작을 때

- 학습률이 클 때