Perceptron was introduced by Frank Rosenblatt in 1957. He proposed a Perceptron learning rule based on the original MCP neuron. A Perceptron is an algorithm for supervised learning of binary classifiers. This algorithm enables neurons to learn and processes elements in the training set one at a time.

1. Perceptron

Cũng giống như các thuật toán lặp trong K-means Clustering và Gradient Descent, ý tưởng cơ bản của PLA là xuất phát từ một nghiệm dự đoán nào đó, qua mỗi vòng lặp, nghiệm sẽ được cập nhật tới một ví trí tốt hơn. Việc cập nhật này dựa trên việc giảm giá trị của một hàm mất mát nào đó.

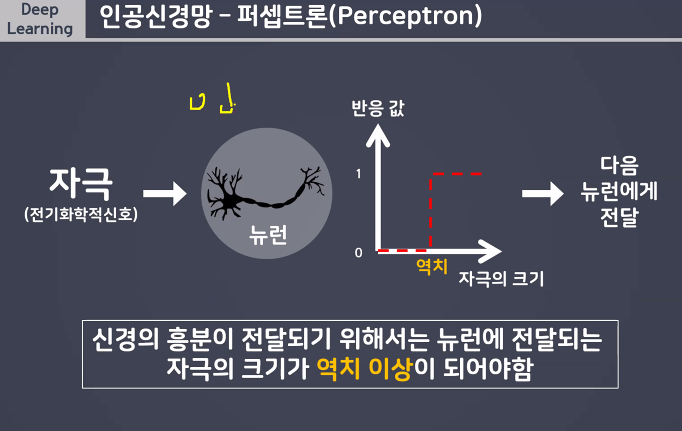

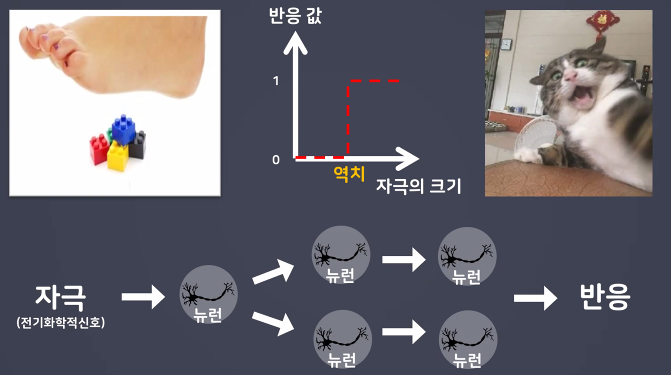

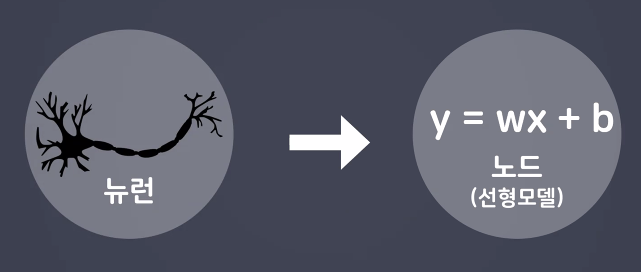

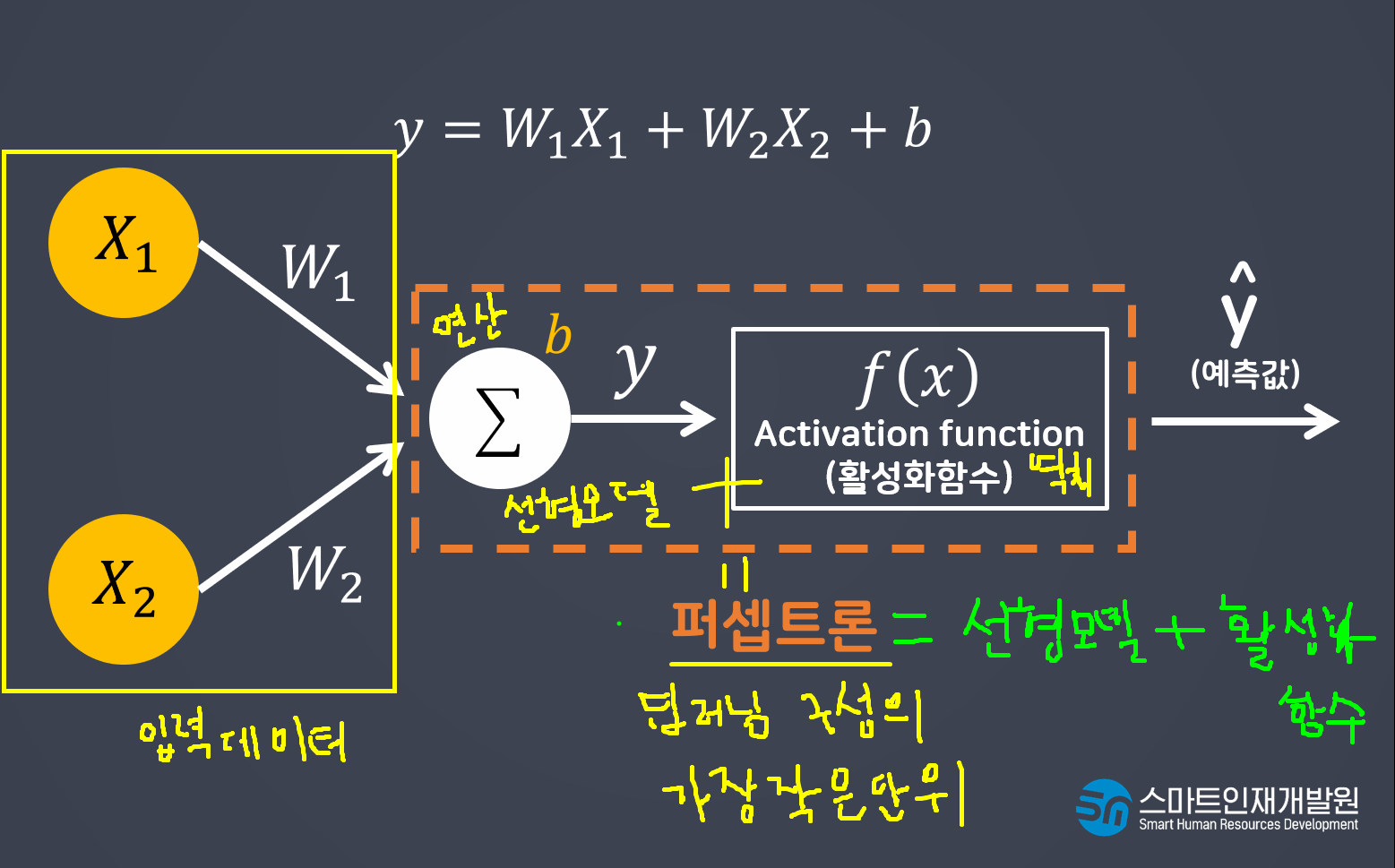

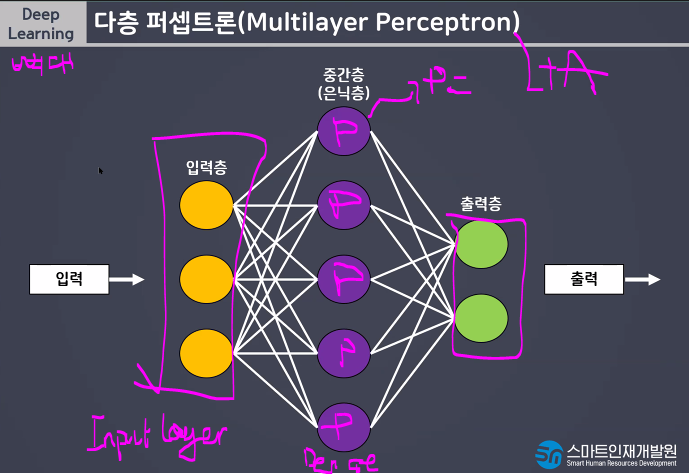

인공신경망 구성요소 중 하나로 딥러닝 모델의가장 작은 가본단위 뇌를 구성하는 신경새포인 뉴런의 동작과 유사하게 (similar) 동작

Basic Components of Perceptron

Perceptron is a type of artificial neural network, which is a fundamental concept in machine learning. The basic components of a perceptron are:

- Input Layer: The input layer consists of one or more input neurons, which receive input signals from the external world or from other layers of the neural network.

- Weights: Each input neuron is associated with a weight, which represents the strength of the connection between the input neuron and the output neuron.

- Bias: A bias term is added to the input layer to provide the perceptron with additional flexibility in modeling complex patterns in the input data.

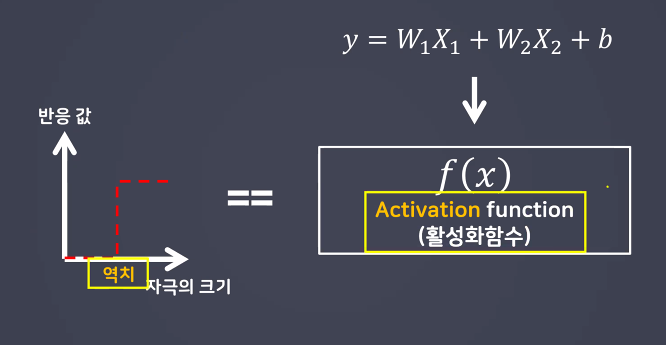

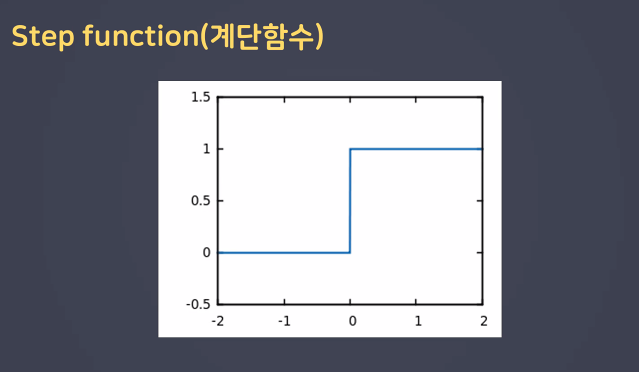

- Activation Function: The activation function determines the output of the perceptron based on the weighted sum of the inputs and the bias term. Common activation functions used in perceptrons include the step function, sigmoid function, and ReLU function.

- Output: The output of the perceptron is a single binary value, either 0 or 1, which indicates the class or category to which the input data belongs.

- Training Algorithm: The perceptron is typically trained using a supervised learning algorithm such as the perceptron learning algorithm or backpropagation. During training, the weights and biases of the perceptron are adjusted to minimize the error between the predicted output and the true output for a given set of training examples.

Overall, the perceptron is a simple yet powerful algorithm that can be used to perform binary classification tasks and has paved the way for more complex neural networks used in deep learning today.

(역치 개념 추가)

where: x1, x2: 입력데이터

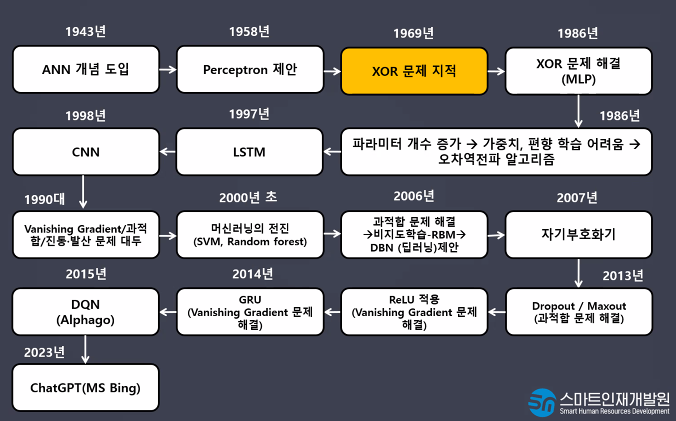

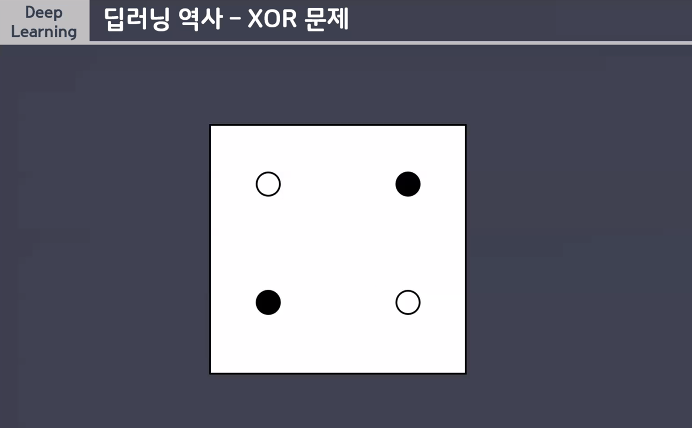

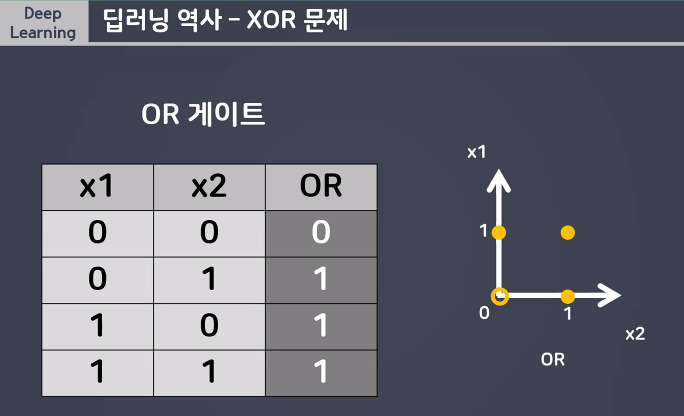

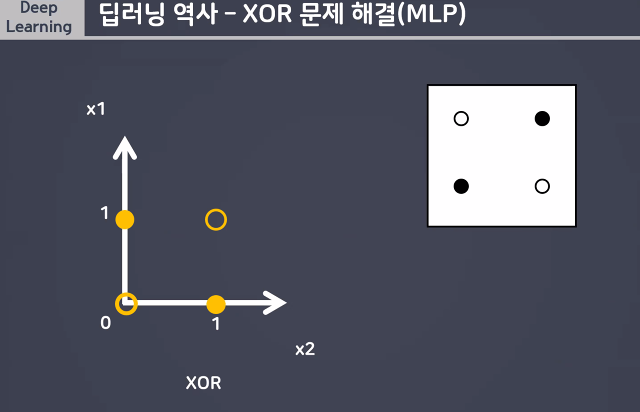

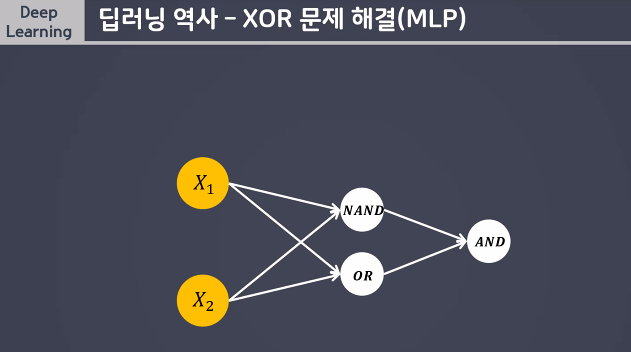

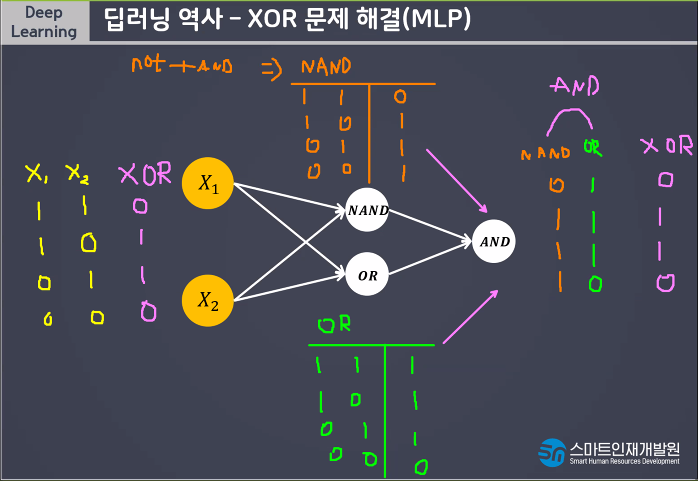

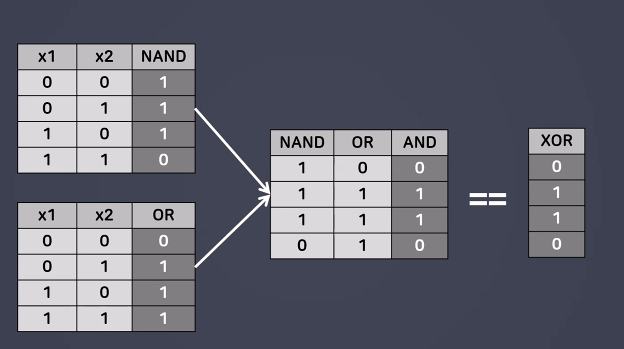

XOR 문제 지적

OR: 같은 면 0, 다르면 1

이걸할 수 없어

이렇게 해야함!!!

(NAND = not and)

- 한 번의 연산으로 해결되지 않은 문제를 해결할 수 있다

- 단층에 비해 학습시간이 오해 걸린다

- 모델(신경망) 복잡해지면서 학습시 과대적합되기 쉽다.

Activation Function 활성화 함수

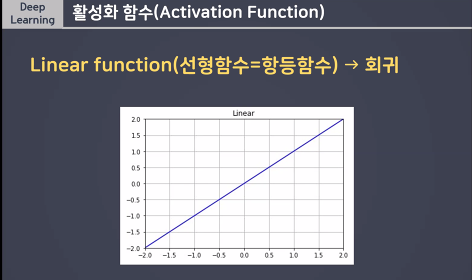

회귀 -> 직선함수 사용

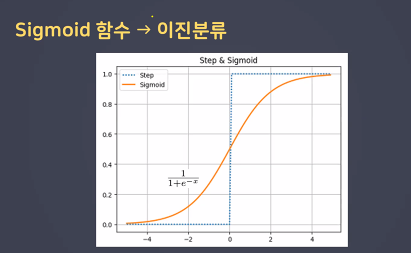

이진분류 -> Sigmoid함수 사용

활성화함수 (Activation Function) 의 역할

활성화함수는 중간층, 출력층에서의 역할이 다르다

- 중간층 (역치) (역치개념>활성화여부)

- 초기의 형태: 계단함수 (step function) -> 시그모이드(sigmoid) y = wx+b

- 출력층 (출력데이터의 형태를 변환)

- 회귀: 항등함수 (linear) y = x 선형모델이 풀력한 결과를 그대로 출력해주기 위함 (변화해줄 필요가 없기때문)_default값이기 때문에 따로 적어주지 않아도됨!

- 이진분류: 시그모이드 분류는 확률값(0~1)으로 변환이 필요하기 때문!