👨🏫학습목표

오늘은 Policy Gradient algorithm의 대표적인 모델 REINFORCE에 대해 배워볼 예정이다.

👨🎓강의영상: https://www.youtube.com/watch?v=CH09gfU7ko4&list=PLvbUC2Zh5oJtYXow4jawpZJ2xBel6vGhC&index=22

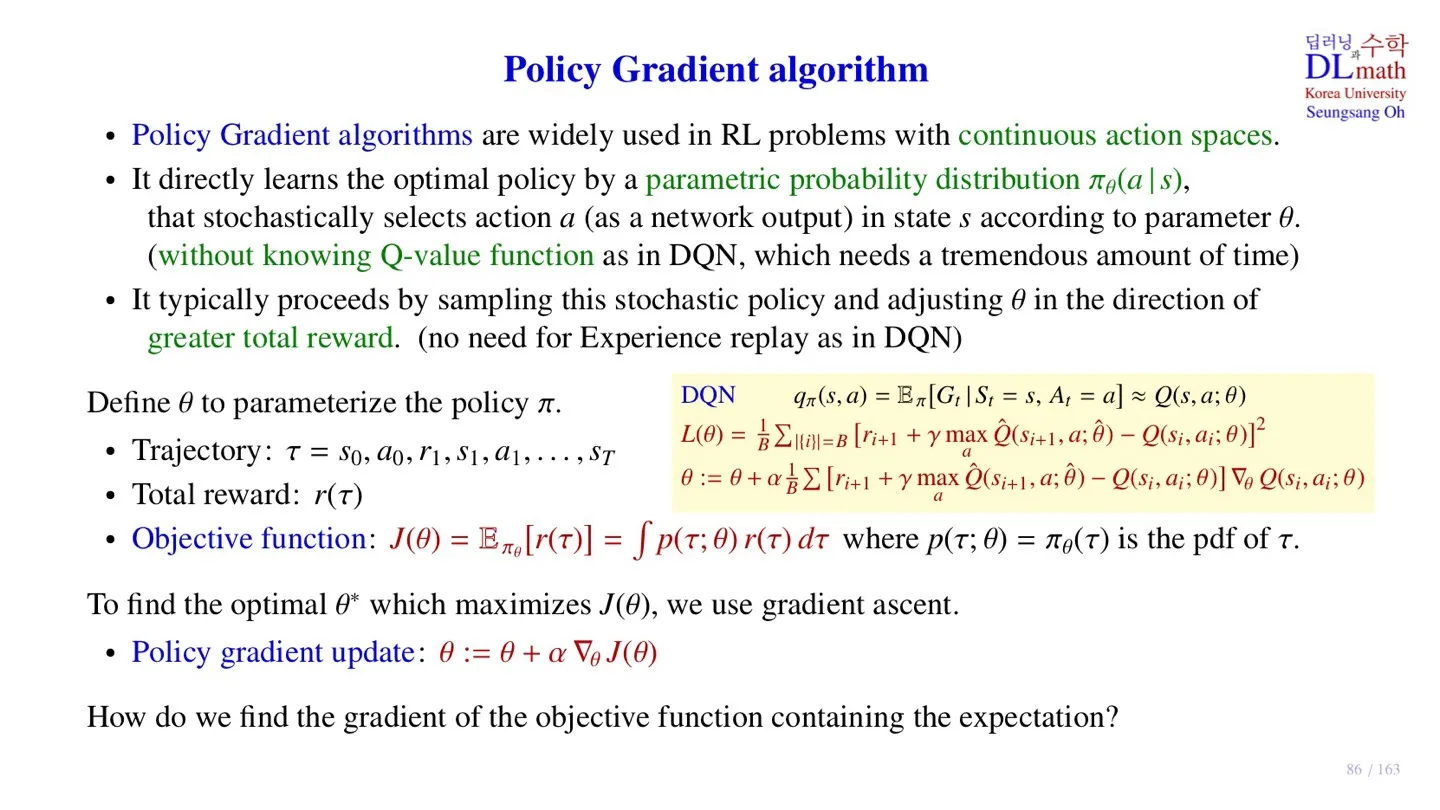

0️⃣ Policy Gradient algorithm

📕 지난 시간에 배운 내용

🔸 Policy Gradient algorithm은 DQN과 구별되는 2가지 특징이 있다.

- Neural Network를 통해 policy를 직접 학습한다.

- Total reward를 maximize하는 방향으로 학습한다.

🔸 Policy Gradient algorithm의 출력

- 입력 state에 대한 action 를 stochastic하게 출력한다.

- 파라미터가 optimal하게 고정되더라고 stochastic하게 출력 가능하다.

- Action을 직접 출력하기 때문에 continuous한 출력이 가능하다.

1️⃣ REINFORCE

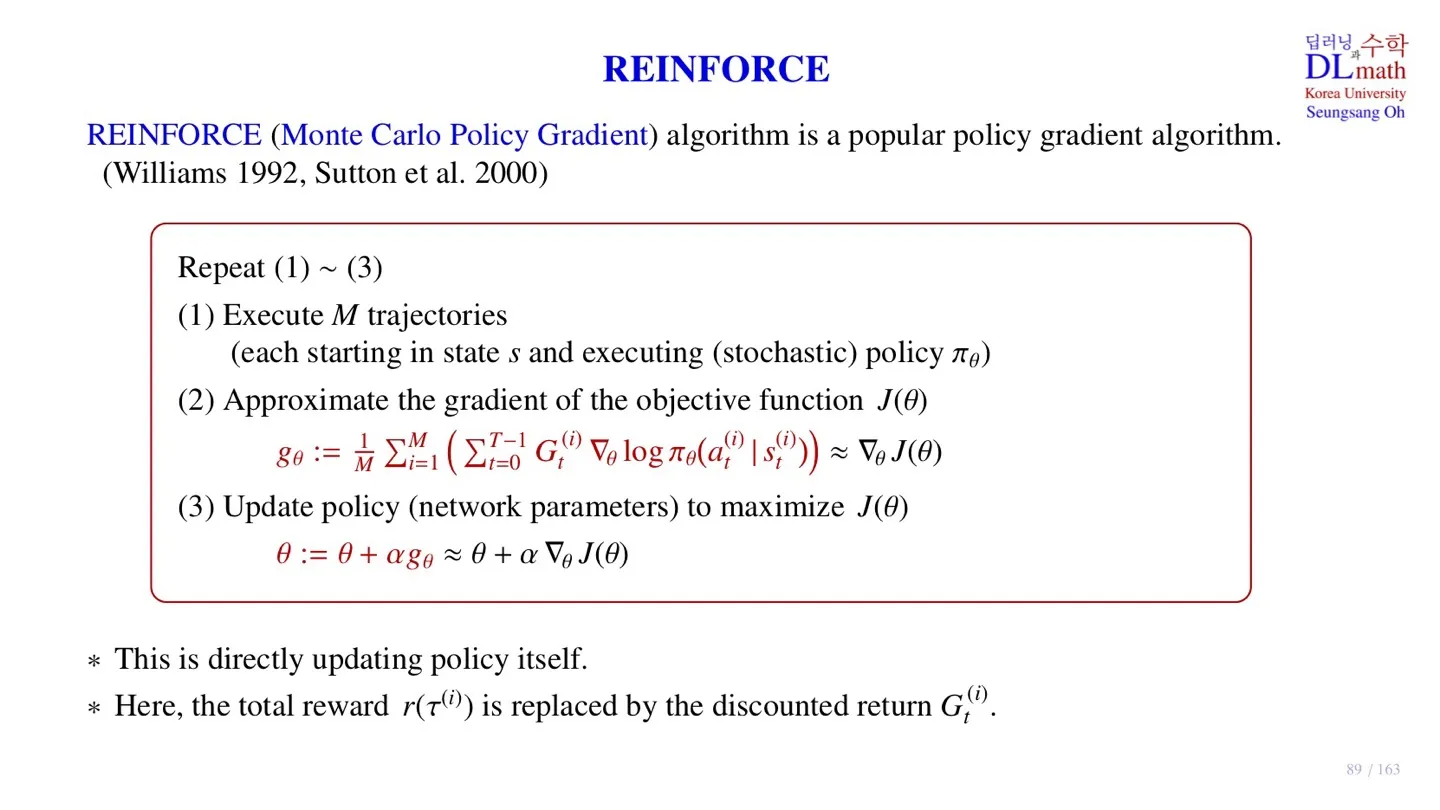

🔷 REINFORCE (Monte Carlo Policy Gradient)

- Policy Gradient방식에 Return 값을 사용하기 때문에 Monte Carlo Policy Gradient 라고 한다.

- Policy Gradient방식으로 policy를 직접 업데이트한다.

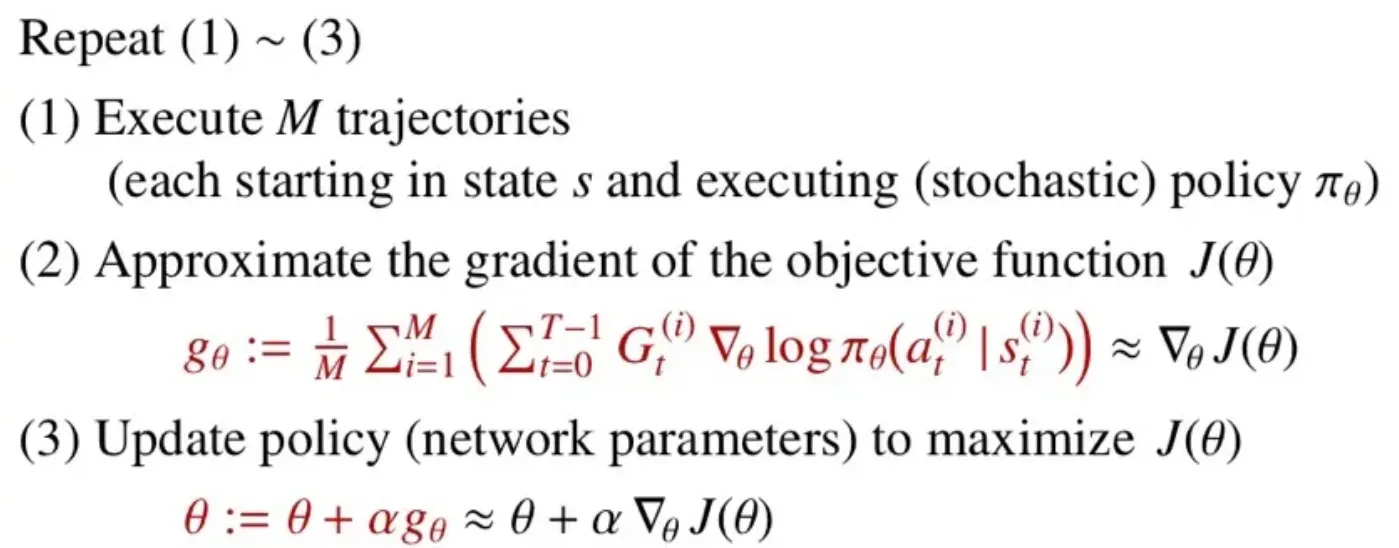

🔻 Pseudo code

🔸 1. Execute M trajectories

- 주어진 policy 에서 Minibatch의 크기 개의 episode sample을 수집한다.

- State 에서 시작하여 데이터를 수집한다.

🔸 2. Approximate the gradient of the objective function

- Return 를 통해 objective function을 계산한다.

- 개의 minibatch에 대한 평균을 통해 gradient를 근사한다.

🔸 3. Update policy to maximize

- 파라미터를 업데이트한다.

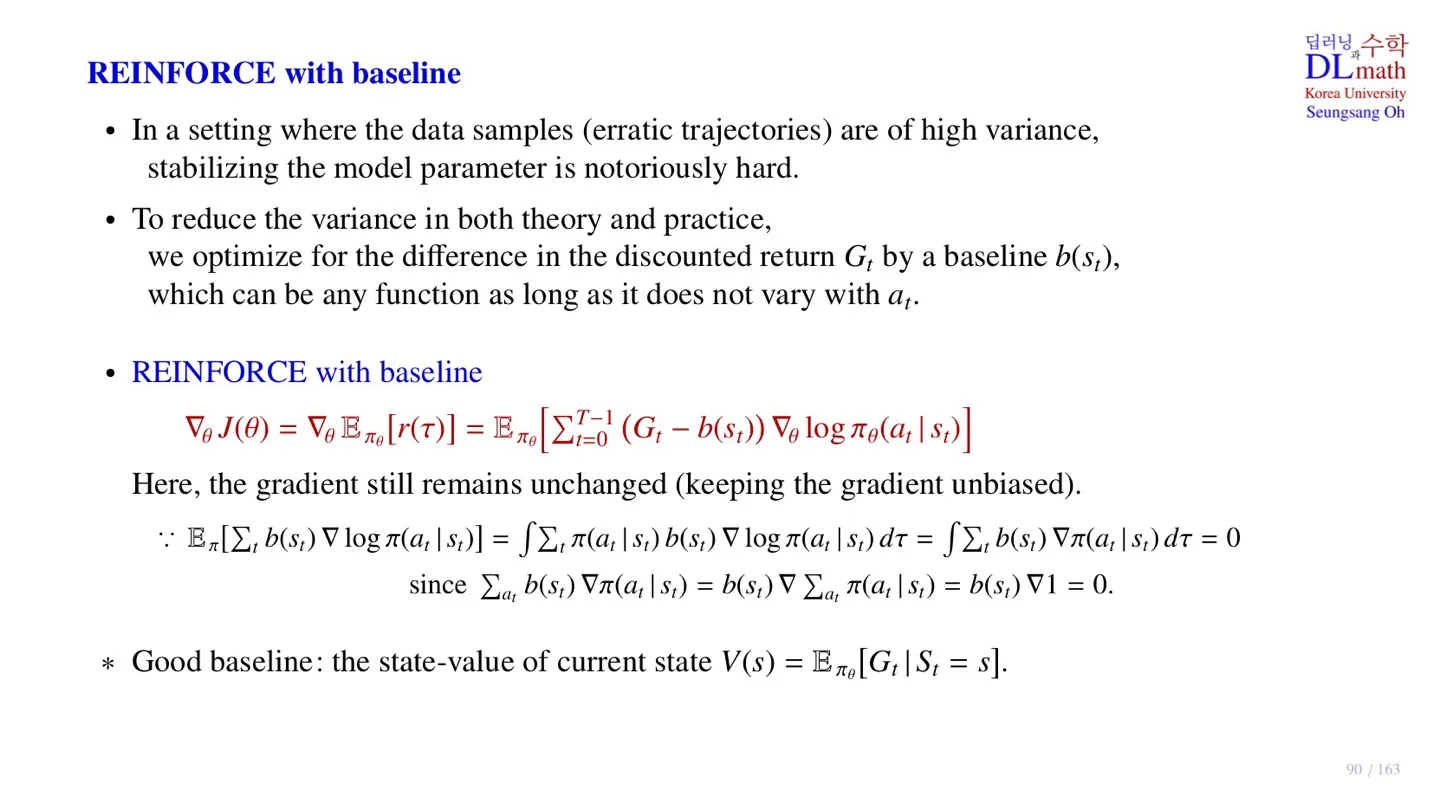

2️⃣ REINFORCE with baseline

🔷 Episode sample 데이터의 한계

- 모델에 policy를 따라 데이터를 수집할 때, 매 step마다 stochastic하게 선택되기 때문에 step이 길어질수록 점점 variance가 커진다.

- Variance가 클수록 학습 과정이 요동치는 것을 확인할 수 있다.

| 종류 | Monte Carlo | Temporal Difference |

|---|---|---|

| Bias | X | O |

| Variance | 크다 | 작다 |

Monte Carlo와 Temporal Difference의 bias에 대한 추가적인 내용은 아래 글에서 확인 가능하다.

📃자료: https://velog.io/@tina1975/Deep-Reinforcement-Learning-14강-Temporal-Difference-Learning-2

🔻 Episode sample 데이터 사용 시 목표

- Sample 데이터의 variance를 줄인다.

- Sample 데이터의 bias를 없애야 한다.

🔷 REINFORCE with baseline

- Baseline 을 추가하여 variance를 줄여준다.

- Baseline 는 action에 독집적이고, state에 의해 결정된다.

- 기존의 은 unbiased하다.

- Baseline 을 추가하여 bias가 생길 수 있기 때문에 bias가 생기지 않는다는 이론적 근거가 필요한다.

- 즉 expectation값 자체가 변하지 않아야 한다.

🔻 Bias가 생기지 않는다는 이론적 근거

- 우리는 위 식이 성립함을 보여야 한다.

- Expectation을 모든 trajectory에 대해 적분으로 표현한다.

- 의 미분 형태에 따라 이므로 위 식이 성립한다.

를 살펴보면

- Baseline 은 action과 무관하므로 에서 빠져나온다.

- 모든 action에 대한 의 합은 1이므로 위 식이 유도된다.

- 위 내용을 연결하면 Baseline을 추가한 식이 0이 됨을 확인할 수 있다.

- 따라서 Baseline을 추가하더라도 gradient의 값에 영향을 주지 않는다.

🔻 Baseline값

- Baseline은 action에 무관한 값을 사용해야 한다.

- 보통 state-value function을 많이 사용한다.

- State-value function은 return 의 평균값이다.

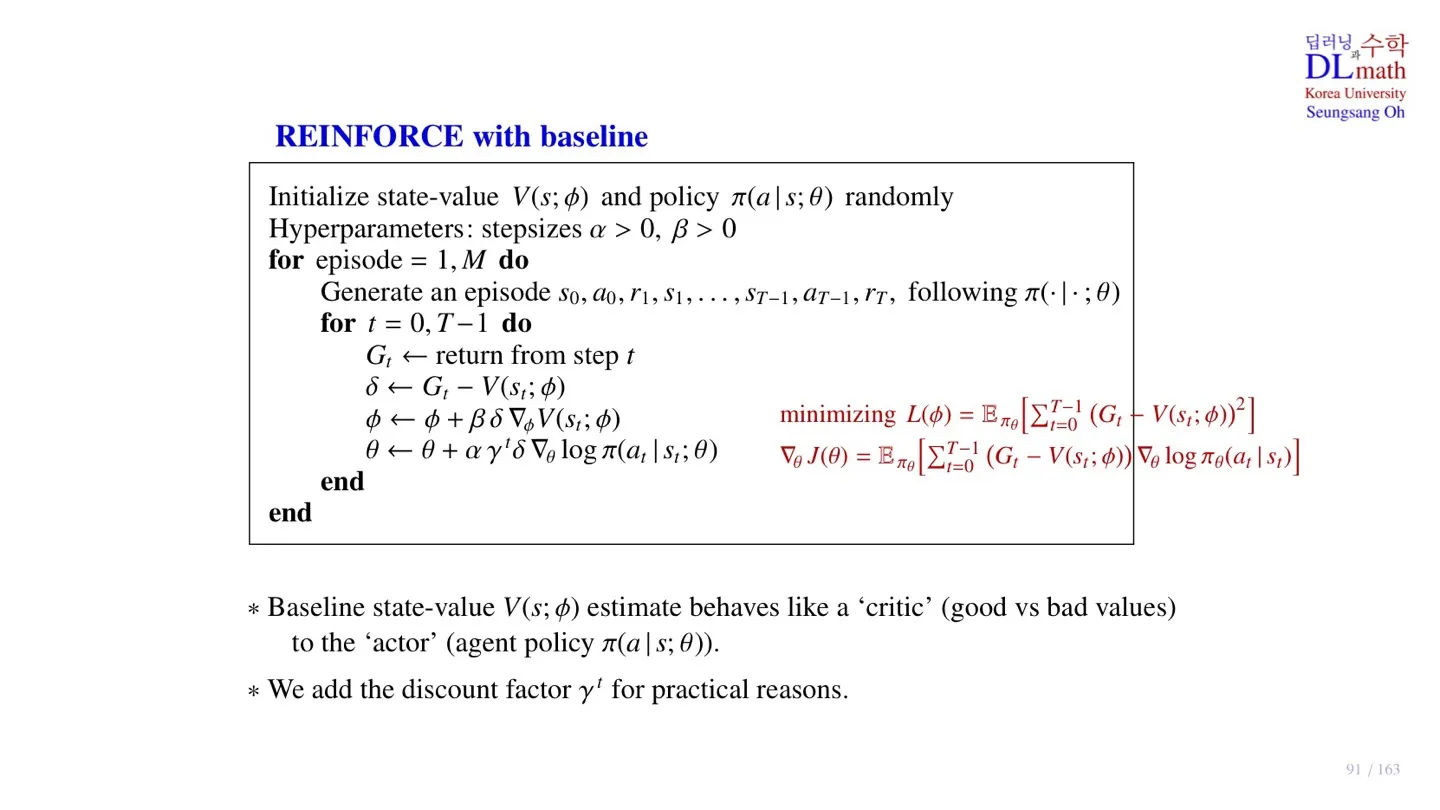

3️⃣ REINFORCE의 pseudo code

🔷 REINFORCE with baseline의 구조

- State-value 를 추정하는 Network와 policy 를 추정하는 Network가 있다.

- Network가 2개이므로 step size 역시 2개가 필요하다.

🔻 작동과정

- 주어진 state 에 대한 sample 데이터를 수집한다.

- 수집한 데이터를 통해 return 를 구한다.

- 파라미터 와 를 업데이트할 때 사용되는 값을 정의한다.

- State-value function 에 대한 업데이트를 진행한다.

- 파라미터 를 수집한 return 값에 가까워지도록 학습한다.

- Policy에 대한 파라미터 를 업데이트한다.

- Discount factor 는 practical한 이유로 추가하였다.

- 업데이트의 방향을 의미하는 Network를 actor라고 부른다.

- 업데이트의 크기를 의미하는 Network를 critic이라고 부른다.

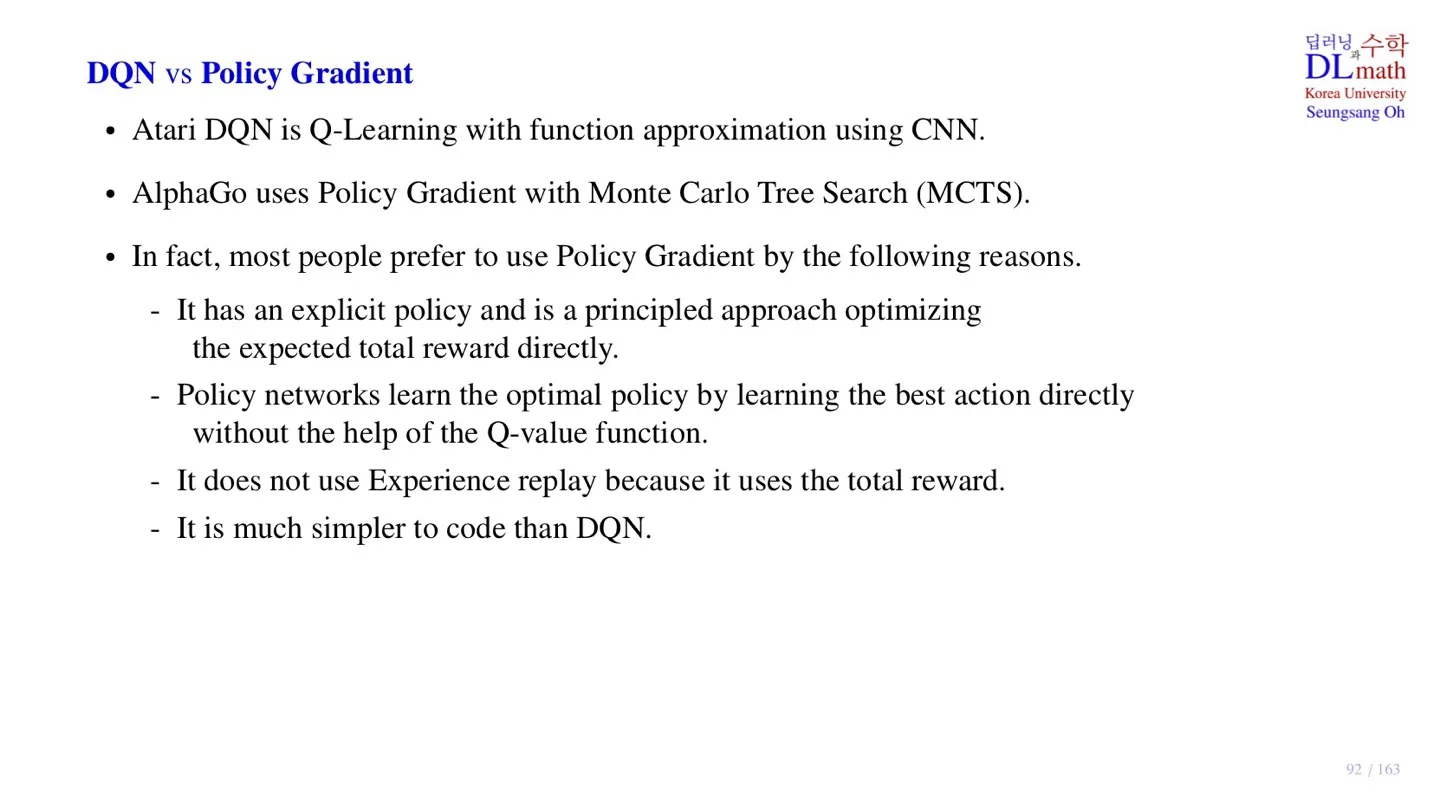

4️⃣ DQN & Policy Gradient

🔷 DQN

- Q-learning에서 Q-table을 Q-Network로 근사한다.

- 대표적인 모델 : Atari DQN

- Optimal Q-value를 통해 policy를 구한다.

- Temporal correlation을 막기 위해 Experience Replay를 사용한다.

🔷 Policy Gradient

- Network를 통해 Policy를 직접 근사한다.

- 대표적인 모델 : AlphaGo

- Expected total reward를 통해 policy를 업데이트한다. → Reinforcement Learning의 핵심 아이디어

- Total Reward를 사용하기 때문에 temporal correlation 문제가 발생하지 않는다.

- 그 결과 코드 역시 훨씬 간단하다.

5️⃣ 정리

🔷 22강에서 배운 내용은 아래와 같다.

- REINFORCE는 Return 를 통해 policy를 업데이트한다.

- REINFORCE의 pseudo code에 대해 살펴보았다.

- Return 를 통한 학습은 variance가 커진다는 한계가 존재한다.

- Action에 무관한 baseline을 통해 variance를 줄일 수 있다.

- Baseline이 있는 REINFORCE 모델의 pseudo code를 살펴보았다.