ELKStack

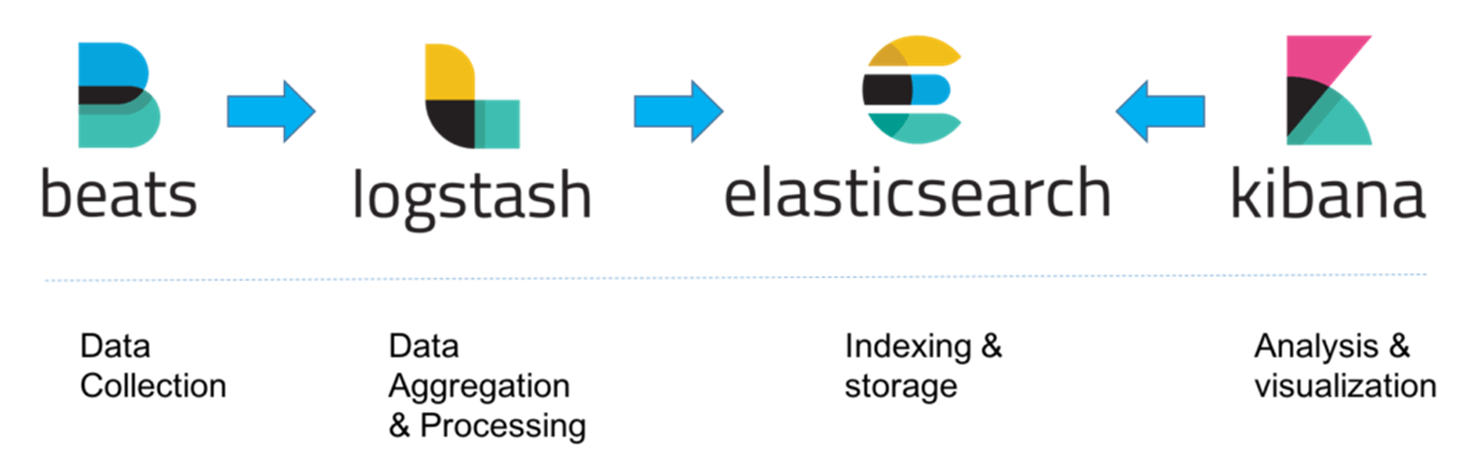

1.ELK

elastic에서 제공하는 Elasticsearch, Logstash, Kibana의 약어로 각각 로그 저장과 분석,검색, 로그 수집, 시각화를 담당하며 이에 추가로 경량 로그 수집기인 elastic의 beats를 추가하여 사용하기도 한다.각각의 프로그램은 독립적이며

2.docker를 이용한 ELK 설치

https://www.docker.com/products/docker-desktop/도커 공식 사이트에서 윈도우용 도커 데스크탑을 설치한다.기존 설치된 Docker 파일을 제거한다.apt package index를 업데이트하고 HTTPS를 통해 reposito

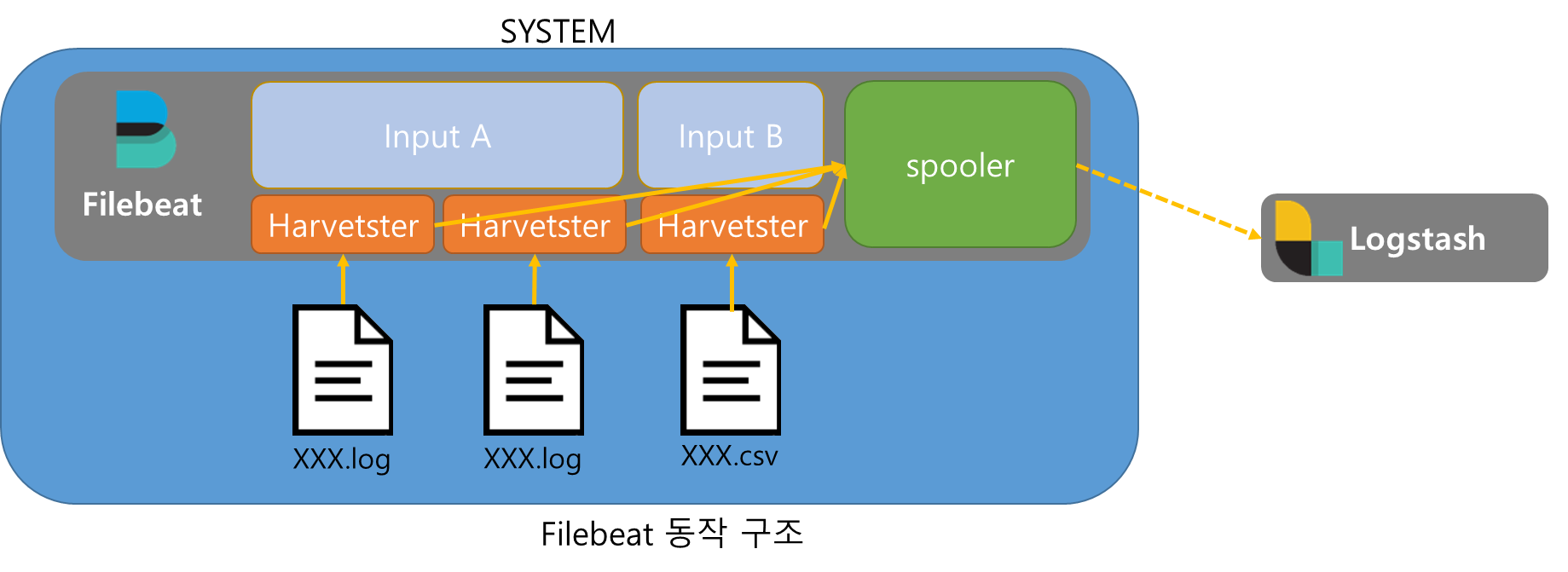

3.FileBeat

Filebeat는 Input, Harvester, Spooler로 구성되어있다.Harvester가 파일을 읽고 Spooler에 저장하여 Spooler가 지정된 Output(그림에서는 Logstash)에 데이터를 전송한다.Input은 경로를 입력받아 해당 경로에 존재하는

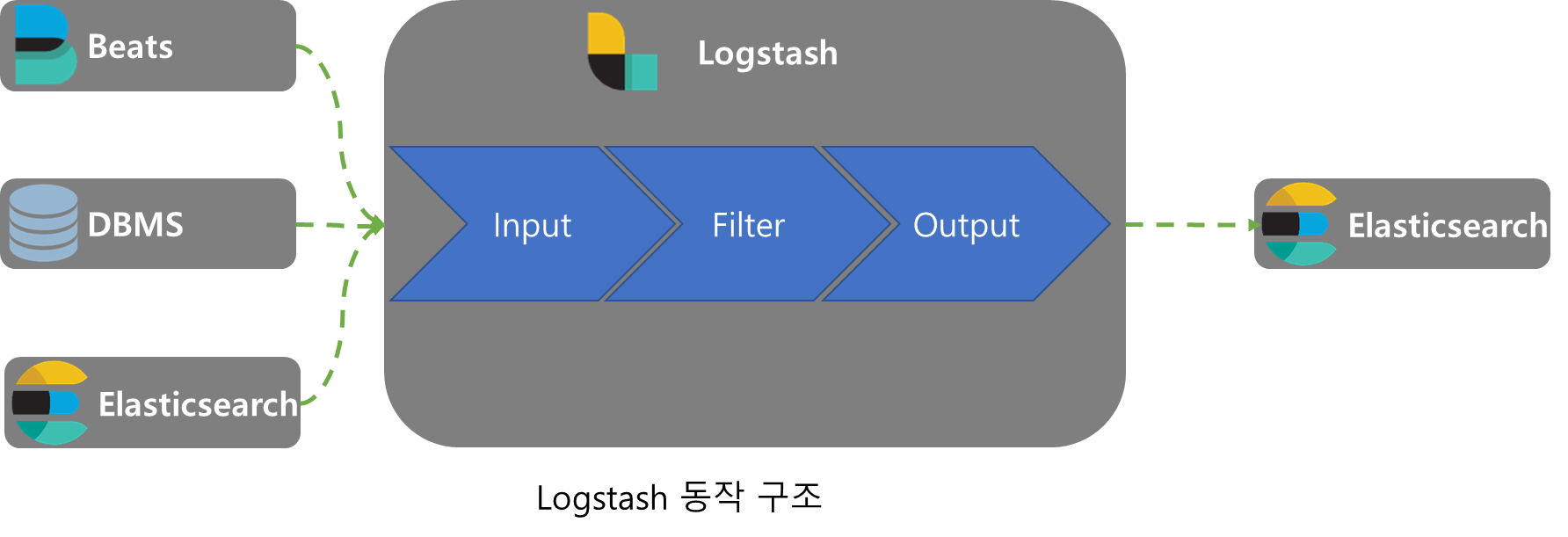

4.Logstash

Logstash는 Input, Filter, Output순서의 pipeline 구조로 이루어져있다.하나의 Logstash는 여러개의 pipeline을 가지며 각각의 pipeline은 여러개의 Input, Filter, Output을 가질 수 있다.데이터 수집과 정제기능

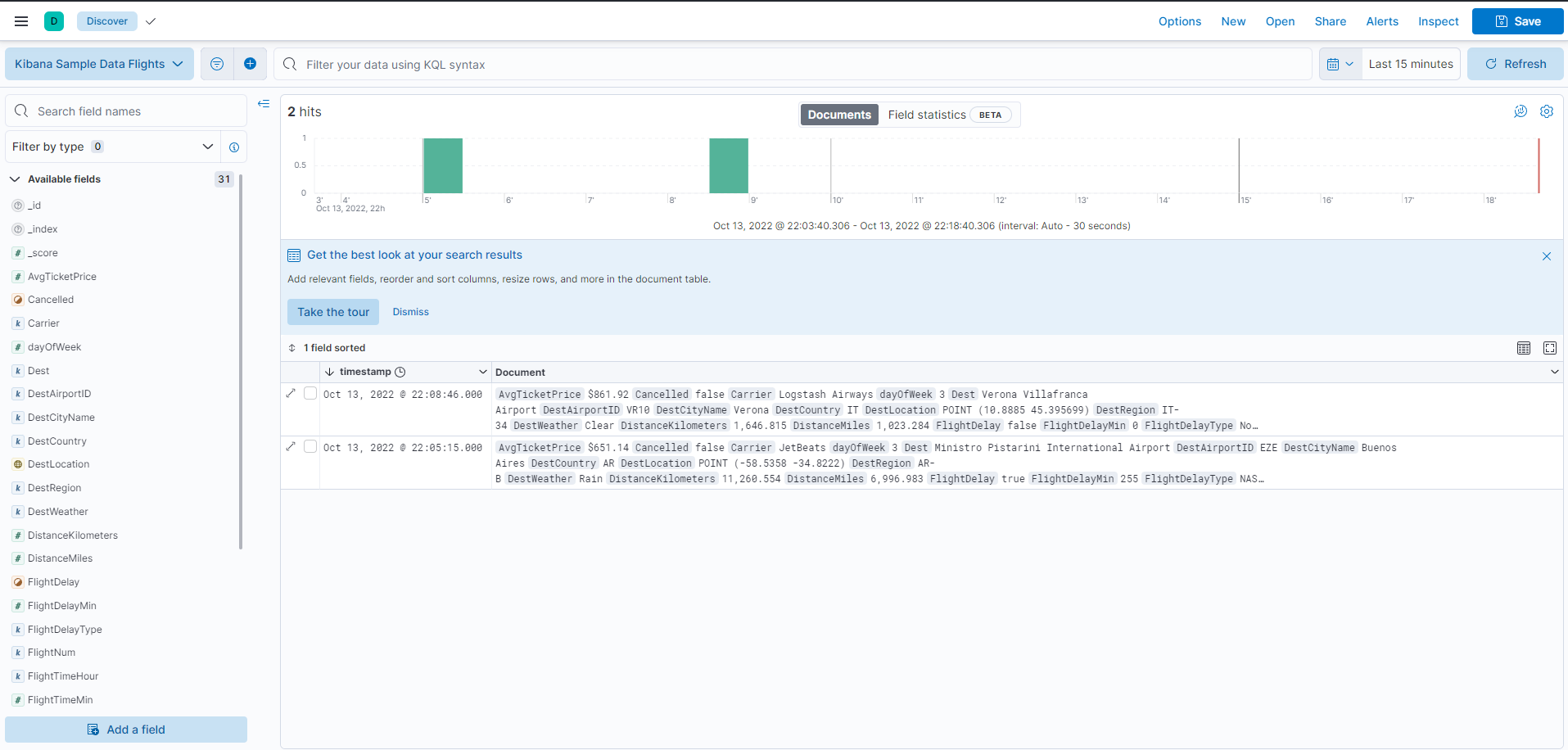

5.Elasticsearch

JSON 형식으로 데이터를 분산 저장하고 검색 및 분석 기능을 제공하는 엔진으로 index, shard, document로 이루어져 있음elasticsearch에서 고가용성을 제공하기 위해 여러개의 Elasticsearch를 묶어 Cluster 형태로 사용할 수 있다.

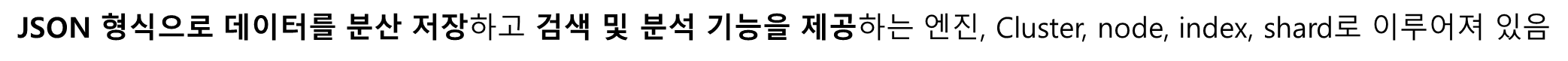

6.Kibana

Kibana에 접속하여 Try sample data를 클릭한다.other saple data set을 펼쳐 Sample flight data를 Add data한다.Discover 화면으로 이동하면 Kibana Sample Data Flights가 추가된것을 볼 수 있다

7.Elasticsearch RESTAPI CRUD

2. 조회