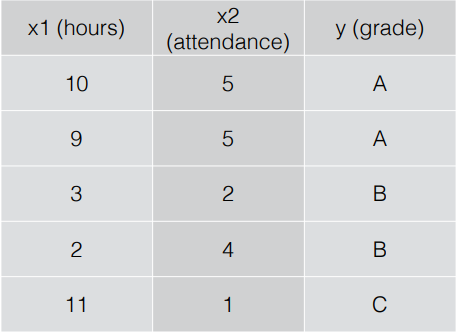

Multinomial Classification

: 여러개의 class로 이루어진 data를 classification하는 방법

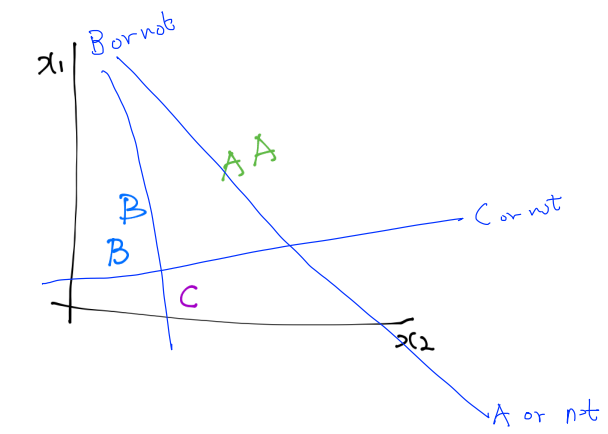

- A, B, C를 각각 분리하기 위해 3단계 과정을 거침

-> A인지 아닌지 / B인지 아닌지 / C인지 아닌지

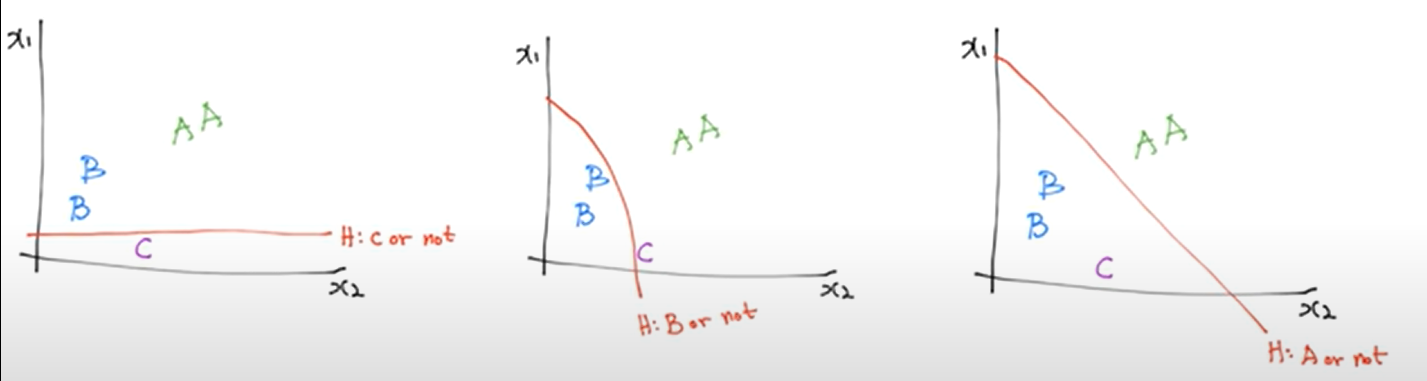

- 행렬식으로 나타내면 위와 같음

- 각각의 X와 w의 행렬곱을 통해 Y hat을 구함

-> But, 독립적으로 구할경우 class의 수가 클수록 복잡

- So, 행렬의 성질을 이용하여 Y hat을 쉽게 구함

- But, Y hat을 구했지만 원하는 결과가 아님

-> Y hat을 0~1 사이의 값으로 만들기 위해 sigmoid 함수를 사용

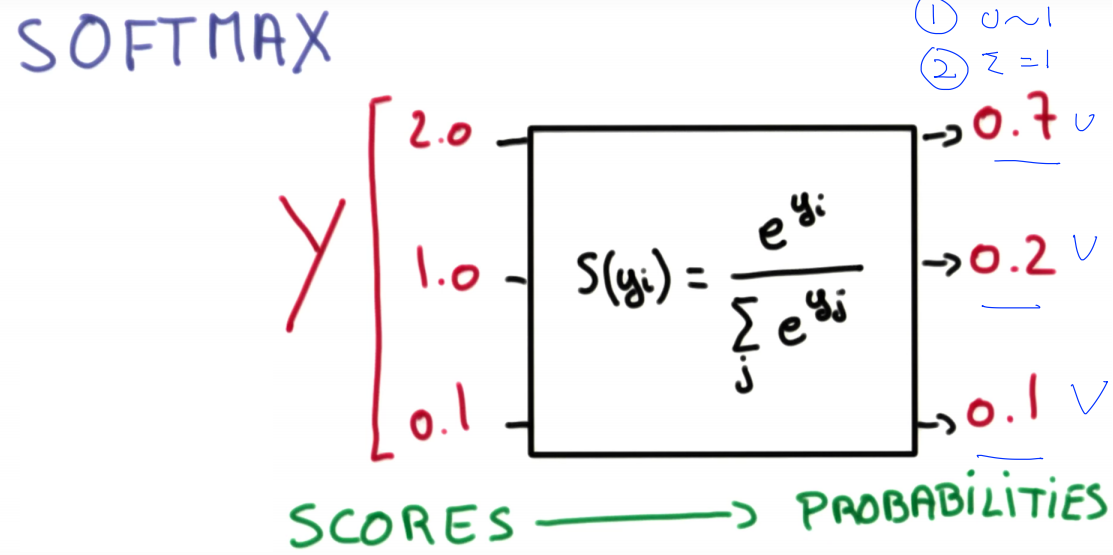

Softmax Regression

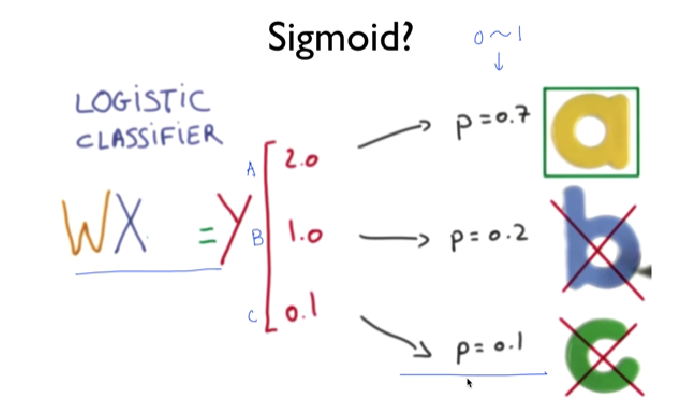

- Logistic Regression -> binary classification만 가능

-> 이를 multi class 구분으로 확장하기 위해 Softmax Regression을 사용

-

sigmoid의 결과 Y hat을 0~1사이의 값으로 변환하였지만 변환된 값들 간의 상대적인 차이를 알고싶을 때 사용

-

0~1사이의 값이며, 총합이 1인 확률 값으로 변환시켜줌

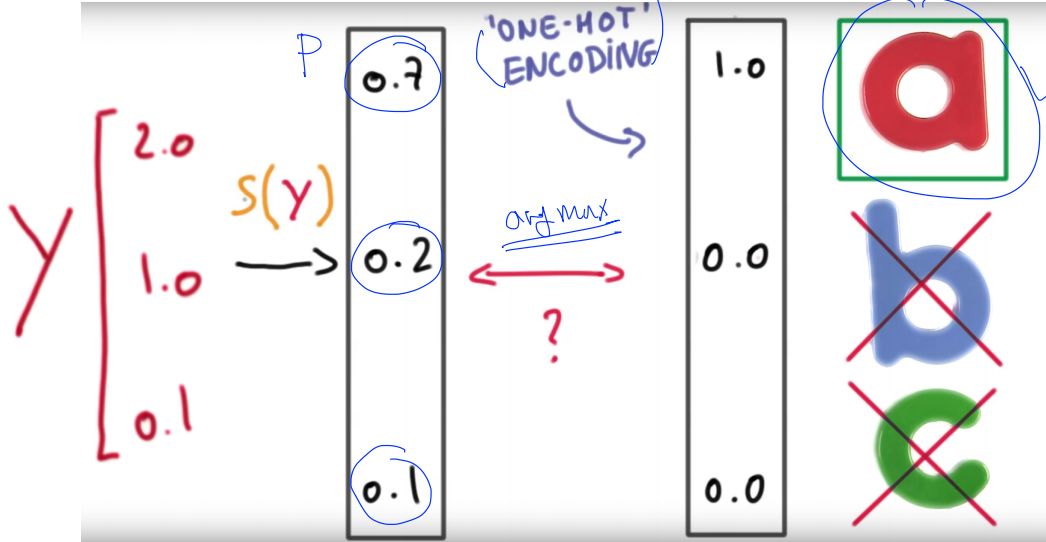

One-Hot Encoding

- Softmax를 이용

-> 첫번째 값이 A인것으로 가장 높은 확률로 예측 됨

-> 가장 높은 값을 1, 나머지는 의미가 없으므로 0 = One-Hot encoding 적용

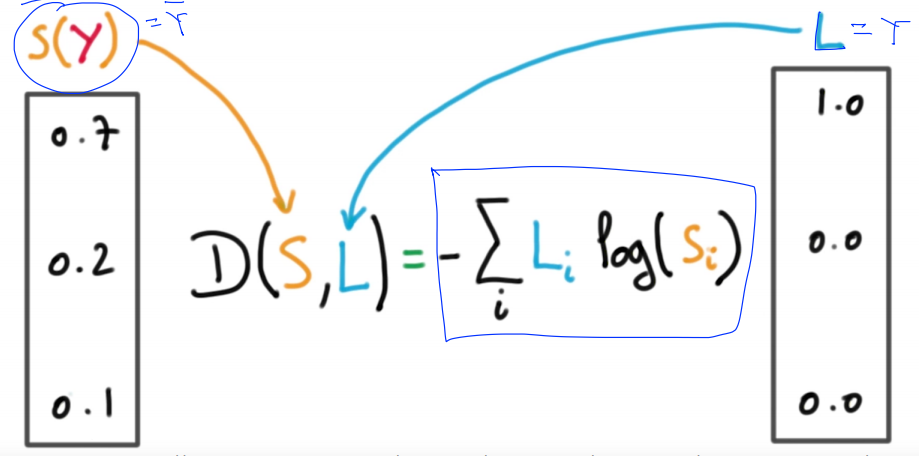

Cost Function - Cross Entropy 사용

: 예측값과 실제값의 차이(불확실성)를 검증할 때 사용

: P(x)와 Q(x) 2개의 확률분포가 주어졌을 때, 그 확률분포가 얼마나 비슷한지 나타낼 수 있는 수치

- entropy가 증가하면 불확실성이 증가

-> entropy를 감소시키는 방향으로 학습해야함

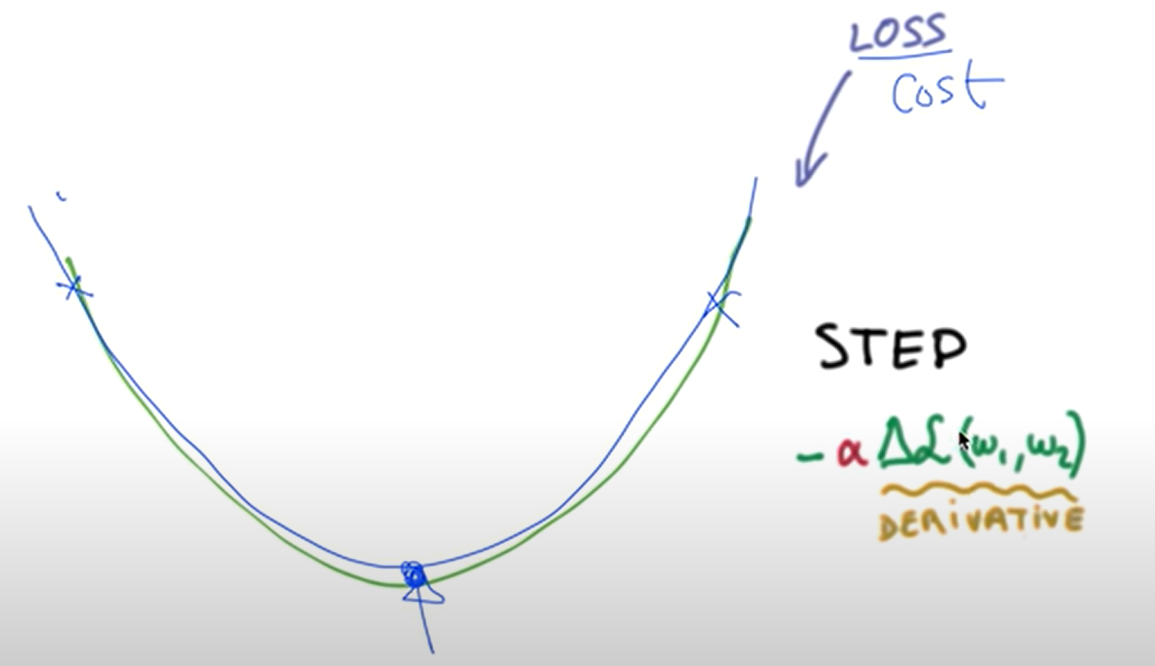

Gradient Descent

- convex function 처럼 생겼기 때문에 사용 가능

Logistic Cost VS Cross Entropy

-

의미상 차이가 없다고 해도 무방

-

차이점 : cost를 구하는 과정에서 행렬 이용유무