1. 프로젝트 목적

1차 프로젝트의 목적은 이커머스 데이터의 전체적인 큰 그림을 이해하는 것입니다. 퍼널분석을 통해 사내 데이터 인프라에서 내가 활용하는 데이터가 어떤 부분에 속하는지 이해하는 시간을 가져보았습니다.

2. 퍼널 분석

제공받은 csv파일을 MySQL에 삽입하고, MySQL을 Redash와 연동하였습니다. Redash에서 쿼리문을 실행하고 결과를 확인하며 프로젝트를 진행했습니다.

How to import csv file in MySQL

How to connect MySQL to Redash

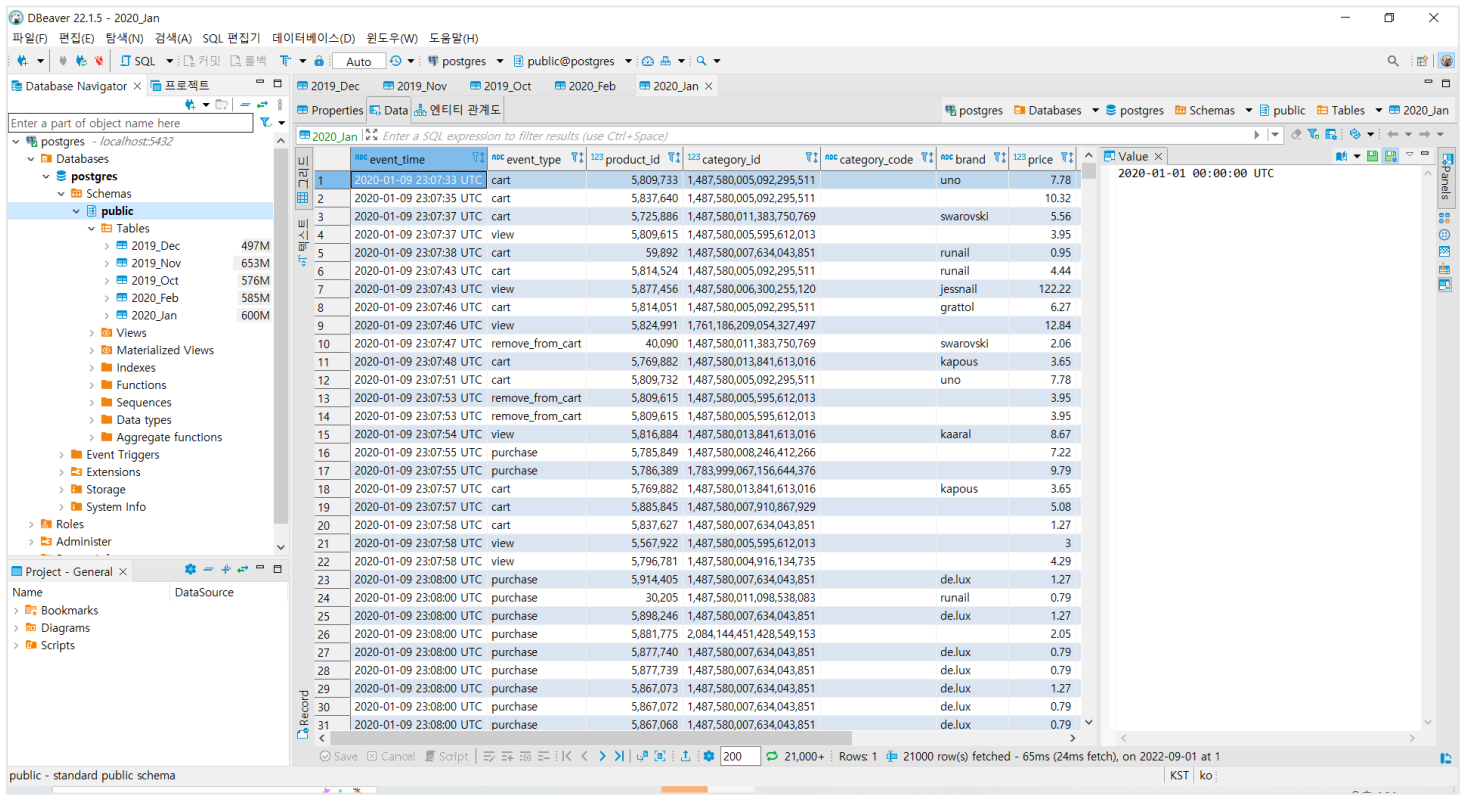

| 컬럼명 | 내용 |

|---|---|

| event_time | 이벤트 발생 시간 |

| event_type | 이벤트 타입 |

| product_id | 상품 아이디 |

| category_id | 카테고리 아이디 |

| brand | 브랜드명 |

| price | 가격 |

| user_id | 사용자 아이디 |

| user_session | ser_session |

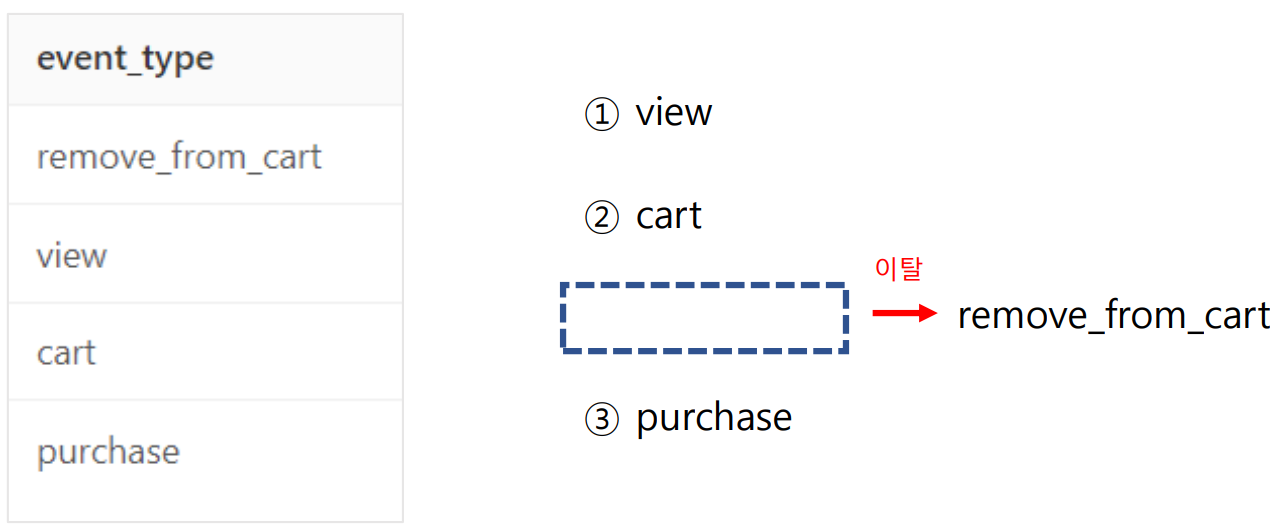

데이터 셋의 컬럼은 위와 같이 구성되어 있습니다. DISTINCT event_type으로 이벤트 타입을 조회해서 전체의 퍼널의 구성요소를 확인해볼 수 있었습니다.

퍼널은 이용자가 해당 상품의 상세페이지를 조회하고, 장바구니에 담고, 구매를 하는 것으로 구성되어 있습니다. 장바구니에서 삭제한 이벤트는 따로 'remove_from_cart'로 확인할 수 있습니다.

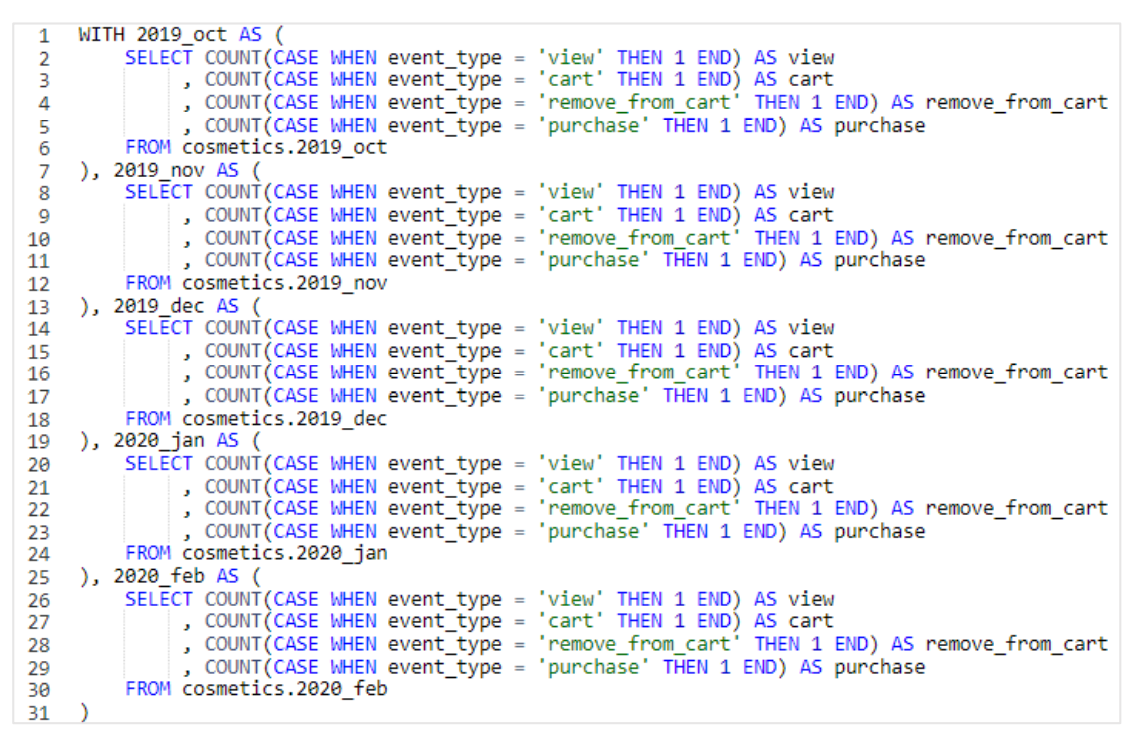

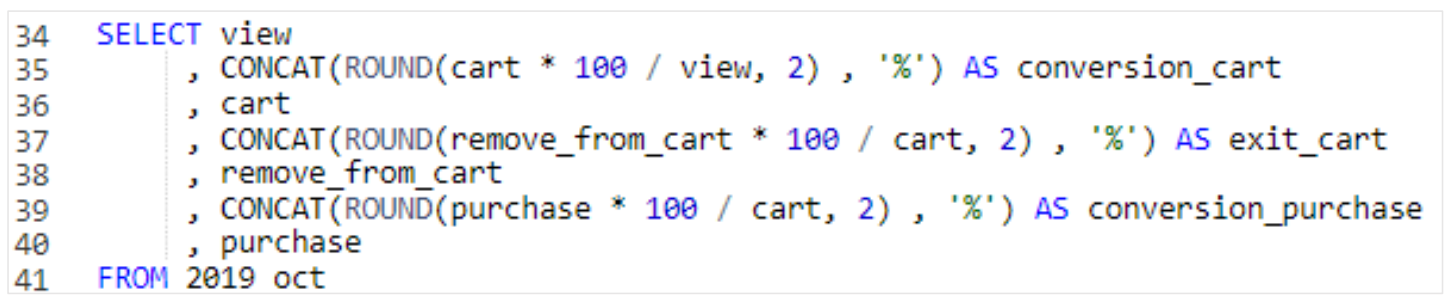

WITH구문과 CASE WHEN 조건문을 활용해 각 퍼널의 이벤트 수를 집계해보았습니다. 다시 확인을 해보니 GROUP BY로 쿼리를 짰으면, 쿼리문의 길이를 더 줄일 수 있지 않았을까 싶습니다.

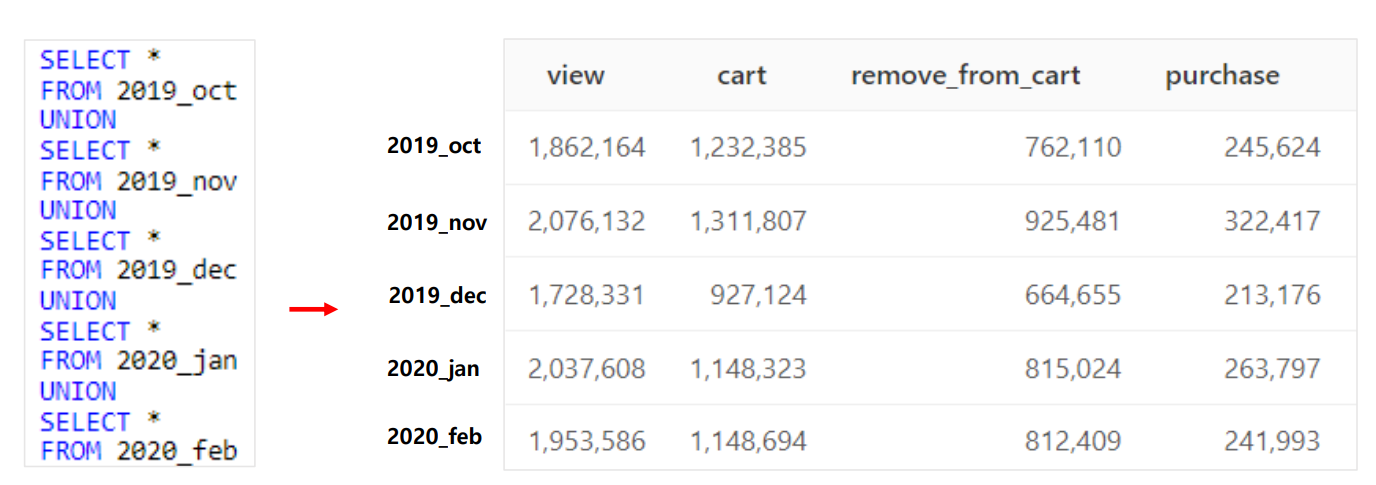

쿼리문을 실행하고 UNION으로 연결을 하면 위와 같은 결과를 얻을 수 있습니다. 이제 각 월별로 퍼널당 이벤트의 수를 확인할 수 있습니다.

3. 인사이트 도출

3.1 이상치 발견

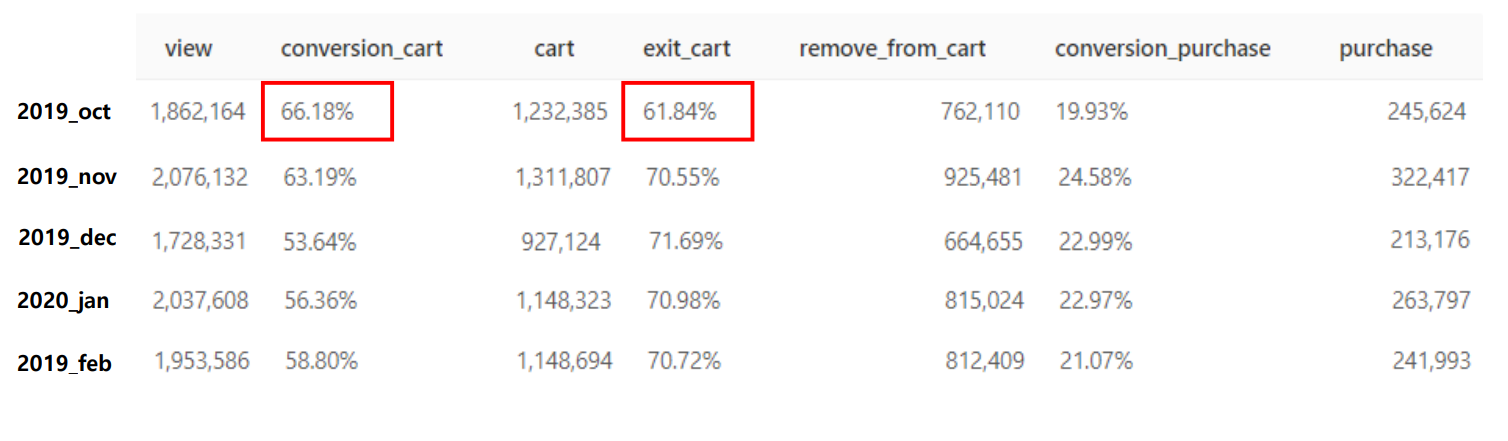

수치만 나와있으면 어떤 데이터가 중요한지 알기가 어려우므로 비율을 계산하여 이상치는 없는지 확인을 해보겠습니다.

2019년 10월에 경우, 유독 방문 유저가 상품을 장바구니에 많이 담는기도 하고, 장바구니에서 삭제도 잘 하지 않는다는 것을 알 수 있습니다.

추가적인 데이터를 확인해보아야겠지만, 10월에 장바구니와 관련된 이벤트를 진행했을 가능성이 높습니다.

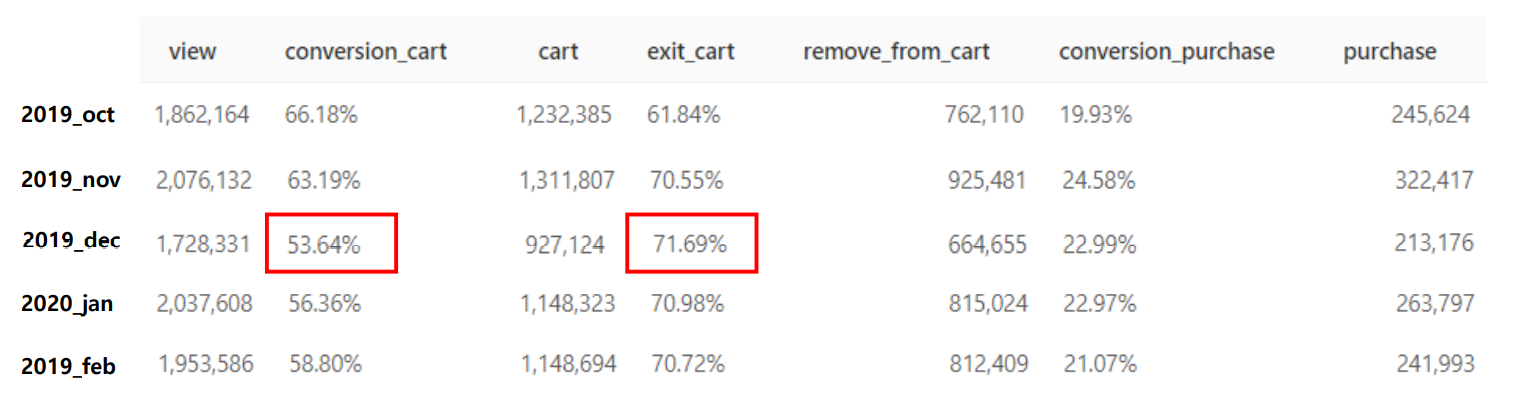

그리고 2019년 12월의 경우, 상품을 장바구니에 담는 액션이 저조합니다. 그리고 장바구니 삭제율도 높습니다.

이 경우 12월에는 어떠한 이유로 이용자들이 액션을 주저했는지 대내외적인 상황을 확인해볼 필요가 있습니다. 사회·경제적인 이슈가 있었을 수도 있고, 아니면 경쟁사에서 대규모 할인 이벤트를 진행하고 있었을 수도 있습니다.

3.2 퍼널의 구성

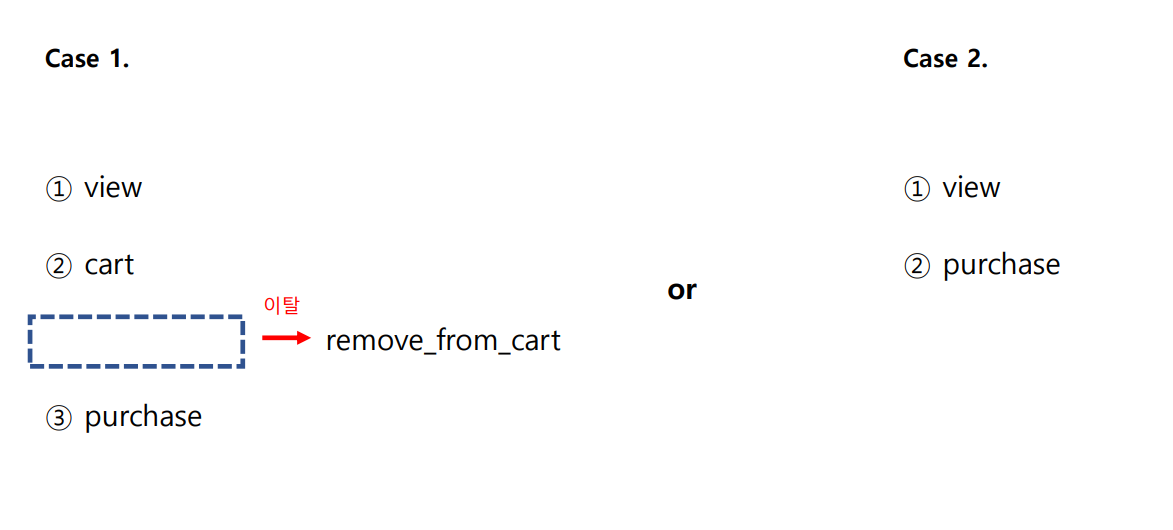

그리고 퍼널의 구성에 대한 생각을 해볼 수도 있는데요. 이용자가 장바구니에 물건을 담고 물건을 구매할 수도 있지만, 그렇지 않고 바로 물건을 구매할 수도 있습니다.

해당 사이트에서 UX가 어떻게 구성되어있는지 알 수 없기 때문에 확답하기는 어렵지만, 만약 퍼널 구조 자체에 문제가 있다면 다시 퍼널에 대한 논의를 해야할 수도 있습니다. 예로 들어 Case 1을 Case 2와 같이 구성할 수 있습니다. 많은 기업에서는 이와 같이 퍼널의 구조를 줄여 이탈율을 줄이려는 노력을 많이 합니다.

반대로 퍼널의 구조를 늘리는 경우도 있는데요. 서비스가 복잡하거나, 진입장벽이 높은 경우 가이드 문서를 확인한다던지 특정 액션을 유도하기도 합니다. 비즈니스의 성격에 맞게 어떻게 해야 전환율 높이고, 이탈율을 낮출지 고민해야 합니다.

안녕하세요

어떤 멘토분에게 들었는지 알 수 있을까요?