영상처리와 컴퓨터 비전 분야에서 Image Transformation(영상 변환)은 서로 다른 시점(view)이나 카메라 위치에서 촬영된 영상을 정합(alignment)하여 하나의 일관된 공간적 표현으로 만드는 핵심 기술이다. 이 과정은 단순히 영상을 겹쳐 붙이는 것이 아니라, 잡음, 조명 변화, 투영 왜곡 등 실제 환경에서 발생하는 다양한 문제를 고려하여 강건한(robust) 특징 기반 정합을 수행해야 한다.

Motivation

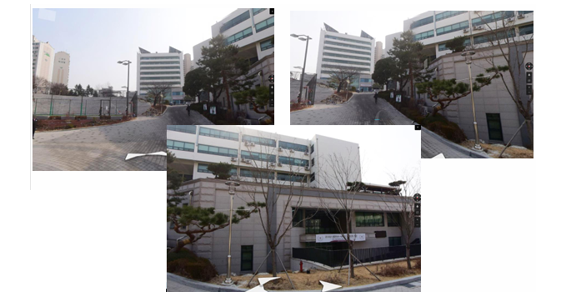

Motivation 1: Naver Street View

네이버 스트리트 뷰와 같은 지도 서비스에서는, 차량이 이동하면서 촬영한 수많은 영상들을 연속적이고 끊김 없는 파노라마 형태로 이어 붙여야 한다.

이를 위해서는 서로 다른 위치에서 찍힌 이미지 사이의 중첩 영역을 올바르게 대응(match)시키고, 기하학적 변환(translation, rotation, homography 등)을 통해 정합해야 한다. 이때, 단순한 픽셀 값 기반 비교는 조명이나 노이즈에 취약하기 때문에, 불변 특징(Local invariant features)을 활용하는 것이 필수적이다.

Motivation 2: Image Stitching

실제 응용에서는 영상에 잡음, 블러, 조명 변화, 가림(occlusion)이 존재한다. 따라서 단순한 대응점 매칭만으로는 안정적인 정합을 보장할 수 없다. 대신, 강건한 특징 추출기(SIFT, SURF, ORB 등)를 통해 불변성을 확보하고, 작은 부분 집합의 대응점으로부터 변환(Transformation T)을 가정(hypothesize)한 후, 나머지 대응점과의 일관성을 검증(verify)하는 과정을 반복한다.

이는 잘못된 대응점(outliers)을 제거하는 효과를 가지며, 후속 단계에서 RANSAC(Ransdom Sample Consensus) 알고리즘과 밀접하게 연결된다.

Comming Up : Roubust Feature - Based alignment

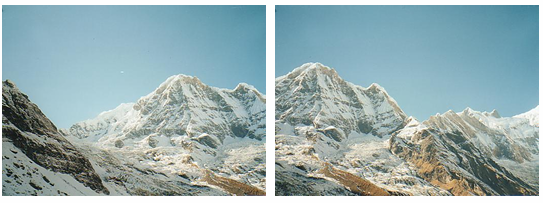

아래는 Image Transformation과 RANSAC 기반 정합 과정을 단계별로 보여준다.

1. Feature Extraction(특징점 추출)

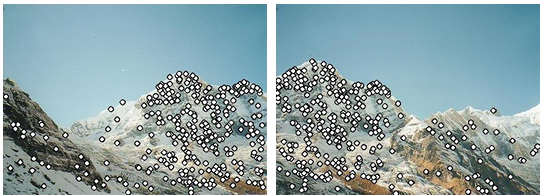

아래는, 위의 원본 이미지 내에서 코너, 에지, blob과 같이 구분 가능한 위치(Interest points)를 검출한 모습이다.

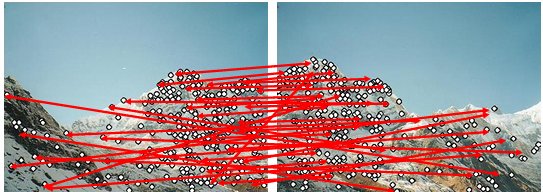

2. Putative Matches(가설 대응점 계산)

아래 이미지는 두 이미지 사이에서 비슷한 특징 기술자(Descriptor)를 찾은 결과이다.

하지만 이때는 잡음이 많아 잘못된 매칭(outlier)도 상당히 섞여 있다.

즉, "Putative match"는 아직 검증되지 않은 가설적 대응점이다.

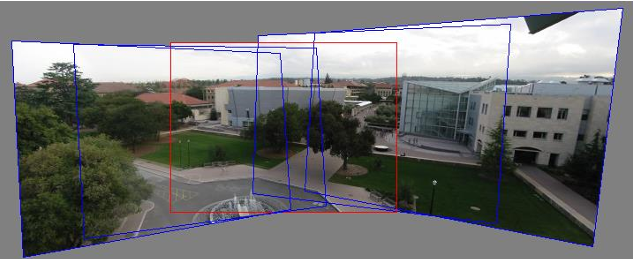

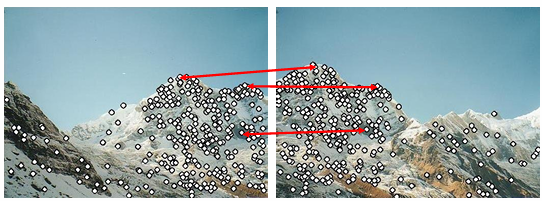

3. Hypothesize Transformation T(변환 가정)

일부 대응점 집합을 석택하여, 두 영상 사이의 변환(예: translation, rotation, affine, homography)을 가설적으로 추정한다.

- 아래 그림에서는 소수의 빨간 선(3개)은 변환된 모델을 추정하기 위해 샘플링된 점들을 나타낸다.

- 여기서 T는 변환 행렬을 의미한다.

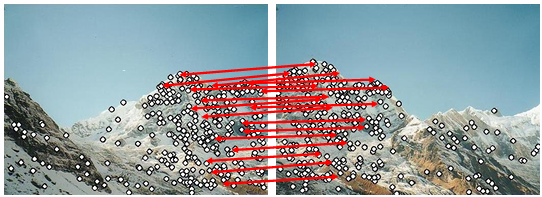

Verify Transformation(검증 단계)

추정한 변환 T를 적용하여 나머지 대응점들이 얼마나 일관되게 매칭되는지를 검증한다.

- 잘 맞는 매칭은 inlier로 남고, 틀린 매칭은 outlier로 버려진다.

이 과정이 반복되며, 최종적으로는 두 영상이 정확히 겹친다. 이후 정합된 결과는 아래와 같다.