✨ 문제 상황

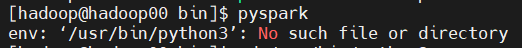

Spark 설치 후 pyspark를 시작했을 때 아래와 같은 Error 발생 env :'/usr/bin/python3': No such file or directory

✨ 문제 원인

/usr/bin에 python3가 없었다!

✨ 문제 해결

같은 버전의 python(여기선 python36)을 설치해 /usr/bin 경로에 지정해주면 해결!

-

CentOS8에 Python36 설치

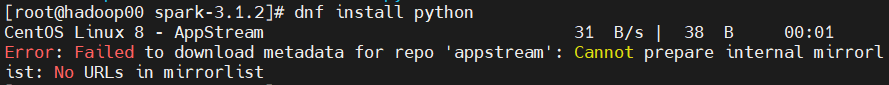

dnf install python36

=> 만약 아래와 같은 오류가 발생한다면 (mirrorlist error) => 아래 명령어 입력해주고 재실행

=> 아래 명령어 입력해주고 재실행

sed -i 's/mirrorlist/#mirrorlist/g' /etc/yum.repos.d/CentOS-Linux-*

sed -i 's|#baseurl=http://mirror.centos.org|baseurl=http://vault.centos.org|g' /etc/yum.repos.d/CentOS-Linux-*

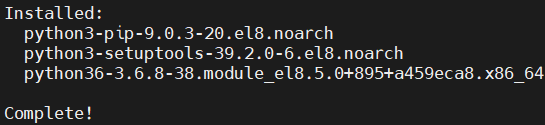

이렇게 나오면 성공 !

-

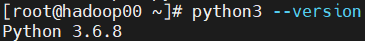

python version 확인

python3 --version

-

python이라는 명령어로 설치된 버전 범용적 사용 (옵션)

sudo alternatives --set python /usr/bin/python3

python -V -

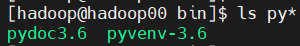

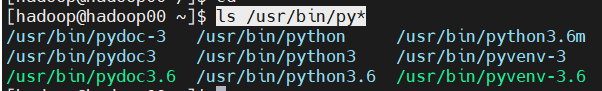

/usr/bin 경로에 python 있는지 확인 !

ls /usr/bin/py*

-

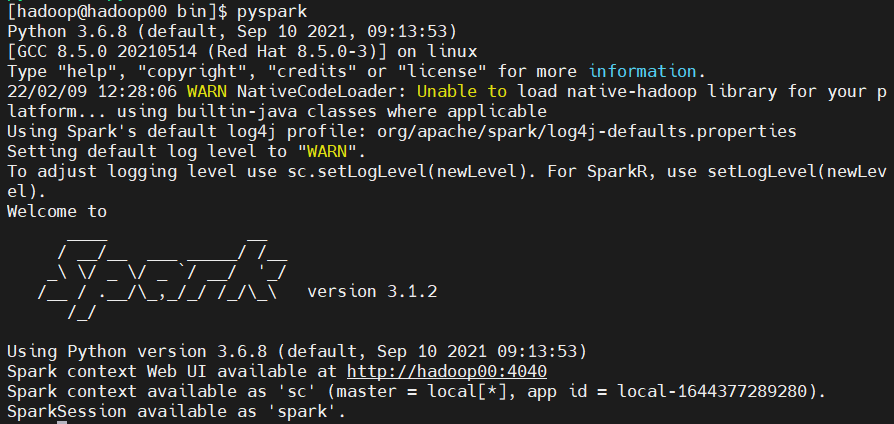

pyspark 실행

🎈Reference

https://chhanz.github.io/linux/2022/02/04/dnf-error-centos-8/

https://jinisbonusbook.tistory.com/10