Spark

1.[Spark] Spark 구조의 이해

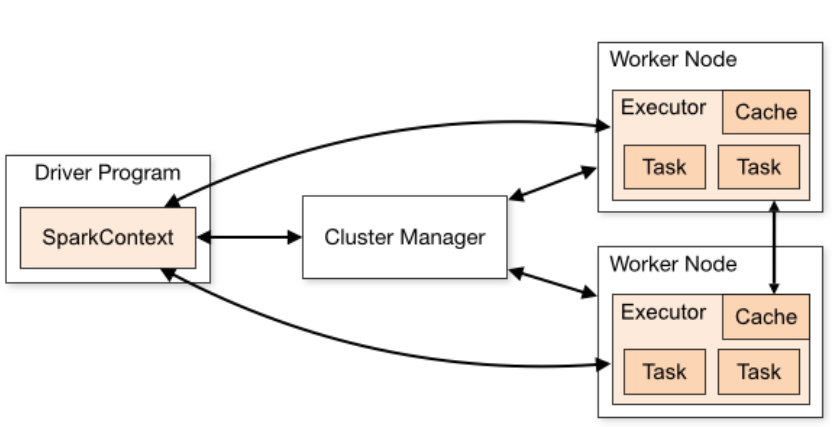

스파크는 스파크 어플리케이션과 클러스터 매니저로 구성되어있음 스파크 어플리케이션 : 실제 일을 수행하는 역할 담당클러스터 매니저 : 스파크 어플리케이션 사이 자원 중계 역할 담당 Spark Application은 Driver Process와 Excutors로 구성됨 하

2022년 2월 8일

2.[Spark] pyspark 실행 오류

문제 상황 : Spark 설치 후 pyspark를 시작했을 때 아래와 같은 Error 발생 env :'/usr/bin/python3': No such file or directory 문제 원인 : /usr/bin에 python3가 없었다! 문제 해결 : 같은 버전

2022년 2월 9일

3.[Spark] Spark 개념 정리 및 scala, spark-shell, pyspark 실습

Hadoop : HDFS + MapReduce병렬처리(parallezation)데이터 분산(Distribution) 장애 내성(Fault Tolerance) -> 복제Job --> MapReduce Job 1 -------------> Job2 \-> HDF

2022년 2월 11일

4.[Spark] Spark Streaming vs Structured Streaming

목적 : 이 내용을 참고해서 Spark Streaming을 해보려고 했는데, KafkaUtils는 현재 사용중인 spark 3.1.2 버전에서 지원하지 않았다. 알고보니 Spark Streaming에는 DStreams라는 기능과 DataFrmae과 연동할 수 있는 S

2022년 3월 29일