자연어처리

1.[자연어처리 9-15주차]

2023년 2학기 전공 수업으로 열린 자연어처리 과목을 수강하며 정리한 내용입니다. [9주차 attention mechanism] https://giddy-trader-6bd.notion.site/9-attention-mechanism-310206d06fef4107a

2.[KoBERT] 다중감성분류모델 구현

Selfume은 사용자의 감정에 맞춰 자유롭게 시료를 조합하여 향수를 제작할 수 있는 셀프 제작소이다. 웹 인터페이스, 감정 분류 인공지능, 그리고 아두이노를 결합하여 사용자가 작성한 감정 기반의 사연 텍스트를 분석하고, 분석된 감정을 기반하여 향수를 추천해주고 제작하

3.[InstructGPT] Training language models to follow instructions with human feedback

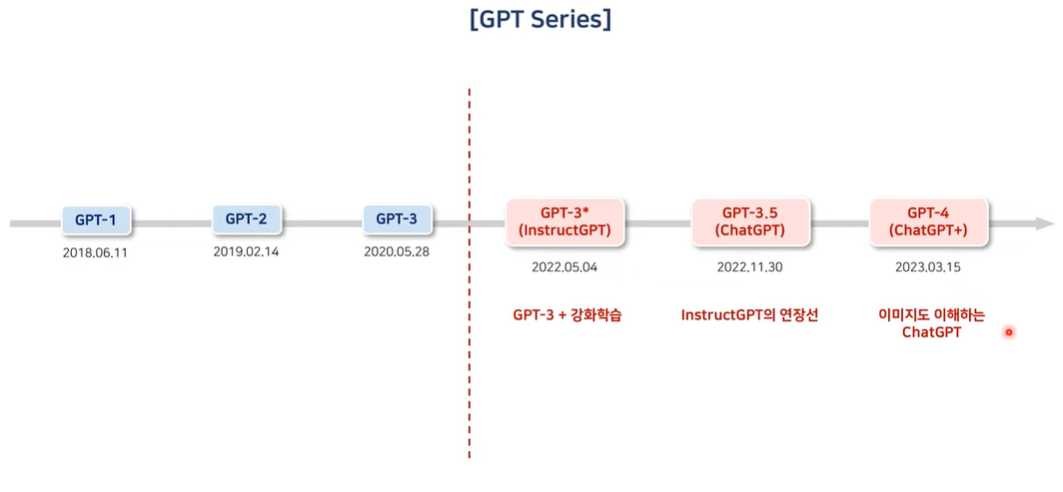

Langauge Modeling 특정 sequence를 구성하는 토큰들이 순차적으로 하나씩 입력이 될 때 주어진 토큰의 sequnce를 바탕으로 그 다음에 올 토큰을 순차적으로 예측하는 Auto-Regressive한 특징을 가지고 있음In-context learning

4.[Llama] Llama 2: Open Foundation and Fine-Tuned Chat Models

GPT1 이후의 모든 Decoder-only 기반의 LLM은 동일한 Pretrain Task 공유 \- Langauge Modeling(LM): t 시점까지의 단어를 기반으로 t+1 시점의 단어가 나올 확률을 예측LLM: 간단한 LM Pretrain Task를 이용하

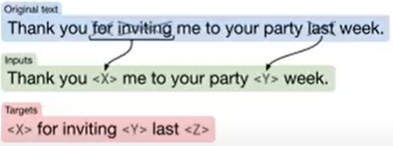

5.[T5] Text-to-Text Transfer Transformer

NLP task를 text input, text output으로 바꾸자unified model을 다양한 task에 사용가능transformer model architectureEncoder + Decoder: T5, BARTEncoder-only: BERT, RoBER

6.[GPT-1,2,3]

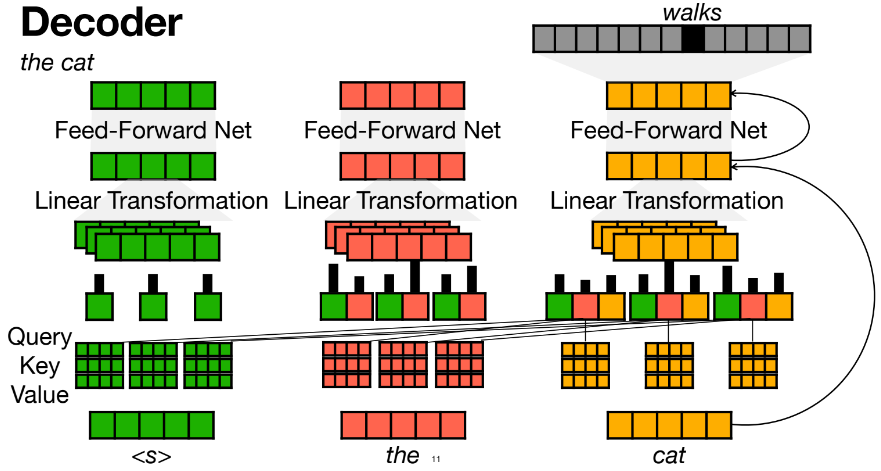

multi-head attention의 결과로 다음단어 예측하고, 예측한 단어로 stop token이 나올 때까지 계속 multi-head attentionposition을 onehot vector로 나타냄vocab과 position을 transform해서 embedd

7.[Train a LM to follow instructions] FLAN, InstructGPT, Chain-of-Thought Prompting

n-shot learning이 갑자기 헷갈려서 쓰는 글!prompt만 주는건지 fine-tuning하는 건지 헷갈렸는데 이 2개의 방법이 모두 있다.instruct tuning을 사용함에 따라 zero-shot 능력이 향상됨을 보여준다.LM을 next word pred