Classifier_Model

Remind for DeepLearning

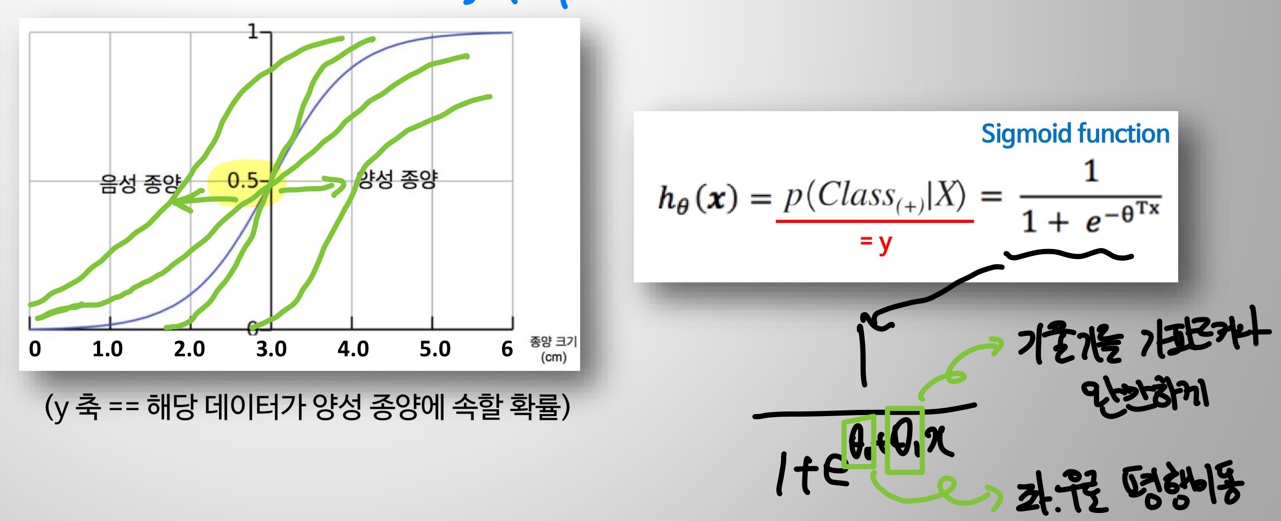

Logistic Regression

- 이진 분류 문제를 해결하기 위한 모델

- sigmoid function을 이용하여 특정 cutoff를 넘는 경우 data가 0 or 1로 예측한다.

- cutoff( Threshold or Decision boundary)

- data가 0 or 1 이 되는 경계선 또는 판단 기준

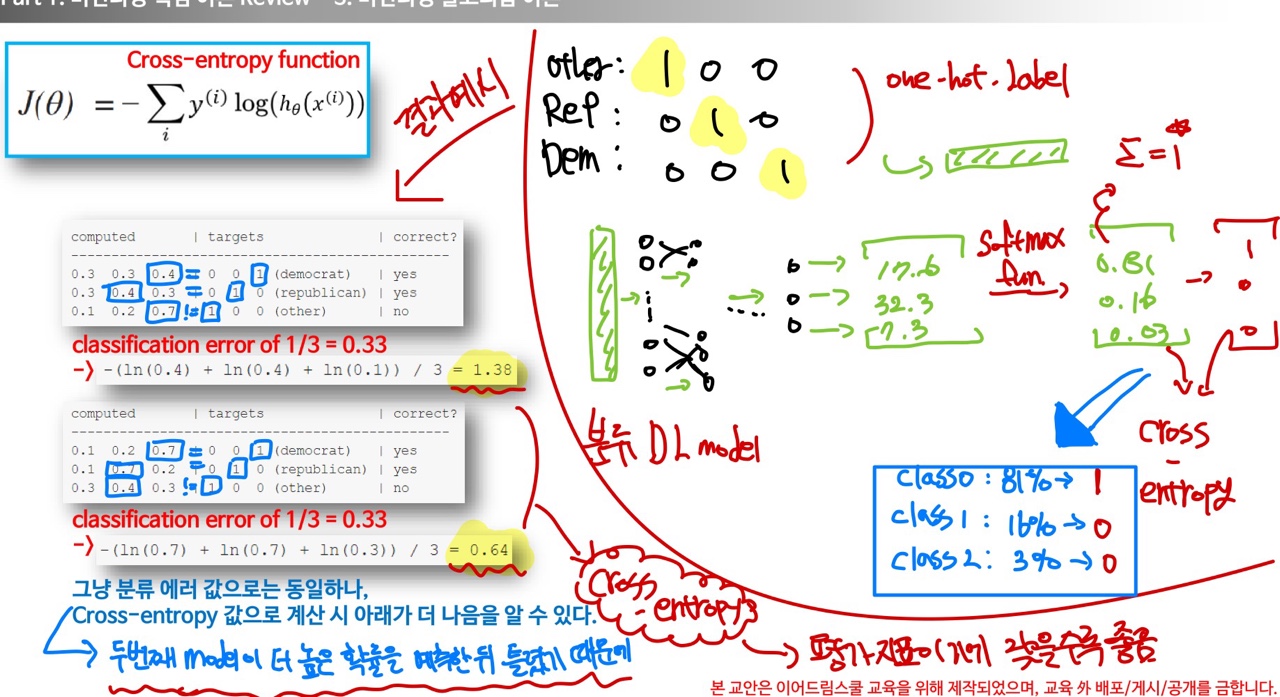

- Cost Function : 분류모델에서 성능지표를 사용해야 하므로 Cross entropy를 활용

Sigmoid’s Gradient Vanishing

- sigmoid에서 x의 절댓값이 커질수록 기울기의 값은 0으로 수렴한다.

→ 이는 역전파를 통해 오차의 값을 개선하는 과정에 있어서 기울기 값이 0이되므로 학습이 진행 될 수 없다!

→ 이를 해결하기 위한 방안으로 Relu가 도입됀다.

Cross entropy

Softmax_Algorithm

- 다중 클래스 분류문제를 위한 알고리즘

- Cross entropy의 결과 값 → Score

- Score → Softmax_Algorithm → probablity

- Score 값의 예시 → (17.4 , 8.5, 32.5)

- Softmax를 통과한 후 prob 값은 합이 1 이 되도록 나온다.

- prob 값의 예시 ( 0.81 , 0.16 , 0.03) → sum = 1

- 0.81에 해당하는 data가 값이 가장 크므로 1에 해당되고 나머지는 0 →( 0.81 , 0.16 , 0.03) → ( 1 , 0 , 0 )

SVM(support vector machine)

- Data를 분류하여 나누었을 때,해당 범주를 여유있게 가르도록 함

- Decision boundary를 생성하여 error 비율을 줄이고, 일반화 성분을 높이도록 함

- ex) xx xx. xx x x x. xx. x. x

ㅡㅡㅡㅡㅡㅡㅡㅡㅡplus planeㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡ

ㅡㅡㅡㅡㅡㅡㅡㅡㅡDecision boundaryㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡ

ㅡㅡㅡㅡㅡㅡㅡㅡㅡminus planeㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡ

o o o o o o o o o o o o o o o o o o

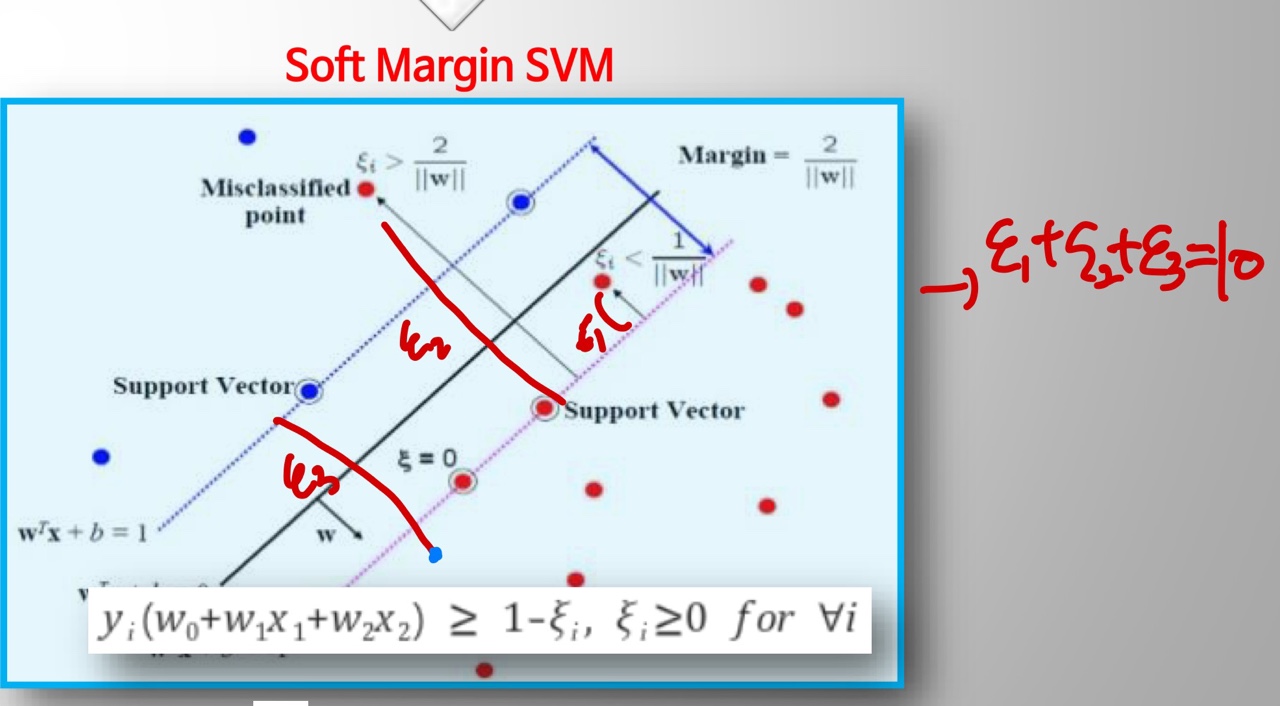

- but 현실에서 엄격하게 data를 구분하기가 힘듬 → 서로의 영역을 넘어서게 분류되는 경우가 존재

- 즉 margin(plus plane - minus plane) 거리를 최대화 하기 위한 기법

- Soft-margin & KSVMs 파생

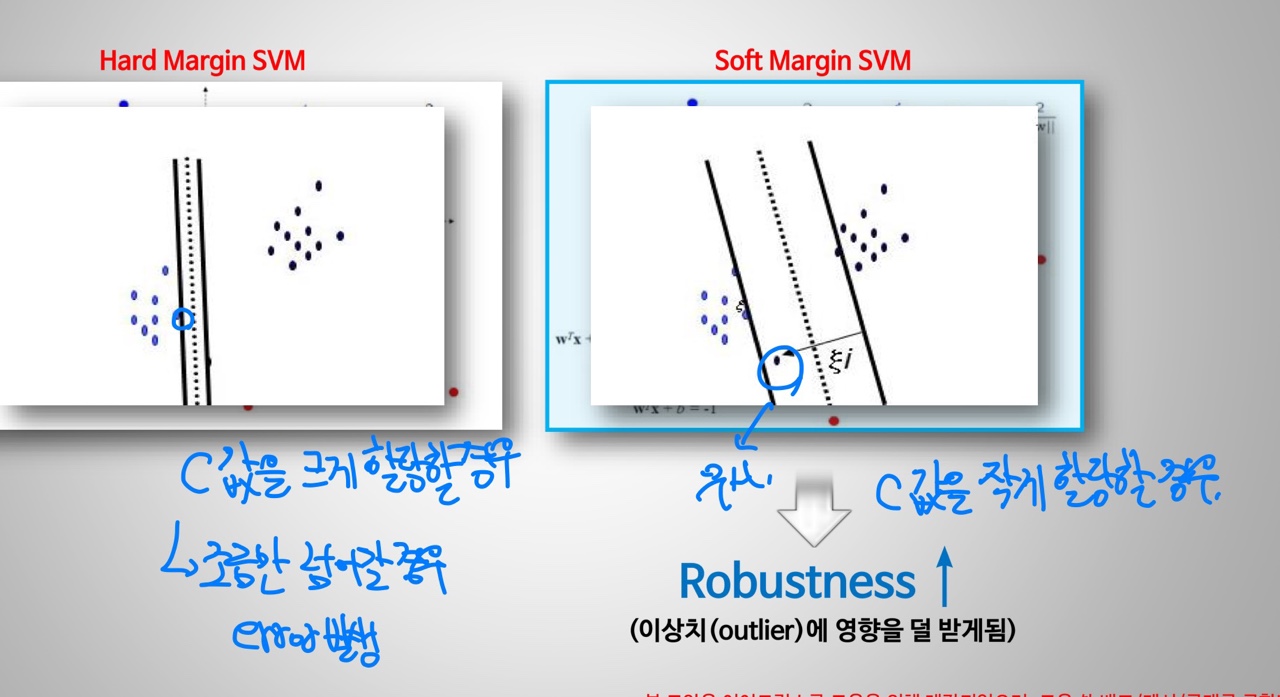

Soft-margin

- C ( Hyper-parameter) 값에 따라 margin의 경계면이 변화

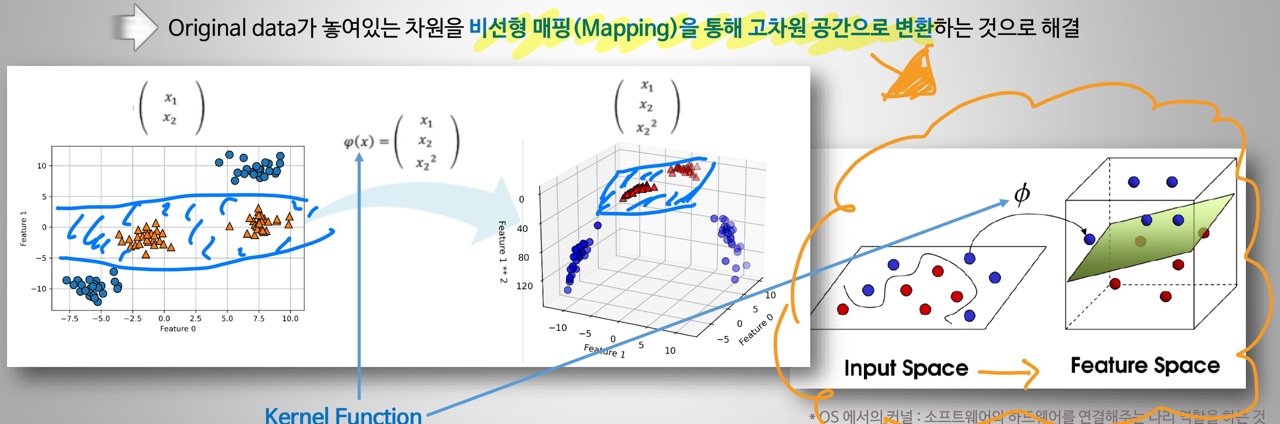

Kernel support vector machine

- Original data가 놓여있는 차원을 새로운 고차원 공간으로 비선형 Mapping하여 변환하여 해결!

- 선으로 나누던 차원 → 면으로 나누는 차원에서 분리 한 뒤 → 다시 본 차원으로 돌아옴