GenAI

1.[LLM] Attention & Transformer

https://www.youtube.com/watch?v=6s69XY025MU

2.[LLM] Evaluation Metrics

Bleu

3.[LLM] Pipeline

환경설정 : 라이브러리 설치 및 데이터셋 로드 (train.csv, test.csv)데이터셋 구축 : 입력 데이터를 train/vaild = 7.5:2.5로 나눈 후 Tokenizing 하여 torch dataset class로 변환모델 및 토크나이저 가져오기: Hug

4.[LLM] Transfer Learning(ELMo)

Transfer Learning

5.[LLM] Encoder Model(BERT)

LLM Encoder Model(BERT)

6.[LLM] Decoder Model(GPT 1,2,3)

LLM Decoder Model(GPT 1,2,3)

7.[LLM] Encoder-Decoder Model(BART)

LLM Encoder-Decoder Model(BART)

8.[LLM] BERT 이후 모델

RoBERTa: 동적 마스킹 방식의 MLMSpanBERT: Span 마스킹 방식의 MLM...

9.[LLM] RLHF

10.[LLM] Data Augmentation

11.[LLM] RAG

12.[LLM] Fine tuning

13.[LLM] Multi-Modal

14.[LangChain] Essentials

ChatPromptTemplate은 LangChain에서 제공하는 프롬프트 구성 도구로,여러 개의 메시지를 조합하여 하나의 프롬프트로 만들 수 있도록 도와줍니다.LLM에게 시스템 지시, 사용자 질문, 예시 답변 등을 함께 전달하고 싶을 때 매우 유용합니다.역할 구분 명

15.[LangChain] RecursiveCharacterTextSplitter

https://rudaks.tistory.com/entry/langchain-CharacterTextSplitter%E1%84%8B%E1%85%AA-RecursiveCharacterTextSplitter%E1%84%8B%E1%85%B4-%E1%84%8E%E1%

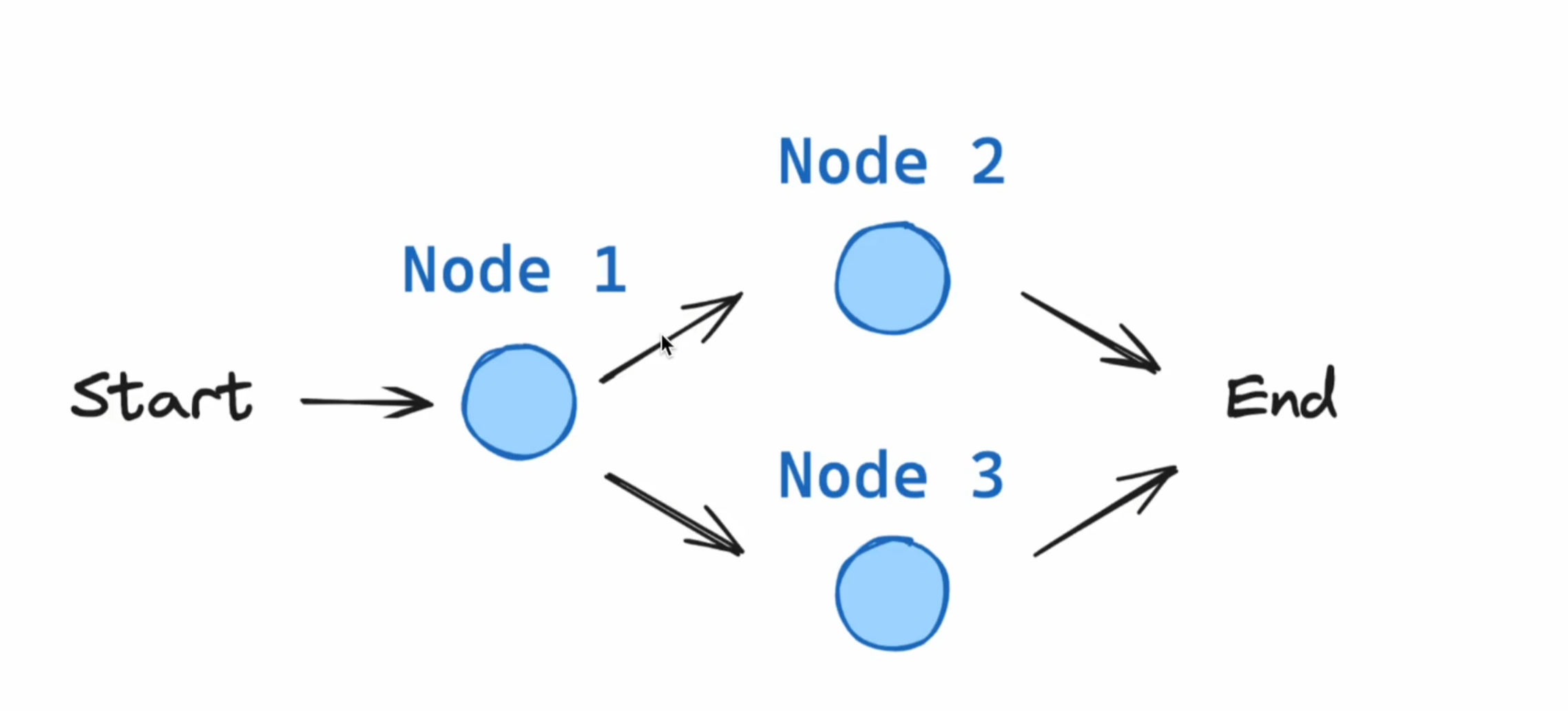

16.[LangGraph] Fundamentals

StateGraphThis object will encapsulate the graph being traversed during excecution.The core of our application, defining the flow of our Travel Planne

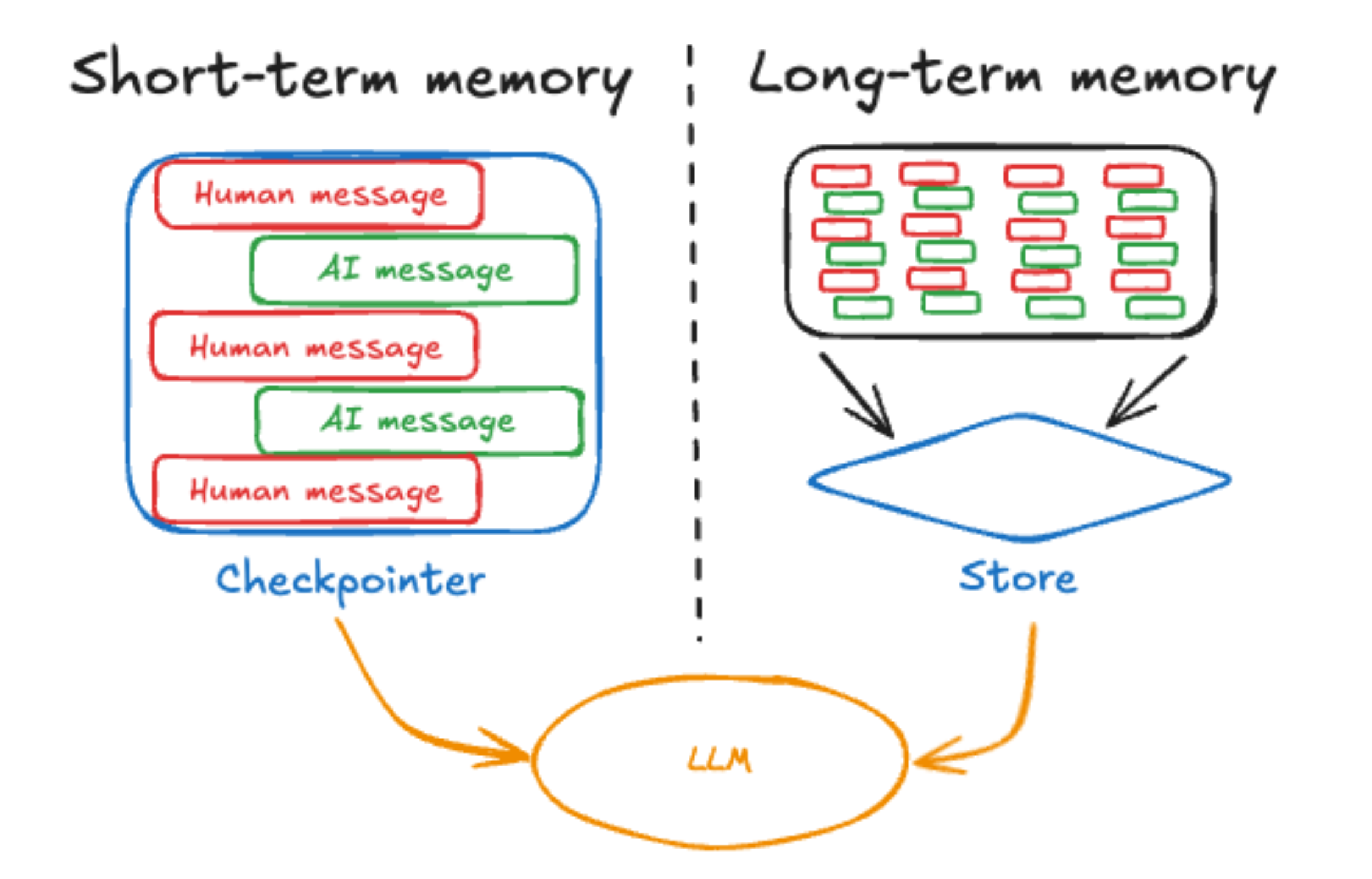

17.[LangGraph] Memory

Memory is key for any agentic conversation which is Multi-Turn or Multi-Agent colloboration conversation and more so if it spans multiple days. The 3

18.[LangGraph] Chain

Chat models use messages, which capture different roles within a conversationLangChain supports various message types, including HumanMessage, AIMessa

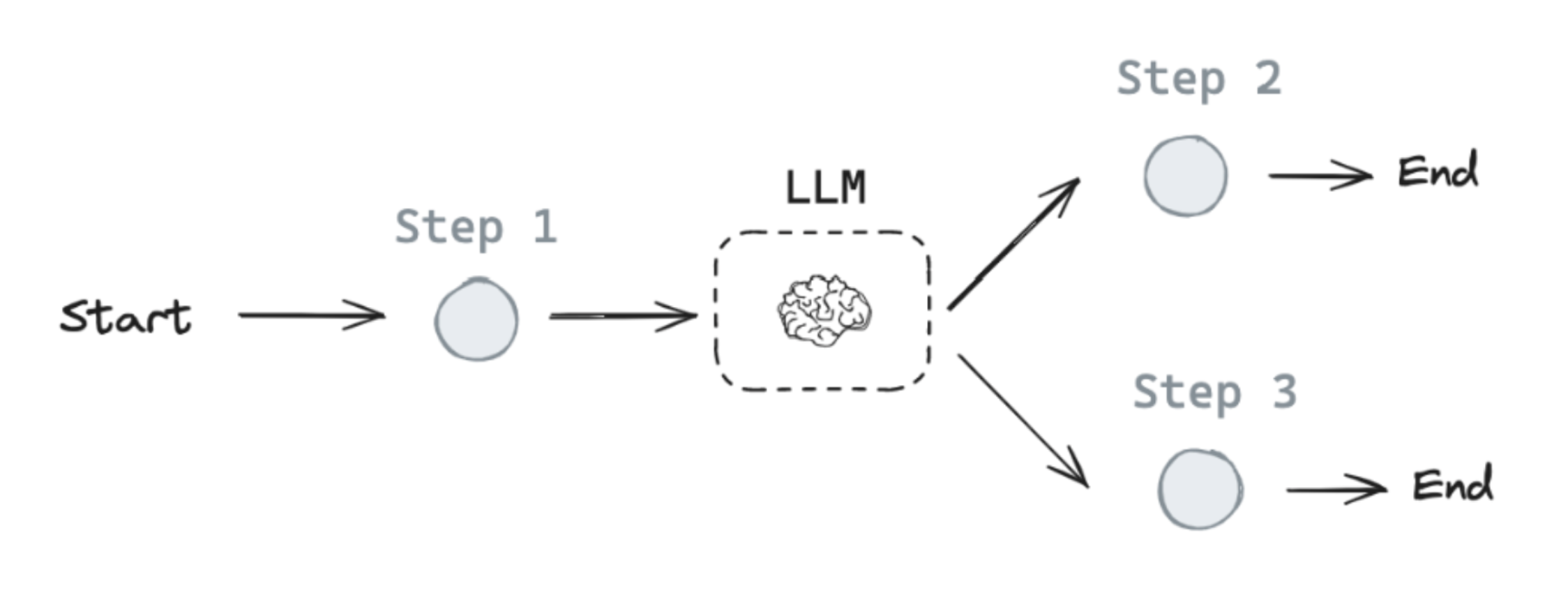

19.[LangGraph] Router

If we pass in Hello!, the LLM responds without any tool calls.(1) Add a node that will call our tool.(2) Add a conditional edge that will look at the

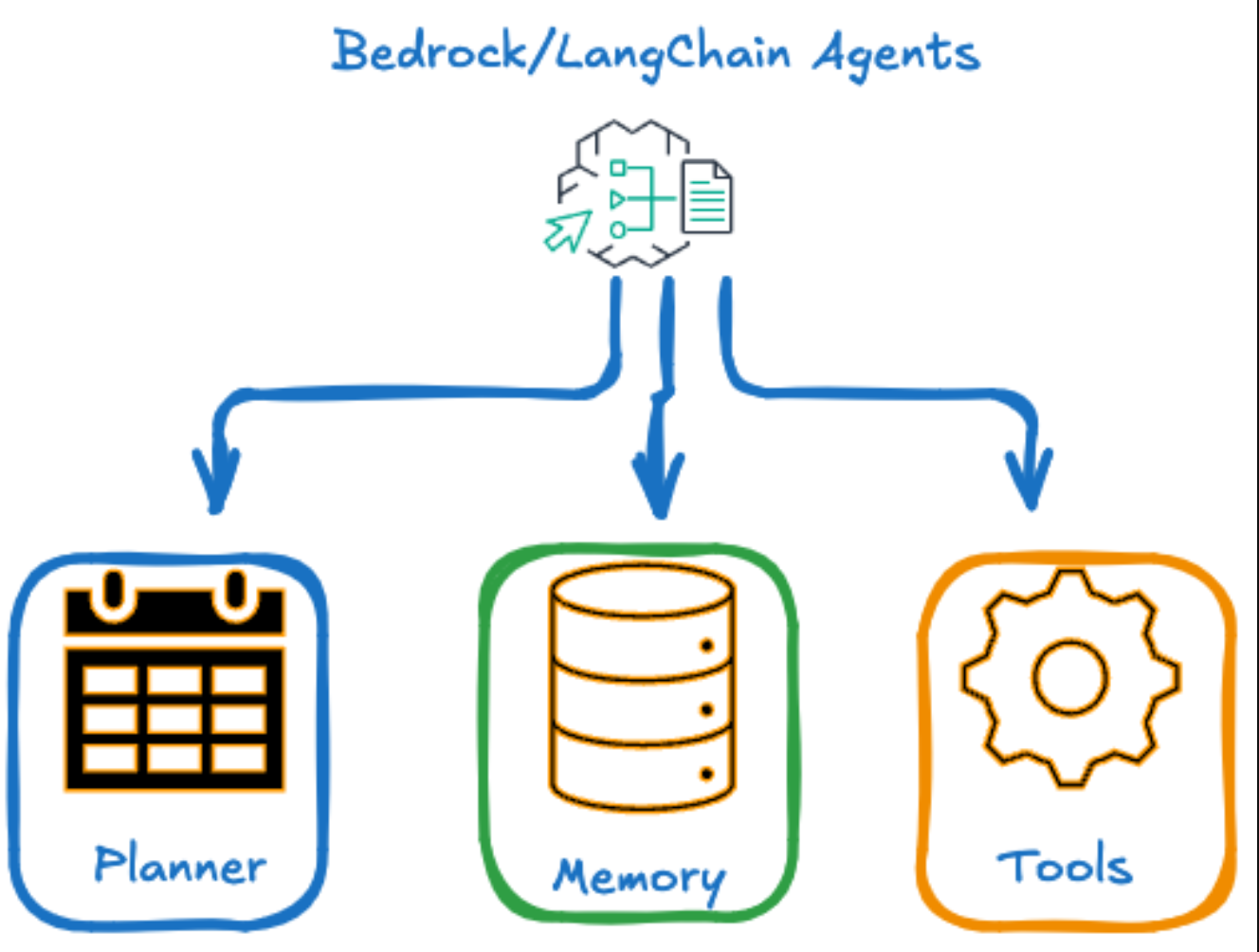

20.[LangGraph] Agents

Agents are intelligent systems or components that utilize Large Language Models (LLMs) to perform tasks in a dynamic and autonomous manner. Here's a b

21.HuggingFace 문서 임베딩

이 글은 Hugging Face 모델을 활용한 문서 임베딩의 전체 과정을 정리한 글입니다.tokenizer, chunking, truncation, padding, CLS 임베딩까지 헷갈리기 쉬운 개념들을 하나하나 설명합니다.문서 → 문장 단위로 분리 (선택)여러 문장