논문리뷰

1.MAE - Masked Auto-Encoder

자연어처리와 머신 비전 두 분야는 인공지능의 가장 큰 갈래이다. 두 분야의 성과는 항상 서로에게 영감을 주며 함께 발전해왔다. 이번 논문은 SSL기법인 BERT의 언어모델 방법론에서 창안된 Masked-Image Learning을 다룬 논문이다.

2024년 9월 3일

2.Reformer

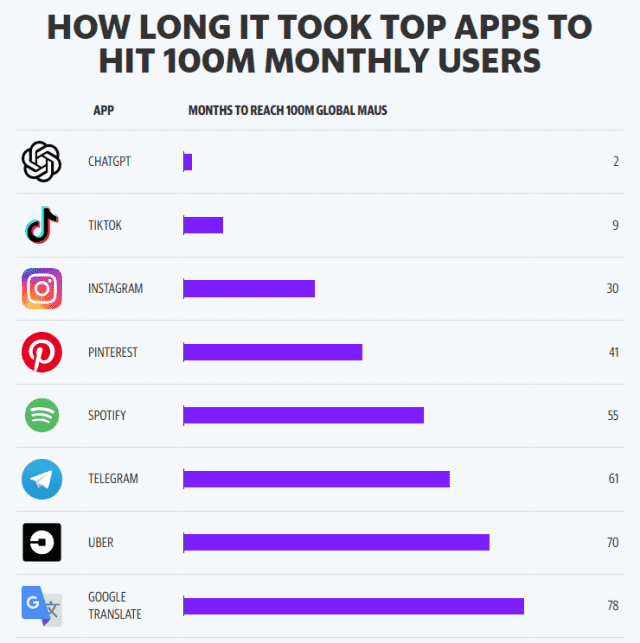

트랜스포머 기반 모델의 핵심은 attention을 계산하는 행렬곱이다. 행렬곱의 시간복잡도는 O(n^2)의 복잡도를 가지고 있고, 이는 트랜스포머 기반 모델의 학습, 추론 속도를 저하시키는 원인이다. 이를 해결하기 위해 제안된 Reformer 논문에 관한 리뷰이다.

2024년 9월 3일

3.LLama1 & Lora

LLama1 과 LLM을 학습시키기 위한 PEFT 방법론인 Lora에 대한 논문의 내용을 요약 및 리뷰한 내용입니다.

2024년 9월 3일

4.GPTQ 리뷰

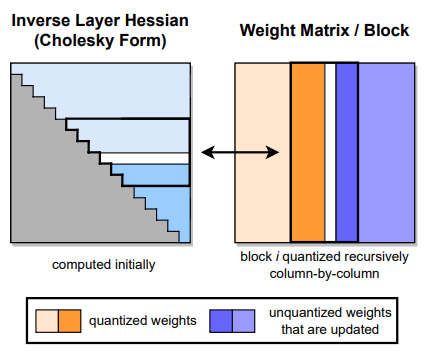

현재 거대한 모델을 양자화 하는데 가장 효과적으로 사용되는 GPTQ에 대하여 알아보자.

2024년 9월 13일