Paper Review

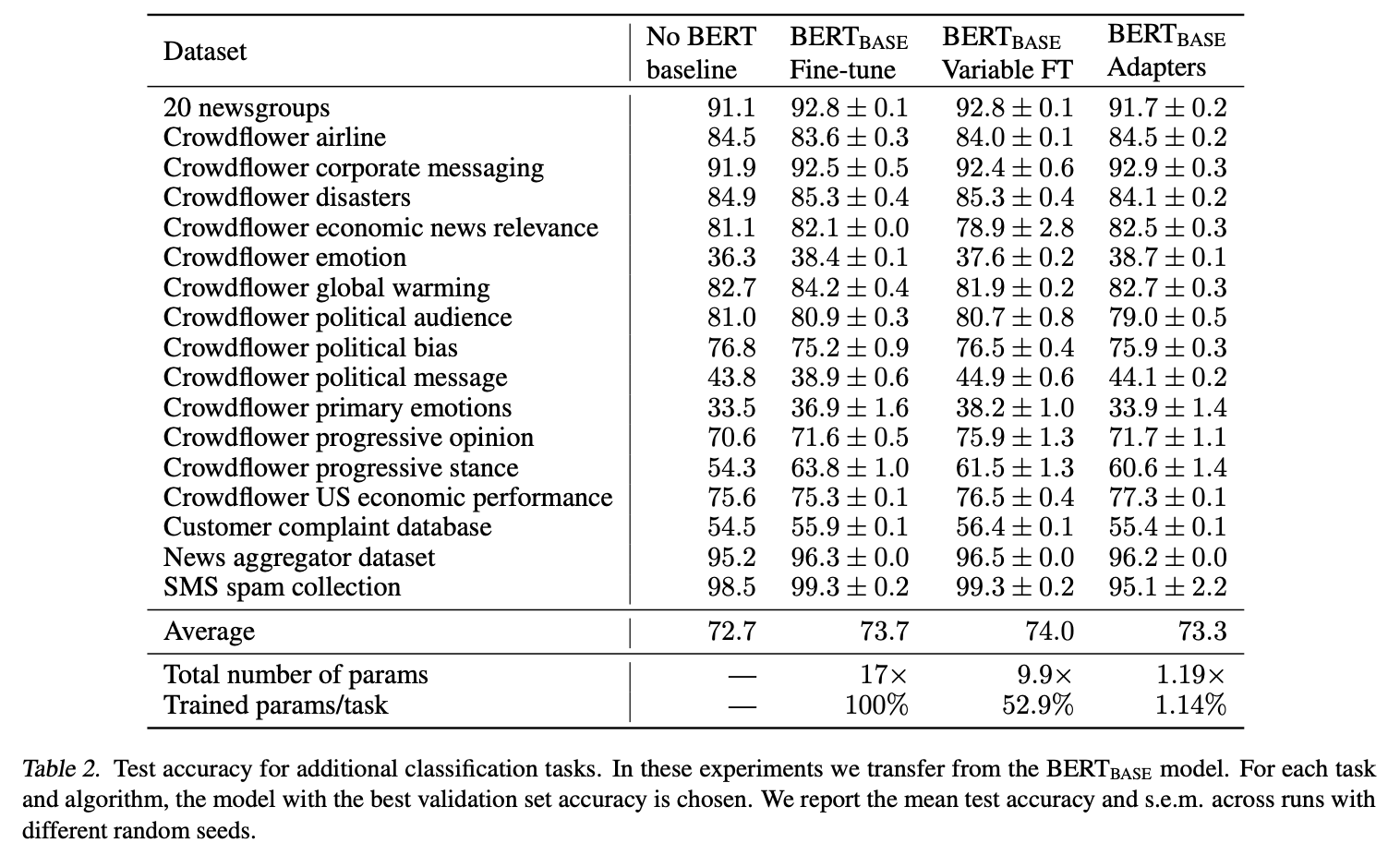

1.[Paper Review] Parameter-Efficient Transfer Learning for NLP

논문 링크 : https://arxiv.org/pdf/1902.00751.pdf ICML 2019 첫번째 논문 리뷰이다. Abstract 현재 Downstream tasks들을 풀기 위해서 Fine-tuning 을 사용하면, parameter inefficient

2.[Paper Review] MAD-X: An Adapter-Based Framework for Multi-Task Cross-Lingual Transfer

논문 pdf: https://arxiv.org/pdf/2005.00052.pdf 간단하게 논문의 소개를 보자. 기존에는 어떤 문제점이 있었고, 어떻게 해결하는지 알아보자. Introduction 기존 cross-lingual transfer 문제점 모든 언어를

3.[Paper Review] XLM

논문 : https://arxiv.org/pdf/1901.07291.pdf이전보다는 간단하게 리뷰해보자! Cross-lingual Language Model이 뭐지?✔️ Cross-lingual Language Model다언어 처리 가능 : 한 언어로 학습된

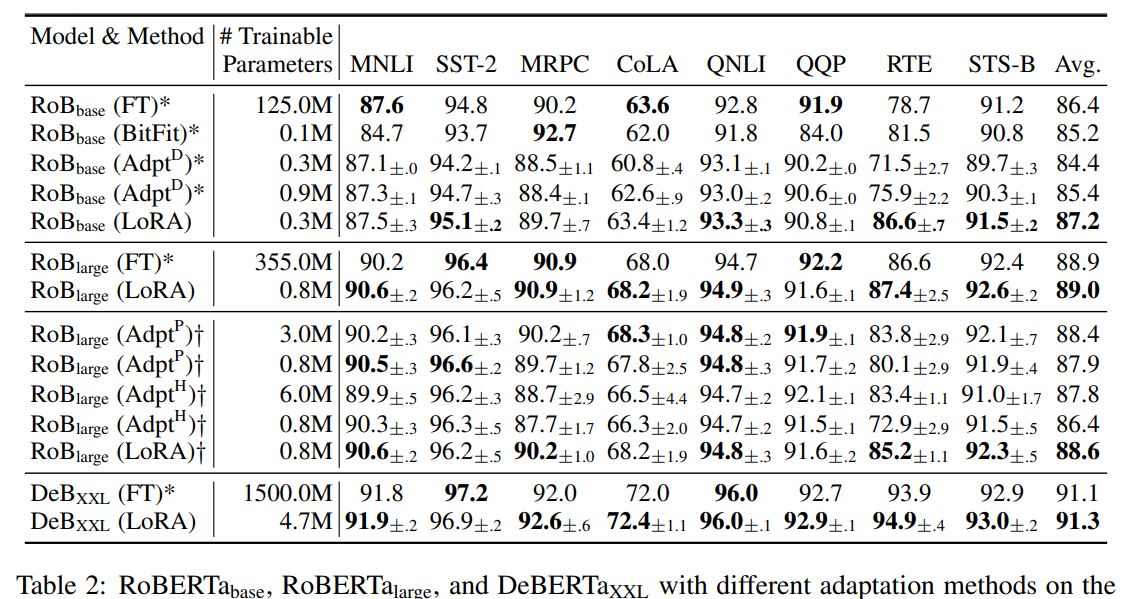

4.[Paper Review] LoRA: Low-Rank Adaptation of Large Language Models

논문 : https://arxiv.org/pdf/2106.09685.pdf Abstract > We propose Low-Rank Adaptation, or LoRA, which freezes the pretrained model weights and injects

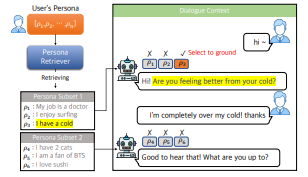

5.[Persona] WHAT, WHEN, and HOW to Ground: Designing User Persona-Aware Conversational Agents for Engaging Dialogue

논문 제목 : WHAT, WHEN, and HOW to Ground: Designing User Persona-AwareConversational Agents for Engaging Dialogue논문 링크 : https://aclanthology.org/20