keypoint_detection

1.[roboflow] annotation

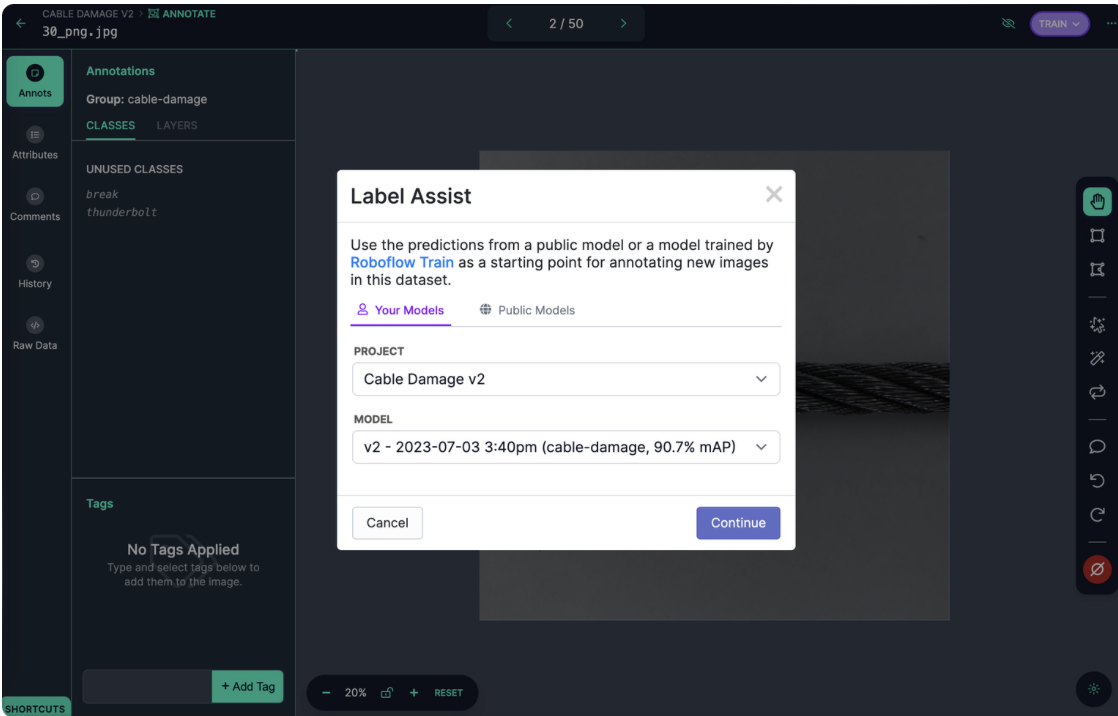

이미지에 다음 방법으로 주석을 추가할 수 있습니다:경계 상자 및 폴리곤을 수동으로 그리기모델 체크포인트(즉, 모델의 이전 버전)를 사용해 주석을 추천하는 Label Assist 사용몇 번의 클릭만으로 폴리곤 주석을 만드는 Smart Polygon 사용SAM과 함께 La

2.[roboflow] Preprocess Images

https://docs.roboflow.com/datasets/image-preprocessing모델을 위한 데이터를 준비하는 이미지 전처리 단계입니다.전처리는 데이터셋이 표준 형식(예: 모든 이미지가 동일한 크기)을 따르도록 보장합니다. 이 단계는 모델을 훈

3.keypoint detection - ideation

경기장 이미지에서, 최소 4개의 코너점을 찾도록 학습시키기dataset을 그대로 활용해야만 함풋살장에도 적용할 수 있을까?라벨링을 한 후, 이미지를 640 by 640으로 변경했음초기에는 약간의 수동 작업이 필요할 수 있지만, 이후에는 모델의 도움을 받아 라벨링 효율을

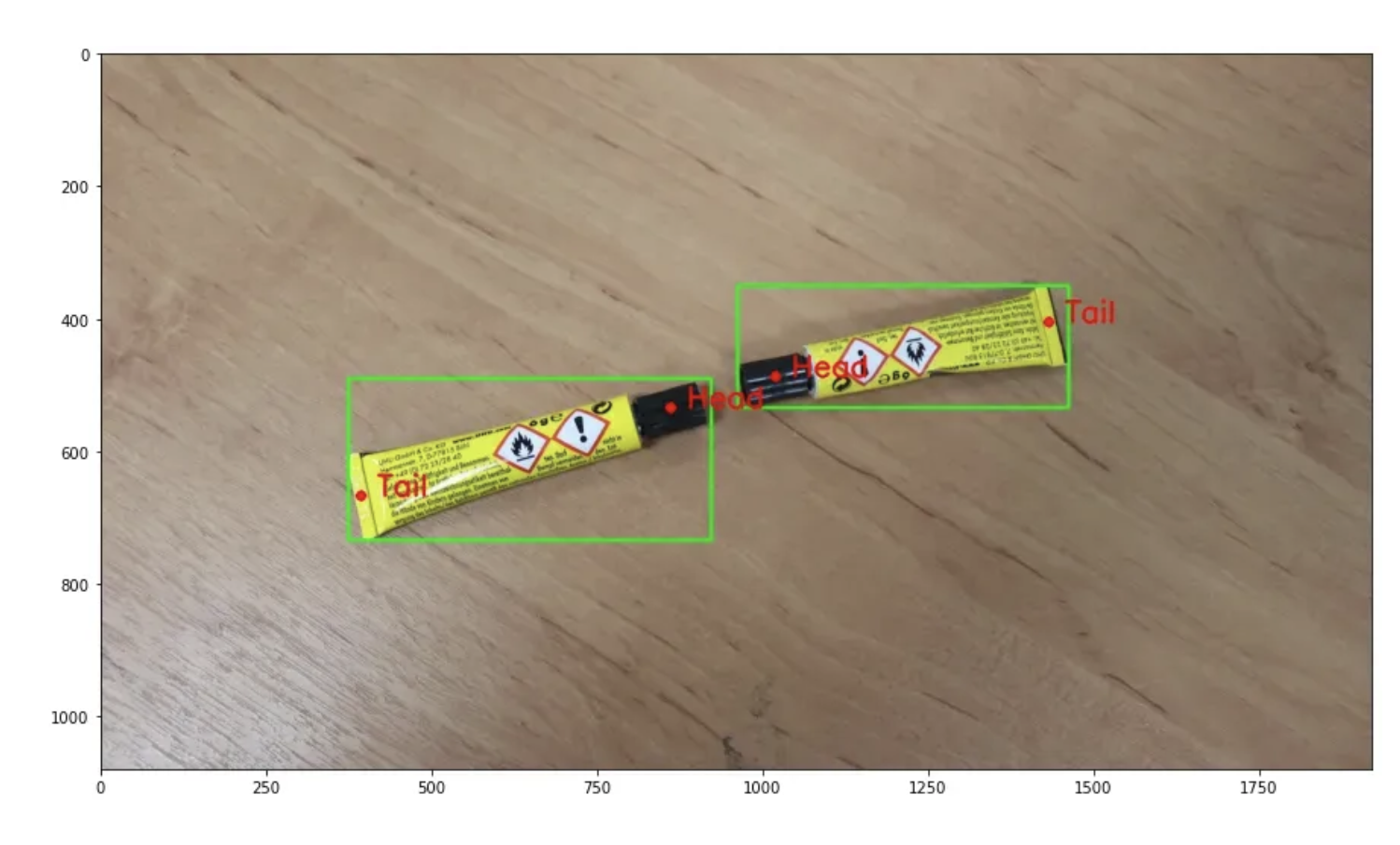

4.How to Train a Custom Ultralytics YOLOv8 Pose Estimation Model

키포인트 탐지는 사람이나 동물에 사용될 때 "자세 추정(pose estimation)"이라고도 하며, 이미지에서 특정 지점을 식별할 수 있게 해줍니다.예를 들어, 키포인트 탐지를 사용하여 조립 라인의 부품 방향을 식별할 수 있습니다. 이 기능은 부품이 다음 조립 단계로

5.keypoint detection 이란?

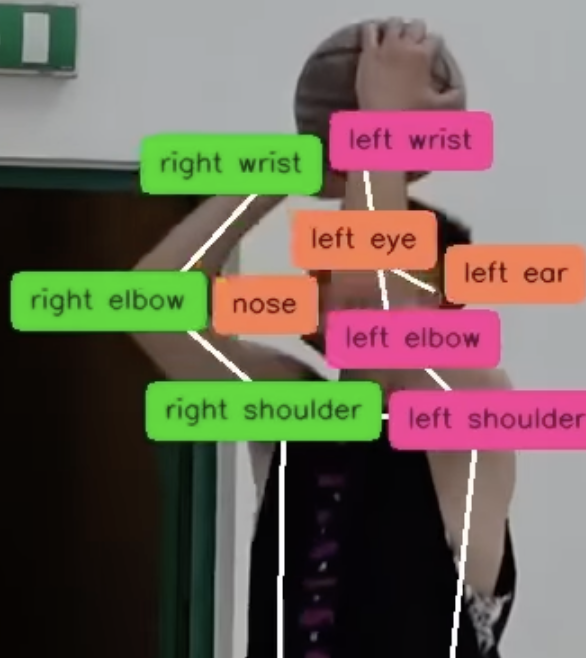

https://blog.roboflow.com/what-is-keypoint-detection/키포인트 탐지는 컴퓨터 비전 작업 중 하나로, 객체(종종 사람)의 위치와 해당 영역 내에서 중요한 지점(예: 다리, 팔, 머리)을 식별하는 것을 목표로 합니다. 키포

6.Launch: Label, Train, Deploy Support for Keypoint Detection Models in Roboflow

스켈레톤에서 첫 번째 지점을 생성하려면 사이드바에서 "Classes"(클래스) 목록을 클릭하세요. 식별하려는 클래스를 추가하세요.스켈레톤을 정의할 수 있는 그리드가 나타납니다. 지점을 클릭하면 해당 지점의 클래스 이름을 지정할 수 있습니다. 스켈레톤에 원하는 만큼 많은

7.[Ultralytics] Pose Estimation

자세 추정은 이미지에서 특정 지점을 식별하는 작업을 말하며, 이러한 지점은 일반적으로 키포인트라고 불립니다. 키포인트의 위치는 보통 2D x, y 또는 3D x, y, visible 좌표 세트로 표현됩니다.자세 추정 모델의 출력은 이미지에서 객체의 키포인트를 나타내는

8.[Ultralytics] Pose Estimation Datasets Overview

YOLO 자세 모델을 훈련하기 위해 사용되는 데이터셋 라벨 형식은 다음과 같습니다:이미지당 하나의 텍스트 파일: 데이터셋의 각 이미지는 동일한 이름을 가진 ".txt" 확장자를 가진 텍스트 파일과 대응됩니다.객체당 한 줄: 텍스트 파일의 각 줄은 이미지 내의 한 객체

9.keypoint detection - 전체 과정 정리

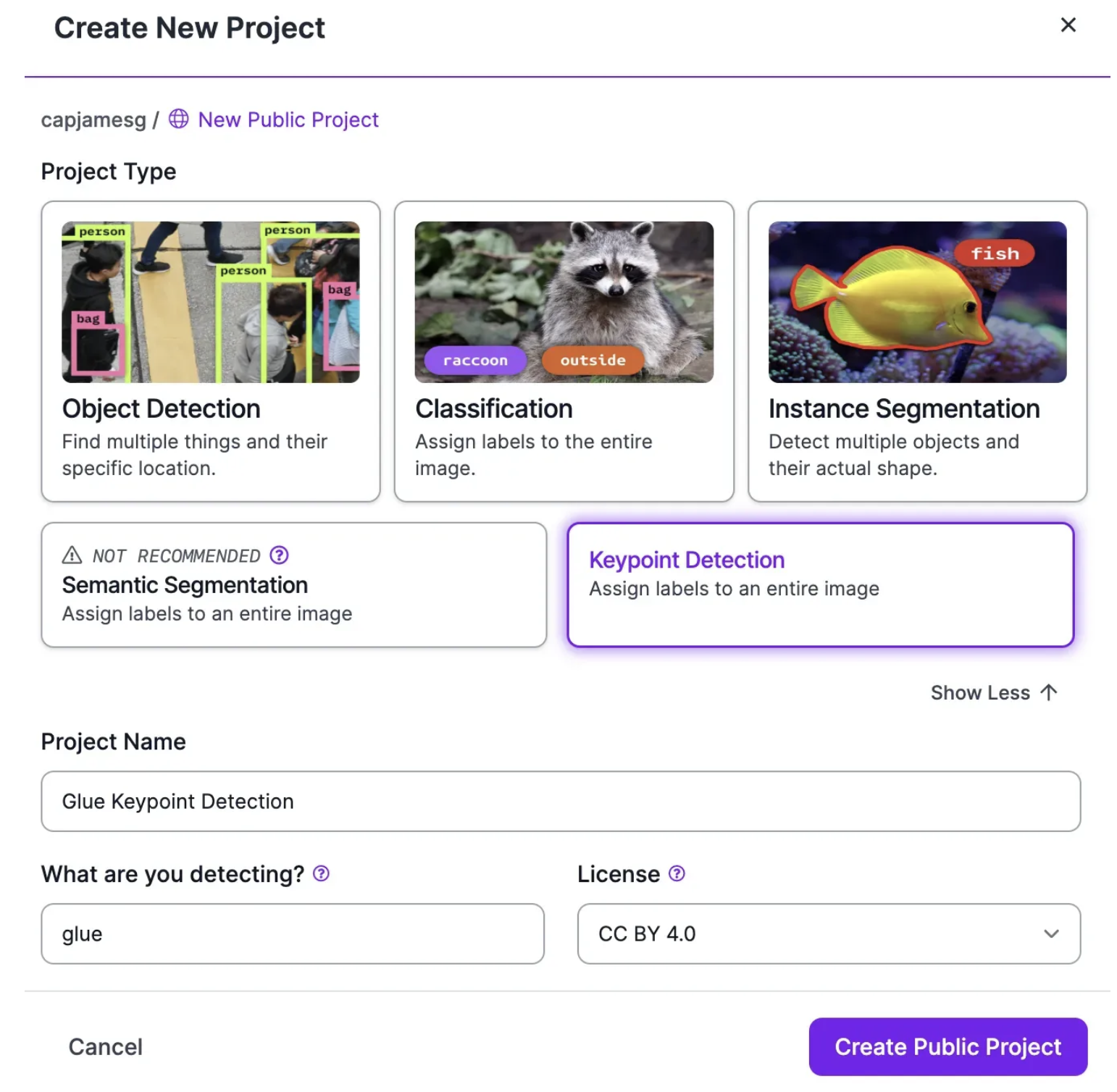

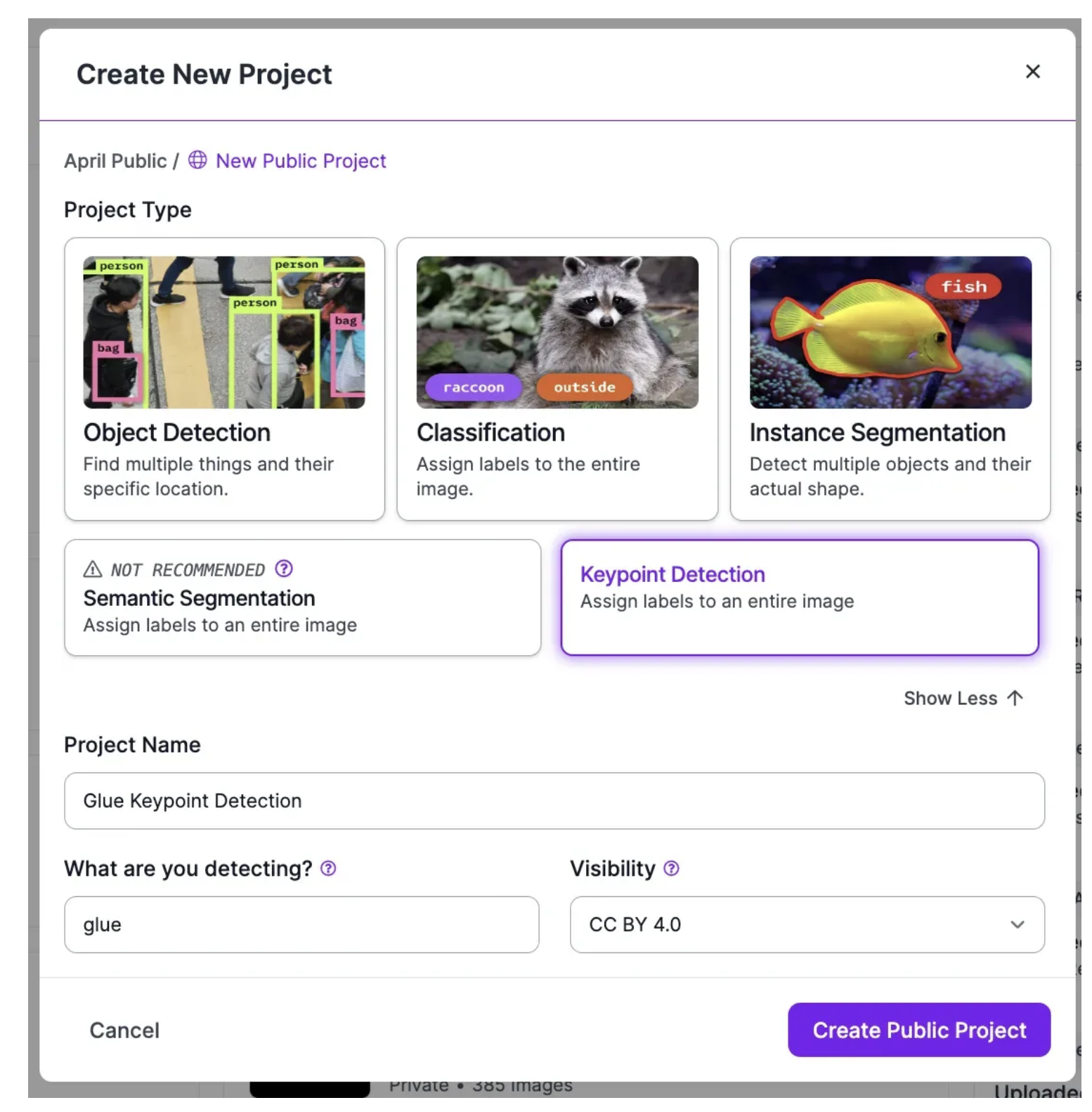

1. 이미지 라벨링 하기 1.1. 프로젝트 생성 Roboflow 대시보드로 가서 "Create New Project"(새 프로젝트 생성)을 클릭 1.2. 각 클래스에 대한 스켈레톤을 설정 Roboflow 사이드바에서 "Classes"(클래스)를 클릭하세요. 그런 다음 모델 훈련에 사용할 모든 클래스를 추가하세요. 클래스를 추가한 후, 각 객체에 대해 라...

10.[roboflow] What is Image Preprocessing and Augmentation?

모델 성능을 높이기 위해 가장 유용한 전처리 단계를 식별하려면 문제에 대한 이해, 수집된 데이터, 그리고 생산 환경에 대한 확실한 이해가 필요합니다. 한 상황에서 잘 작동하는 것이 다른 상황에서는 적절하지 않을 수 있습니다. 이는 이미지 증강에서도 마찬가지입니다.따라서

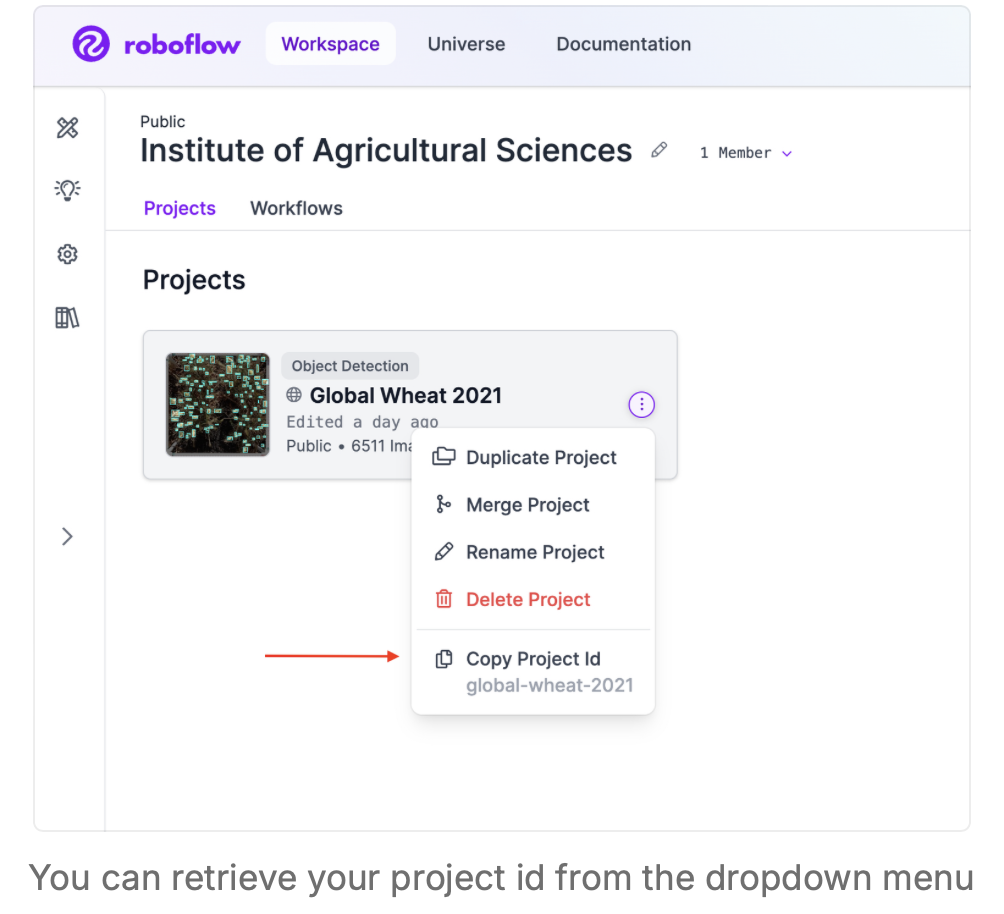

11.[roboflow] Workspace and Project IDs

https://docs.roboflow.com/api-reference/workspace-and-project-ids?ref=blog.roboflow.comAPI와 함께 사용할 작업 공간 및 프로젝트 ID를 가져오는 방법. 모델에서 추론을 실행하거나 프로젝트

12.roboflow 요금제

이 내용은 데이터 라벨링 도구의 가격 정책을 설명하는 문구로, 주어진 플랜의 제한 사항과 주요 기능을 명시하고 있습니다. 이를 하나씩 살펴보면:3명의 사용자 최대: 이 플랜을 이용할 수 있는 최대 사용자 수가 3명으로 제한되어 있습니다. 즉, 3명까지 이 툴을 함께 사

13.keypoint detection - flip_idx 란?

대칭적인 경우: flip_idx를 설정해 좌우 대칭을 명확히 학습하게 함.비대칭인 경우: flip_idx를 사용하지 않거나 최소화해 불필요한 혼동을 방지.YOLOv8-Pose와 같은 모델에서 이 설정은 데이터 증강을 최적화하고, 좌우 대칭 구조를 효과적으로 인식하게 도

14.keypoint detection - 성능 높이기

좌 우 로 구분 -> 그러므로 flip_idx 는 쓰지 않습니다.좌: 주황색 중: 빨강색우: 하늘색

15.골 하이라이트 추출하기

골을 자동으로 찾아주는 연구골이 들어간 다음의 사람 행동을 보고 -> 골인지 알 수 있음소리로 골인지 알 수 있음https://github.com/NVlabs/LITAhttps://github.com/OpenGVLab/video-mamba-suiteh

16.tracking으로, 팀구분+위치 해결

ByteTrack은 객체 감지 결과(detections)를 입력받아, 동일 객체를 여러 프레임에 걸쳐 추적tracker.update_with_detections()는 현재 프레임의 객체 감지 결과에 추적 ID를 부여하고, 프레임 간 일관성을 유지하기 위해 객체의 상태를

17.Training, validation, test data

Training Data: 모델 학습에 사용되는 데이터. 모델의 가중치와 편향을 조정함.Validation Data: 모델의 성능을 평가하며, 하이퍼파라미터를 조정하고 과적합을 방지하기 위해 사용.Test Data: 최종 모델의 성능을 확인하기 위한 독립적인 데이터로,

18.overfitting 막는 법

과적합(overfitting)을 방지하기 위해 조정할 수 있는 주요 하이퍼파라미터들과 그 효과를 아래에 정리했어. 각각의 상황에 맞게 적절한 조합으로 사용하면 좋아!설명: 너무 높은 학습률은 모델이 최적점에 도달하기 전에 튕기게 만들고, 너무 낮은 학습률은 과적합을 유

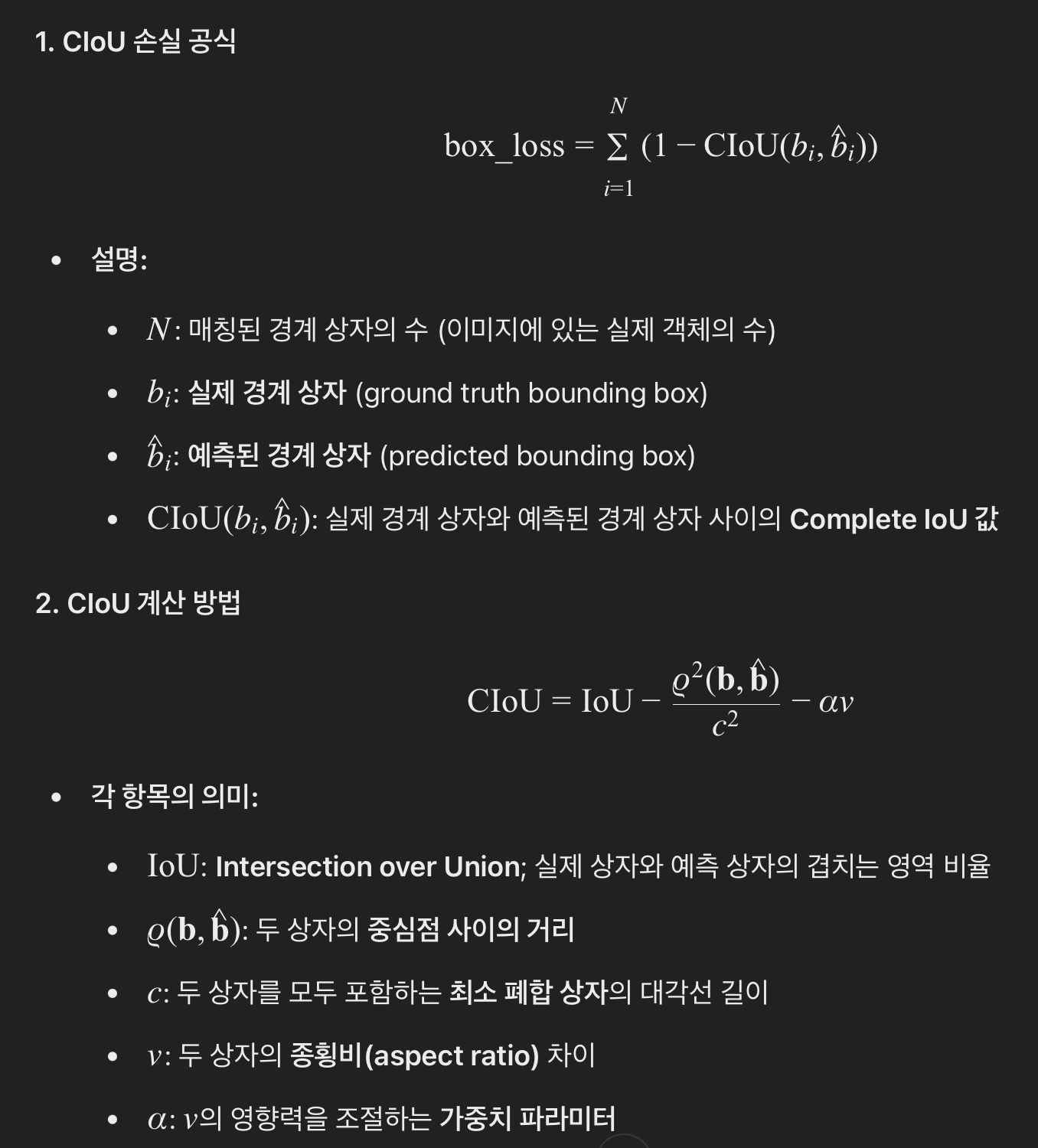

19.[keypoint detection] loss

정의: box_loss는 모델이 예측한 경계 상자와 실제 경계 상자(ground truth) 사이의 위치와 크기 차이를 측정하는 손실 함수이미지를 그리드 셀로 분할이미지를 가로와 세로로 작은 사각형들인 그리드 셀(grid cell)로 나눕니다.입력 이미지 크기: (가로