WHAT IS DNN?

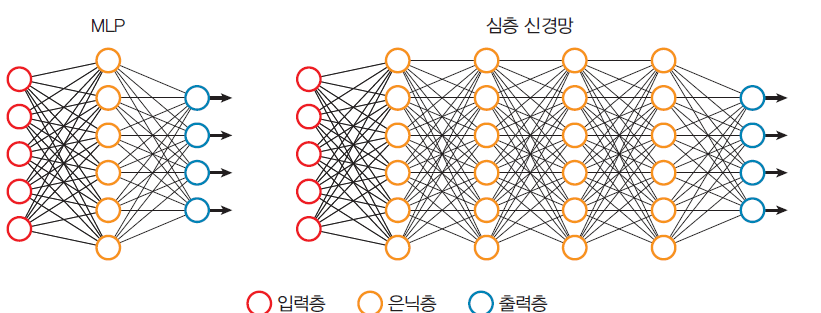

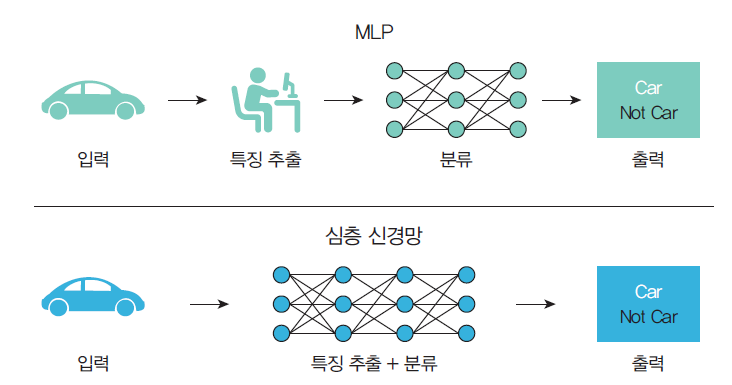

MLP(다층 퍼셉트론)에서 은닉층의 개수를

증가시킨 것이다.

은닉층을 하나만 사용하는 것이 아니고 여러 개를 사용한다.

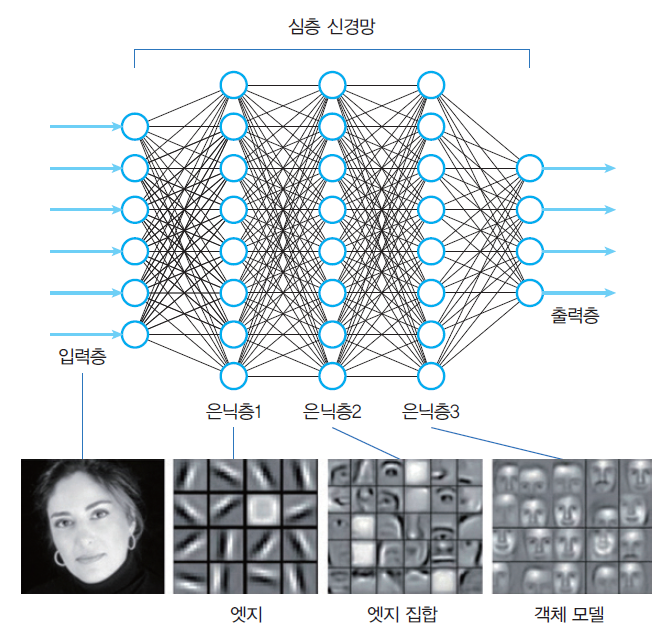

은닉층들의 역할

여러 개의 은닉층 중에서 앞단은 경계선(에지)과 같은 저급 특징들을 추출하고,

뒷단은 코너와 같은 고급 특징들을 추출한다.

MLP vs DNN

DNN의 문제점

그래디언트 소실 문제

심층 신경망에서 그래디언트가 역으로 전달되다가 점점 0에 가까워지는 문제

원인

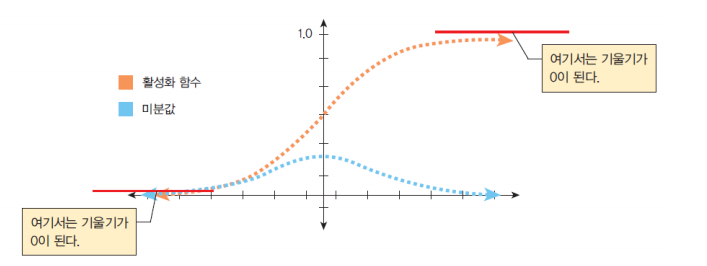

원인은 시그모이드 함수다.

시그모이드 함수의 특성상, 아주 큰 양수나 음수가 들어오면 출력이 포화되어서 거의 0이 된다.

해결책

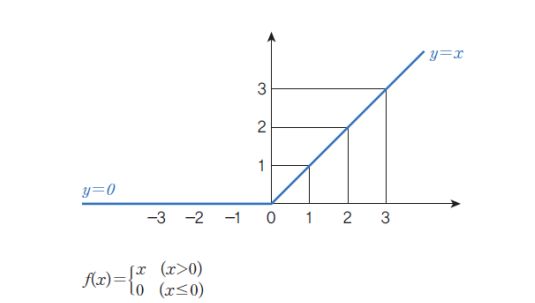

ReLU 함수를 사용한다.