AI BASIC

1.What is AI?

1997년 IBM의 딥블루: 체스시합에서 세계 챔피언이었던 카스퍼로프를 상대로 승리(인간을 넘어선최초의 컴퓨터)2011년 IBM의 왓슨: 퀴즈쇼 “제퍼디”에서 우승 차지2016년 알파고(AlphaGo):구글의 인공지능 바둑 프로그램- 이세돌과의 경기에서 4-1로 승리2

2.기계 학습의 종류

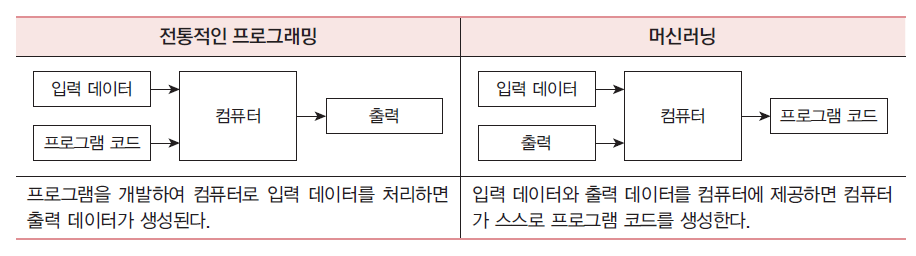

즉, 절차과정을 인간이 직접 작성하는지의 여부에서 차이가 난다.머신러닝은 입력을 받아서 출력하는 함수 y=f(x)를 학습한다고 할 수 있다. (함수 근사)크게 3가지로 나눌 수 있다.지도 학습예제와 정답이 주어지고, 이를 통해 학습하여 입력과 출력의 관계를 학습하여 새

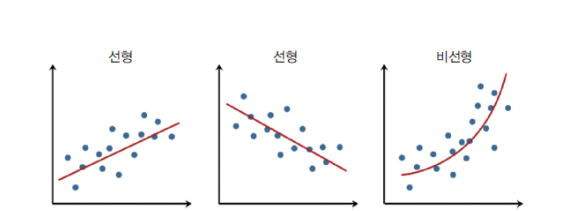

3.회귀(Regression)

vd

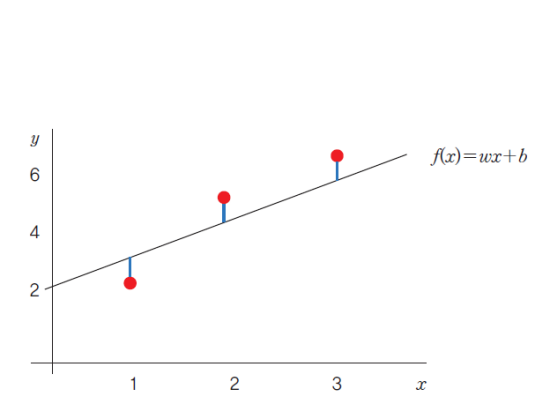

4.손실 함수(Loss Function)

모델의 출력값과 사용자가 원하는 출력값의 오차손실함수의 함수값이 최소화 되도록 하는 가중치(weight)와 편향(bias)를 찾는 것이 목표임각 점을 (x1, y1), (x2, y2)... 일 때 함수의 y값에 점의 y값을 빼서 제곱(음수를 제거하고 거리만을 보기 위함

5.최적화(Optimizer)

모델의 손실 함수(Loss Function)를 최소화한다는 의미이다.경사 하강법(Gradient Descent)경사 하강법은 손실 함수가 어떤 형태이라도, 또 매개 변수가 아무리 많아도 적용할 수 있는 일반적인 방법이다.경사를 따라 내려가면서 가중치(w) 업데이트 시킨

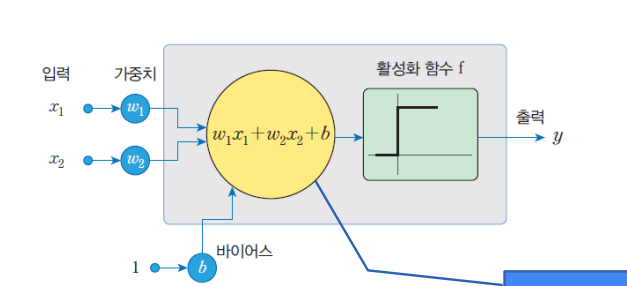

6.Perceptron

퍼셉트론(Perceptron)1957년에 로젠블라트(Frank Rosenblatt)가 고안한 인공 신경망뉴런에서는 입력 신호의 가중치 합이 어떤 임계값을 넘는 경우에만 뉴런이 활성화되어서 1을 출력한다. 그렇지 않으면 0을 출력한다. 학습이라고 부르려면 신경망이 스스로

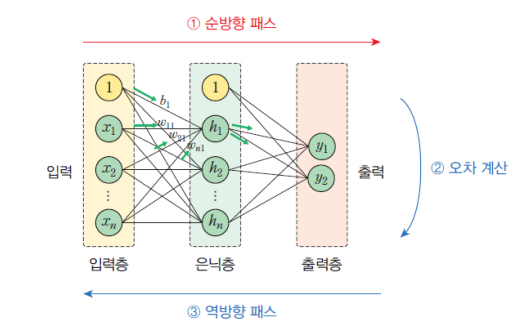

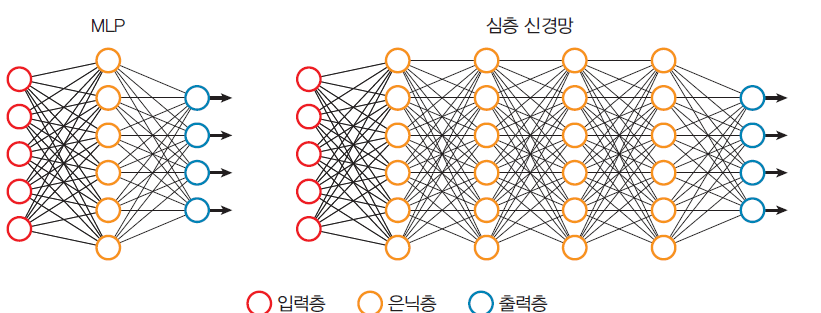

7.MLP (multi-layered perceptron)

다층 퍼셉트론(multilayer perceptron: MLP) > 입력층과 출력층 사이에 은닉층(hidden layer)을 가지고 있는 퍼셉트론 MLP에서는 다양한 활성화 함수를 사용한다. 일반적으로 많이 사용되는 활성화 함수 선형레이어는 많아도 쓸모가 없다.

8.DNN(deep neural networks)

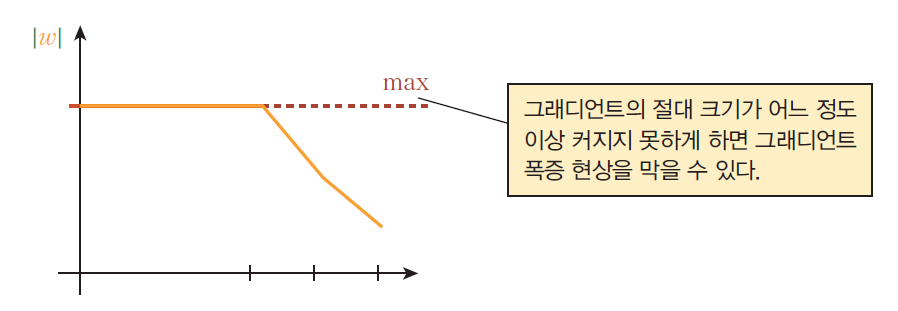

MLP(다층 퍼셉트론)에서 은닉층의 개수를증가시킨 것이다. 은닉층을 하나만 사용하는 것이 아니고 여러 개를 사용한다.여러 개의 은닉층 중에서 앞단은 경계선(에지)과 같은 저급 특징들을 추출하고, 뒷단은 코너와 같은 고급 특징들을 추출한다.그래디언트 소실 문제심층 신경망

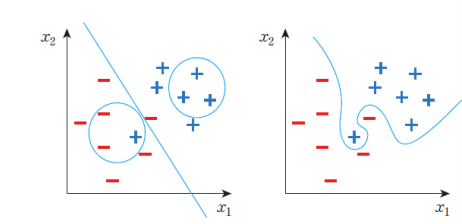

9.과잉적합&과소적합

과잉적합(Overfitting)과 과소적합(Underfitting)은 머신러닝 및 딥러닝 모델을 평가하고 최적화하는 과정에서 중요한 개념이다.지나치게 훈련 데이터에 특화돼 실제 적용 시 좋지 못한 결과가 나오는 것자세하게는 모델이 훈련 데이터에 너무 맞춰져서 훈련 데이

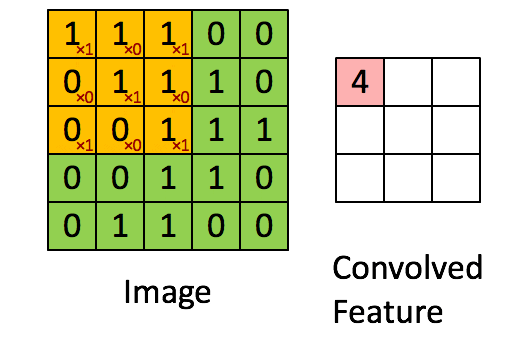

10.CNN(Convolutional Neural Networks)

컨벌루션 신경망(Convolutional Neural Network, CNN)은 주로 이미지 분석 및 컴퓨터 비전 작업에 사용되는 딥러닝 방식 중 하나이다. > 특히 이미지 처리에 탁월한 성능을 보인다. CNN의 탄생 인공신경망의 기본 구조로 이미지를 분석하기

11.RNN(Recurrent neural networks)

순환신경망(RNN)은 무엇인가? > RNN은 순차 데이터나 시계열 데이터를 이용하는 인공 신경망 유형이다. 순차 데이터(시계열 데이터) > 순차데이터란, 순서가 있는 데이터이다. 시간적인 순서도 가능하고 공간적인 순서도 가능하다. EX) 주식 가격이나 텍스트 데이터

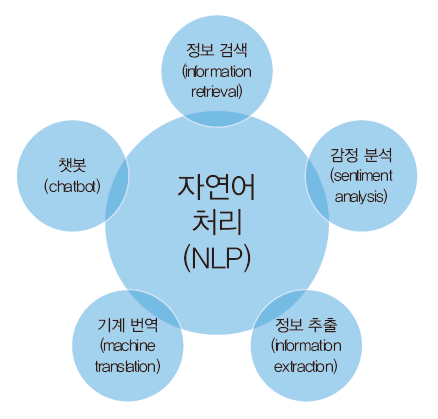

12.자연어 처리 (Natural language processing, NLP)

인간의 언어를 컴퓨터가 이해하고 해석하여 유용한 방식으로 사용할 수 있도록 하는 인공지능(AI)과 언어학의 한 분야자연어를 처리하는 방법에는 여러가지가 있다.딥러닝이 유행하기 전까지는 단어 간의 통계적인 유사성에 바탕을 둔 방법이 많이 사용되었다.최근에는 딥러닝을 이용

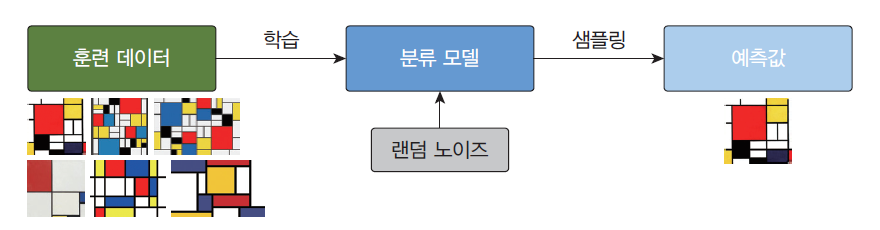

13.생성 모델 (Generative model)

생성 모델(generative model)은 훈련 데이터의 규칙성 또는 패턴을 자동으로 발견하고 학습하여, 훈련 데이터의 확률 분포와 유사하지만, 새로운 샘플을 생성하는 신경망이다. 생성 모델은 훈련 데이터들의 잠재 공간 표현을 학습할 수 있으며, 학습 종료 후에, 잠

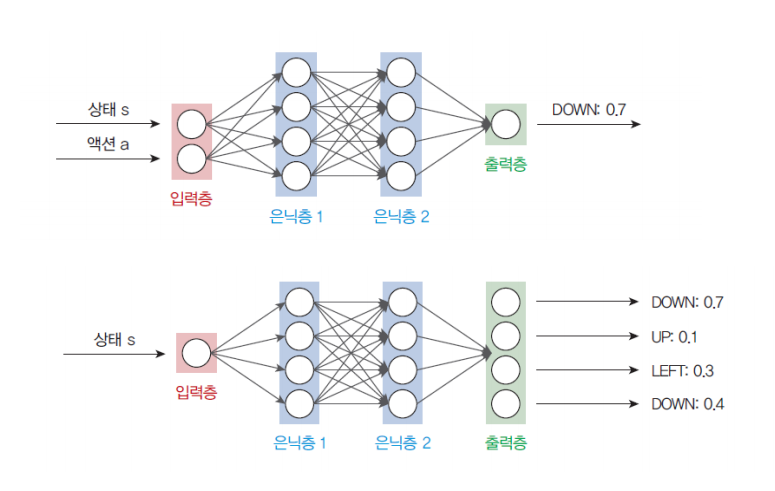

14.강화 학습

https://velog.io/@humpose/Fundamental-of-Machine-Learning 이전 시간에 다뤘던 지도 학습, 비지도 학습에 이어 강화 학습을 설명해보려고 한다. 강화학습이란?🤔 지금까지 우리가 살펴본 딥러닝에는 항상 인간이 훈련 데이터