GridSearch CV

- Classifier, Regressor과 같은 알고리즘에 사용되는 hyper parameter를 순차적으로 입력하면서 최적의 parameter 결과를 도출해줌

여러 parameter 값을 딕셔너리 형태로 만든 후 여러 조합을 넣어보면서 최적의 정확도를 가지는 parameter를 도출해줌

ex) Decision Tree Parameter

grid_parameters = {'max_depth' : [1, 2, 3],

'min_samples_split : [2, 3]

}GridSearchCV는 교차 검증을 기반으로 함

=> train, test 세트로 자동으로 분할한 뒤 모든 파라미터를 순차적으로 테스트

주요 parameter

estimator : 데이터 셋에 사용할 모델의 종류

(classifier, regressor, pipeline)

param_grid : parameter명, 사용될 parameter 지정

scoring : 예측 성능을 측정할 평가 방법 지정(ex) accuracy)

cv : 교차 검증을 위해 분할되는 train, test 세트의 개수를 지정

refit : Default = True며 가장 최적의 hyper parameter를 찾은 뒤 입력된 estimator 객체를 최적의 parameter 조합으로 재학습

예제

결정트리

parameter 이름 : dictionary, 값 : 리스트

from sklearn.datasets import load_iris

from sklearn.tree import DecisionTreeClassifier

from sklearn.model_selection import GridSearchCV

iris_data = load_iris()

X_train, X_test, y_train, y_test = train_test_split(iris_data.data, iris_data.target,

test_size=0.2, random_state=121)

dtree = DecisionTreeClassifier()

parameters = {'max_depth':[1,2,3], 'min_samples_split':[2,3]}GridSearchCV 적용

import pandas as pd

# refit = True (default) True이면 가장 좋은 파라미터 설정으로 재 학습

grid_dtree = GridSearchCV(dtree, param_grid=parameters, cv=3, refit=True)

# 붓꽃 Train 데이터로 param_grid의 하이퍼 파라미터들을 순차적으로 학습/평가 .

grid_dtree.fit(X_train, y_train)

# GridSearchCV 결과 추출하여 DataFrame으로 변환

scores_df = pd.DataFrame(grid_dtree.cv_results_)

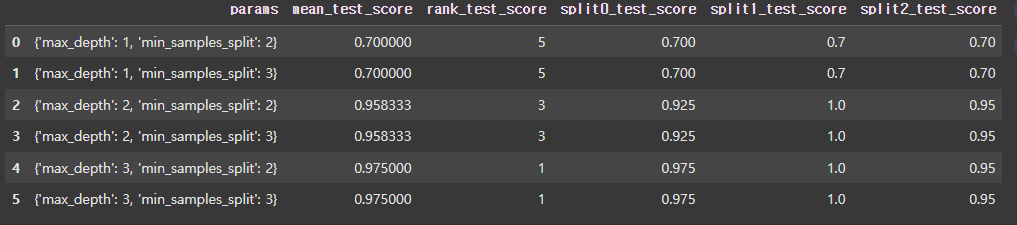

scores_df[['params', 'mean_test_score', 'rank_test_score', \

'split0_test_score', 'split1_test_score', 'split2_test_score']]

- 4번과 5번이 0.97로 공동 1등임

- GridSearchCV의 결과는 griddtree.cv_results에 들어감

- 최고 성능을 낸 parameter와 결과 값은 bestparams, best_score에 기록

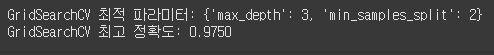

print('GridSearchCV 최적 파라미터:', grid_dtree.best_params_)

print('GridSearchCV 최고 정확도: {0:.4f}'.format(grid_dtree.best_score_))