대량의 corpus 로 encoder - decoder 기반의 PLM transformer 모델

Pegasus 는 기존 pretrained model 에서 사용하는 MLM(Masked Language Model) 과 유사하게 GSG(Gap-Sentences-Generation) 을 사용해 학습시켰다.

MLM 은 token 단위로 masking하여 masked token 을 예측하는 방식으로 학습을 진행하고,

GSG 는 Input Document 로부터 Sentence 단위로 Masking 을 한 후 Sentence 를 기반으로 masked sentence 를 예측하는 방식으로 학습된다.

subword BPE 가 아닌 SentencePiece Unigram 을 사용한다.

GSG 는 3가지 방식으로 수행된다. , Three primary strategies for gap-sentence

- Select and mask whole sentences from documents

- Concatenate the gap-sentences into a pseudo-summary

- The ccorresponding position of each selected gap sentence is replaced by a mask token [MASK1] to inform the model

(여기서 gap sentence 비율은 GSR(Gap Sentences Ratio)에 의해 결정되는데 이는 문서의 전체 sentence에서 선택된 gap sentence의 비율을 의미하고, 다른 Masked Language Model에서의 mask rate와 유사한 개념이라고 생각하면 된다. 해당 논문에서는 GSR의 비율에 따른 성능을 실험하였는데 데이터셋에 따라 성능 편차가 있었지만, 최종적으로 GSR을 30%로 선택하였다고 한다.)

그러면 어떤 문장이 gap sentence ?

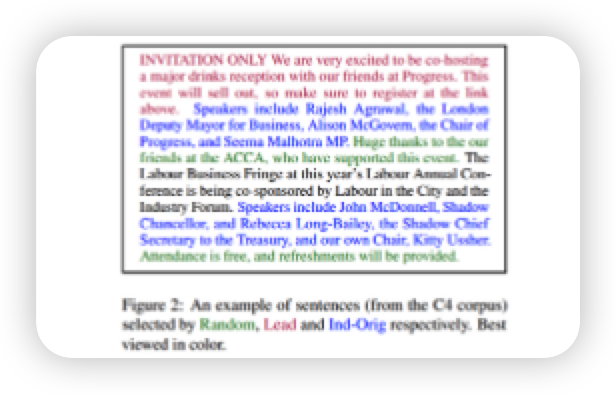

Random : Uniformly select m sentences at random

Read : Select the first m sentences

Principal : Select top-m scored sentences according to importance. As a proxy for importance compute ROUGE1-F1 between the sentence and the rest of document

다시말해

Random 은 랜덤하게 m개 문장을 추출하는 것이고

Read 는 문서의 가장 첫 m개의 문장,

Principal 은 selected sentence 와 remaining sentence 간의 ROUGE1-F1 score 를 기반으로 top-m 개의 sentence 를 선정하는 것을 말한다.

(예시)

그러면 성능은 ?

적은 데이터 셋으로도 12 개의 bench mask task 에서 모두 SOTA 를 달성

또한 CNN/DailyMail, XSum 에서는 PEGASUS 모델이 만든 요약본이 사람이 만든 요약본보다 더 높은 성능을 보여줬다.