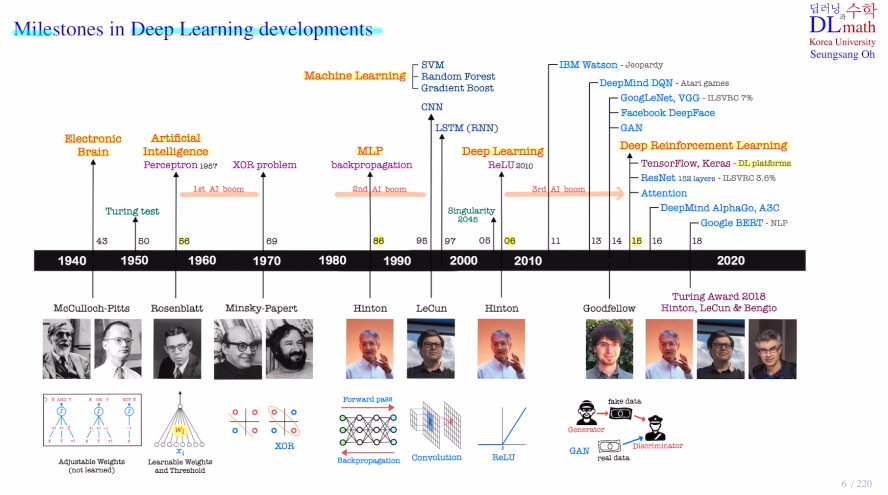

AI 역사에 대해 알아보자!

초창기 인공지능과 딥러닝의 발전을 보자

Eletronic Brain(Computer:ENIAC)

프로그래밍 : 뉴런을 본 따 만든 것, weight를 계산하고 step ft을 통해 도출

=> AI . perceptron 1차AI붐

learning

컴퓨터가 자아의지 및 창의력이 있을까?

프로그램한데로 결과가 나오는 것이기에 아니다.

하지만 사람도 결국 2백억개의 뉴런의 프로그래밍 결과이지 않느냐?

여기서 Turing test 실행 : 사람인지 기계인지 헷갈릴 정도가 오면 사람과 유사한 지능을 가졌다고 판단. 이 배경으로 만든 영화가 Blade runner(영화에서 기계인지 사람인지 대화를 할 때, Turing test와 똑같은 기법)

Dartmouth conference에서 AI를 공식적인 학문분야로 인정

이제 learning의 내용이 들어간다. 가중치들이 학습할 수 있게 하고, 마지막 판단을 내릴 때 0or1 step ft이 아닌 activation ft sigmoid를 이용하여 결론을 유추

이로인해 복잡한 문제를 해결할 수 있게 된다.

reasoning추론(인간의 사고 과정) search탐색(결정할 때 모든 경우의수 중 최적의 판단) 의 시대

=> XOR problem 1차빙하기

Perceptron은 사람처럼 고도화된 문제(XOR)를 풀 수 없다고 한계점을 지적

- weak AI : 특정 한 가지 분야에서 빠른 연산력을 보인다.

- strong(general) AI : 로봇을 만들 때 한 가지 목적이 아닌 다양한 분야에서 일을 할 수 있는 AI - 아직까지는 현실적으로 어렵다

- Super AI : 초인공지능으로 strong AI가 인간의 분야에서 유사하게 일을 할 수 있다면, 이를 뛰어 넘어선 것을 Super AI라고 한다.

=> Hinton교수의 backpropagation : 2차AI붐 머신러닝의 발전(SVM, RF, GB)

layer가 깊어질 수록 사람이 생각할 수 있는 복잡한 문제도 구현이 가능하게 된다.

Knowledge 지식의 시대로 머신러닝의 발전

데이터 전처리 과정에서 사람이 필요한 feature만 잘 뽑아내면 적은 데이터로도 좋은 성과를 보인다.

=> 기울기 소실 문제로 2차빙하기

layer가 많아질 수록 기울기소실 문제가 발생

방대한 양의 데이터를 넣을 수 없다.

CNN, LSTM의 발견

CNN : flatten을 시키면 너무 많아지는 문제와 강아지와 같은 비슷한 이미지들을 같은 클래스로 구분할 수 있는지에 대한 문제를 이미지 데이터의 문제를 CNN을 통해 해결한다.

LSTM(RNN) : RNN의 장기기억력 문제를 해결하여 sequential 데이터들을 효율적으로 다룰 수 있게 된다.

2005 singularity is near : 특이점. 사람보다 뛰어난 알고리즘을 짜게 되면, 이 더 훌륭한 알고리즘은 또 더 좋은 알고리즘을 짜고, 이것이 폭팔적으로 반복되어 슈퍼AI가 출현할 것이다.

=> Hinton교수의 Relu개발로 3차AI붐

Hinton교수는 2006 딥러닝을 공식적으로 선포, 기울기 소실을 극복하기 위한 relu개발을 통해 3차 AI 붐이 일어났다.

IBM 왓슨 : 의료용으로 만들어졌다. jeopardy 연속 74회 우승한 사람과 대결하여 왓슨이 우수한 정적으로 우승

딥마인드의 DQN : 사람보다 뛰어난 성능을 보였다. ex) 블락을 깨는 게임 - 학습을 하게 되면, 공의 방향을 조절하여 볼이 빨라지기 전에 한쪽을 깨서 넣는다.

구글이 이 딥마인드 팀을 인수하고 Deep Reinforcement Learning이 성장했다.

GoogLeNet, VGG : 14,000,000장 이미지가 있는 ImageNet에서 이 CNN을 잘 접목시켜 AlexNet부터 결국 GoogLeNet, VGG 로 오차를 7%까지 줄였다.

Facebook의 DeepFace

GAN : 데이터를 생성할 수 있게 된다! 이는 생성자와 판별자를 이용하여 학습을 적대적으로 진행한다.

-> 계속해서 발전해오다 Deep Reinforcement Learning 등장

2015 tensorflow, keras

ResNet : layer수가 20개밖에 되지 않던 GoogLeNet, VGG와 달리, residual learning을 통해 layer를 깊게 쌓을 수 있게 되고 성능 또한 우수하게 만들었다.

Attention : 이미지를 볼 때 특정한 부분을 관심있게 보는 것이 효율적일 것이다. 예를 들어 엑스레이를 찍을 때 단순 판단이 아닌, 어느 부분을 집중해서 보았는데 이상을 탐지함을 확인할 수 있는 것이다. - 판단의 근거를 알 수 있게 되는 것이다!

AlphaGo : A3C

Google BERT : NLP - Transformer의 인코더

OpenAI : GPT3 : 디코더

Turing Award : Hinton, LeCun & Bengio

고려대학교 오승상 교수님 딥러닝 강의 : https://www.youtube.com/watch?v=ykIyKT_HMeE&list=PLvbUC2Zh5oJvByu9KL82bswYT2IKf0K1M&index=8