self-learnging 알고리즘과 관련된 인공지능의 하위분야로 머신러닝이 출현함

인간이 직접 대량의 데이터를 분류하고 규칙을 유도하며 모델을 구축하는 기호주의 방식에서 벗어나

머신러닝을 통해 데이터에서 더 효율적으로 지식을 추출하고 이를 바탕으로 예측 모델과 데이터 기반의 의사결정을 진행함

광고성 이메일 필터링, 손글씨 & 음성인식, 웹 검색엔진, 체스 대결 프로그램, 군사용 자율주행 시스템 까지 등장

지도학습

예를 들어 광고성 이메일 필터링을 할 때 지도 학습 머신러닝 알고리즘은 학습이란 과정을 통해 데이터를 학습할 수 있는데 이 데이터 셋은 광고성 메일 또는 일반메일로 정확하게 표시 되어 있다.

그리고 훈현을 마친 모델은 새로운 이메일이 들어왔을 때

두 개의 범주 중 어디에 속하는지 예측한다.

이와 같은 광고성 이메일 필터처럼 개별 클래스 레이블이 있는 지도학습을 분류라고 부른다.

지도학습의 또 다른 종류는 연속적인 값을 예측하는 회귀가 있다.

분류는 지도학습의 하위 카테고리에 속해있음

이러한 분류는 과거의 관측을 기반으로 새로운 샘플의 범주형 클래스 레이블을 예측하는 것이 목적

클래스 레이블은 이산적이고 순서가 없어 데이터가 속한 그룹으로 이해할 수 있는데 앞서 언급한 광고성 이메일 감지가 전형적인 이진분류작업의 예다.

광고성 이메일과 일반 이메일을 구분하기 위해 머신러닝 알고리즘은 일련의 규칙을 학습하게 된다.

👆 30개의 훈련 데이터가 있는 이진 분류작업의 개념 나타냄

15개의 샘플은 광고성 이메일 클래스로, 다른 15개는 일반메일 클래스로 되어있음

각 데이터는 x1과 x2 두개의 값에 연관되어 있으므로

2차원 데이터 셋이라 할 수 있다.

지도 학습 알고리즘을 사용하여 두 클래스를 구분할 수 있는 규칙을 학습시킨다.

이 규칙을 점선으로 표현할 수 있으며 이는 결정경계라고 부른다.

최종적으로 학습을 마친 알고리즘에 새로운 데이터가 들어오고 이 데이터에 x1과 x2값이 주어지면 두 범주 중 하나의 범주로 분류된다.

하지만 세상에는 두 개 이상의 클래스 레이블을 가진 경우가 많다.

그래서 지도 학습 알고리즘으로 학습한 예측 모델은 훈련 데이터 셋에 있는 모든 클래스 레이블을 새로운 샘플에 할당할 수 있어야 한다.

이러한 다중 샘플의 전형적인 예는 우리가 익히 알고 있는 손글씨 인식이 있다.

각 글자를 손으로 한자 한자 쓴 이미지 샘플을 모아서 훈련 데이터 셋을 구성하고 학습하며, 새로운 글자를 입력으로 제공하면 모델은 머신러닝 알고리즘을 바탕으로 우리가 쓴 손글씨 알파벳을 예측한다.

회귀

예를 들어 프로게이머 지망생들의 게임 랭크 점수를 예측한다고 가정해 보자

게임 연습에 투자한 시간과 최종 점수 사이에 관계가 분명히 있다면 우린 두 값으로 훈련 데이터를 마들고 모델을 학습시킬 수 있다.

프로게이머 지망생들의 연습량 데이터를 활용해 최종 랭크 점수를 예측하고 선수에게 더 맞는 훈련 방향성을 잡아 볼 수 있을 것이다.

입력값 x와 결괏값 y가 주어지면 각 데이터와 직선 사이 거리가 최소가 되는 직선을 그을 수 있는데, 일반적으로 평균 제곱 거리를 사용합니다.

이렇게 데이터에서 학습한 직선의 기울기와 절편을 사용하면 머신러닝 알고리즘은 새로운 데이터의 출력값을 예측할 수 있다.

강화학습

과거 강화 학습은 머신러닝의 한 분야로 조그맣게 소개되었지만

최근 들어 급격하게 떠오르고 있는 분야로

실제로 강화학습만을 대상으로 집필한 책도 출간되고 있다.

그만큼 강화학습은 공부해야할 이론과 개념이 방대하며

이를 적용한 사례도 이제서야 조금씩 모습을 드러내고 있는 추세이다.

환경이란 개념과 상호작용하며 에이전트의 성능을 향상시키는 것이다.

환경의 현재 상태 정본느 보상 신호라는 것을 포함하기 때문에

강화학습을 지도학습과 관련된 분야로 생각할 수도 있지만,

이 강화학습의 피드백은 정답 레이블이나 수차가 아니다.

보상 함수라는 것을 통해 에이전트가 취한 행동이

얼마나 좋은 행동인지 혹은 좋지 못한 행동인지를 측정한 값이다.

이러한 에이전트는 환경과 핑퐁하며 보상이 최대화하는 일련의 행동을 강화 학습을 통해 학습한다.

강화학습의 대표적인 예는 게임인데

2014년 딥 마인드는 알파고의 전신인 강화학습의 연장선에 있는 Deep-Q-Network를 통해 아타리 게임의 절반 이상에서 사람보다 더 높은 스코어를 달성합니다.

최근 2020년 4월 딥마인드는 다시 한 번 인공지능 에이전트 57을 공개 이 인공지능은 아타리 게임의 57종 모두를 마스터했다.

어떤 방식으로 에이전트는 게임을 학습하는 걸까?

벽돌 깨기는 단순히 하단의 배트로 공을 튕겨 위의 벽돌을 제거함으로 점수를 얻는다.

에이전트는 어떻게 해야 점수를 얻는지 어떻게 하면 게임 오버가 되는지 전혀 모른 상태에서 게임을 시작한다.

하지만 게임의 수를 거듭할 수록 어떻게 하면 양의 보상을 얻는지,

어떻게 하면 음의 보상을 얻는지 행동과 환경 그리고 바상이라는 개념을 통해 학습을 하기 시작함.

보상이 최대화 하는 '일련의 행동'을 학습을 진행함.

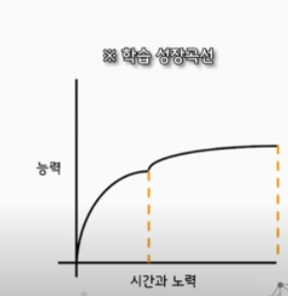

사람은 게임에 대하여 어느 정도 학습을 하고 점수를 얻는 방식을 깨달으면, 극한의 스코어를 얻기까지 '시간'과 '노력'이 상당히 소요된다.

하지만 강화학습은 사람과 달리 이러한 학습과정을 밤낮없이 진행할 수 있으며 단기간에 놀라운 성장을 보여준다.

그리고 이세돌과 알파고이 2번째 대국의 37번째 수처럼 사람은 이해할 수 없는 행동을 취하고, 이는 '사람이 생각하지 못한 수'가 됩니다.

이처럼 강화학습은 머신러닝에서 급격하게 떠오르고 있는 분야이다

비지도 학습

강화학습에서는 에이전트의 행동을 어떻게 보상할지 그 측정 방법을 정의했다.

비지도 학습을 사용하면 출력값이나 보상 함수의 도움 없이도

의미있는 정보를 추출할 수 가 있으며 데이터 구조를 탐색할 수가 있게 된다.

군집

군집은 사전 정보 없이 쌓여있는 그룹 정보를 의미있는 서브 그룹 도는 클러스터로 조작하는 탐색적 데이터 분석 기법이다.

분석과정에서 만든 각 클러스터는 어느 정도 유사성을 공유하고 다른 데이터(클러스터)와 구분되는 그룹을 형성한다.

차원축소

비지도 학습의 또 다른 하위 분야로, 고차원의 데이터를 저차원으로 축소하는 기법이다.

고차원 데이터가 많아 머신러닝 알고리즘은 계산 성능과 저장 공간의 한계에 종종 맞닥뜨렸으나

무작정 이상치라 판단되는 데이터 일부를 제거하게 되면 특정 알고리즘의 예측 성능을 감소시키는 불상사가 생기기도 한다.

이런 상황을 극복하고자, 비지도 차원 축소 기법은 대부분의 정보를 유지하면서 더 작은 차원의 부분 공간으로 데이터를 압축시키게 된다.