1주차가 드디어 시작됐는데 하루종일 공부해본 게 정말 오랜만이라 은근 힘들었다.💦

매주 애매했던, 기억하고 싶은 개념들을 정리하고자 하는데 꾸준히 기록하는 걸 잘 못해서 이번에 정말 빠짐 없이 매주!! 기록하자고 다짐했다.

덮어놓고 지나가는 개념이 없도록 모르는 부분들을 전부 찾아보고자 했는데 역시 가장 어려운 부분은 수학... 수식을 유도하고 싶어도 기본 지식이 부족한 느낌이 들어 수학 공부를 열심히 해야겠다고 생각했다.😭

Linear Regression

바로 직전 학기에 머신러닝을 들었어서 그런지 익숙한 내용들이라 평이하게 느껴졌다.

심지어 이전까지 했던 PyTorch 자료형의 간단한 사용법보다 더 듣기 편했다. ㅎㅎ

선형 회귀 분석이란, 종속 변수 y와 한 개 이상의 독립 변수 x와의 선형 상관 관계를 모델링하는 회귀 분석 기법이다. [출처: Wikipedia]

또한, 국어사전에서 회귀란 수학 용어로, 하나의 종속 변수와 두 개 이상의 독립 변수 사이에 나타나는 관계를 최소 제곱법으로 추정하는 방법을 말한다. [출처: 국어사전]

선형 관계라는 용어에 대해서 어렵게 생각할 것 없다!

단지 독립 변수가 증가할 때 종속 변수도 함께 증가하는지, 혹은 독립 변수가 증가할 때 종속 변수는 반대로 감소하는지에 대한 관계를 선형 관계라고 한다.

이때, 전자의 경우를 양의 선형 관계라고 하고, 후자의 경우를 음의 선형 관계라고 한다.

다시 말해, 두 데이터의 값 사이에 직선과 같은 형태의 식이 있으면 선형 관계가 있는 것이다.

선형 회귀에서의 가정

선형 회귀 분석을 적용하기 위해서는 여러 가정이 성립해야 한다.

선형성

선형 회귀 분석의 정의에서 알 수 있듯이, 종속 변수가 독립 변수와 선형 회귀 계수의 선형 조합으로 표현 가능함을 말한다.

독립성

다중 회귀 분석을 수행할 때 독립 변수 x간 상관 관계가 없이 독립성을 만족하는 특성을 의미한다.

비슷한 특징을 갖는 독립 변수를 여러 개 사용하여 선형 회귀 분석을 수행하면 유의미하지 않은 결과가 도출되며, 이렇게 발생하는 문제를 다중공선성(Multicollinearity)라고 한다.

다중공선성이 회귀 분석에서 문제가 되는 이유는 다음과 같다.

종속 변수를 예측할 때 사용되는 독립 변수들은 설명 변수라고도 하는데, 일반적으로 회귀 분석에서 종속 변수에 대해 하나의 설명 변수의 영향력을 파악할 때 다른 설명 변수들은 모두 고정이라고 과정하기 때문이다.

따라서 서로 종속 관계에 있는 두 개 이상의 변수가 설명 변수가 되면 하나의 설명 변수에 대한 영향력을 정확히 파악할 수 없게 된다.

이를 수학적으로 증명해보자! 확통적으루다가...

서로 종속 관계에 있는 설명 변수를 각각 라 하고, 회귀 계수(weight)를 라고 하자.

로 표현할 수 있다. 이때 회귀 계수 W는 일반적으로 최소 제곱법을 사용하기 때문에 아래와 같은 식으로 도출할 수 있다.

여기서 행렬 가 선형 종석일 경우 해당 행렬의 determinant가 매우 작아져 가 매우 커진다. 결과적으로 회귀 계수를 계산하기 어려워질 뿐만 아니라 의 값이 매우 커져 올바른 결과를 도출하지 못하게 된다.

등분산성

서로 다른 종속 변수들의 잔차(정답값과 예측값의 차이)의 분산이 독립 변수와 무관하게 항상 같은 분산을 가지는 것을 의미한다.

이 가정이 만족되지 않으면 이분산성(Heteroscedasticity)이 발생하며, 회귀 계수의 표준 오차에 영향을 미치기 때문에 편향된 학습이 이루어질 수 있다.

정규성

앞서 설명한 등분산성과 비슷한 맥락에서 잔차가 정규 분포를 따라야 함을 말한다.

정규 분포에서 크게 벗어나게 되면 등분산성과 마찬가지로 편향된 학습이 이루어질 것으로 생각되는데 내 생각이 맞는지 모르겠다.

Logistic Regression

Linear Regression이 주어진 데이터의 특성을 잘 나타내는 모델을 구하는 거라면, Logistic Regression은 주어진 데이터를 잘 구분하는 모델을 구하는 것이다.

직전 학기(24년도 1학기)에 머신러닝을 배울 때도 초기에 등장했던 개념인데 중간고사 공부 겸 수식에 대하여 정리한 내용이 있어 복습하며 정리하고자 한다.

Multinomial Logistic Regression(다중 분류 문제)도 수행할 수 있지만, 간단히 Binary Classification(이진 분류 문제)을 기준으로 설명할 것이다.

모델

먼저 모델은 y의 확률 즉, class가 1일 확률을 계산한다.

Odds & Logits

회귀는 일반적으로 의 형태를 갖는다. 하지만 이 값은 의 범위를 가지기 때문에 Binary Classification을 수행할 수 있도록 [0, 1]의 이산적 값을 가질 수 있는 형태로 변환해야 한다.

이때 Odds 개념이 등장하는데, Odds란 전체 데이터에 대한 각 class label들의 비율을 나타내며, 이를 수식으로 표현하면 아래와 같다.

이때 는 의 확률이며, )의 범위는 갖는다.

이 에 자연로그를 취한 것이 이며, 수식은 아래와 같다.

의 범위가 (-, )이고, 이게 바로 의 식이 된다.

Logistic Function

위 내용의 결론만 수식으로 표기하여 정리하면 아래와 같다.

앞서 설명했듯이 p는 class의 label이 1일 확률이기 때문에 해당 식은 독립 변수 x가 주어졌을 때 해당 변수의 class가 1일 확률을 나타내는 식이 되며, 이 식을 sigmoid 함수라고 한다.

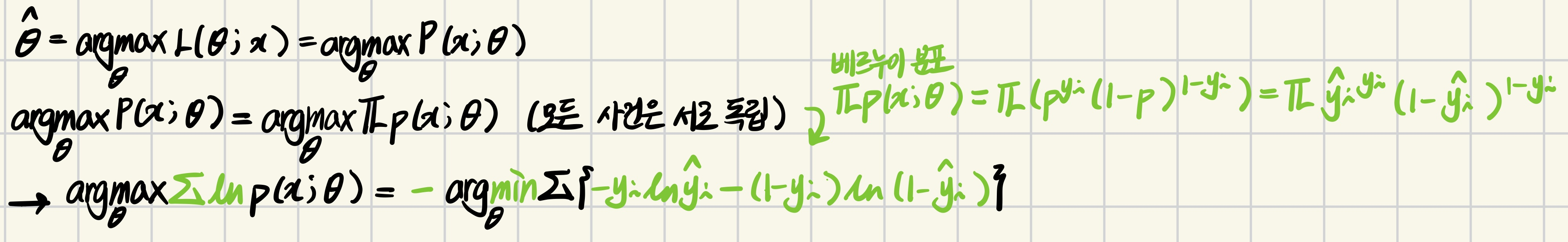

Estimating Parameters

학습을 하기 위해서는 sigmoid 함수가 얼마나 잘 맞히는지를 알아볼 수 있는 Cost Function이 필요하다. Logistic Regression에서의 Cost Function은 정답과 예측값(Logstic Function)이 얼마나 유사한지를 계산하는 Maximum Likelihood Estimation을 사용한다.

Maximum Likelihood Estimation은 우리말로 최대 가능도 추정이라고 하는데, 모집단에 대해 이론적으로 가장 가능성이 높은 모수를 추정하는 것을 말한다.

여러 확률 분포 X에 대한 확률 밀도 함수는 로 정의할 수 있으며, 가능도 함수인 와 동치이다. 이때 는 베르누이 확률 분포라고 하고, 로 표기하며, 수식으로 표기하면 아래와 같다.

: 가능도 관점에서 본, 데이터의 분포 x가 주어졌을 때의 모수

: 확률 관점에서 본, 데이터 분포의 모수 가 주어졌을 때 x값을 가질 확률

식을 정리하면 아래와 같다.

(마크다운 너무 복잡해서~~ 손필기 첨부😀)

결과적으로 그림의 마지막 식이 Cost Function이 되며, 이진 분류에서 사용하는 Binary Cross Entropy이다.

출처

최대가능도 추정법

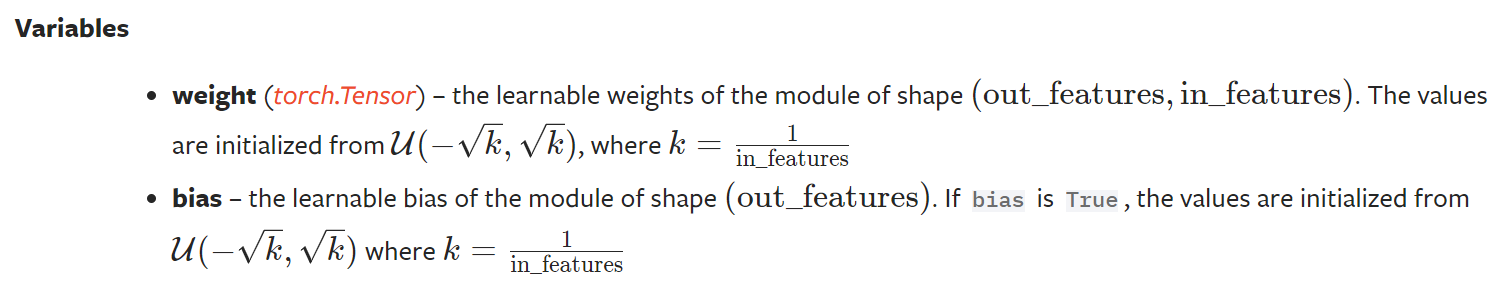

torch.nn.Linear

일반적으로 nn 모듈 없이 직접 수식과 레이어, 모델을 정의할 때는 weight와 bias를 torch.randn()을 사용한다. 하지만 torch의 Linear 레이어에는 초기 loss값을 줄이며 모델을 보다 빠르게 수렴하게 하고자 하는 방법이 적용되어 있다.

먼저 공식 문서에서 설명하는 weight와 bias를 초기화하는 방법은 아래와 같다.

코드 구현을 살펴보면, 아래와 같이 weight와 bias를 초기화하는 부분이 있다.

def reset_parameters(self) -> None:

# Setting a=sqrt(5) in kaiming_uniform is the same as initializing with

# uniform(-1/sqrt(in_features), 1/sqrt(in_features)). For details, see

# https://github.com/pytorch/pytorch/issues/57109

init.kaiming_uniform_(self.weight, a=math.sqrt(5))

if self.bias is not None:

fan_in, _ = init._calculate_fan_in_and_fan_out(self.weight)

bound = 1 / math.sqrt(fan_in) if fan_in > 0 else 0

init.uniform_(self.bias, -bound, bound)이때 kaiming_uniform_이라는 함수가 사용되는데, 이는 Kaiming He라는 사람이 개발한 He Initialization이라고 하는 Parameter Initialization 기법이다.

활성화 함수로 ReLU를 사용할 때 파라미터를 랜덤 초기화 할 경우 기울기 소멸 또는 폭발 등의 문제를 해결할 수 있다.

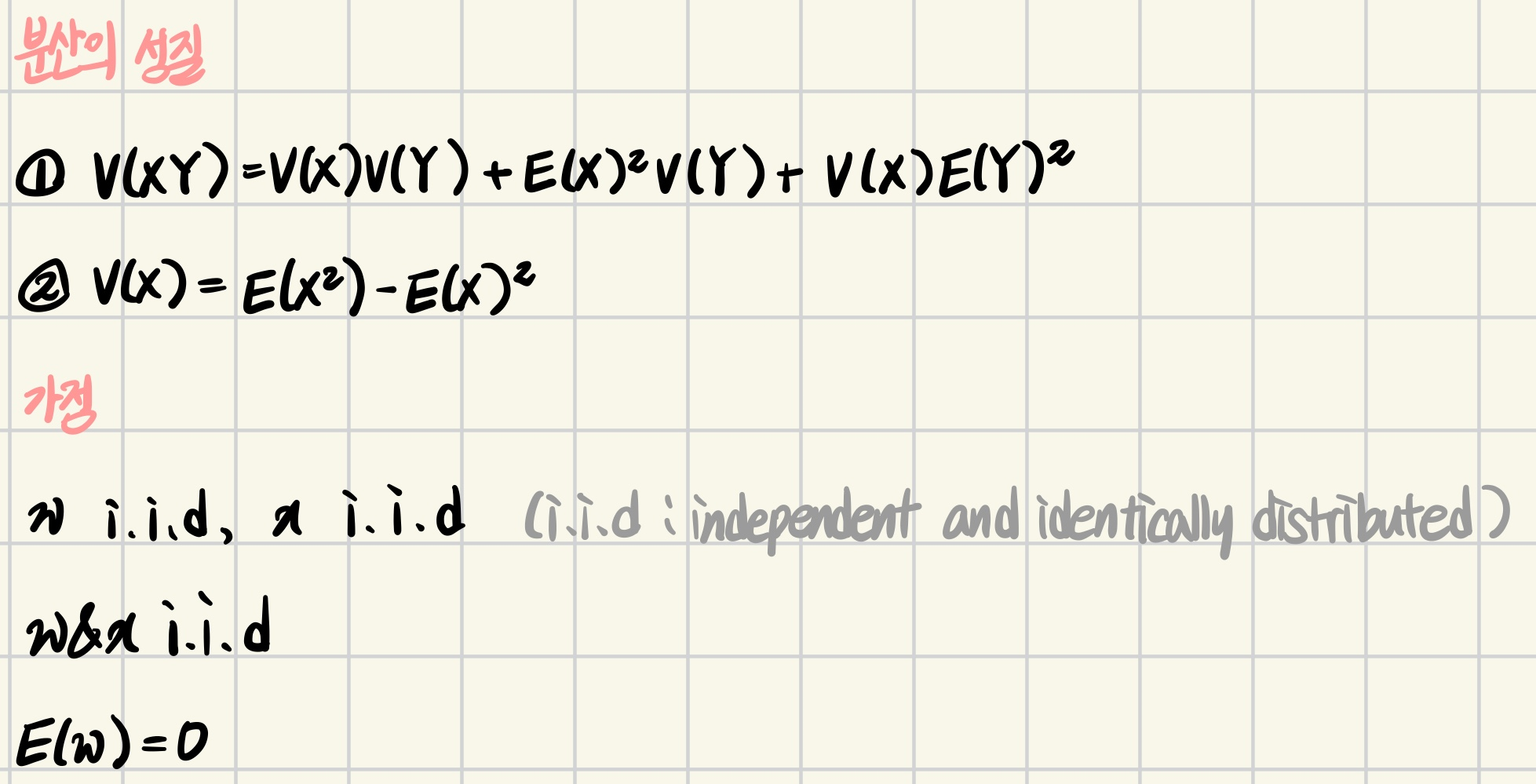

아래는 증명에 관한 내용인데 반 정도밖에 이해를 못해서 틀린 부분이 있다면 댓글 달아주십셔.

He Initialization의 증명을 시작하기에 앞서, 분산의 성질과 가정이 필요하다.

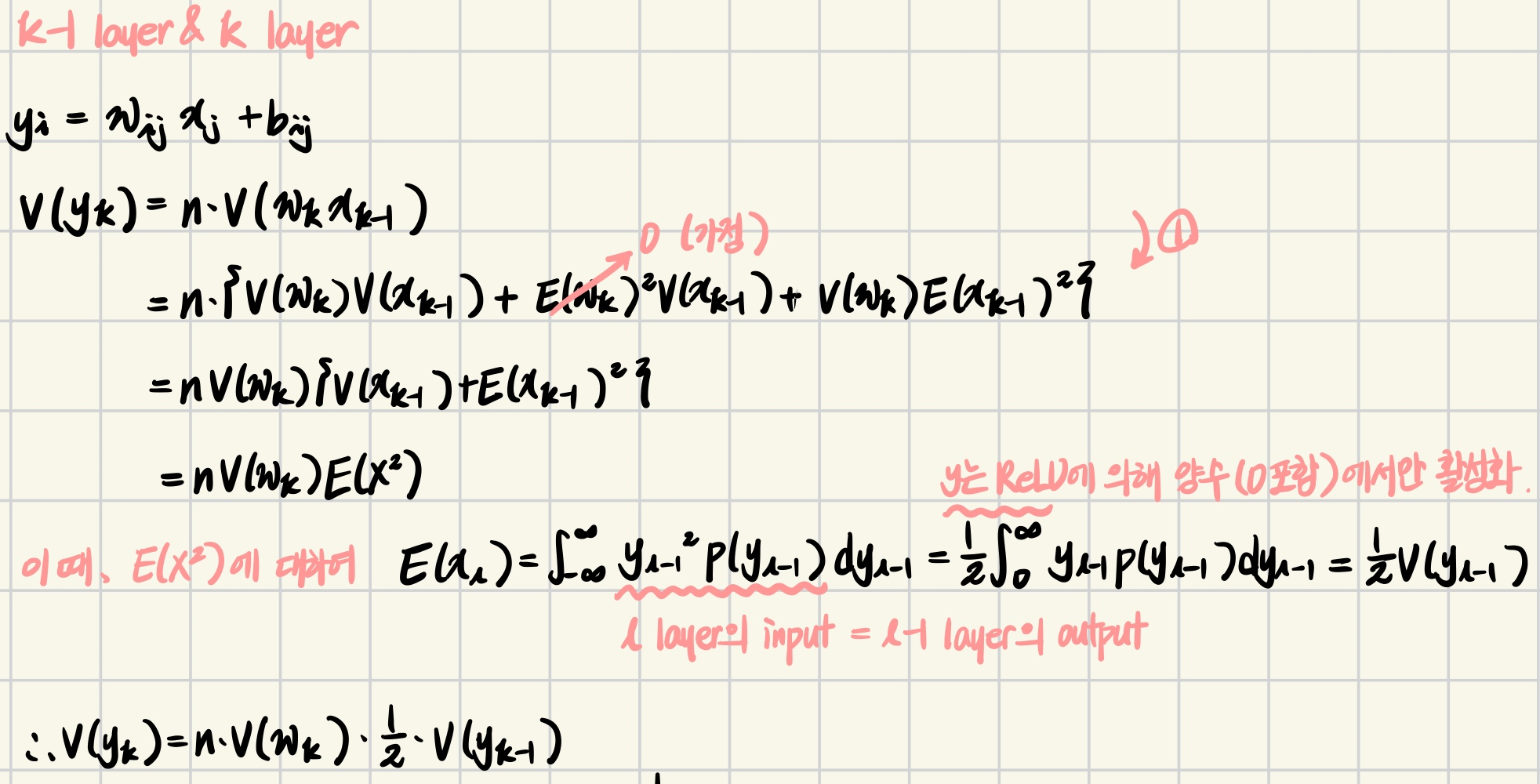

다음으로 Logistic Regression 수행을 위해 k-1번째 layer와 k번째 layer의 식을 살펴보자.

이때 적절한 Parameter Initialization란, input 벡터()가 여러 번의 layer()을 거쳤을 때 기하급수적으로 줄어들거나 확대되는 것을 방지해야 한다.

즉, input 벡터와 output 벡터의 분산이 유사하거나 동일해야 한다는 것이다.

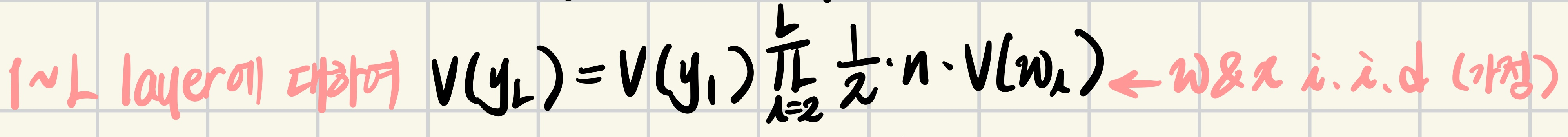

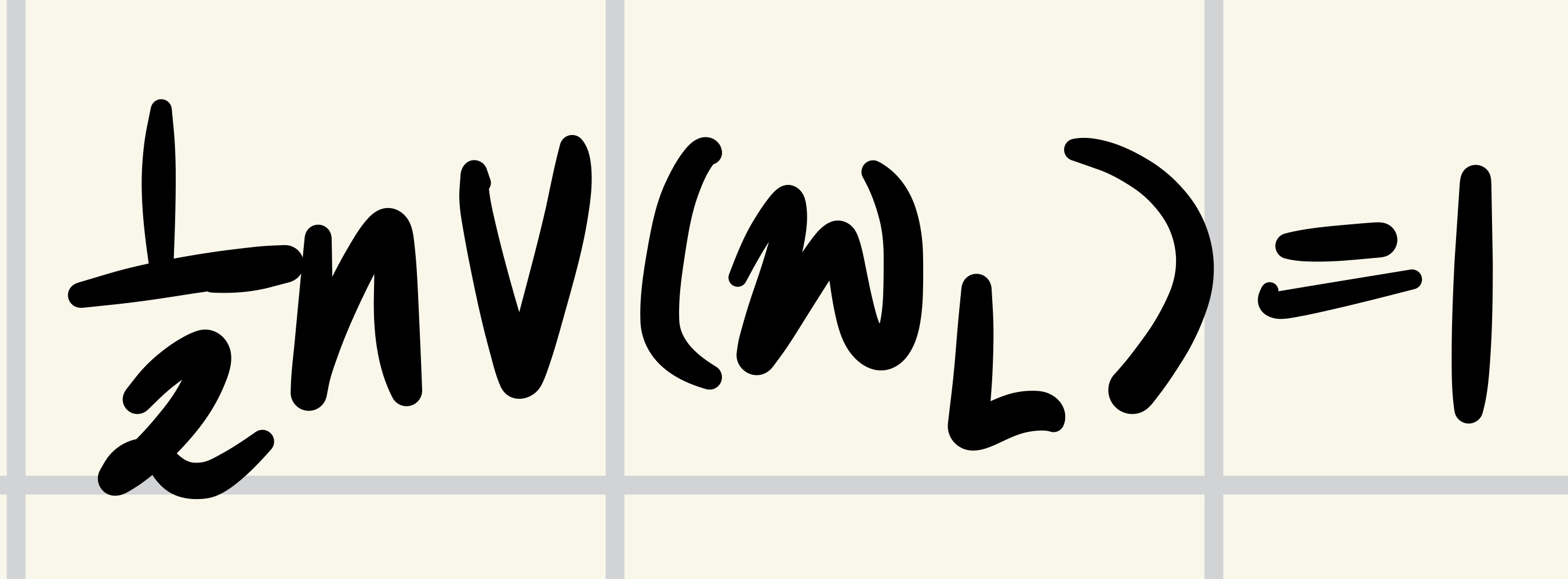

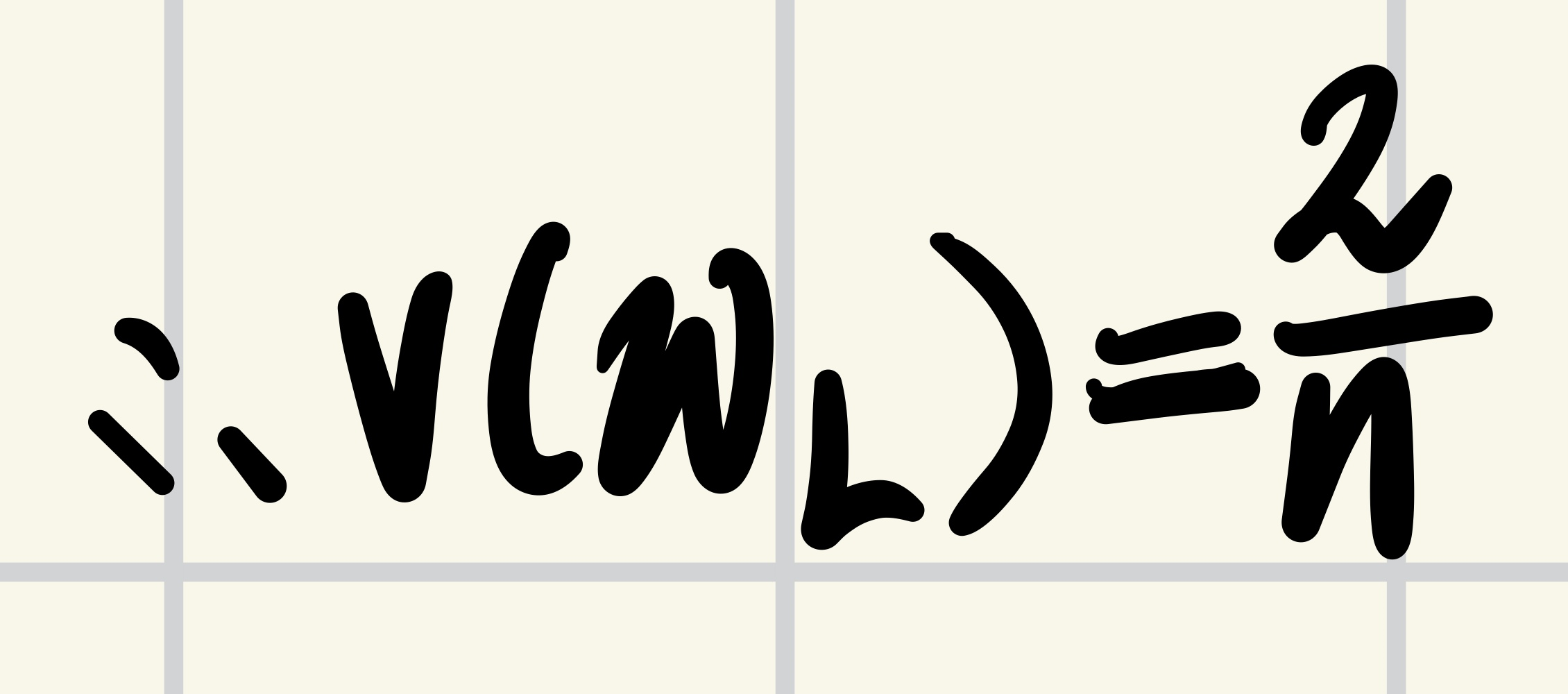

따라서 위 식에 근거하여 이 성립하기 위해서는 아래와 같이 이 된다.

그렇다면!🥁

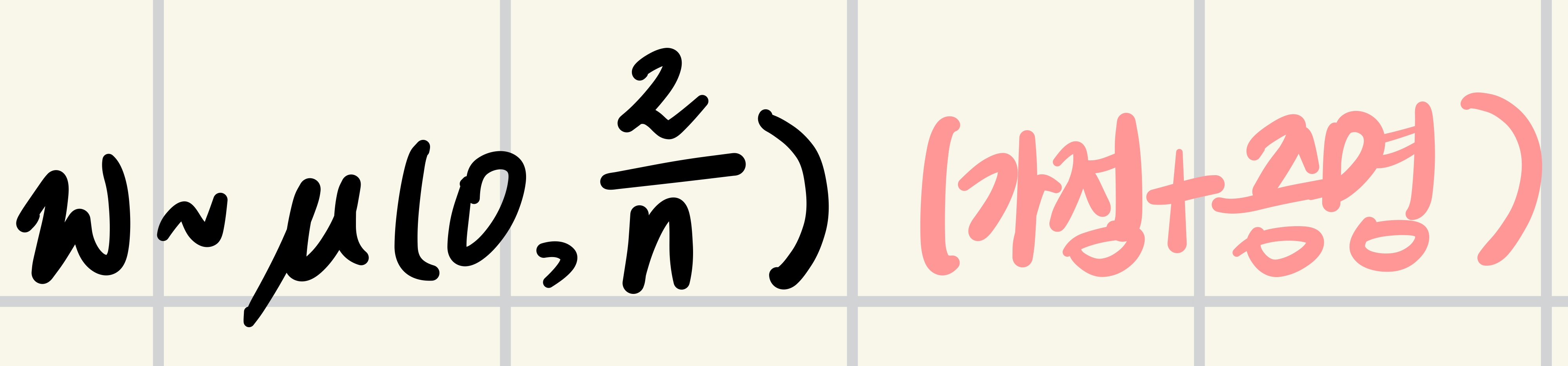

이와 같은 결론이 나오고, 초기 parameter는 아래와 같은 모수를 가질 수 있다.

논문에서는 실제로 ReLU에 Xavier Initialiazation와 He Initialization을 적용한 결과를 비교하고 있는데, 학습이 진행되더라도 He Initialization을 적용했을 때 더 빠르게 수렴하며, 모델의 깊이가 깊어졌을 때 Xavier Initialization으로 초기화한 Parameter들은 학습이 되지 않는 경우도 있다고 한다.