NLP

1.Sequence to Sequence Learning with Neural Networks

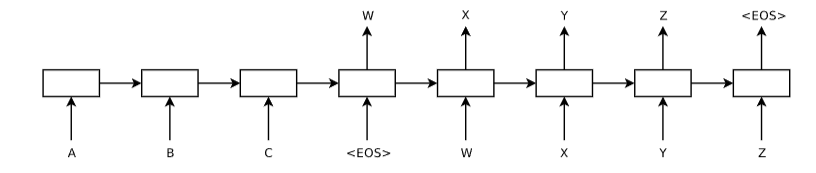

Sequence to Sequence Learning with Neural Networks Sequence to Sequence(Seq2Seq) Learning은 두개의 RNN을 사용하여 하나의 Sequence를 다른 Sequence로 변환하는 모델로 주로 기계 번역 Task에 적용되어 한 언어의 텍스트를 다른 언어로 번역하는데 사용된다. Abstract...

2.Show and Tell: A Neural Image Caption Generator

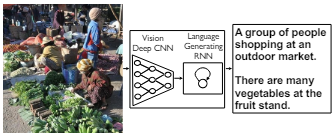

Show and Tell: A Neural Image Caption Generator 2015년 Google Brain 팀에서 발표한 논문으로 이미지 캡션 생성에 관한 연구이며 이미지에 대한 자연어 설명을 생성하는 모델을 제안한다. 이 논문에서는 이미지의 특징을 추출하는 CNN(Convolutional Neural Eetwork)과 문장을 생성하는 RN...

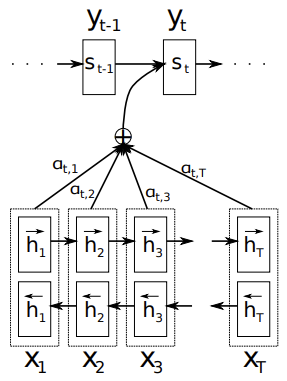

3.Neural Machine Translation by Jointly Learning to Align and Translate

서론 연구 배경 및 목적 기계 번역은 컴퓨터를 이용하여 한 언어의 텍스트를 다른 언어로 자동 변환하는 기술로 초기의 기계 번역 시스템은 주로 규칙 기반(Rule-Based) 접근법을 사용하였으며 이후 통계적 기계 번역(Statistical Machine Translation, SMT) 방식으로 발전하였다. SMT는 대규모 parallel corpus를 사용...

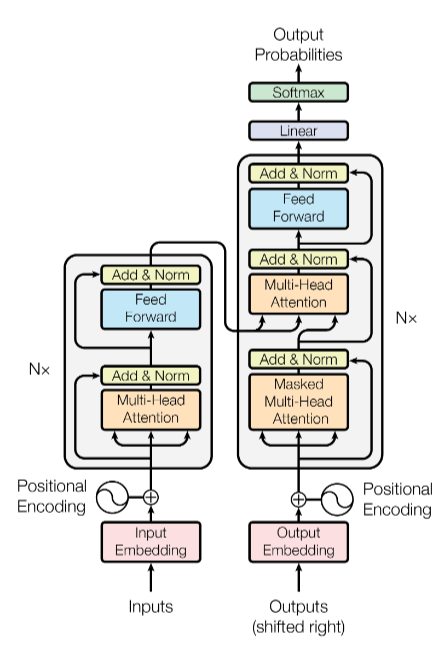

4.Attention is All You Need

Introduction 연구 배경 자연어 처리(Natural Language Processing, NLP)는 컴퓨터가 인간 언어를 이해하고 생성할 수 있도록 하는 인공지능의 한 분야로 특히 기계 번역, 텍스트 요약, 질문 응답 등 다양한 응용 분야에서 큰 성과를 보였다. 이러한 성과는 주로 Sequence-to-Sequence (Seq2Seq) 모델의 발전...

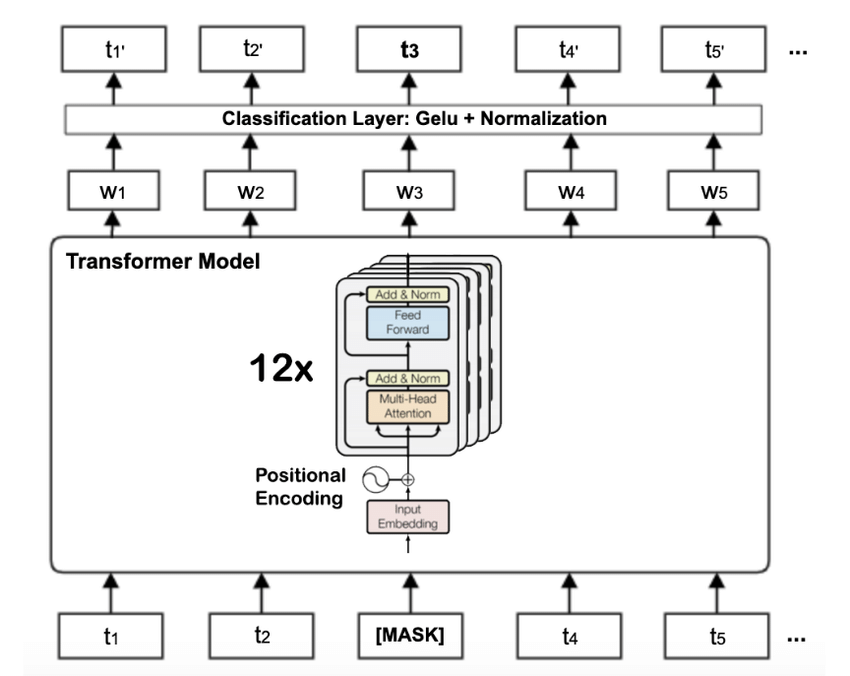

5.BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

Introduction 기존 NLP 모델들의 한계 기존의 NLP 모델들(RNN, LSTM, LSTM, GRU)은 주로 seq2seq 구조를 기반으로 설계되어 다음과 같은 한계점이 있다. 장기 의존성 문제 RNN과 같은 순차적 모델들은 입력 시퀀스의 길이가 길어질수록 초반 입력 정보가 뒤로 갈수록 희미해지는 문제 발생 따라서 문장 내에서 멀리 떨어진 단어들...