1. 딥러닝의 의미

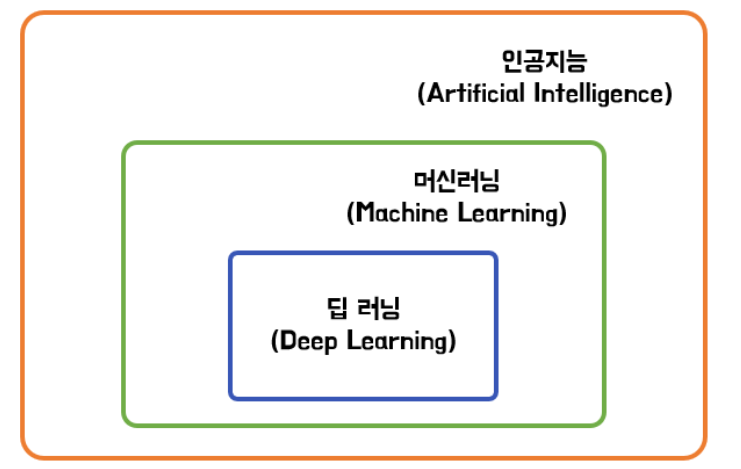

오늘날 인공지능이라고 불리는 기술은 대부분 머신러닝(Machine Learning)을 기반으로 이루어 진다. 또한 현재 머신러닝 중 가장 인기있는 분야는 딥러닝(Deep Learning)이다.

그림으로 살펴보면, 아래와 같은 포함관계이다.

- 인공지능 : 사람의 지능을 모방하는 기술

- 머신러닝 : 데이터를 통해 학습하는 인공지능

- 딥러닝 : 신경망을 활용하는 머신러닝

여기서 딥러닝은 일반적으로 신경망(Neural Network)을 활용하는 머신러닝이라고 표현된다.

Neural Network라는 표현은 인간의 뇌 구조에서 따온 명칭이다.

뇌는 뉴런으로 구성된 신경망으로 이루어진 조직이다. 인공지능을 구현하기 위해, 이런 인간의 뇌 구조를 참고하며 신경망이론(Neural Network)이 만들어졌다. 이 이론이 현 딥러닝의 기본이다.

하지만 현재의 딥러닝 이론은 발전과정에서 동물의 뇌 구조와는 꽤 멀어진 상태이다.

📁 이는 아주 자연스러운 현상이다.

유사한 변혁의 예를 살펴보면, 비행기를 생각할 수 있다. 비행기는 기본적으로 새의 비행을 모방하는 것에서 시작했다. 하지만 현대의 발전된 비행기를 생각해보면, 새와는 꽤나 다른 형태와 운영방식을 가지고 있다.

딥러닝도 이와 같이, 뇌 신경망을 모방하였지만 지금은 조금 다른 방향으로 발전을 계속하고 있다.

현재의 딥러닝은 '행렬 변형 후 비선형 변형'의 계산을 반복해서 쌓아서 함수로 근사하는 방식으로 정의할 수 있다.

딥러닝 방법을 구체적으로 알고 싶으면 아래 링크를 참고하자!

https://velog.io/@recoder/딥러닝-학습방법-기본-원리-신경망-이론

2. 딥러닝의 역사

최근 딥러닝은 4차 산업혁명의 핵심 기술로 불리고 있다.

하지만 딥러닝 기술이 처음부터 인공지능으로써 지금처럼 각광받았던 것은 아니다.

이 글에선 딥러닝이 현재와 같이 각종 분야에서 활용되기까지의 핵심적인 역사를 살펴보도록 하겠다.

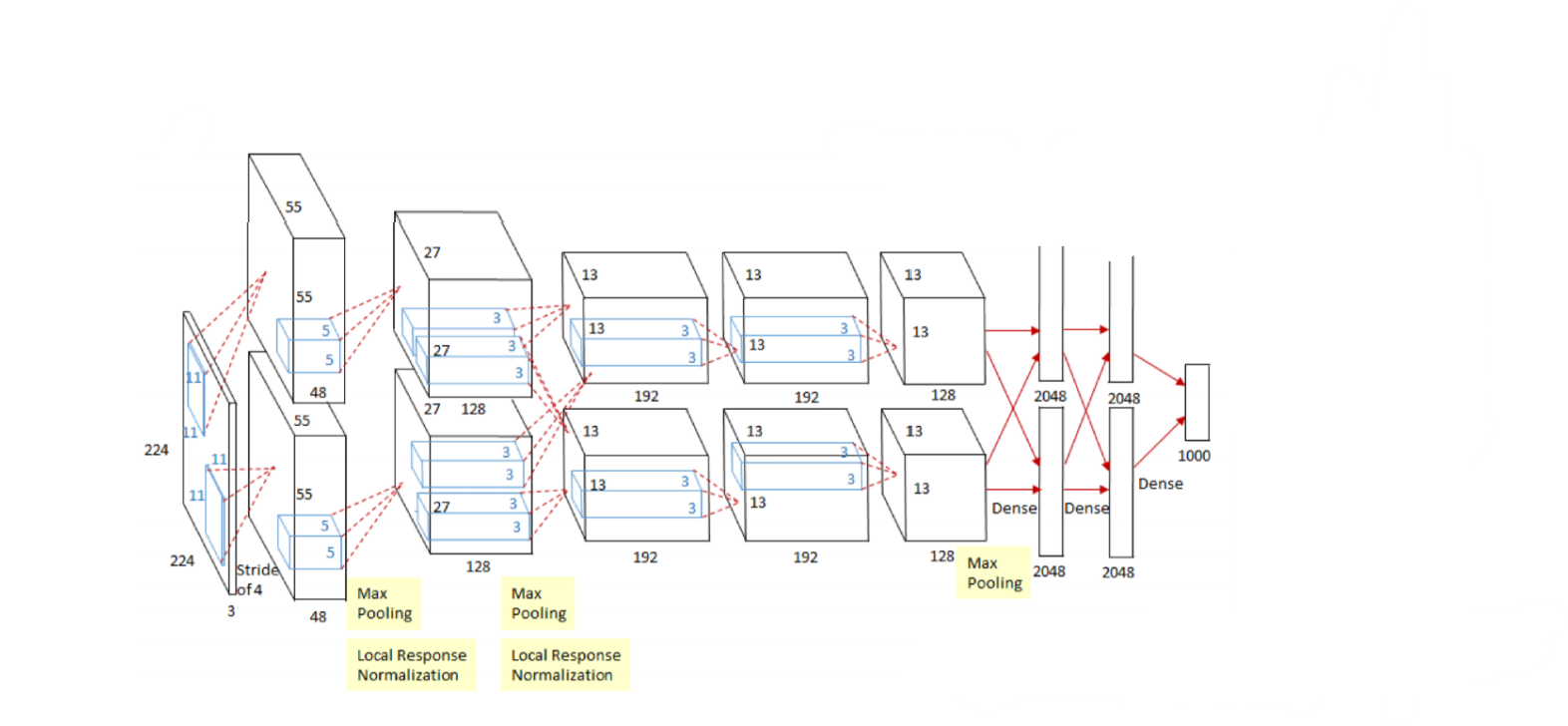

2012 - AlexNet

- convolution network(CNN)의 일종

- 224*224의 이미지를 분류

이 기술은 2012년 ILSVRC(ImageNet Large Scale Visual Recognition Challenge) 대회에서 우승하며 널리 알려지게 되었다.

이전까지 해당 대회에선 kernel 기반 Machine Learning, Support Vector Machine 등 전동적인 ML을 이용하였다.

그러던 중 AlexNet이 2012년 처음으로 DL을 이용해서 우승하게 되고, 이후론 모든 우승자가 DL 기술을 사용하게 되었다.

이 때가 딥러닝이 처음으로 성능이 발휘되고, 인공지능 분야 판도가 바뀌게 된 계기이다.

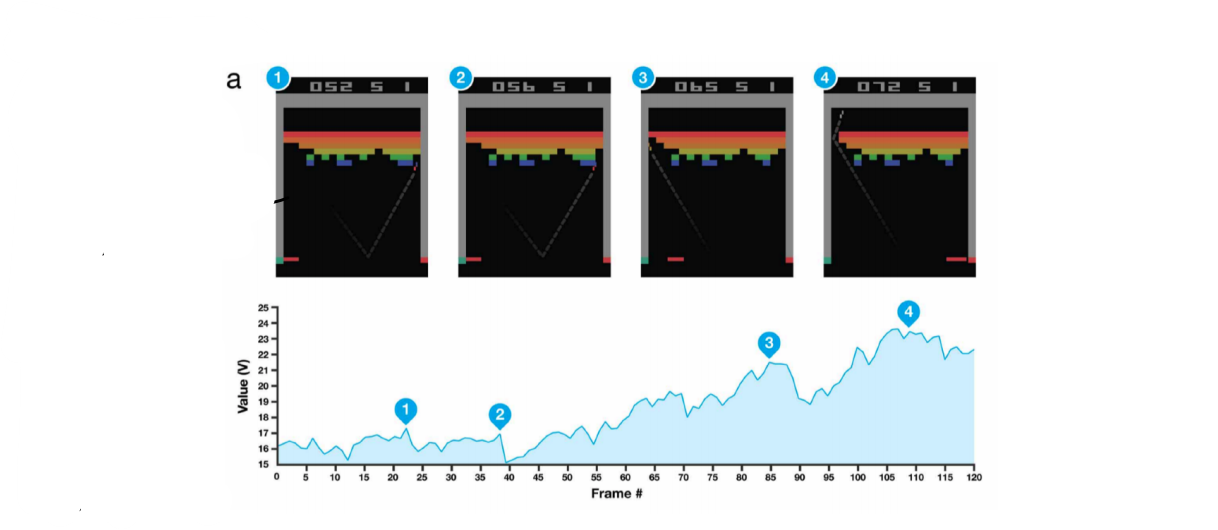

2013 - DQN

- 강화학습 중 하나인 Q-Learning을 딥러닝에 적용

오늘날의 구글 딥마인드가 있게 한 기술로, 잘 알려진 알파고, 알파폴드2 등에 사용된 기술이다. 본래 스타트업에서 계발한 기술이지만, 구글이 인수하여 널리 활용되고 있다.

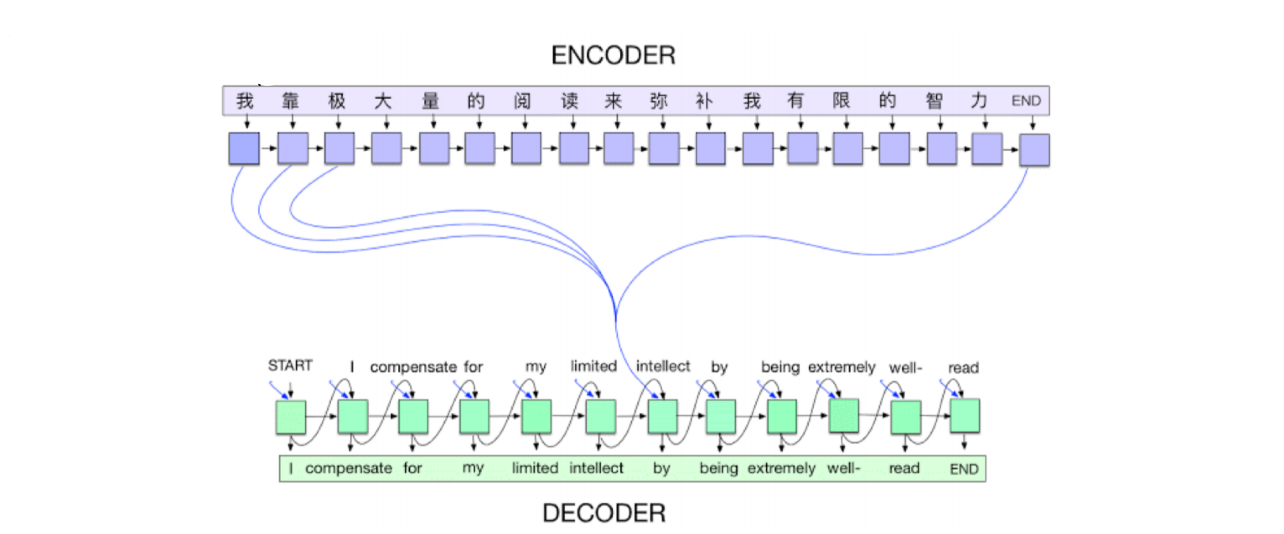

2014 - Encoder/Decoder

- NMT(Neural machine translation)를 풀기 위한 기술

- 문장(단어의 연속)을 벡터로 인코딩 한 후, 우리가 원하는 다른 언어의 문장(단어의 연속)으로 만드는 기술

구글 번역기 등 번역 분야에서 일반적으로 활용하는 기술이다. 이 기술 이후로 기계어 번역의 트렌드가 크게 바뀌었다.

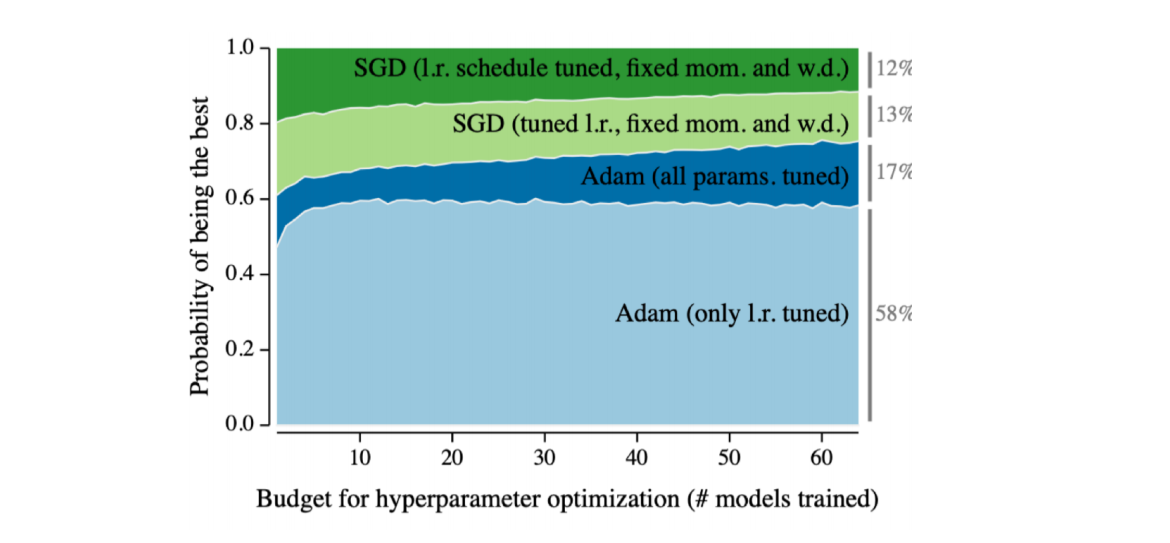

2014 - Adam Optimizer

- Adam : Adaptive Moment Estimation

아담은 위 그래프에서 볼 수 있 듯, 일반적으로 가장 좋은 성능을 가진다. 따라서 별다른 이유가 없으면 대부분의 경우 사용하는 Optimizer이다.

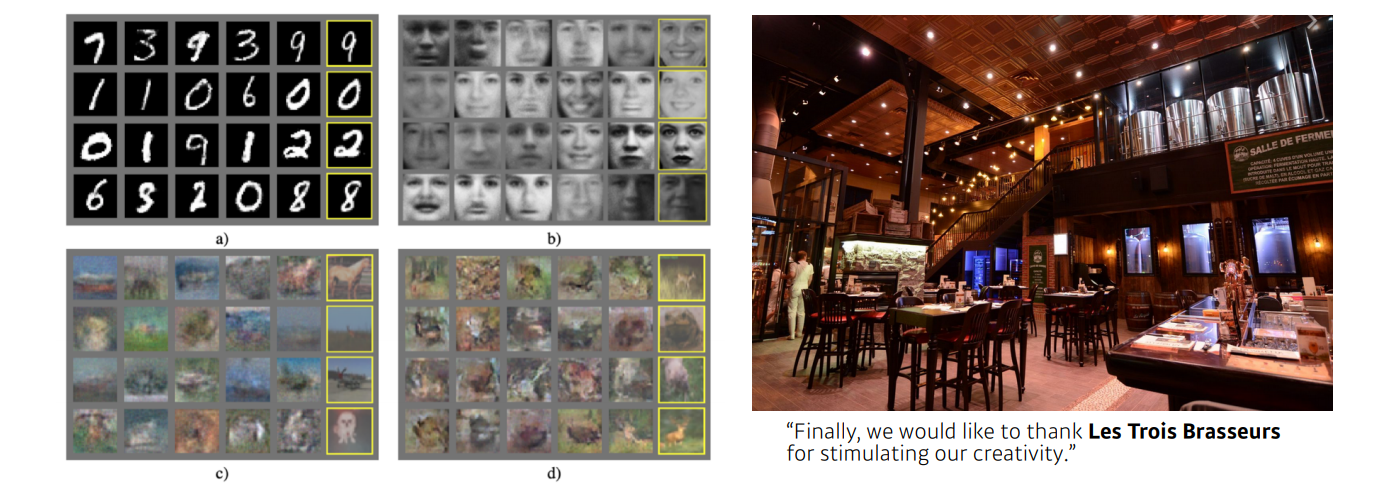

2015 - Generative Adersarial Network

- 이미지, 텍스트 등을 생성할 때 사용

- network가 generator, distributor 2개를 만들어 학습

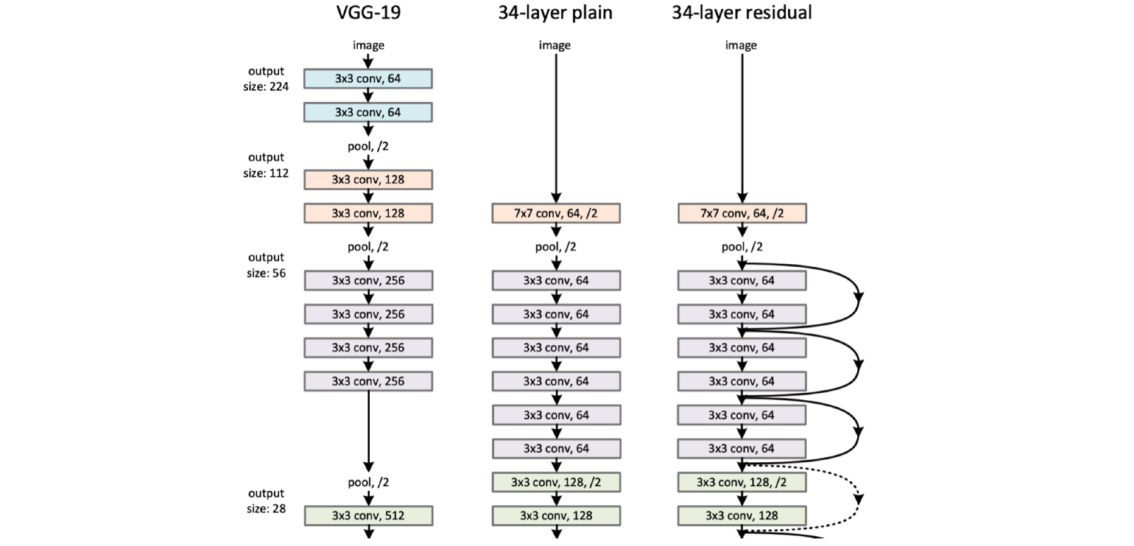

2015 - Residual Networks

- 네트워크를 깊게 쌓을 수 있게 만듦

"딥러닝"이라는 이름이 사용될 수 있는 이유라고 볼 수 있는 기술이다. Neural Network 기술을 Deep Learning이라고 부르는 이유는 일반적으로 네트워크를 깊게 쌓기 때문이다.

이 기술 이전까지는 네트워크를 대략 20개 이상 깊게 쌓을 수 없었다. 너무 깊게 쌓을 경우 성능이 좋지 않았기 때문이다.

하지만 Residual Network의 등장으로 100단 가량 쌓을 수 있게 되었다.

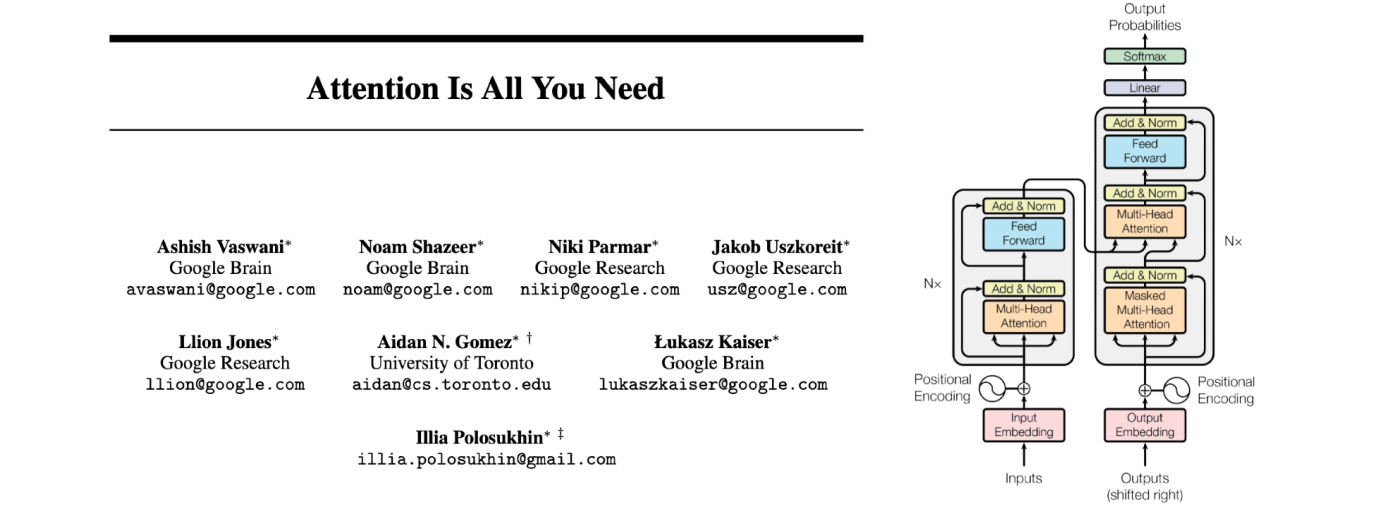

2017 - Transformer

- "Attention Is All You Need"라는 논문 내용

이 논문 이후, 현재는 대부분의 RNN 기술을 대체하였다. 또한 최근엔 CV 분야에도 사용되는 추세이다.

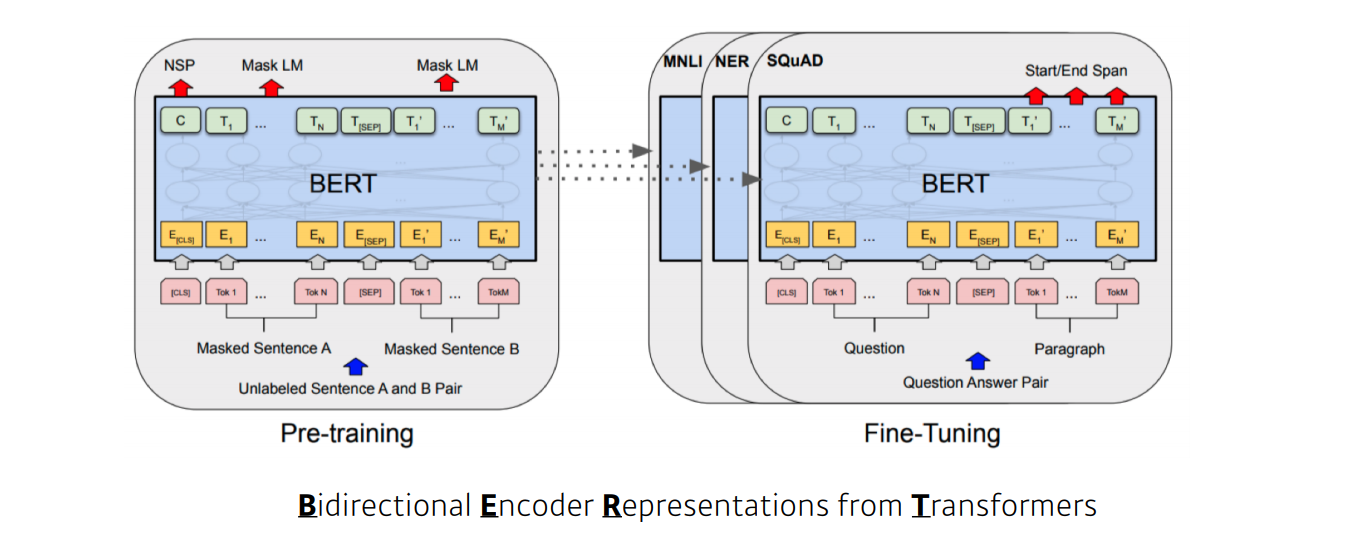

2018 - BERT (fine-tuned NLP models)

- 구글의 NLP 사전 훈련 모델

- 일반적인 대규모 언어 데이터로 pre-train 해두고, 필요한 목적에 따라 세부 조정(fine-tuning)해서 활용

2019 - Big Language Models

- bert와 같은 사전 훈련 모델

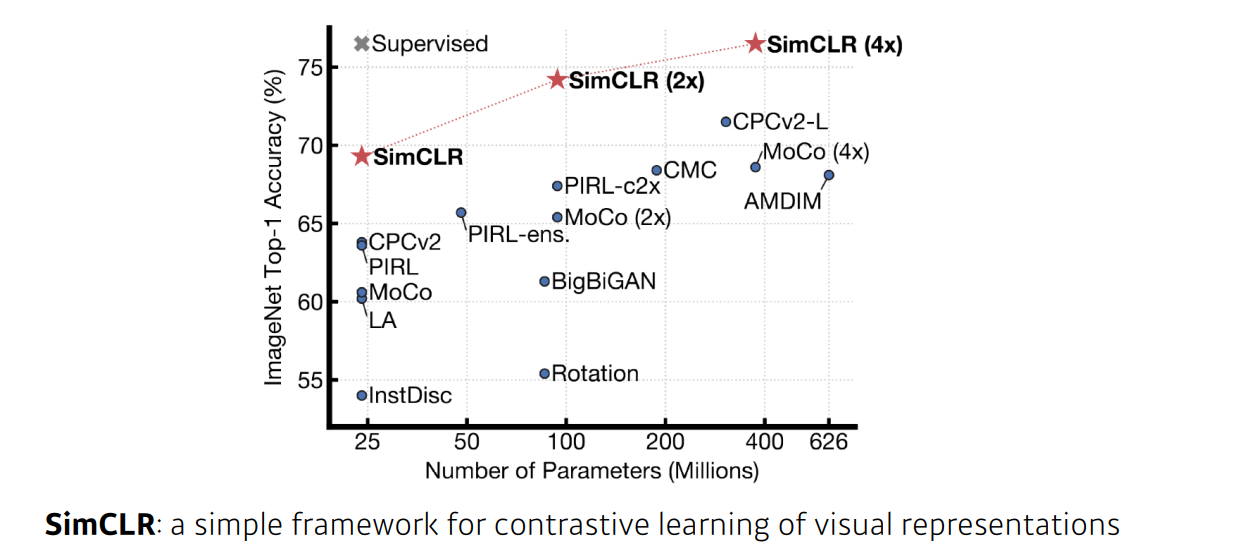

2020 - Self Supervised Learning

- 분류문제에서 지도학습 + 비지도 학습

- 라벨링 되어있는 이미지를 모델링 하기 위해, 라벨링되지 않은 이미지도 함께 활용

- 최근에는 도메인 지식 등을 통해 학습 데이터를 추가로 만들어 내서 학습에 활용하기도 한다.

최근 관련 연구가 굉장히 많이 이루어지고 있다.