Paddin은 콘볼루션 신경망을 통과하면서 기능 맵 크기를 조작하는 놈

패딩 그대로 겨울철에 입는 그걸로 생각해도 될 것 같다.

찬바람에 대신 상처 입어줌

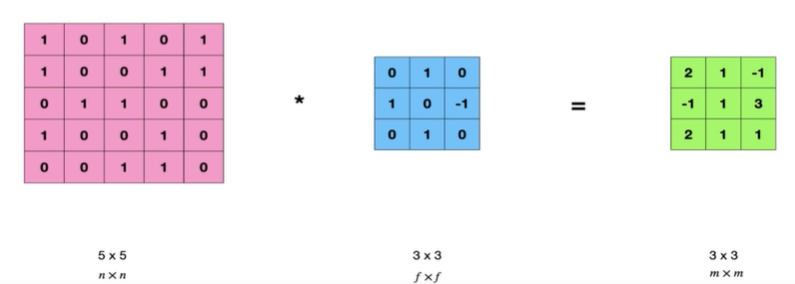

위 사진도 그렇고, 앞서 봤던 내용들도 그렇고 입력보다 출력이 무조건 작은데 이 사실을 알 수 있다.

저번시간 복습으로 5-3+1 = 3 으로 기능맵의 크기도 계산할수 있다.

기능맵의 크기를 계산할 줄안다 = 재료비를 적당히 준비할수있다.

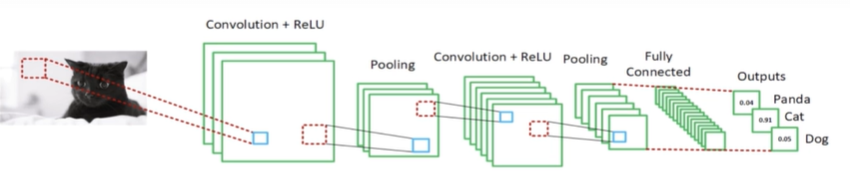

CNN(컨볼루션 신경망)을 생각해보면 사슬처럼 연속으로 응축(입력보다 출력이 작음)이 일어난다.

일어날수밖에 없는 일이지만, 이렇게 출력이 작아지는것은 결과에 좋지않다.

그때 사용하는게 padding

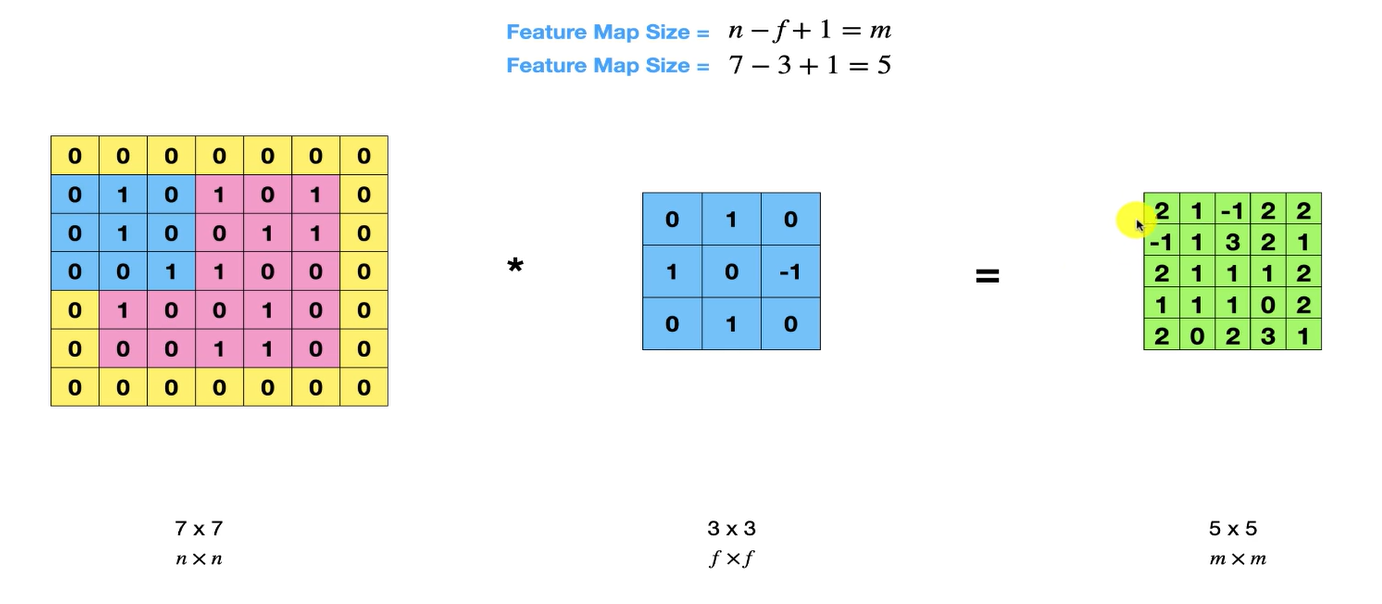

input image 겉에 0을 추가하니 5x5의 이미지가 7x7이 됐다.

공식을 이용해서 기능맵,output의 크기를 계산해보면 7-3+1 = 5가 나오고 연산 결과도 5x5로 맞다.

이렇게 padding을 이용해 이미지의 크기를 보존하는 것이다.

padding 어째서 씀?

-

복잡한 데이터셋을 위한 심층적인 네트워크의 크기를 계속 줄이지 않기 위해

-

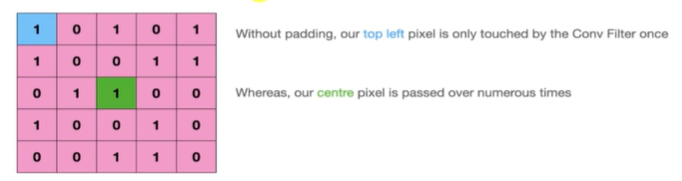

가장자리의 픽셀은 출력 피쳐맵에 덜 기여하므로 해당 픽셀에서 정보를 삭제

"패딩이 없으면 상단 왼쪽 픽셀이 컨브 필터에 한 번만 닿습니다"

"반면에, 우리의 중심 픽셀은 수 차례에 걸쳐 통과된다"

근데 padding 을 했을 경우에는 가장자리, 에지 픽셀에 자주 접촉하기 때문에 뉴럴네트워크가 좀 더 균형 잡힌 정보를 습득할 수 있다.