앙상블 기법

- Voging,Bagging,Boosting,

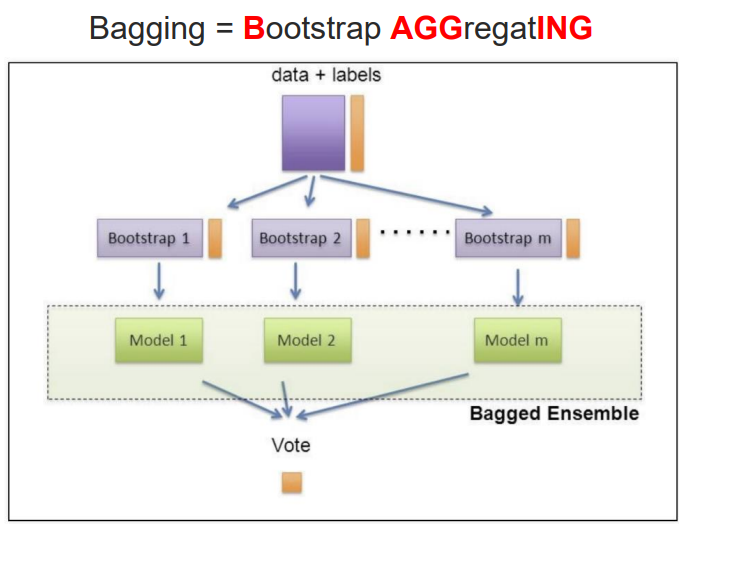

- voting과 bagging은 여러개의 분류기가 투표를 통해 최종 예측 결과를 결정하는 방식

- 보팅과 배깅의 차이점은 보팅은 각각 다른 분류기, 배깅은 같은 분류기를 사용

- 대표적인 배깅 방식이 랜덤 포레스트

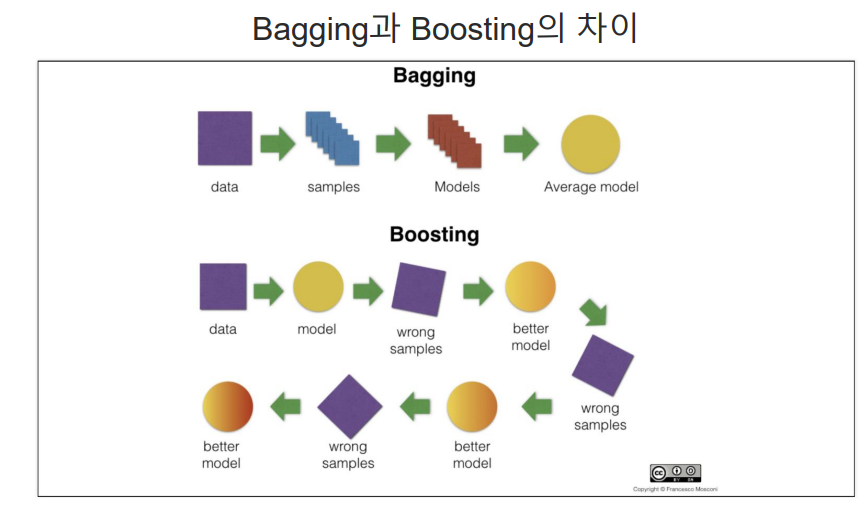

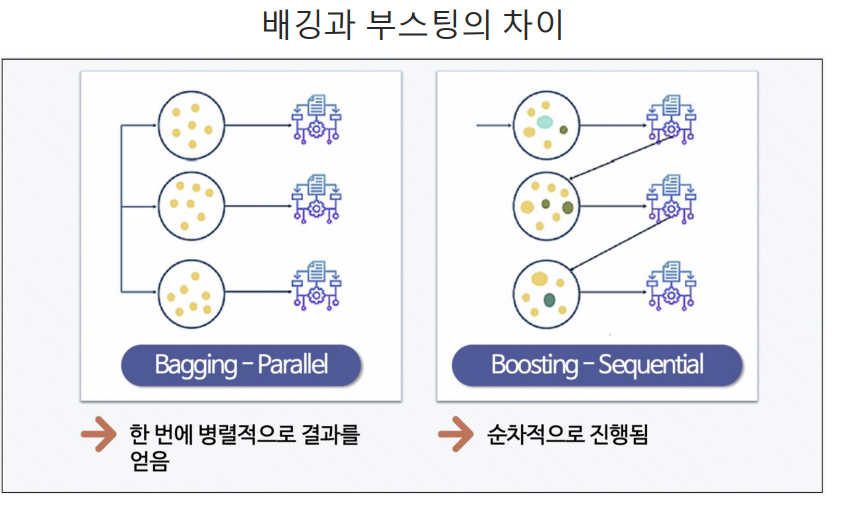

- 배킹과 부스팅의 차이

차이점

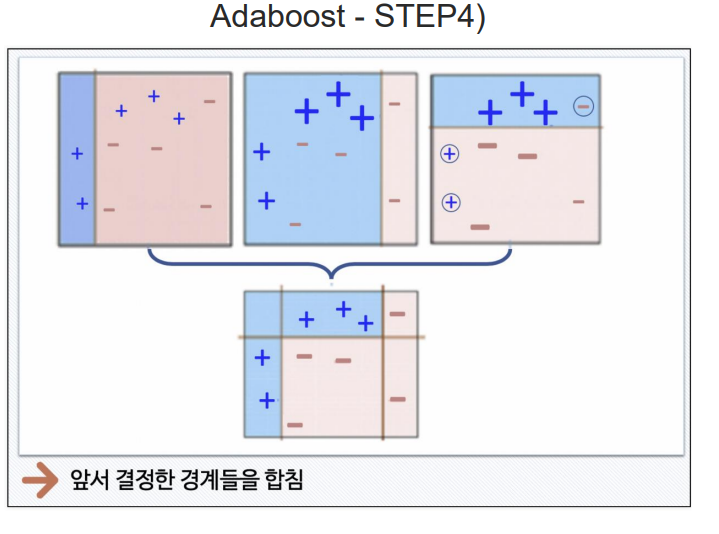

1. 배깅은 병렬적으로 모델을 학습하고 예측을 결합하는 반면, 부스팅은 순차적으로 모델을 학습하고 이전 모델의 오차를 보완

2. 배깅은 각 모델이 독립적으로 학습하므로 모델 간에 상호 작용이 없다.

부스팅은 모델 간 상호 작용을 고려하여 앙상블을 구축한다.

3. 배깅은 과적합을 줄이고 모델 간의 분산을 감소시키는 데 도움이 되며, 안정적인 예측을 제공한다. 부스팅은 훈련 데이터에 더 잘 맞게 되며 높은 성능을 제공하지만

과적합에 민감하다.

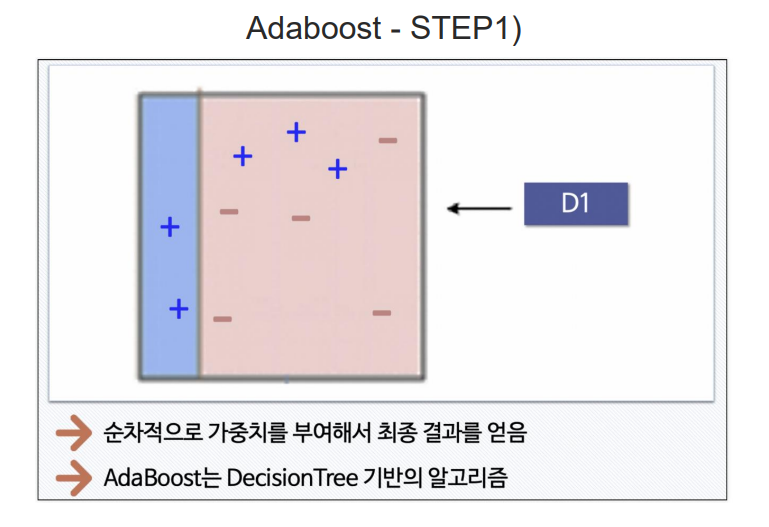

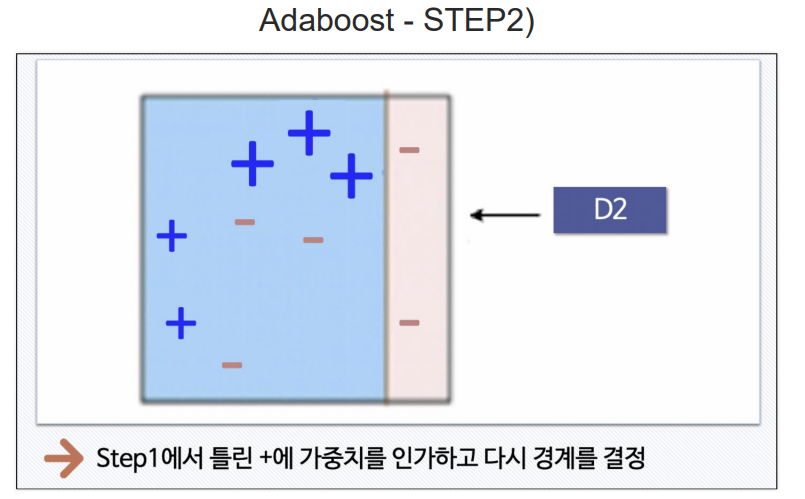

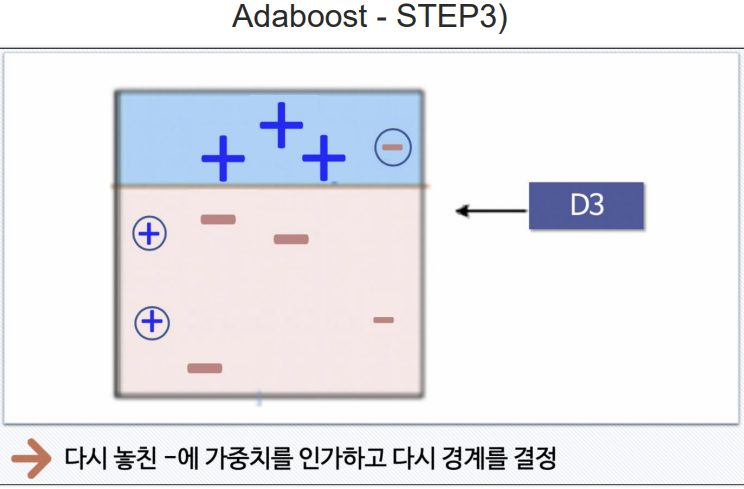

AdaBoost(adaptive Boosting)

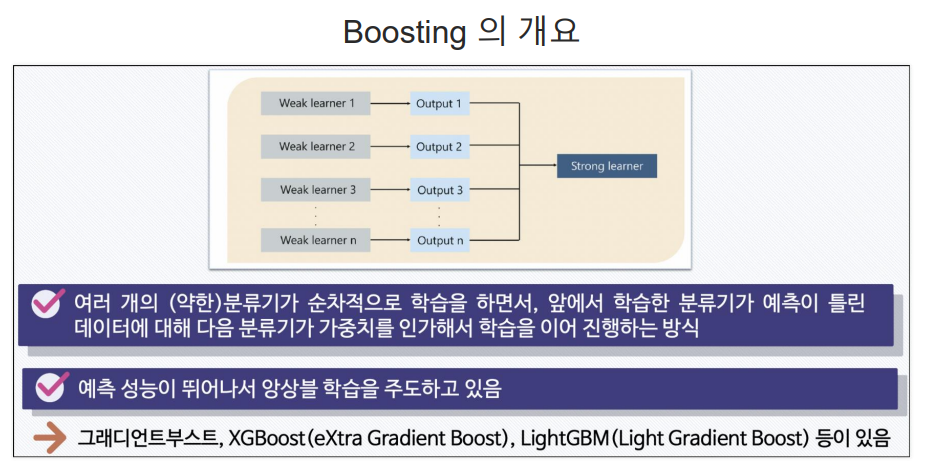

에이다부스트: 약한 학습기(weak learner)를 결합하여 강한 학습기(strong learner)를 구축하는 방법 중 하나이다.

- 에이다 부스트는 이전 모델들이 놓친 샘플에 더욱 집중하여 오분류율을 줄이는 방식으로 동작한다. 매우 강력한 앙상블 모델을 만들어내며, 과적합에도 비교적 강한 성능을 가질 수 있다. adaboost는 분류 문제에서 주로 사용되며, 의사 결정 트리,SVM,나이브 베이즈 등 다양한 약한 학습기와 함께 사용

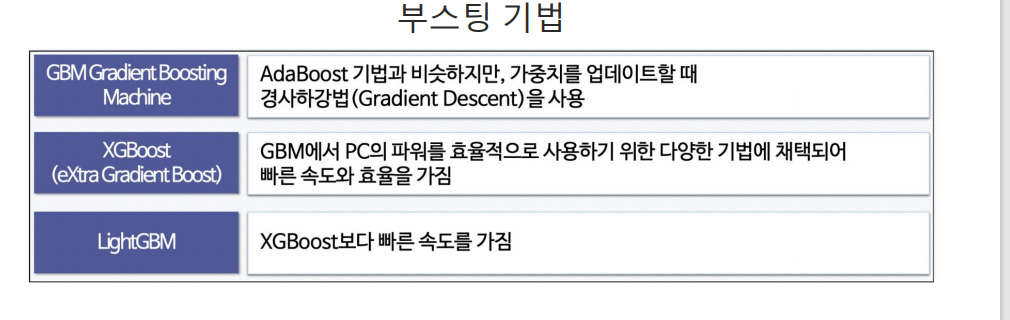

부스팅 기법

Boost

1. GBM(Gradient Boosting Machine)

- GBM은 부스팅 알고리즘 중 가장 기보존적인 형태로 예측 오차를 최소화하기 위해 경사 하강법(Gradient Descent)을 사용한다.

- 이전 모델에서 발생한 오차를 보안화는 새로운 모델을 학습하는 과정을 반복하여

모델을 구축한다.- GBM은 과적합에 민감하며 모델 파라미터 튜닝이 중요하다.

- XGBoost(Extreme Gradient Boosting)

- GBM의 확장된 버전으로, 더욱 효율적인 알고리즘과 정규화 기능 제공

- 자동으로 결측값 처리, 카테고리 변수 처리, 조기 중단 기능 등을 제공하여 모델의 성능을 향상

- LightGBM(Light Gradient Boosting Machine):

- GBM의 경량화된 버전으로, 빠른 학습 속도와 효율적인 메모리 사용 제공

- Leaf-wise Growth 알고리즘과 최대 손실(Gradient)기반 스플릿 방식을 사용하여 빠르게 모델을 학습할 수 있다.

- LightGBM은 대규모 데이터셋에서도 빠르게 처리할 수 있으며, 카테고리 변수를 처리하는 데 용이하다.

Bagging