Transfer Learning을 RL을 보다 우연히 발견했는데 처음에는 progressive learning을 조사하려다 국내에서 DEN이라는 굉장히 놀라운 논문이 있다고 해서 궁금함에 조사하게 되었다.

Abstract

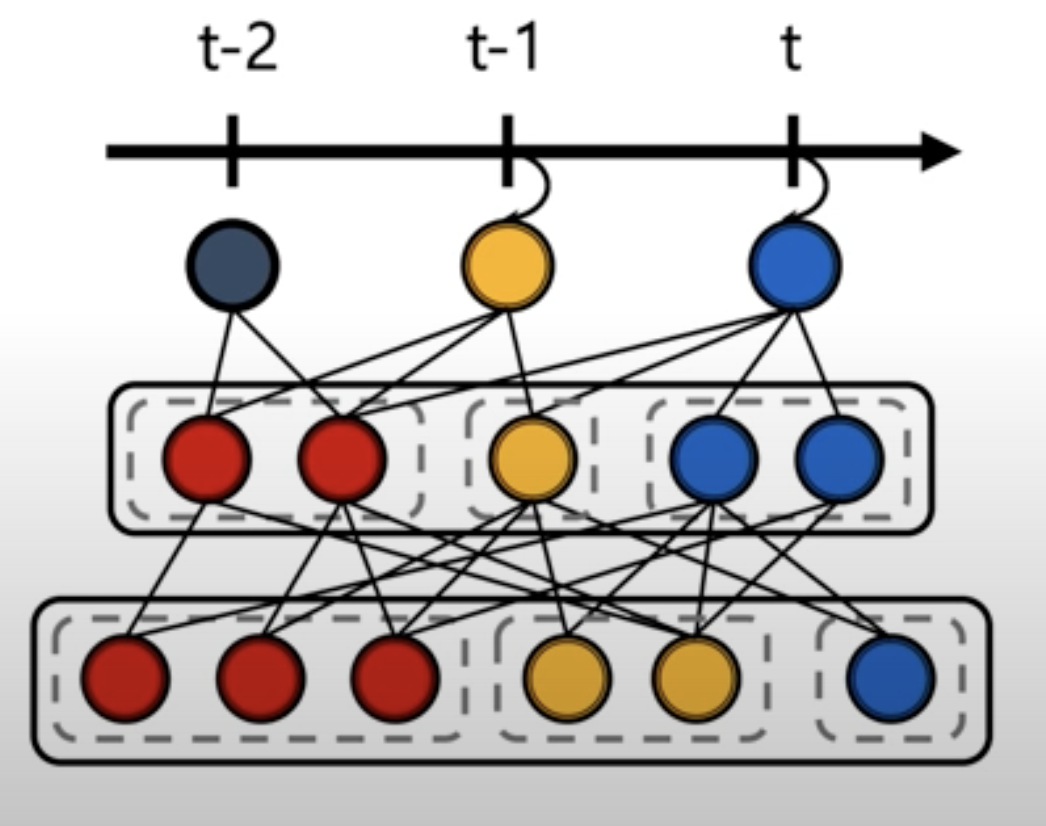

이 논문은 LIFELONG LEARNING을 위한 Dynamically Expandable Network(DEN)을 제안한다.

위 Network는 training에 있어 Capacity를 Dynamically하게 결정하여 Compact한 overlapping된 지식을 공유하는 모델이다.

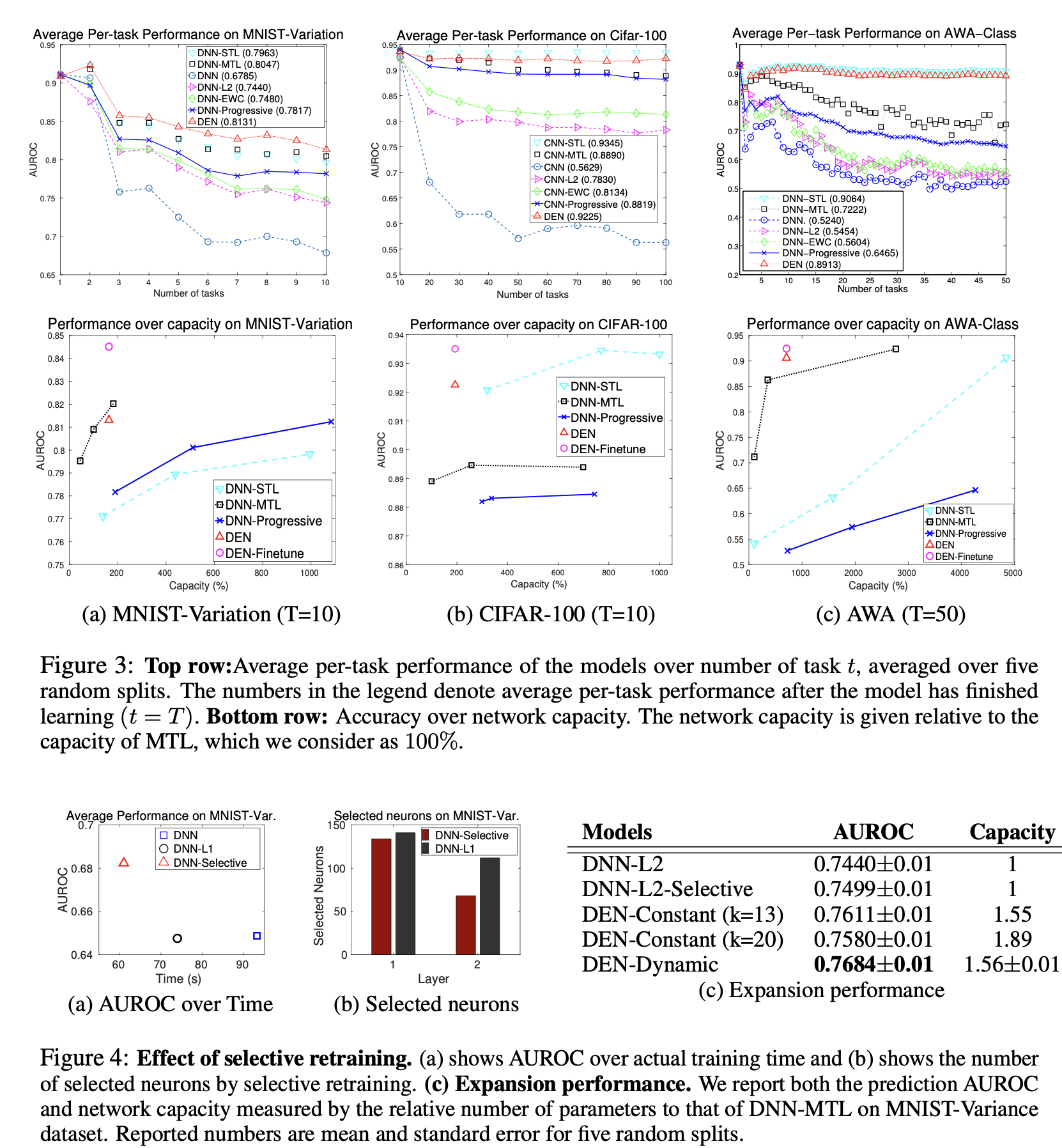

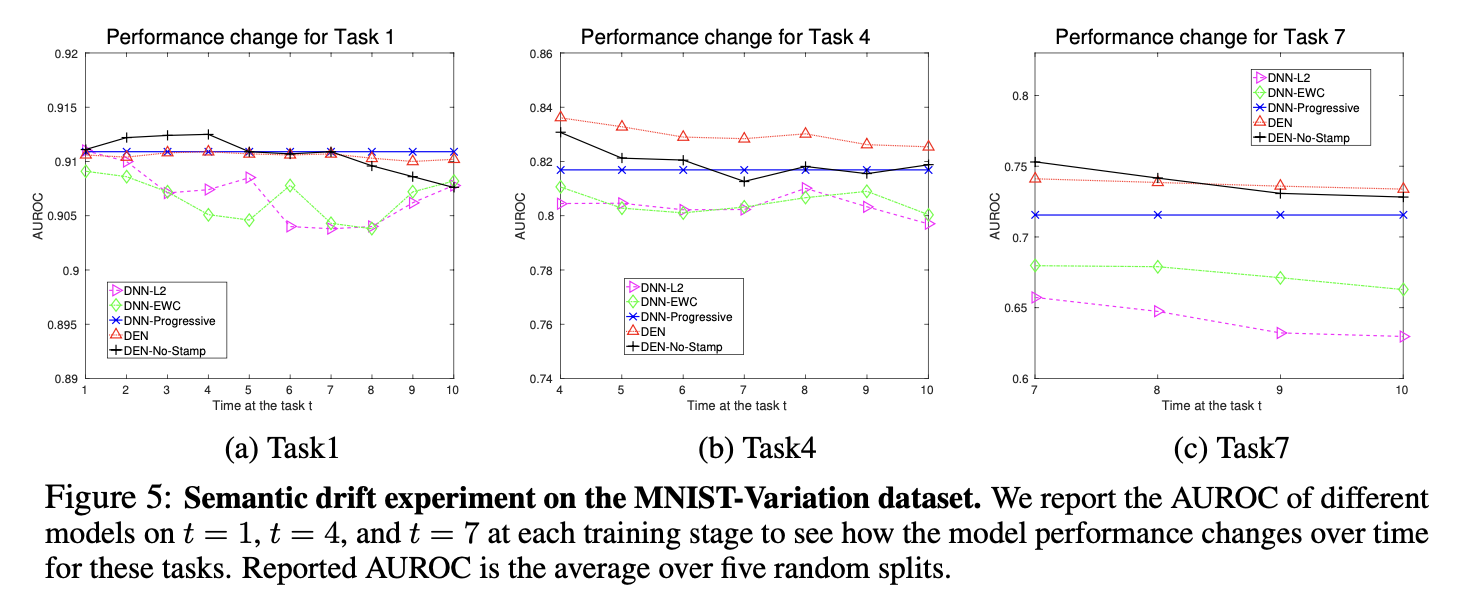

선택적 retraining하여 online 방식으로 효율적으로 학습하고 필요한 Neuron을 dynamically하게 Expend하며 splitting/duplicating하고 timestamping 으로 sementic drift 문제를 방지한다.

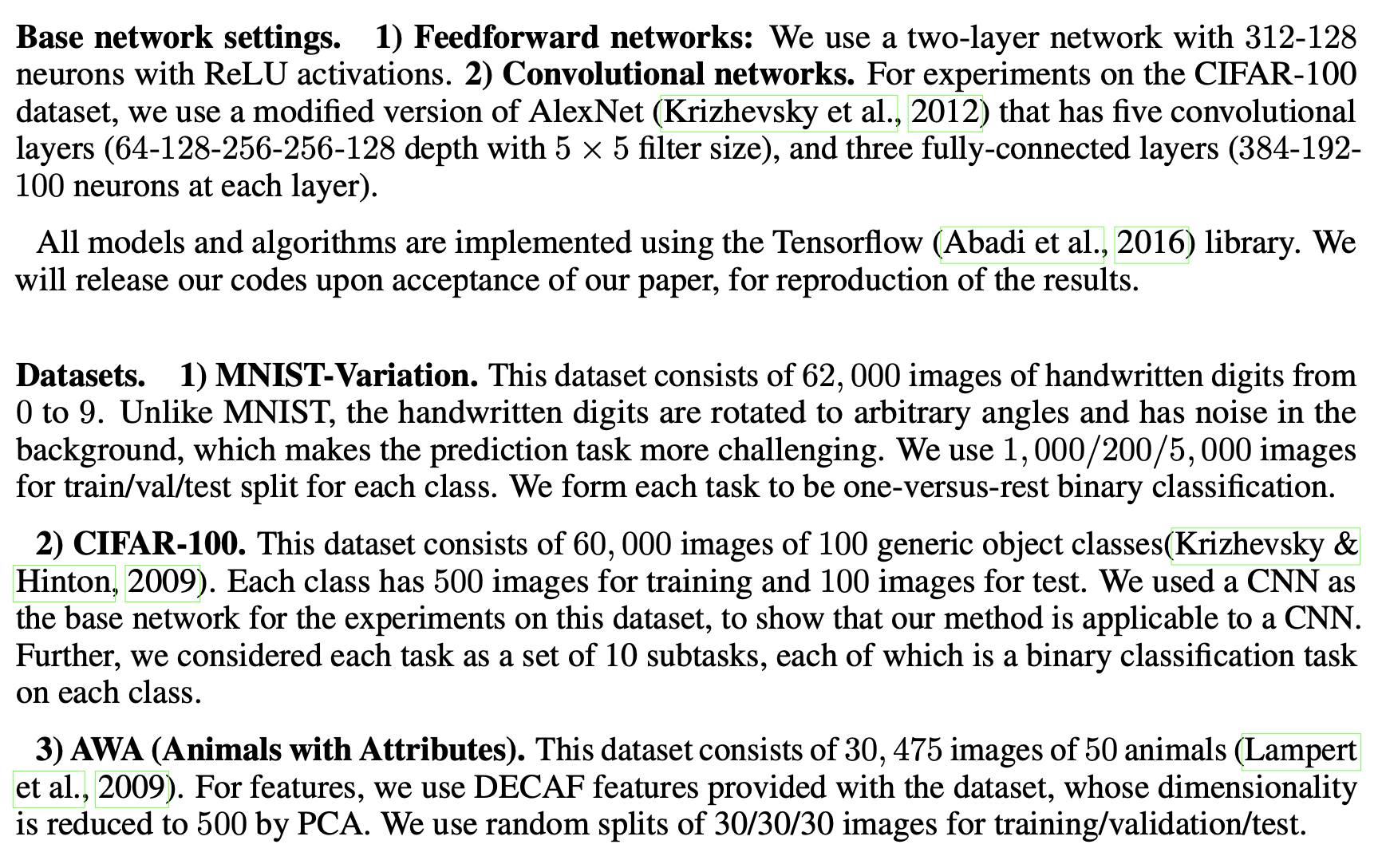

위 모델을 가지고 여러 Experiments에서 검증하였고 기존 LifeLong Learning을 훨씬 능가하며 훨씬 적은 Capacity로 다른 Batch상태의 NN와 비슷하거나 이상의 성능을 낸다.

또한 위 모델을 Finetuning한 모델은 Batch모델보다 더 나은 성능을 보이며 최적의 네트워크를 추정할 수 있음을 보여준다.

INTRODUCTION

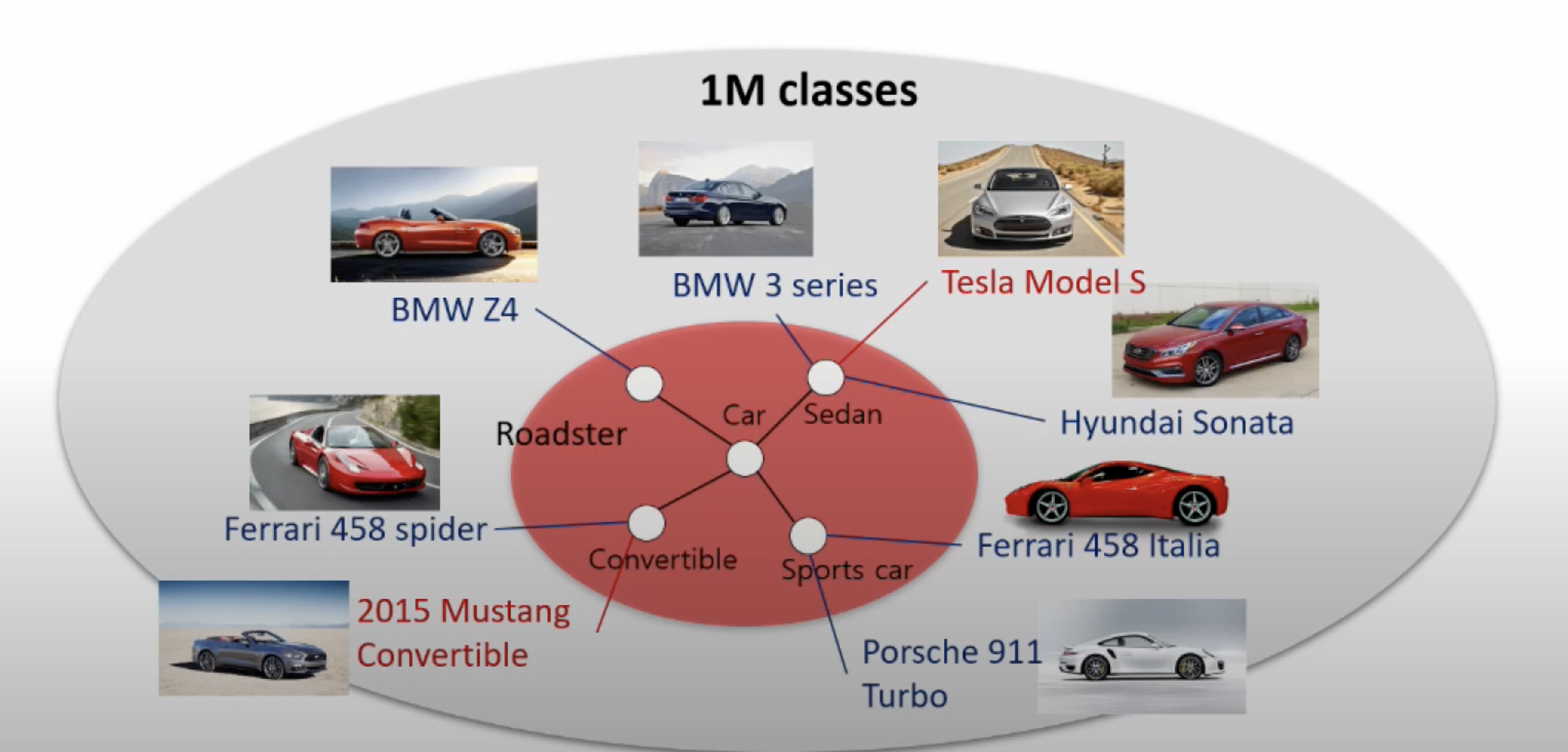

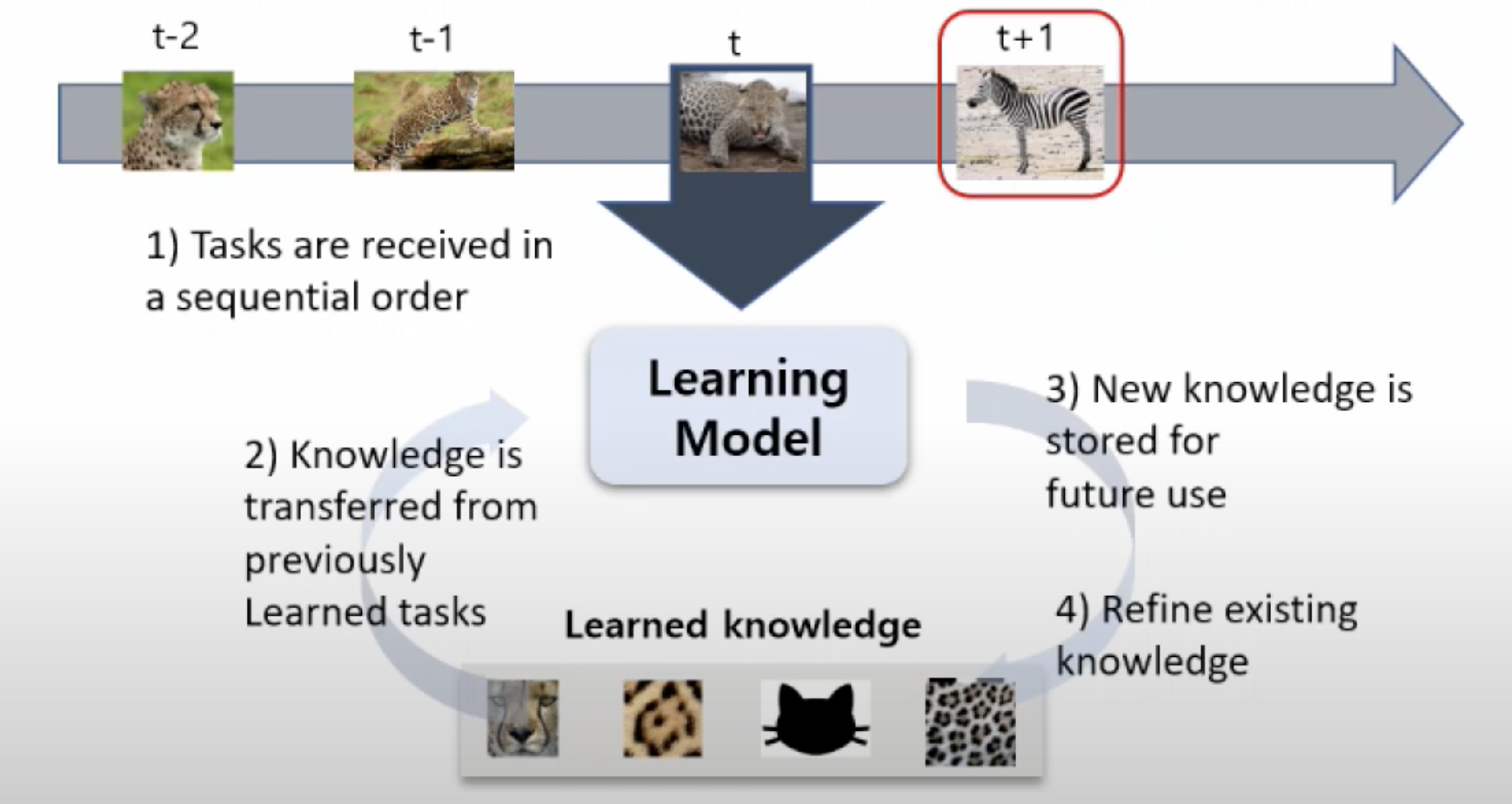

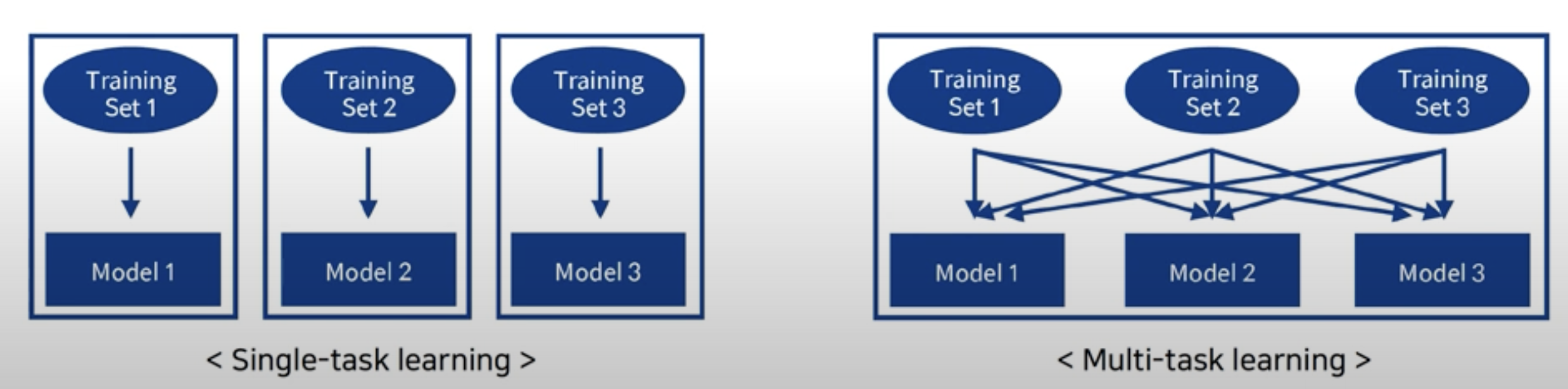

LifeLong Learning(the problem of continual learning where tasks arrive in sequence)은 Transfer learning의 중요한 주제이다.

lifelong learning의 주요 목적은 이전 지식을 활용해 더 나은 성능을 얻거나 이후 작업을 위해 모델에 대한 더 빠른 convergence/training speed 를 얻는 것이다.

위 모델은 DNN을 활용하기 위해 DNN 아래에 LifeLong Learning을 고려한다.

DNN은 가중치를 통해 지식을 저장하고 전달하는데 이 학습된 가중치는 기존 작업에 대한 지식이 될 수도 있고 새로운 작업은 이를 공유하여 활용할 수 있다.

그래서 LifeLong Learning은 online or incremental learning의 special case 라고 할 수 있다.

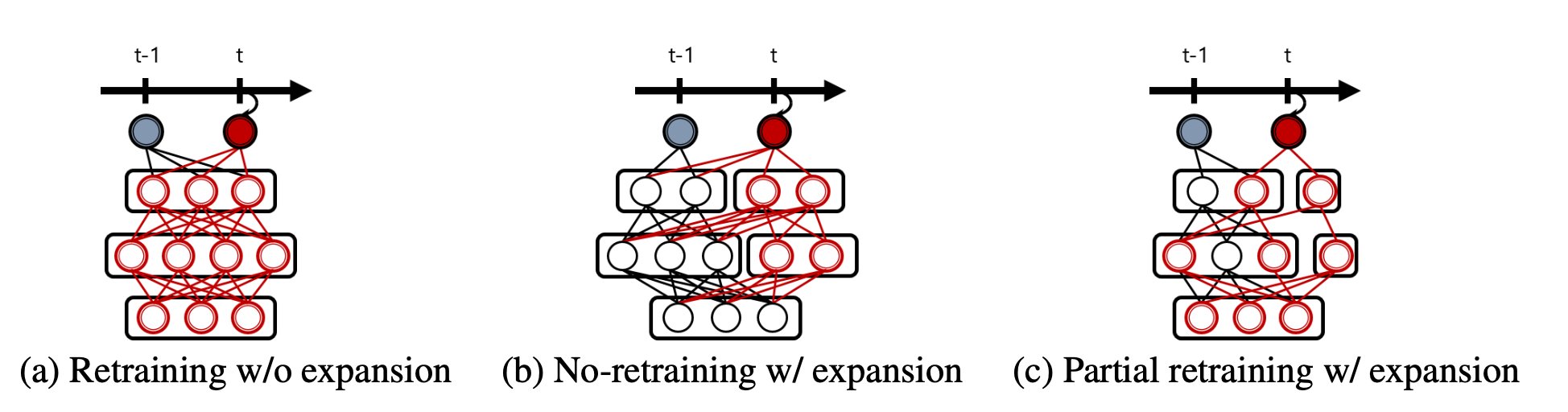

Incremental learning을 학습시키는 방법은 여러가지가 있는데 가장 간단한 방법은 새로운 훈련 데이터로 네트워크를 계속 훈련시켜 네트워크를 점진적으로 Finetuning 하는 방법이다. 하지만 이 방법은 새로운 task나 이전 task 모두 성능을 저하시킬 수 있다.

그렇기 때문에 최근 연구는 다음과 같다.

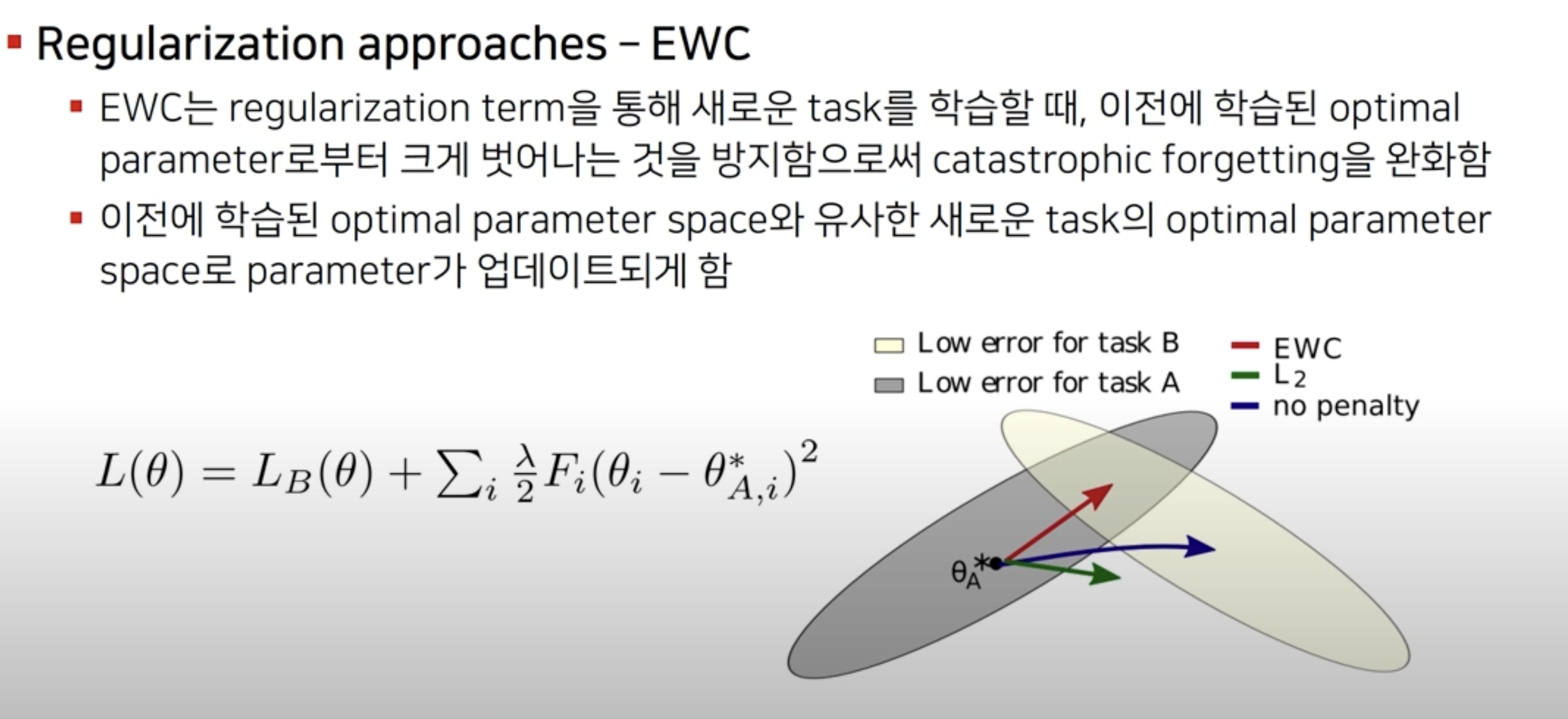

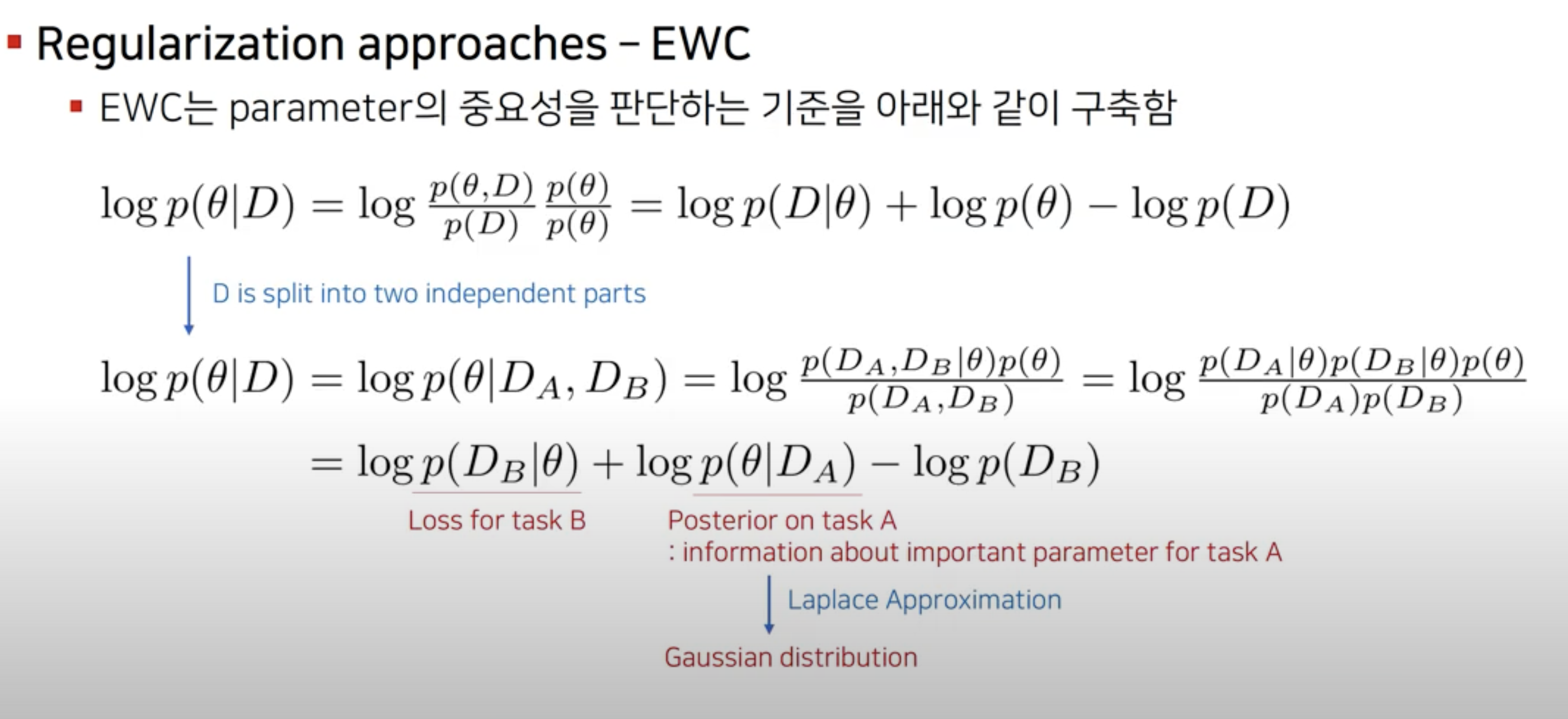

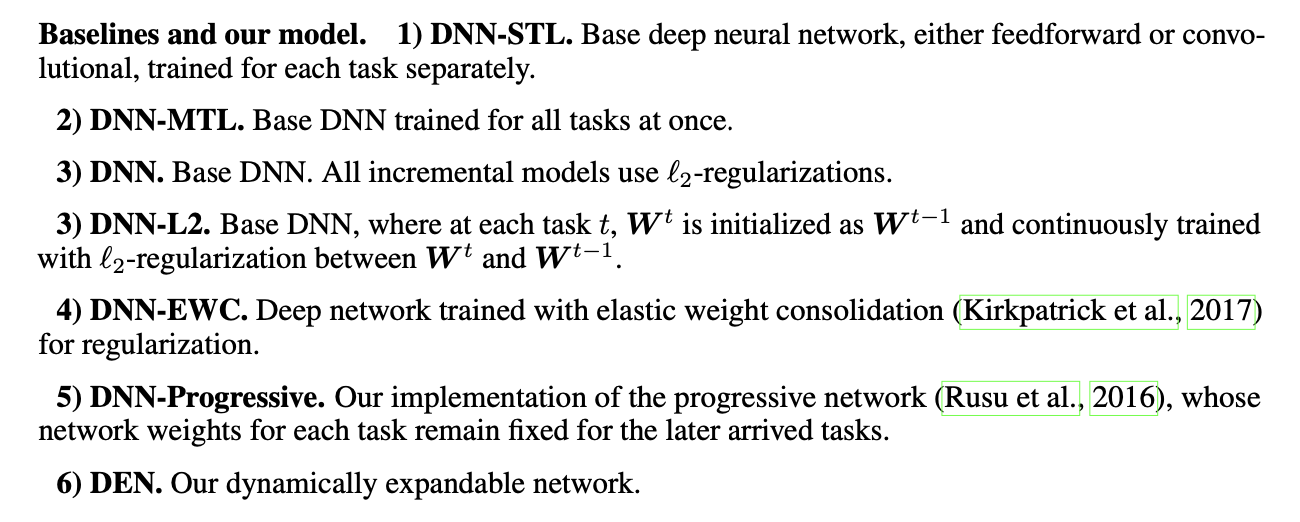

a) EWC(Elastic Weight Consoliation)을 활용한 Retraining 방법.

b) Non-retraining models such as Progressive Network

c) partial retraining and expansion/ DEN

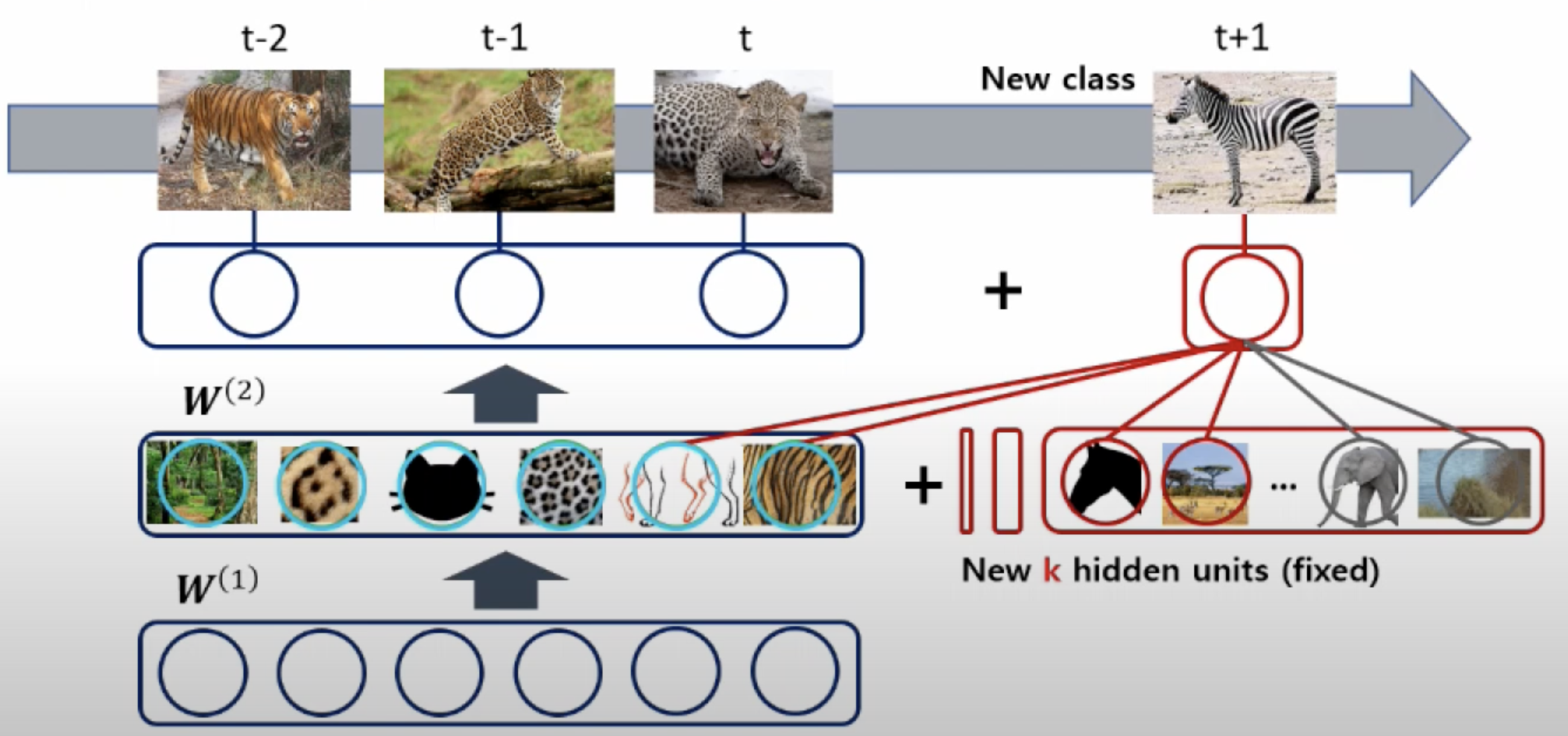

DEN은 관련 가중치 노드를 sparse하게 retraining 하며 필요에 따라 새로운 노드를 expand하여 최적의 capacity를 갖는 모델이다.

Challenge of Incremental deep learning setting with selective parameter sharing and dynamic layer expansion.

1) Achieving scalability and efficiency in training

Network Capacity가 증가하면 이후 작업은 더 큰 Network로 인한 많은 비용 문제 발생.

2) Deciding when to expand the network, and how many neurons to add

이전 Network가 New Task를 충분히 해결할 수 있으면 expanding이 필요 없지만 아닌 경우는 필요함. 선택적으로 확장 가능해야함

3) Preventing semantic drift, or catastrophic forgetting

이는 성능저하로 이어지는 문제들이기 때문에 반드시 해결 필요하며 관련 mechanism이 필요.

이를 위해 DEN(Dynamically Expandable Networks)을 제안.

RELATED WORK

Preventing catastrophic forgetting

catastrophic forgetting 문제를 해결하기 위해 l2-regularizer사용.

-> 새 모델이 이전 모델을 너무 벗어나지 않도록 방지.

하지만 새로운 모델을 위한 새 지식을 제대로 학습하지 않으면 최적의 성능을 얻을 수 없음.

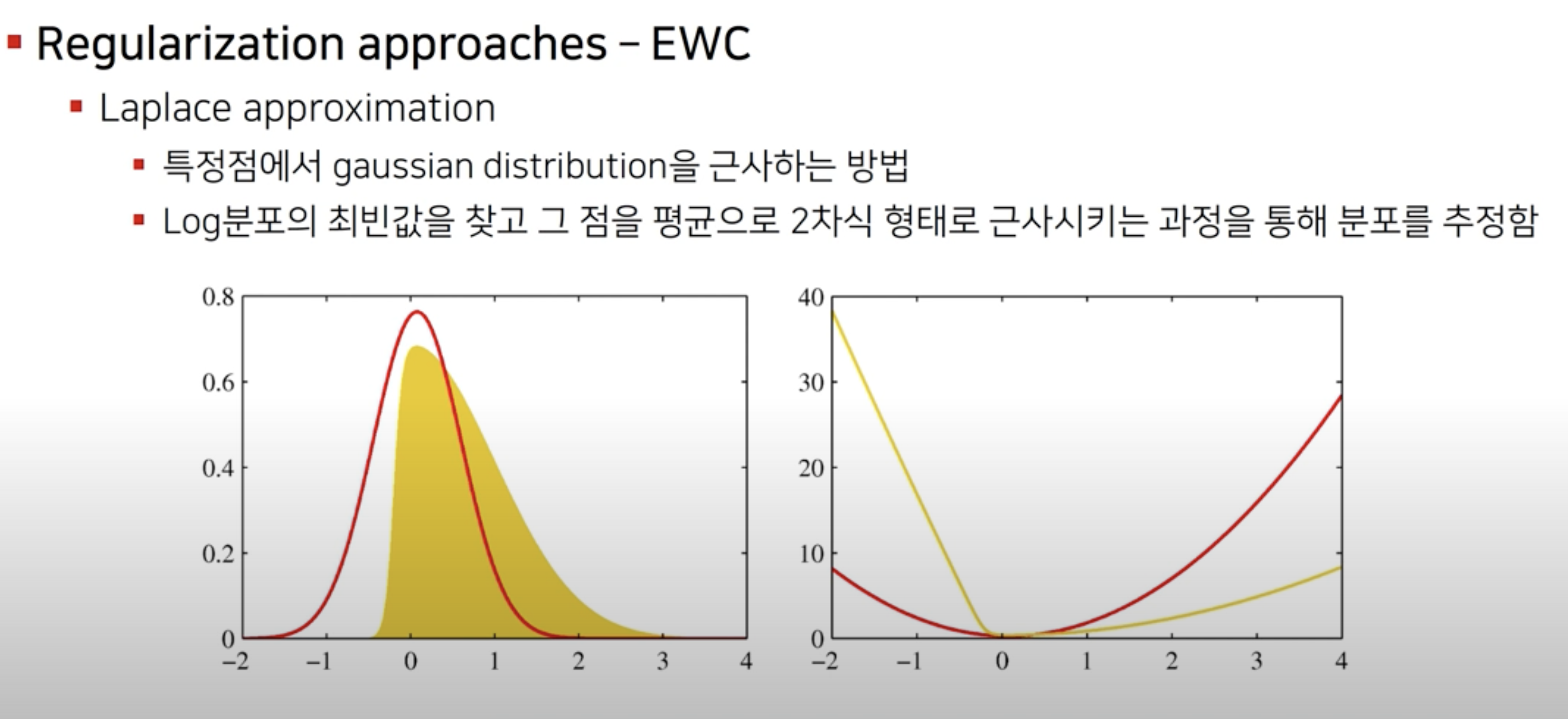

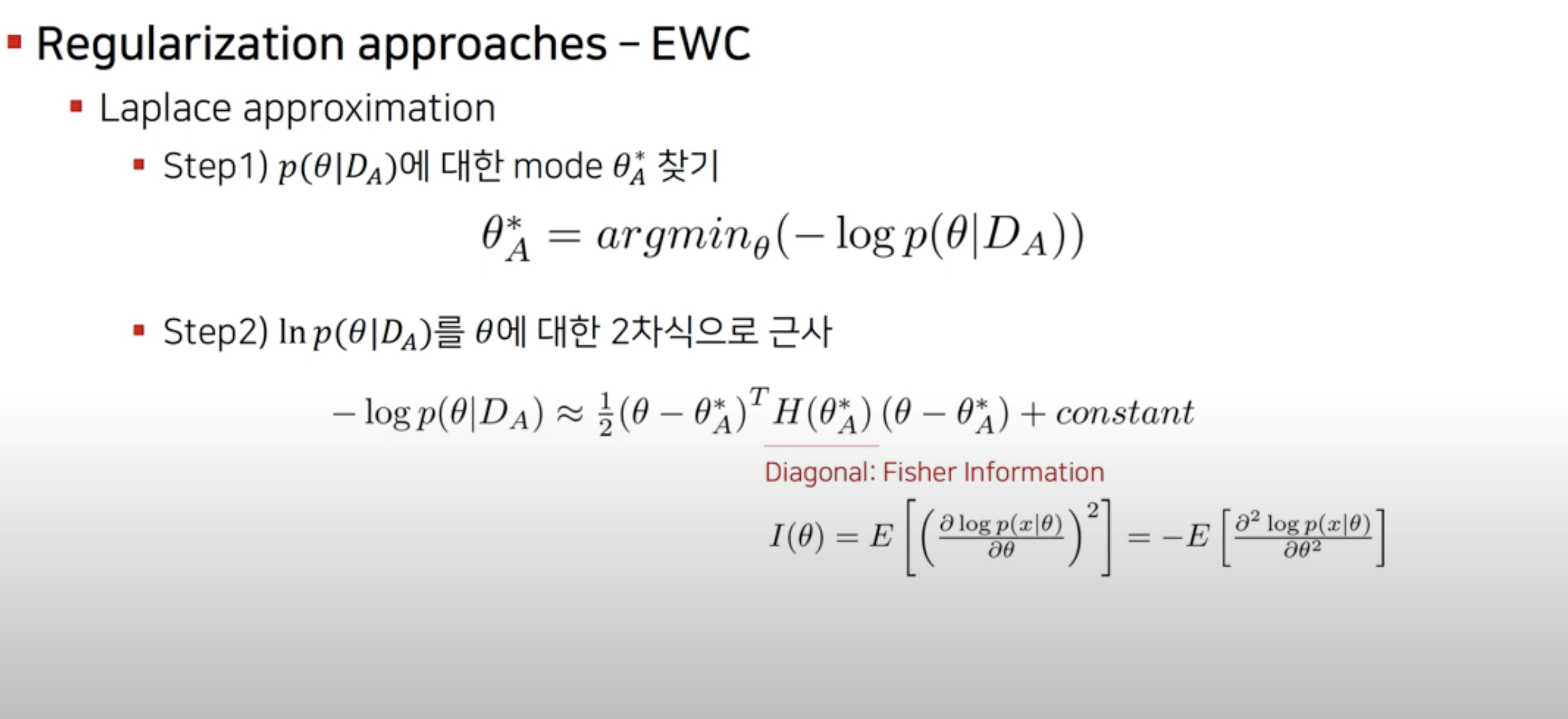

Elastic Weight Consolidation (EWC) 고안

Dynamic network expansion

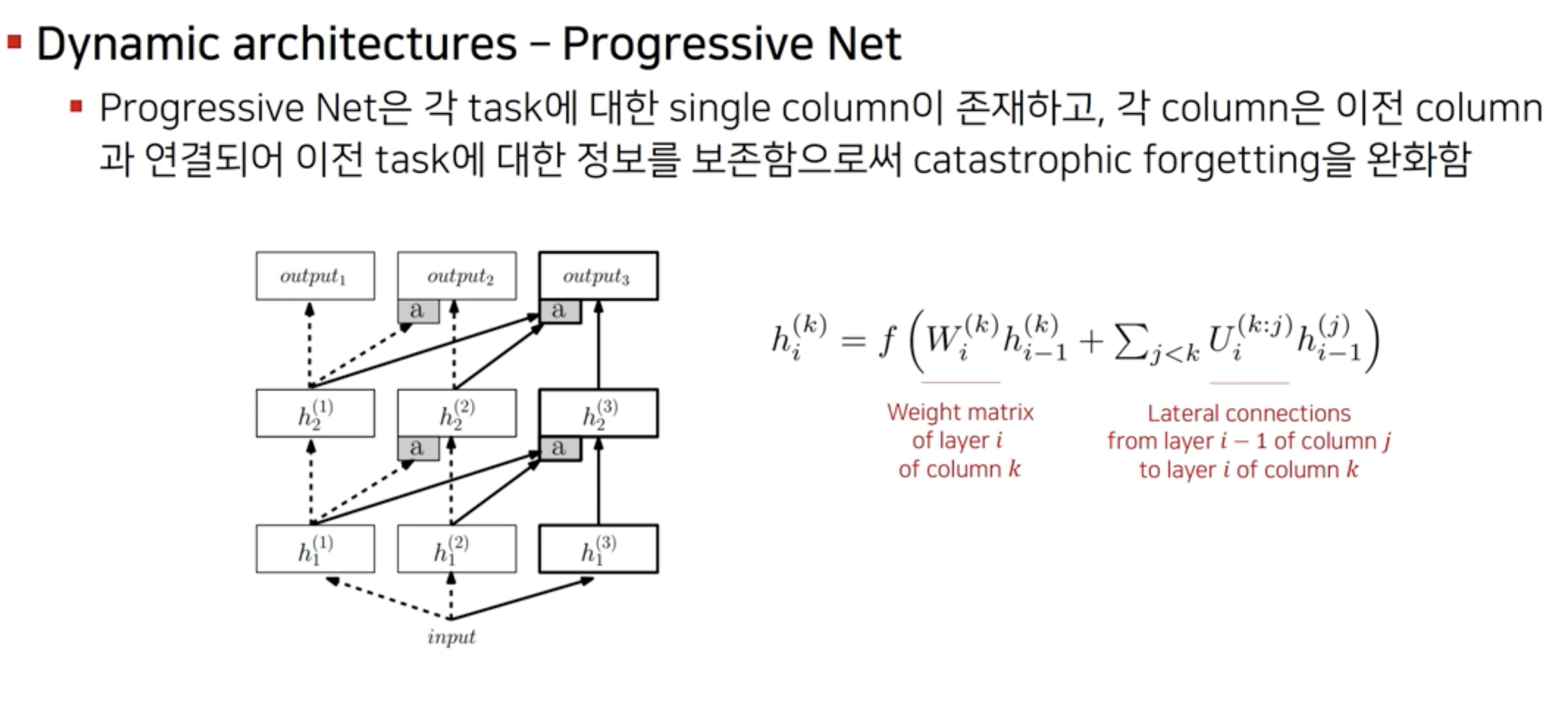

Progressive Neural Network

INCREMENTAL LEARNING OF A DYNAMICALLY EXPANDABLE NETWORK

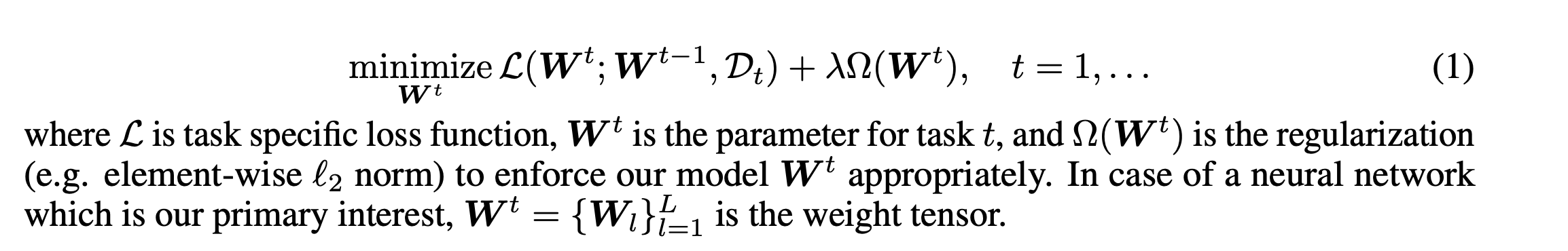

sequential한 t들이 있을 때 목표는 t를 학습, 이때 Dt=Nt제공.

task는 binary case 분류(0,1)

3 step

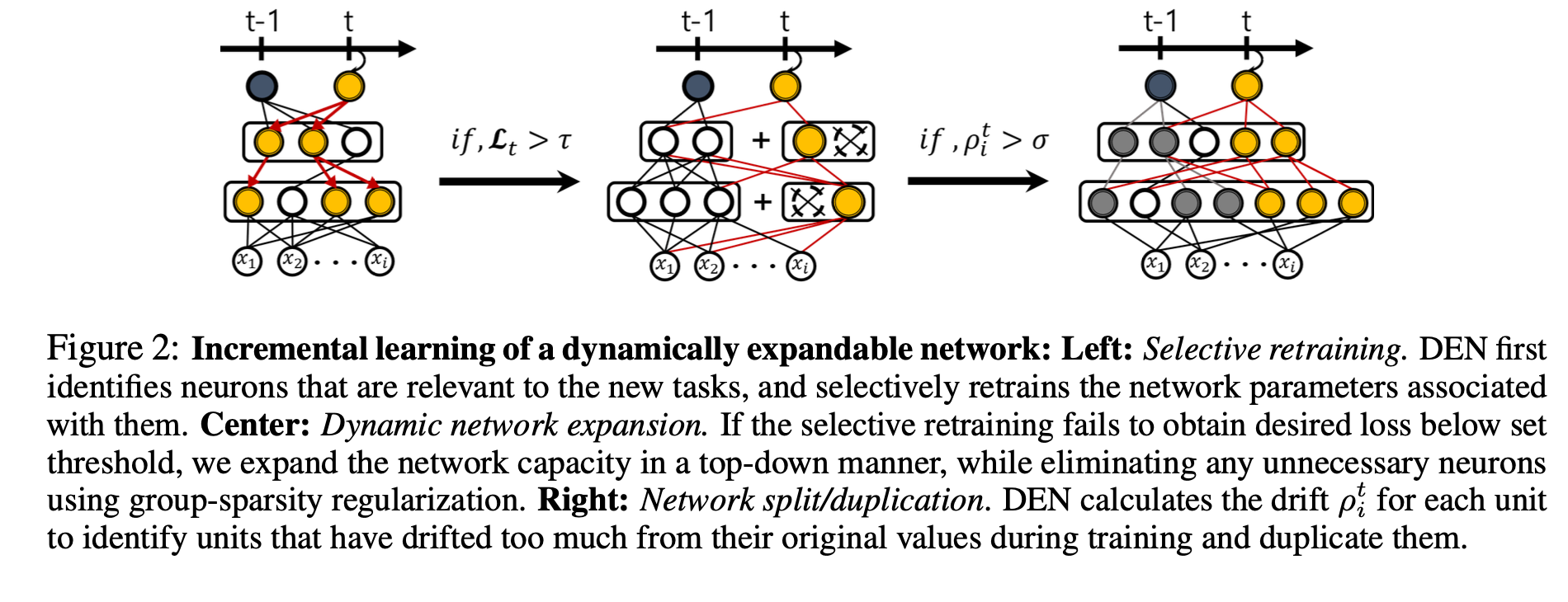

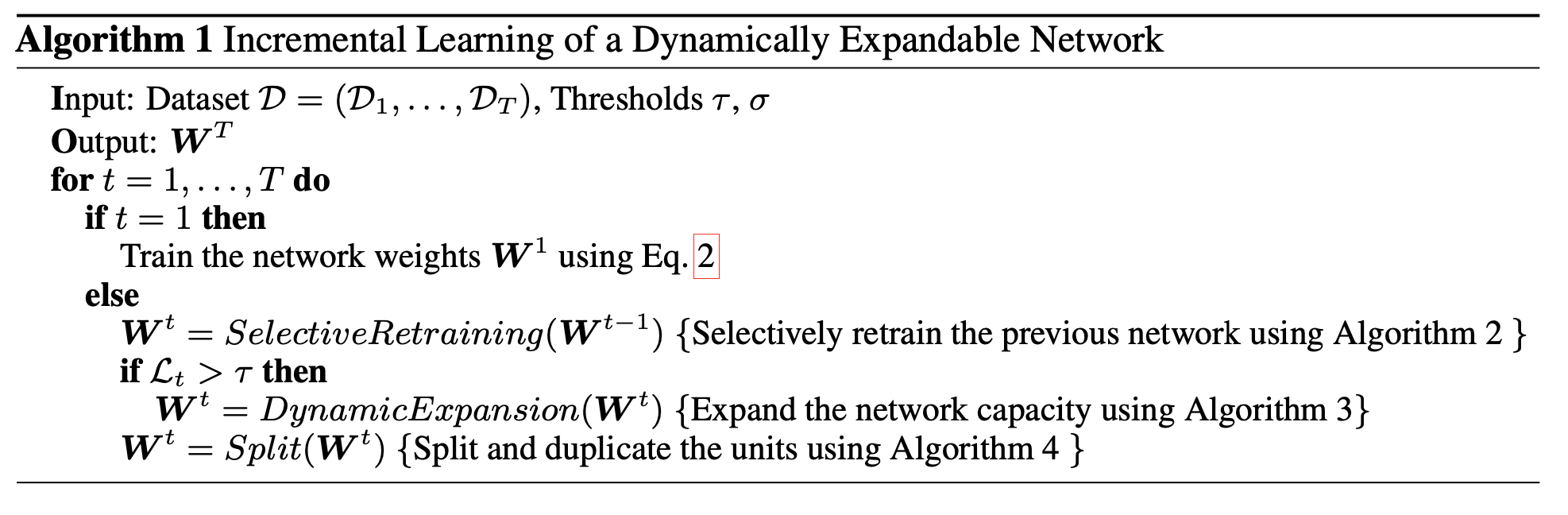

1. Selective Retraining.

2. Dynamic Network Expansion.

3. Network Split/Duplication.

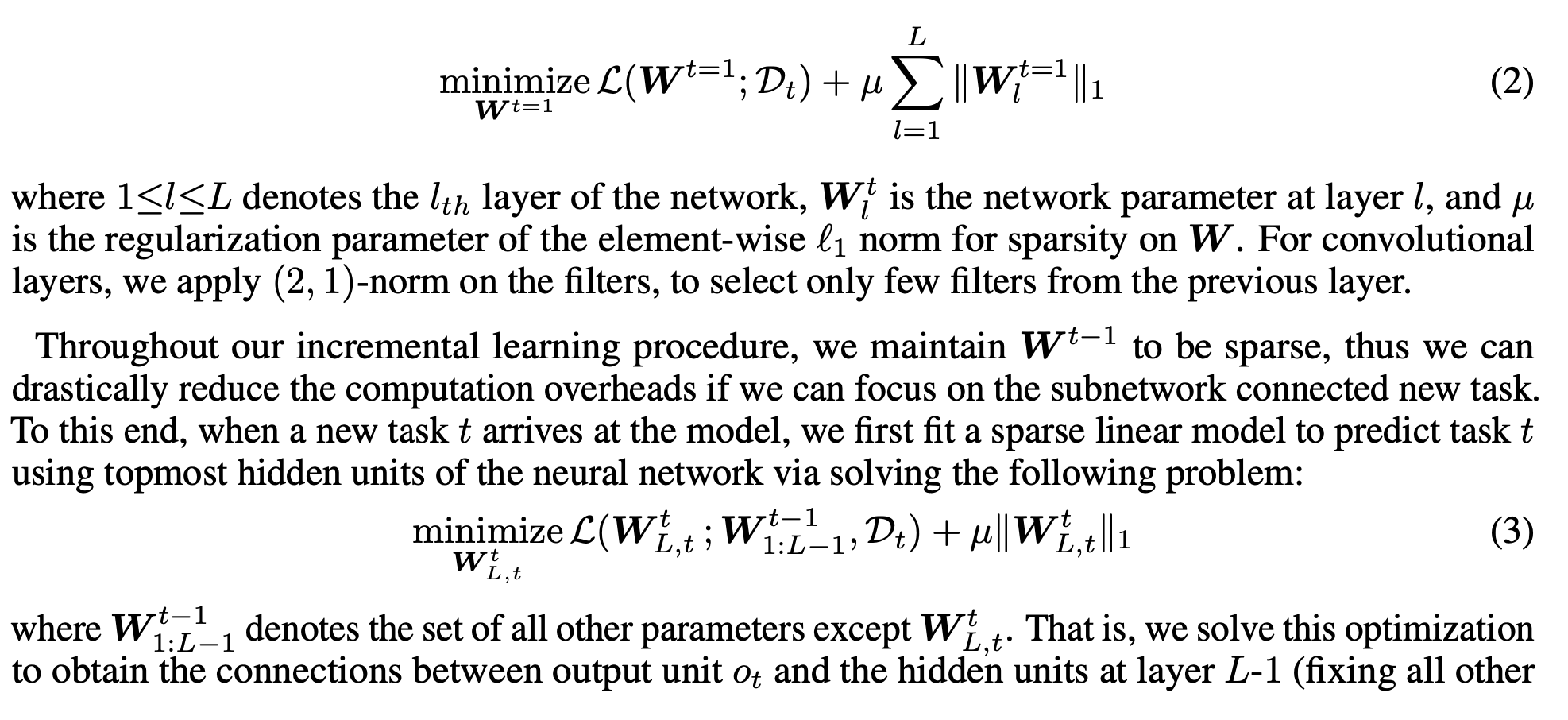

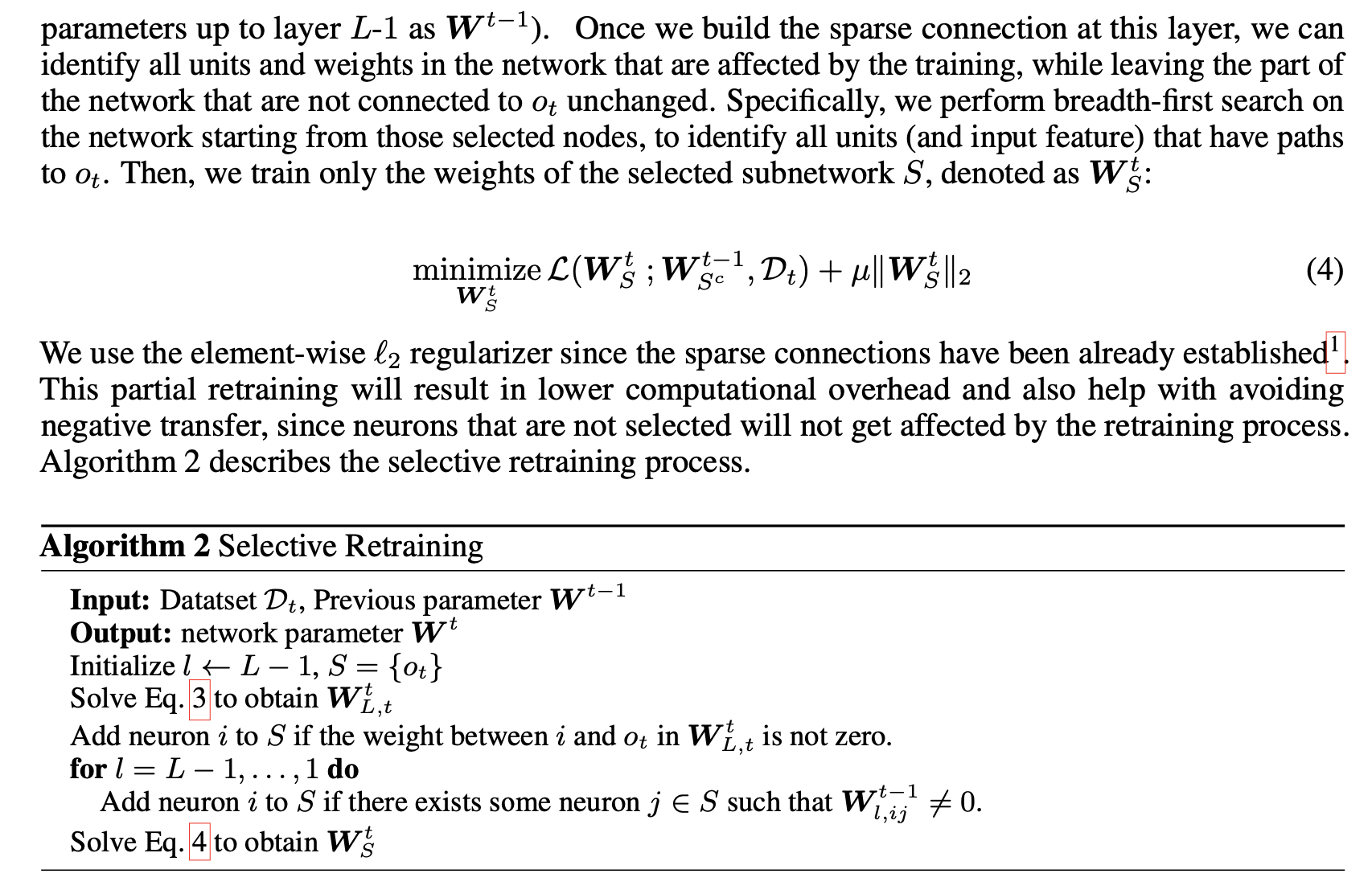

Selective Retraining

retraining시 필요한 feature이자 weight만 학습 필요. 선택적으로 필요 Node 선택하고 Retraining시키는 algorithm.

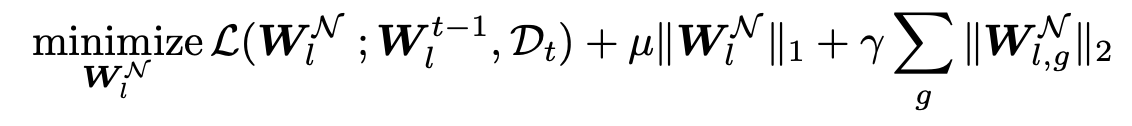

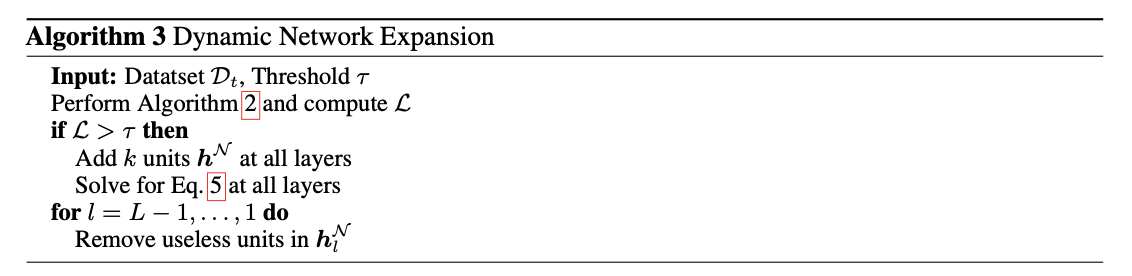

Dynamic Network Expansion.

1) Selective retraining model이 task를 적절하게 표현하는지 확인

2) task의 필요한 feature을 잘 추출하기 위한 neuron 생성

-> 새로운 task의 selective retraining 의 Loss가 threshold 이상인가

k개의 노드 확장 후 Loss를 계산해

Task difficulty를 확인 후 확장:

group sparse regularization 적용 한 후 필요 없는 Neuron 를 제거함으로 Network 확장.

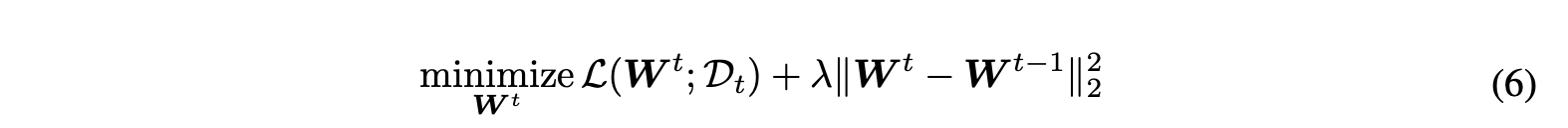

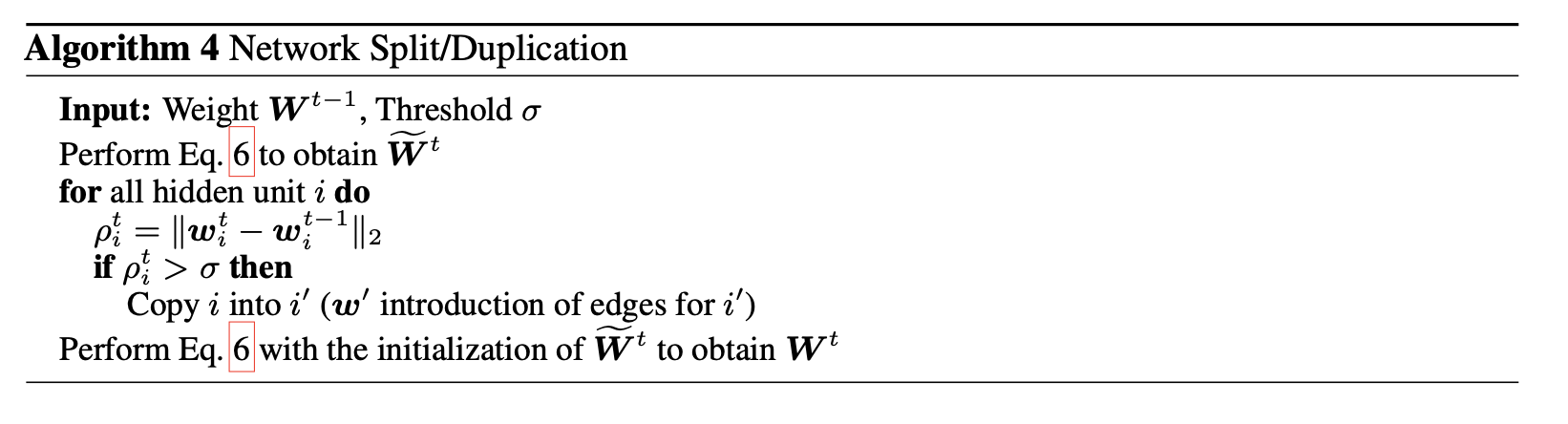

Network Split/Duplication.

1) 각 Neuron에 Sementic drift가 발생했는지 확인.

2) Sementic dfirt 발생 시 그 Neuron은 duplicate 후 학습.

Timestamped Inference.

timestamping을 해 상황에 따라 선택적 노트 골라서 test

EXPERIMENT

Conclusion

DEN을 만듦으로써 적은 Capacity의 multi task를 좋은 성능으로 train하는 model 개발.