자연어처리 관련 내용 정리

1.word2vec

Stanford의 cs224n 강의를 보고 복습차원에서 정리하였습니다. 언어라는 것은 지식을 전달하는 매개체로서 인간의 발전을 이끌어 왔고 현대에서도 아주 중요한 역할을 해오고 있습니다. cs224n의 강의는 이러한 인간의 언어를 어떻게 하면 컴퓨터가 인간의 언어를 더

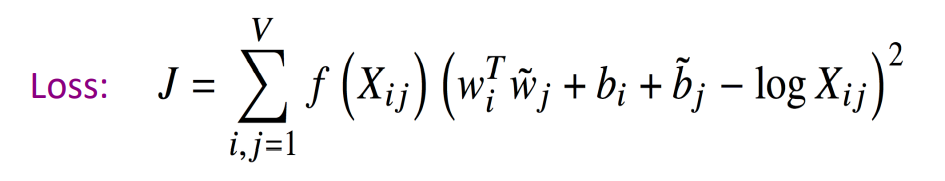

2.word2vec/GLOVE

Stanford의 cs224n 강의를 보고 복습차원에서 정리하였습니다. 저번 강의에서는 word2vec에 대해서 주요 개념들을 정리하였습니다. 이번 챕터에서는 저번챕터에 이어 word2vec과 Glove에 대해서 알아보겠습니다. word2vec ▶저번시간 내용 ra

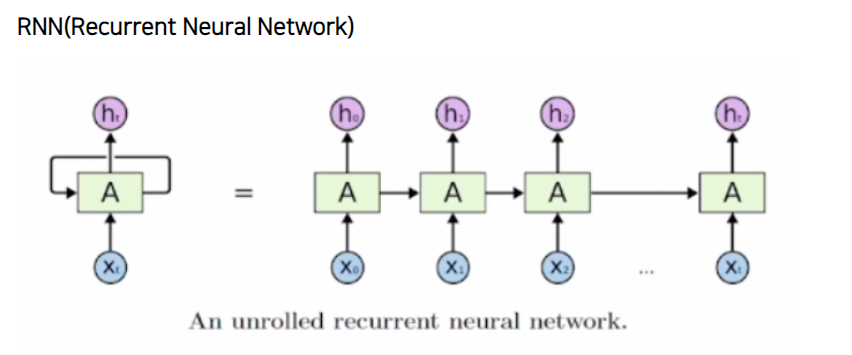

3.Recurrent Neural Net

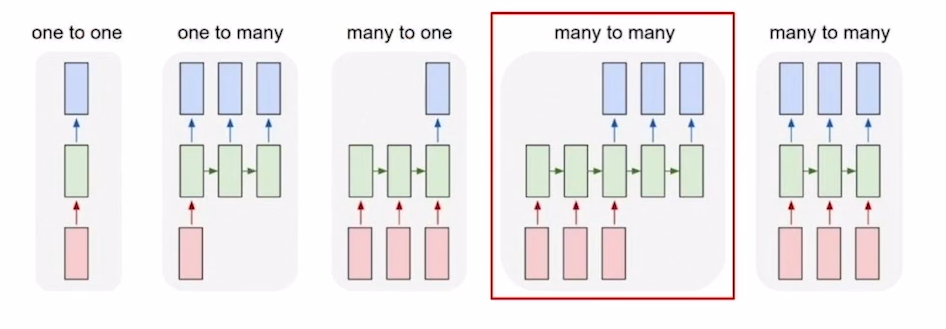

boost course 자연어처리의 모든 것의 강의를 보고 rnn에 대해 정리하였습니다.RNN은 입력과 출력을 시퀀스 단위로 처리하는 모델입니다. 현재 입력값에 대하여 이전 입력값들에 대한 정보를 바탕으로 예측값을 산출한다는 말입니다. 예를들어 I am a studen

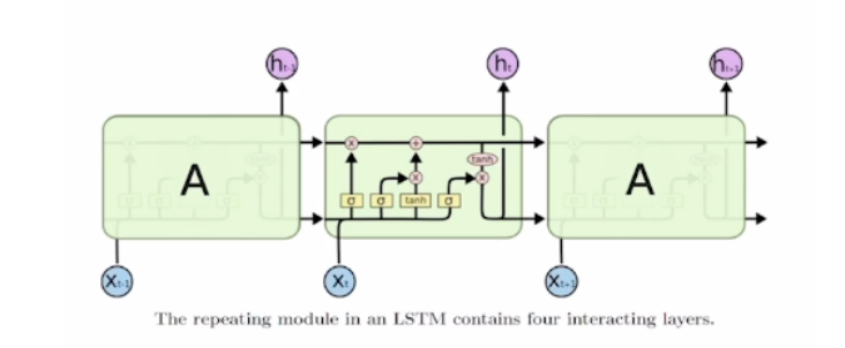

4.LSTM( long short-term memory ) & GRU( Gated recurrent unit )

boost course의 자연어처리의 모든 것을 보고 복습차원에서 작성하였습니다. 앞에서는 RNN과 RNN을 이용한 CHARACTER LEVEL language model에 대해서 살펴보았습니다. CHARACTER LEVEL language model은 위의 그림과

5.Sequence-to-sequence with attention

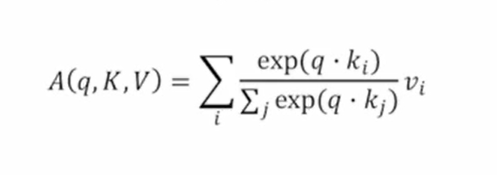

boost course의 자연어 처리의 모든 것 강의를 보고 복습차원에서 작성하였습니다.앞선 내용들 까지는 RNN의 구조와 문제점, lstm, gru에 대해서 살펴보았습니다. 이번에서는 이러한 모델들을 가지고 Sequence-to-sequence model을 만들고

6.Beam search & evaluation metric

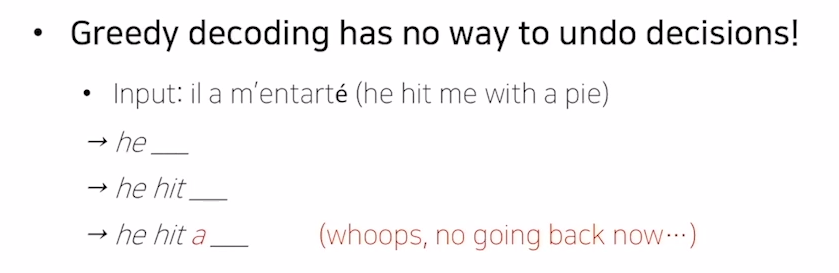

boost course의 자연어 처리의 모든 것을 보고 강의 복습차원에서 작성하였습니다. 앞선 chapter에서는 seq2seq 모델에 대해서 설명을 하였습니다. seq2seq model의 decoder는 encoder에서 나온 output과 decoder의 input

7.Transformer

boost course 자연어 처리의 모든 것 강의를 보고 복습차원에서 정리해 보았습니다. 앞의 chapter에서 설명드린 RNN의 구조에 대해서 간단하게 살펴보고 가겠습니다. RNN은 현 시점의 input과 이전 시점의 hidden state를 입력으로 받는다고 하