LLM의 등장배경

ML(Machine Learning)

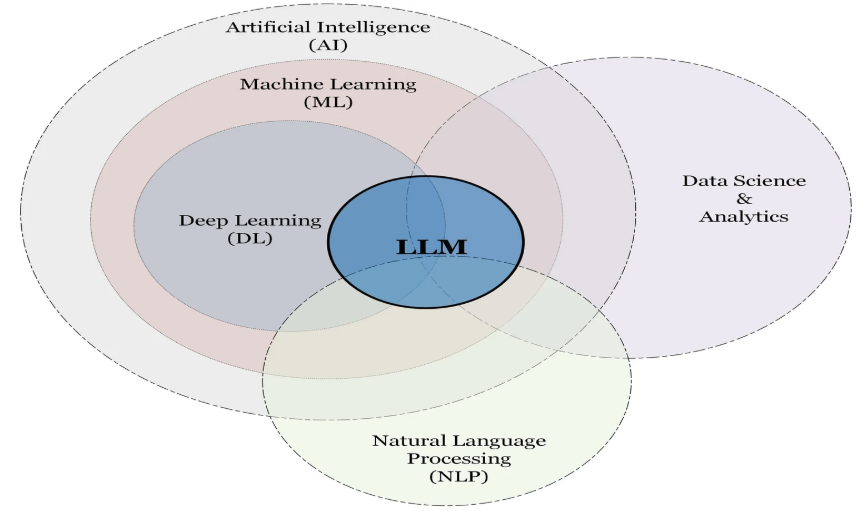

그 후, 1990년대에 들어서 ML(Machine Learning)이라는 개념이 생기게 된다. 말 그대로 스스로 규칙을 찾아 학습을 하는 알고리즘이 생긴것이다. 당연하게도 해당 기능이 가능해진 이유는 인터넷의 등장이다.

웹이 생겨나며 대량의 데이터를 활용할 수 있게 되면서, AI는 머신러닝을 기반으로 다시 발전하기 시작한다.

하지만 입력과 출력 사이에 단순한 직선적인 관계가 아닌 복잡한 관계가 존재하는 문제들(비선형 문제)를 효과적으로 해결하지 못하면서 모델이 데이터에서 중요한 패턴을 놓치거나 잘못된 예측을 하는 경우가 생기게 되며 ML의 끝을 보게 된다.

-> 복잡한 데이터(이미지,음성,자연어(NLP))처리 성능의 부족

-> 특징을 사람이 직접 설계

DL(Deep Learning)

침체된 인공신경망의 연구를 끌어올린 인물이 딥러닝의 대부 제프리 힌튼(Geoffrey Hinton) 이다.

힌튼은 인공신경망을 여러 겹 쌓은 다층 퍼셉티론 이론에 역전파 알고리즘을 적용하여 기존의 비선형문제를 해결할 수 있음을 증명했고, 심층 신뢰 신경망(DBN)을 제시하여 비지도학습을 통한 사전 훈련과 네트워크의 미세 조정을 통해 학습 속도와 효율성을 크게 높여 '딥러닝'의 기초 개념을 정립했다.

이렇게 다층신경망(DNN)을 사용하여 데이터에서 자동으로 특징을 학습하고 발전하여 AI 알파고가 탄생하게 된것이다.

-> 앞선 이미지,음성,자연어 어느정도 처리는 가능하지만, 아직 부족

-> 해석 가능성이 낮음 -> 왜 특정 결론을 내렸는지 이해 불가(신뢰도)

LLM(Large Language Machine)

그리고 2022년 말 오픈AI가 LLM GPT를 탑재한 chatGPT를 출시하면서 생성형 AI의 시대가 열리게 된다. 생성형 AI는 인간의 영역이라고 불리우던 창작의 영역에 침투하며 수준 높은 컨텐츠를 생성하게 된다.

즉, 인간 언어를 이용해서 컴퓨터와 의사 소통하게 되었다는 의미이다.

이제 우리는 LLM의 발전 과정에 대해 좀 더 자세하게 들여다볼것이다.