논문 리뷰

1.OMNIQUANT: OMNIDIRECTIONALLY CALIBRATED QUANTIZATION FOR LARGE LANGUAGE MODELS

Large Language Model(LLM)은 다양한 Natural Language Process(NLP) benchmark에서 인상적인 performance를 보여주었다. 그러나 LLM이 많은 computation과 memory를 요구하기 때문에 LLM을 real

2.Scalable Pre-training of Large Autoregressive Image Models

1. Introduction NLP task에서 pre-training task agnostic models은 일반적이다. 최근 LLM들은 pre-training task에 상관없이 비교적 적은 수의 samples로 downstream task에 대해 좋은 성능을 보인

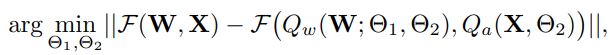

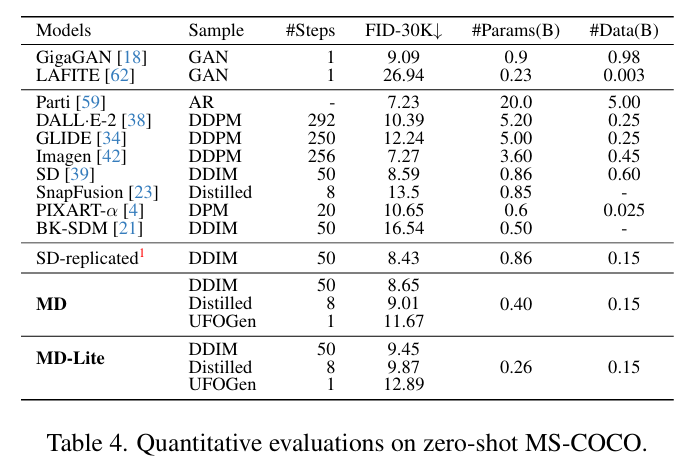

3.MobileDiffusion: Subsecond Text-to-Image Generation on Mobile Devices

1. Introduction Text-to-image model의 inefficiency는 다음 두 가지가 주요 요인이다. 1) iterative denosing 2) complex model architecture 이전의 연구들은 주로 1)에 주목하여 연구를 진행하

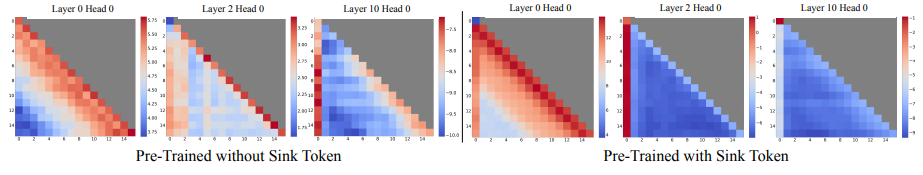

4.Efficient Streaming Language Models with Attention Sinks

1 Introduction 서비스 관점에서 효과적이고 유용한 application을 만들기 위해 LLM은 long sequence generation을 수행할 수 있어야한다. 그러나 현재 LLM은 pre-trained 과정에서 설정된 input token length

5.MobileNetV4 - Universal Models for the Mobile Ecosystem

1. Introduction Efficient on-device neural networks는 빠르고 interactive한 neural networks 경험을 제공한다. 또한 private data를 public internet에 streaming 하는 것을 방지할