AI

1.LLM이란 무엇일까? : LLM의 정의 고찰

순환신경망이라고도 불리는 RNN은 NLP에서 가장 기본적인 모델로 알려져있다. 스팸 메일을 분류하는 문제가 있다고 생각해보자. 입력으로 들어갈 문장은 하나의 Sequence인데 기본적인 MLP(Multi Layer Perceptron, 기본적인 딥러닝 구조)는 문장의

2023년 11월 18일

2.Windows에서 Llama2 실행해보기 (CPU)

Meta(Facebook)에서 개발된 LLM인 Llama는 23년 3월에 유출되면서 세상에 알려졌다. Llama2는 23년 9월에 정식으로 공개되었는데 라이센스를 읽어보면 상업적 사용까지 허용되었다.

2023년 11월 21일

3.Windows에서 Llama3 실행해보기 (Intel Arc GPU A770 + LLaMA.C++)

24년 4월에 Meta에서 공개한 LLM이다. 지난 모델과 비교해서 엄청난 성능 향상을 보여준다. 그리고 여전히 상업적 사용을 허락하는 라이센스이다!

2024년 6월 23일

4.RunPod으로 LLM 직접 실행해보기 (Ollama / Open WebUI / Llama3.1)

GPT3를 시작으로 LLM(Large Language Model)들의 크기(=매개변수)는 급격히 증가했고, 이로 인해 아주 많은 메모리와 연산량이 필요해졌다. 런팟과 같은 GPU 클라우드를 이용하면 RTX 4090기준 시간당 1달러 미만으로 GPU를 대여할 수 있다.

2025년 3월 2일

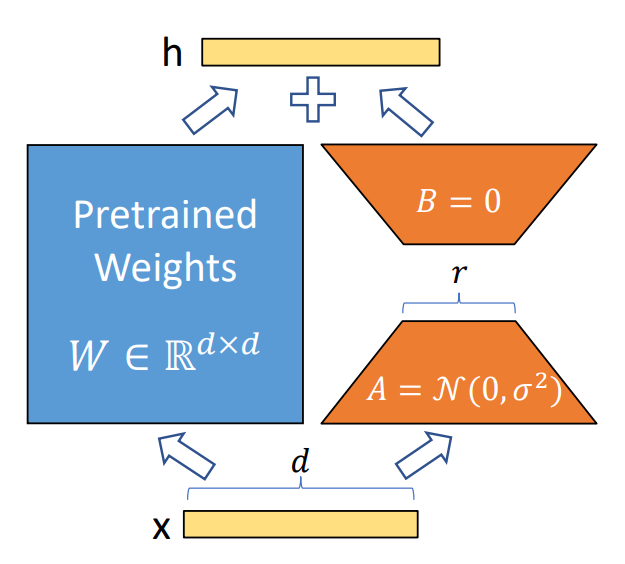

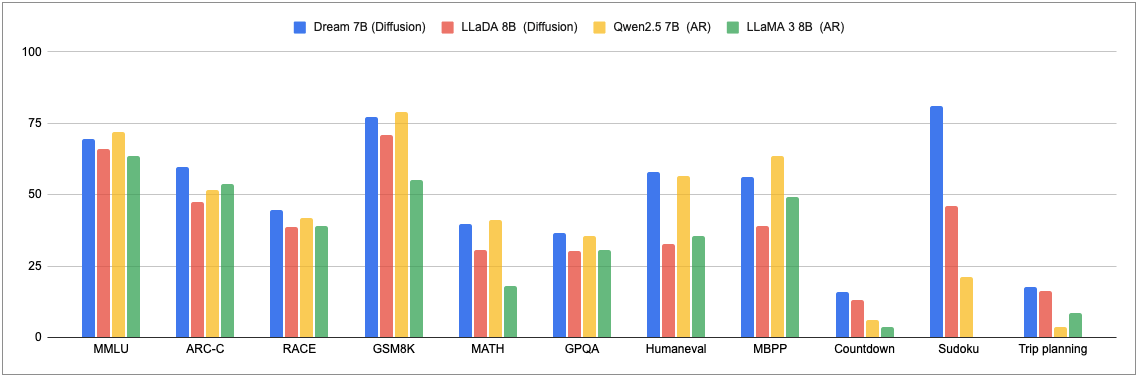

5.Diffusion-LM 예제로 이해하기 (DREAM-7B)

이전에 썼던 글에 LLM의 정의를 고찰한 적이 있는데, 개인적으로는 아직도 현업에서 용어의 혼동이 잦은 것 같다. Large Language Diffusion Models라고 부르는 곳도 있으므로 Diffusion-LM도 LLM이라고 해도 되지만, 혼선을 방지하기 위해

2025년 4월 7일