AI 데이터 사이언티스트 과정 수강 일기

1.[Week1] Day1. OT

야심차게 데이터 사이언티스트가 되는 것을 목표로 삼고 데이터 사이언스 글을 연재하려다 보니 부족한 지식이 너무 뼈저리게 느껴져서 지원한 패스트캠퍼스 부트캠프..!

2.[Week1] Day2. 데이터와 친해지기

매일 끊김없는 온라인 강의의 늪이 시작되었다! 오늘의 수업 일정은 이러했다. 이제 열심히 함 달려보자!

3.[Week1] (파이썬 프로그래밍) 01. Data Type

가장 많이 사용되는 연속형 데이터 타입이자, 굉장히 유연한 구조를 가지고 있어 대부분의 데이터를 편하게 다룰 수 있다.파이썬에서 '' 와 ''를 이용하여 표현한다. e.g. 1, 2, 3리스트의 원소는 쉼표로 구분되며, 리스트의 원소는 아무 데이터 타입이나 가능하다.

4.[Week2] (데이터 사이언스란?) 01. JD로 살펴보는 Data Science

💡 Data Science : 데이터를 통해 실제 현상을 이해하고 분석하는데, 통계학, 데이터 분석, 기계학습과 연관된 방법론을 통합하는 개념이다.Data를 이용하는 과학의 분야 중에 하나

5.[Week2] (데이터 사이언스란?) 02. 데이터 사이언스 기본 용어

데이터사이언스를 하는데 있어서 기본적인 수학지식이 필요하다! 선형대수학과 통계, 컴퓨터 지식은 선택이 아닌 필수다. 이번 시간에는 간단하게 기본 중의 기본에만 용어를 알아보도록 하자.

6.[Week2] (데이터 사이언스란?) 03. 데이터 분석 레포트

데이터 분석 내용을 정리해서 공유하는 것도 중요한 능력이다. 데이터 분석은 “설득의 도구"로써 사용되기 때문에 분석한 내용을 전달하는 것도 중요하다. 시각화된 자료없이 코드만 들고 경영진을 찾아간다면, 내일 백수가 되는 마법을 경험할 수 있을 것이다.

7.[Week2] (데이터 사이언스란?) 04. 모델링

💡 모델링(Modeling) : 수학/통계적인 방법을 이용하여 데이터를 해석하는 과정 근본적인 개념은 수학적인 모델과 통계적인 모델의 개념에서 나온다. 데이터 사이언스에 사용하는 모델은 통계모델일 수도 있고, 데이터를 분석하는 어떤 시스템일 수도 있다.

8.[Week2] (데이터 엔지니어링이란?) 01. JD로 살펴보는 Data Engineering

💡 Data Engineering : 빅데이터를 수집, 가공, 저장하는 모든 시스템을 구축/관리하는 과정. 대용량 데이터 처리를 위한 DB를 관리하는 작업을 말한다.

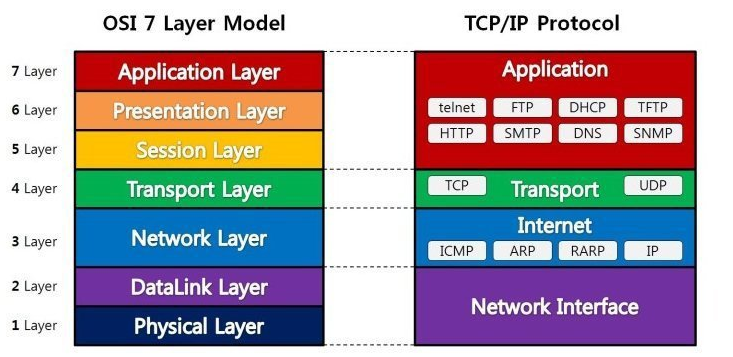

9.[Week2] (데이터 엔지니어링이란?) 02. 데이터 엔지니어링 기초 용어

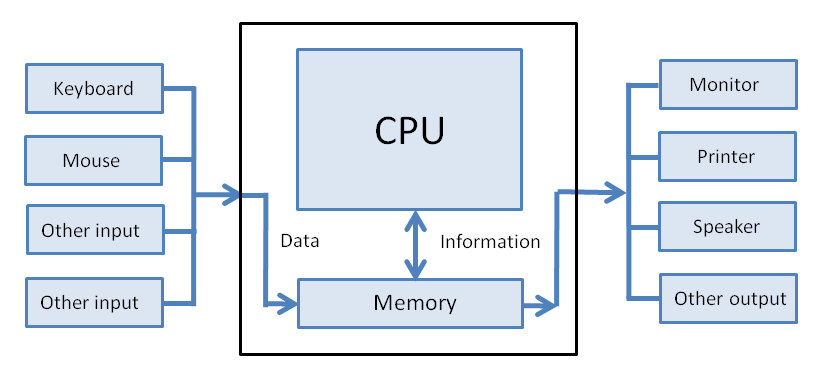

데이터 엔지니어는 컴퓨터의 구조를 이해하고 데이터(특히, 최근에는 빅데이터)를 효율적으로 저장/관리/가공할 수 있는 데이터 파이프라인을 만드는 것

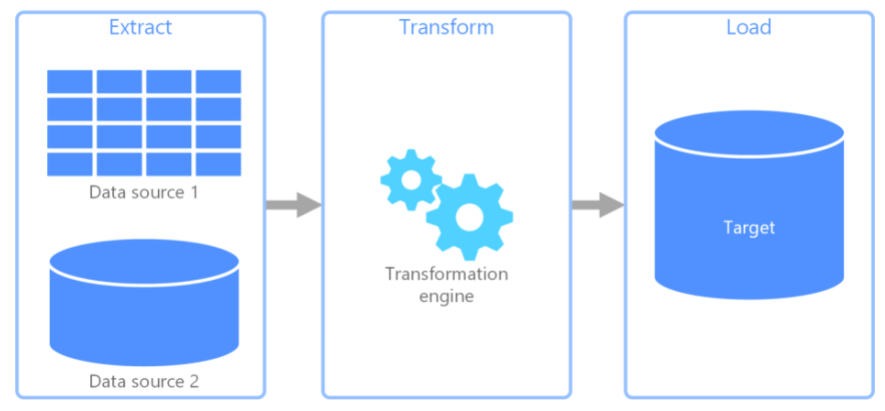

10.[Week2] (데이터 엔지니어링이란?) 03. Data Pipeline

💡 ETL : Extract / Transform / Load. 다양한 데이터 소스로부터 데이터를 수집 및 처리하는데 사용되는 데이터 파이프라인데이터 분석가들이 분석에 사용할 데이터를 정의하게 되면, 데이터 엔지니어에게 요청을 해서 해당 데이터를 처리해주길 원한다.

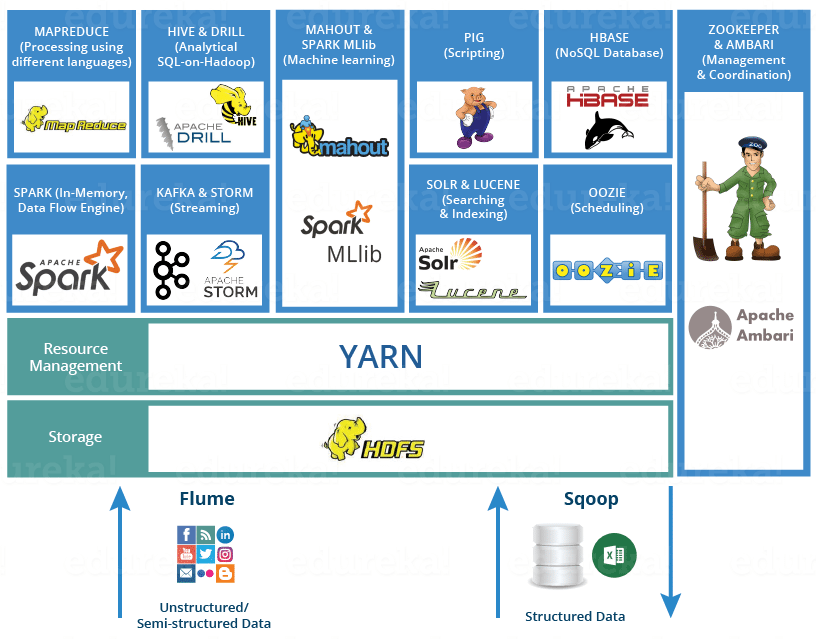

11.[Week2] 데이터 엔지니어링이란?) 04. Hadoop Ecosystem

💡 (Apache) Hadoop : High-Availability Distributed Object-Oriented Platform의 약자

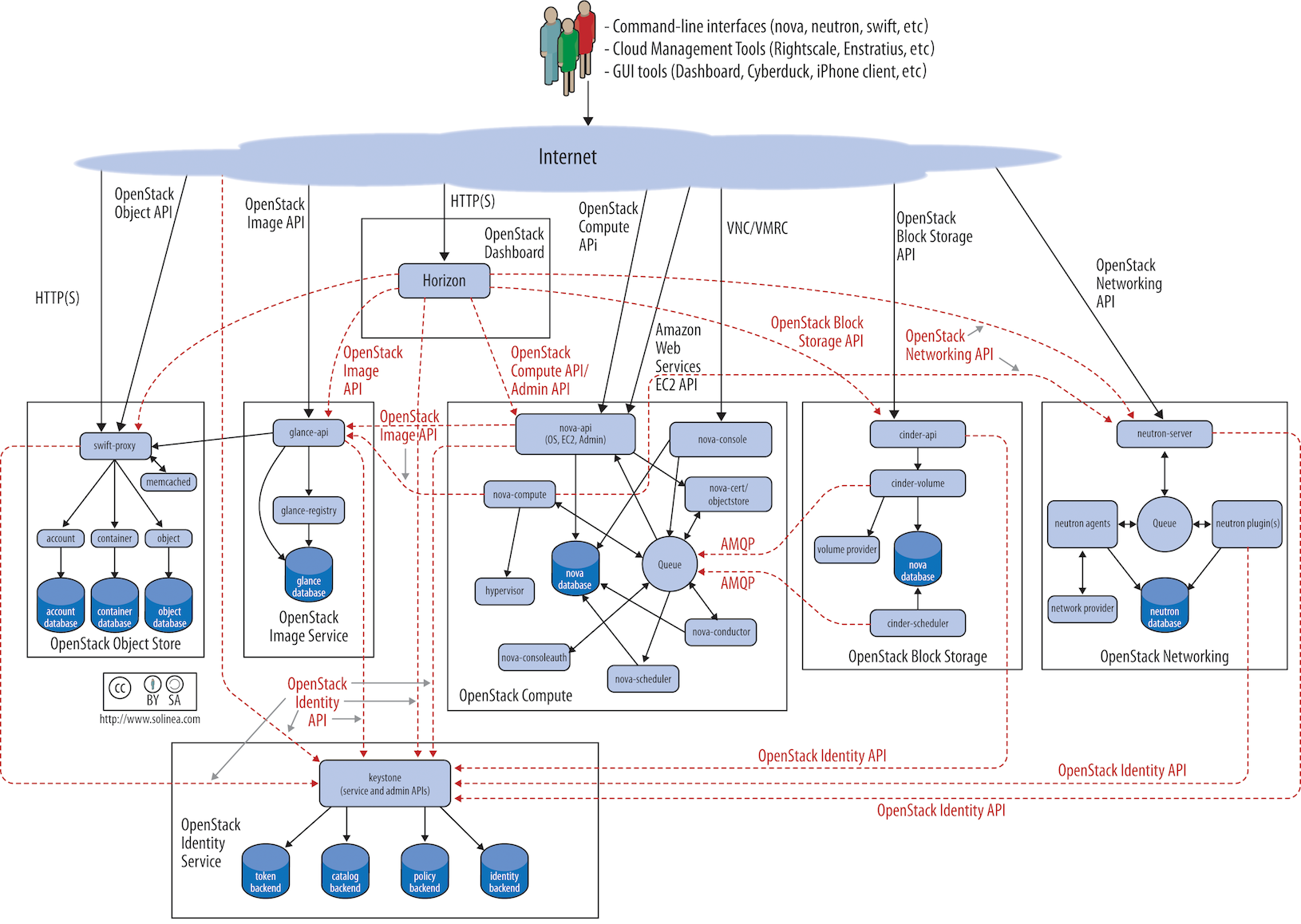

12.[Week2] (데이터 엔지니어링이란?) 05. Cloud Computing

💡 Cloud Computing : 사용자의 필요에 따라 Computing Resource를 할당해주는 시스템. 할당을 해주는 서버가 네트워크/서비스를 통해서 제공해주는 시스템. 지금은 ‘대'클라우드 시대다.

13.[Week2] (파이썬 프로그래밍) 02. IF

💡 IF : 조건에 따라 다른 명령을 수행하는 statement. (조건문, conditional statement)

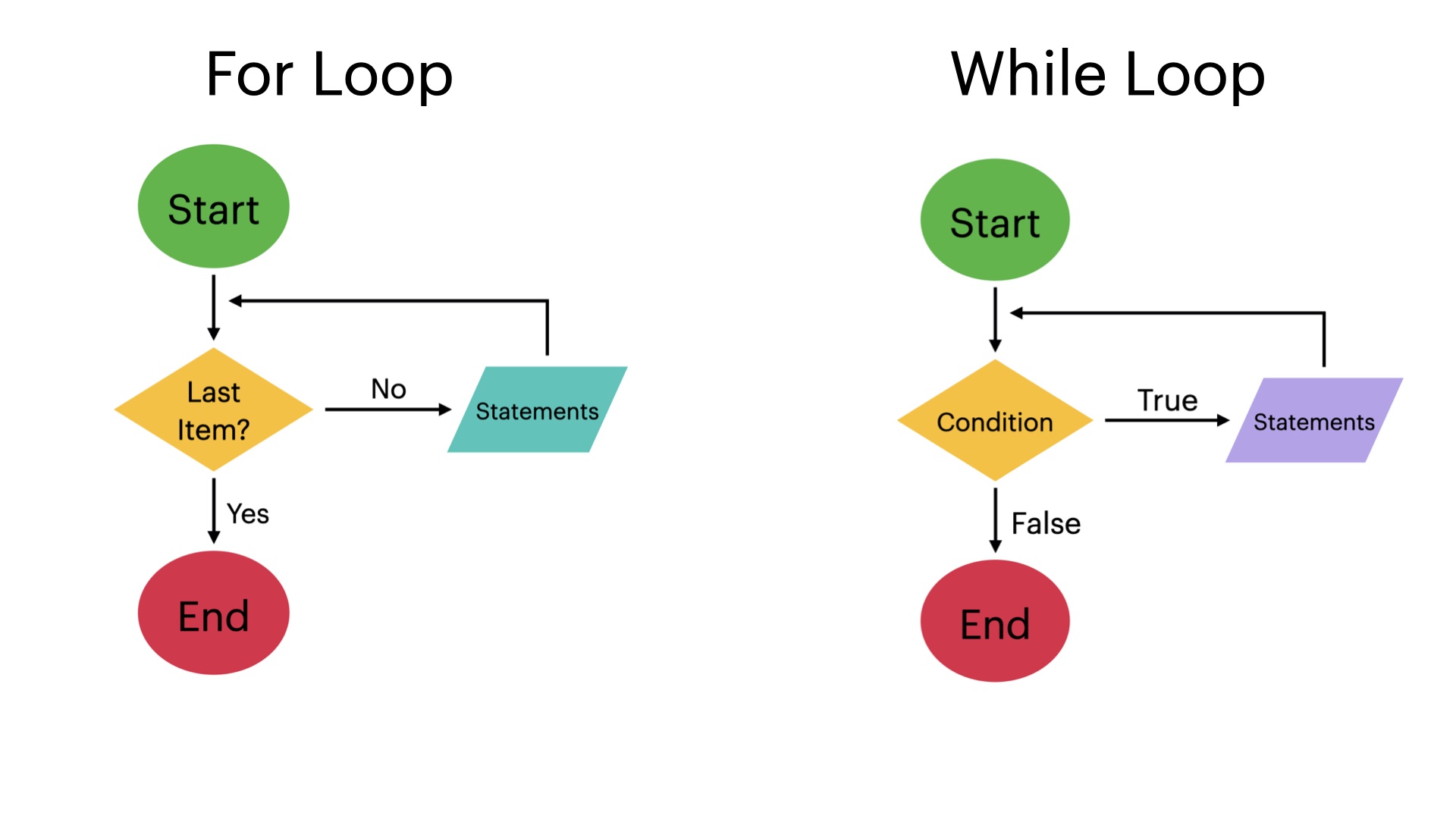

14.[Week2] (파이썬 프로그래밍) 03. for, while

💡 for, while : 조건에 따라 반복 작업을 수행해야 할 때 사용하는 statement(반복문, iteration)

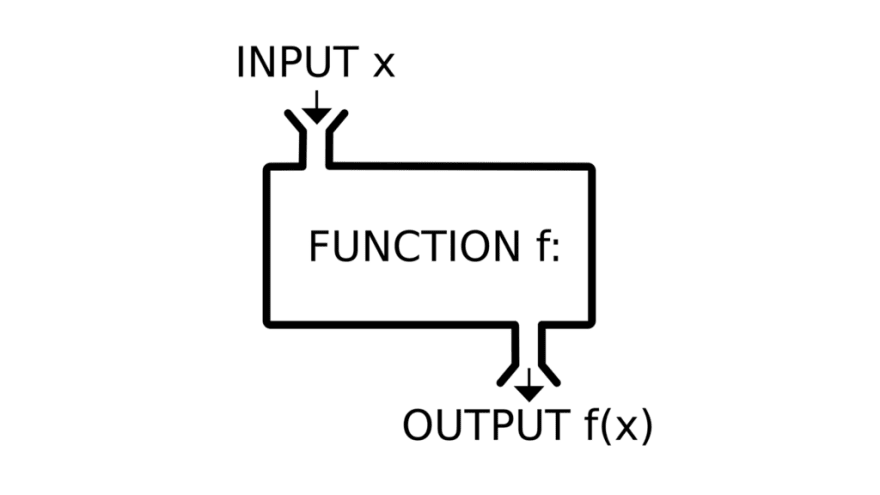

15.[Week2] (파이썬 프로그래밍) 04. 함수

💡 함수(Function) : 한 가지의 기능을 하는 코드 묶음. Input을 받아서 처리하고 Output을 돌려주는 코드. 함수는 기능(function)을 의미한다

16.[Week2] (파이썬 프로그래밍) 05. I/O(입출력)

💡 I/O : Input/Output의 약자로 컴퓨터가 데이터를 입력받고 출력하는 모든 작업을 의미합니다.

17.[Week2] (파이썬 프로그래밍) 06. OOP(객체지향 프로그래밍)

💡 OOP : Object-Oriented Programming의 약자로 객체(Object)를 기반으로 프로그램을 만드는 방법론.

18.[Week2] (파이썬 프로그래밍) 07. Class

💡 Class : OOP에서 구현하려는 개념을 추상화한 코드 템플릿. Class란 구현하려는 개념을 객체(object)의 형태로 표현한 것이다.

19.[Week2] (Web Crawling) 0. 크롬드라이버 세팅하기

웹크롤링을 하기 위해서는 크롬드라이버를 설치해야 한다.chromedirver는 아래 링크에 들어가서 다운로드 받을 수 있다.다운로드 링크 https://chromedriver.chromium.org/downloads그리고ipython을 실행한 후를 실행하면 크

20.[Week3] (Web Crawling) 웹 크롤링이란?

웹 크롤링은 데이터 사이언스를 하는데 있어서 알아두면 굉장히 좋은 스킬이다. 아마 코딩을 배우는 분들이면 많이 들어봤을 것이다. 그렇다면, 웹 크롤링은 대체 무엇일까? 어원을 보면 '웹을 긁어오는 것' 이라는 뜻이다.

21.[Week3] (Web Crawling) 웹 정보 선별하기

웹 크롤링의 뼈대는 앞선 포스팅을 통해 알아보았으니, 이번엔 웹 데이터를 어떻게 가져오고 선별은 어떻게 하는지를 알아보도록 하겠다.우선, 웹 페이지가 무엇인지 대략적으로 알아야 웹페이지에 있는 특정데이터를 가져올 수 있을 것이다.그렇다면, 웹페이지는 무엇일까?

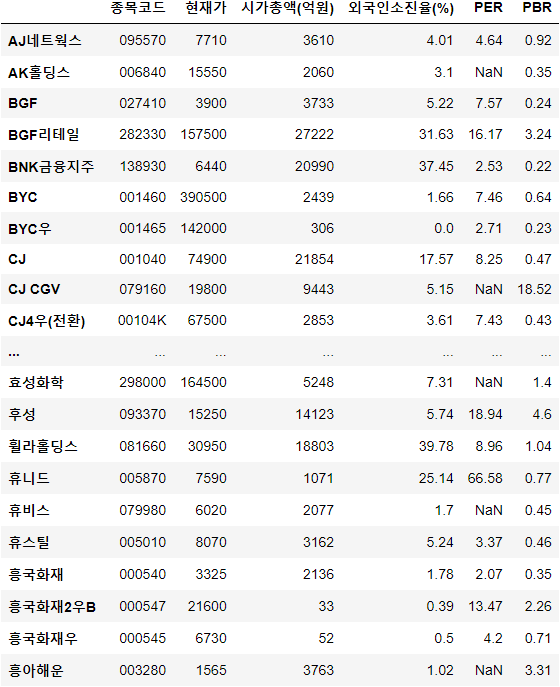

22.[Week3] (Web Crawling) KOSPI 전종목 지수 가져오기

크롤링 연습에 가장 좋은 것이 바로 주식 데이터 불러오기다.동학개미로서 참을 수 없었기 때문에 KOSPI 전종목을 불러오는 코드를 통해 실습을 진행해보았다.코드를 하기 전 준비물은 전종목 kospi 종목코드다.

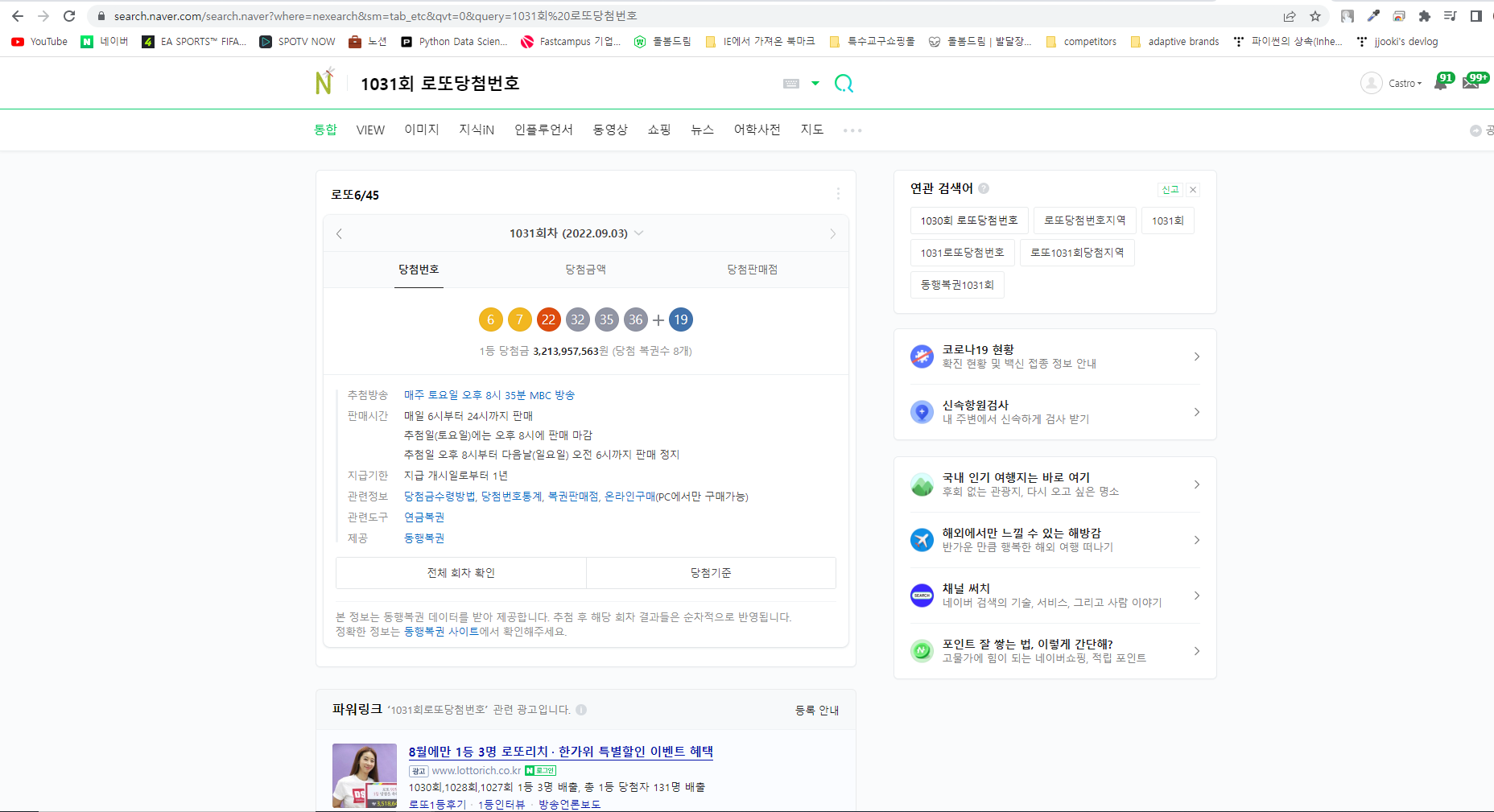

23.[Week3] (Web Crawling) 패턴 URL 크롤링

크롤링 타겟 URL이 순서 또는 특정 규칙에 따라 페이지별로 바뀌는 부분을 이용해 반복문을 통해 다수의 페이지를 긁어오는 방식. 패턴 URL 크롤링은 가장 많이 쓰이는 크롤링으로 여러 페이지를 한번에 긁어오는데 상당히 유용한 방법이다.