NLP

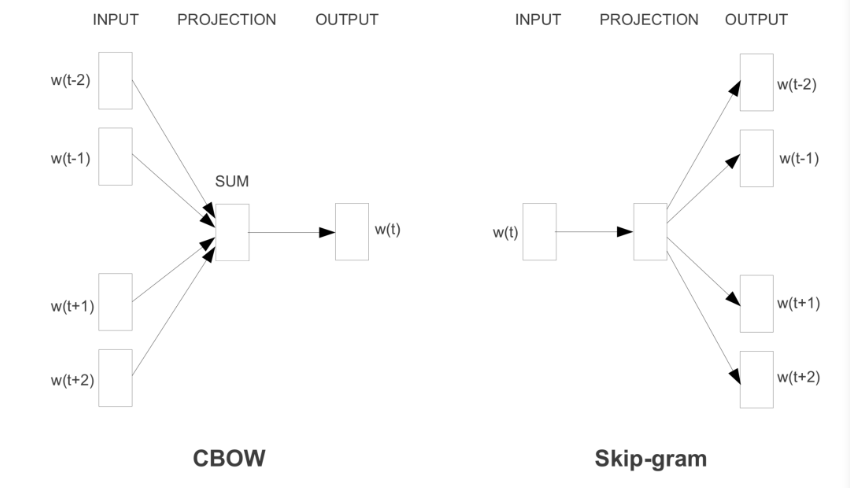

1.NLP - Embedding(word2vec)

임베딩 중 word2vec을 공부하였습니다.

2.시퀀셜 모델링(sequential modeling)

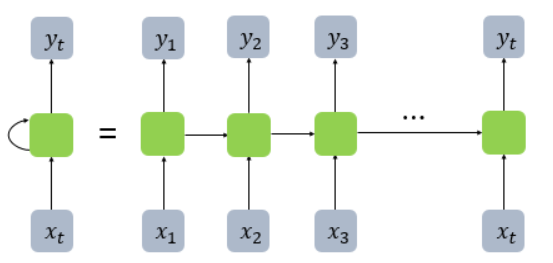

순환 신경망(RNN) 기존의 신경망 구조는 정해진 입력 $x$를 받아 $y$를 출럭해주는 형태였습니다. 하지만 순환 신경망(RNN)은 입력$x1$와 직전의 은닉상태(hidden state)인 $h{t-1}$를 참조하여 현재의 상태인 $h_t$를 결정하는 작업을 여러 t

3.RNN 코드구현

이전 포스트에서 RNN,LSTM,GRU 모델에 대한 개념을 학습했습니다. 이번 포스트는 RNN,LSTM,GRU의 모델을 파이토치 코드로 구현해보겠습니다.파이토치로 RNN을 구현하면 위의 코드와 같습니다. 이 코드를 분석해 보겠습니다.먼저 torch.nn의 nn.Modu

4.전이학습, BERT

이 글은 김기현의 자연어처리 딥러닝 캠프의 내용을 요약하였습니다. 전이학습이란? 전이학습(transfer learning)이란 신경망의 일부 또는 전체 신경망 가중치 파라미터를 최대우도법을 통해 학습데이터에 본격적으로 훈련시키기에 앞서, 다른 데이터셋이나 목적 함수

5.SBERT(Sentence Bert)

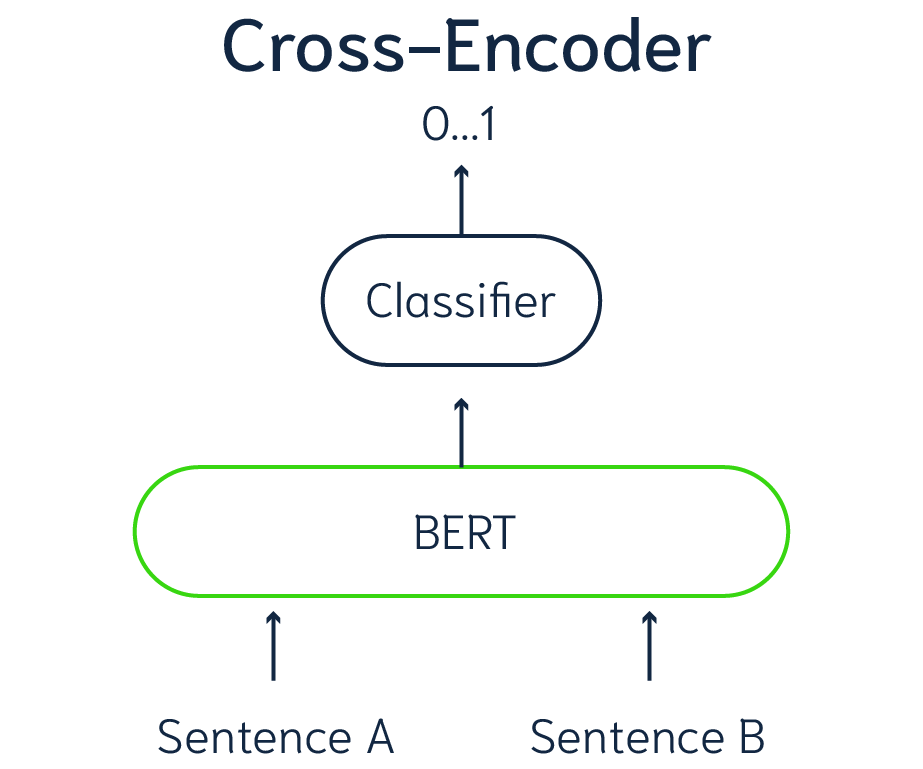

SBERT: https://arxiv.org/pdf/1908.10084.pdfSBERT는 BERT를 개선하여, 문장의 의미를 반영하는 임베딩, 즉 문장의 임베딩을 구하게끔 설계되었습니다.기존의 BERT는 cross-encoder를 사용합니다. 두 문장이 하나

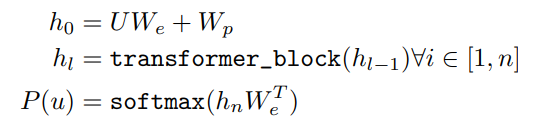

6.[NLP] GPT-1 논문 리뷰

Abstract

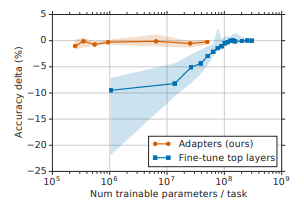

7.[논문 리뷰]adapter

해당 글은 Parameter-Efficient Transfer Learning for NLP 논문을 정리한 글입니다.논문 링크:https://arxiv.org/pdf/1902.00751.pdfICML 2019최근 LLM 모델이 많이 나오게 되면서 점점 천문학적