개념 정리

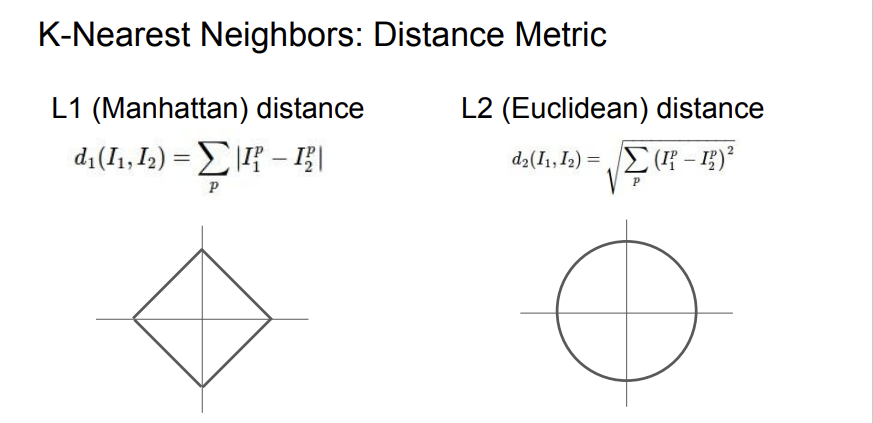

1.L1, L2, Max norm

최근에 cs231n 내용을 다시 복습하면서 모르는 내용을 채워가는 중인데, 그 중에 첫 번째로 다룰 주제는 norm이다. cs231n 2강의 knn classifier의 원리를 설명하면서 나오는 내용이다. 물론 image classification에는 knn을 사용

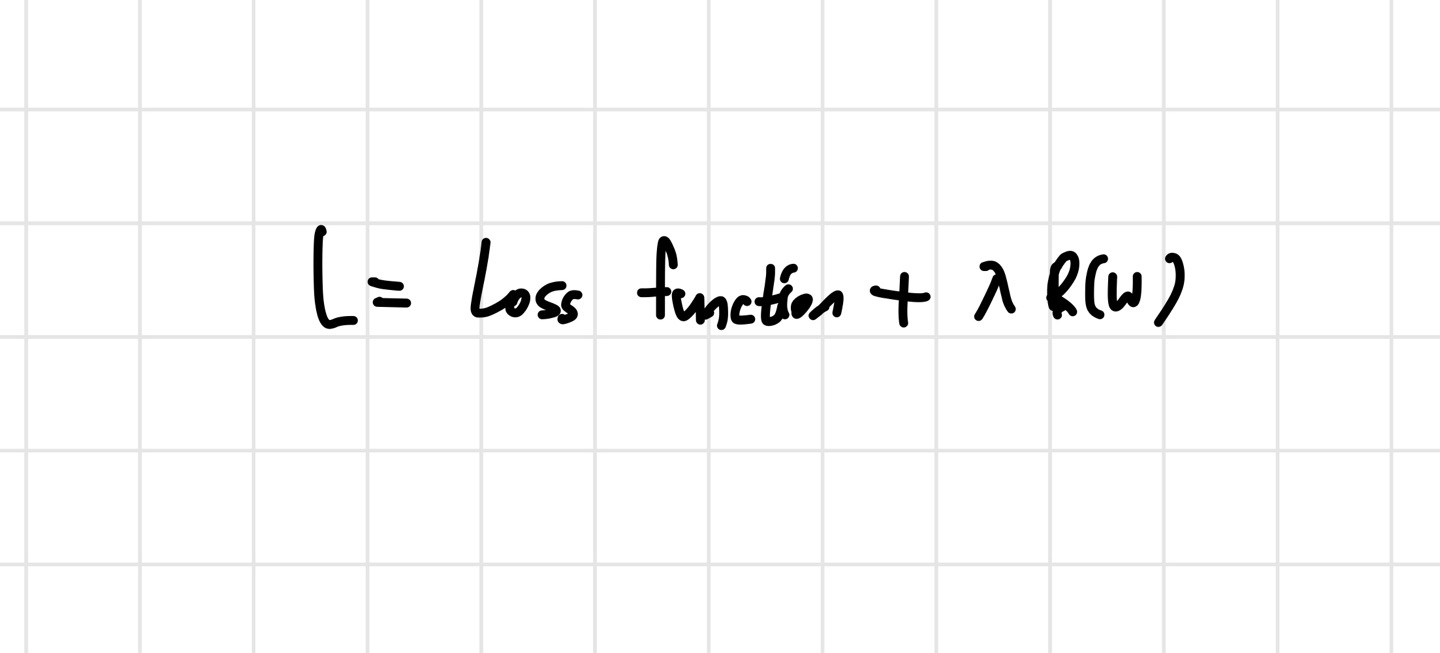

2.L1, L2 Regularization

L1,L2 Regularization은 이전에 정리한 L1,L2 norm을 기반으로 하는 Regularization 방식이다. cs231n 3강을 복습하면서 이 개념들이 항상 헷갈려 정리해보게 되었다. 일단 regularization이 뭔지부터 알아보자. Regu

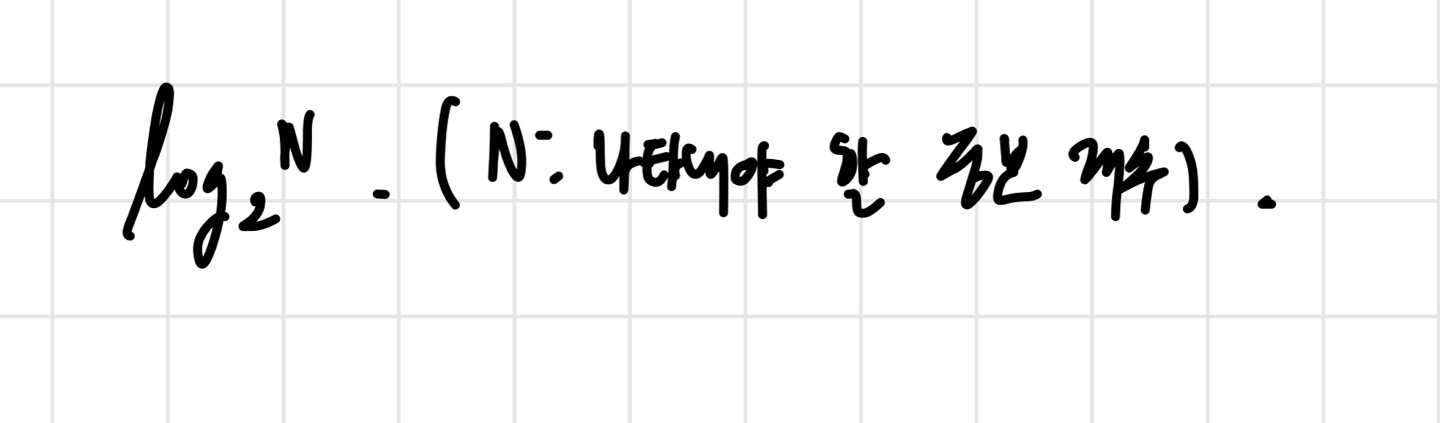

3.Entropy, Cross Entropy, KL-Divergence

이 글은 cs231n 3강을 복습하다가 모르는 부분들을 찾아보고 정리한 내용이다. 공부를 하다보면 많이 듣게되는 Entorpy/ Cross Entropy/ KL Divergence를 다룰 예정이다. 대충은 뭔지 알지만 설명하라고 하면 못할 것이기 떄문에, 한 번쯤

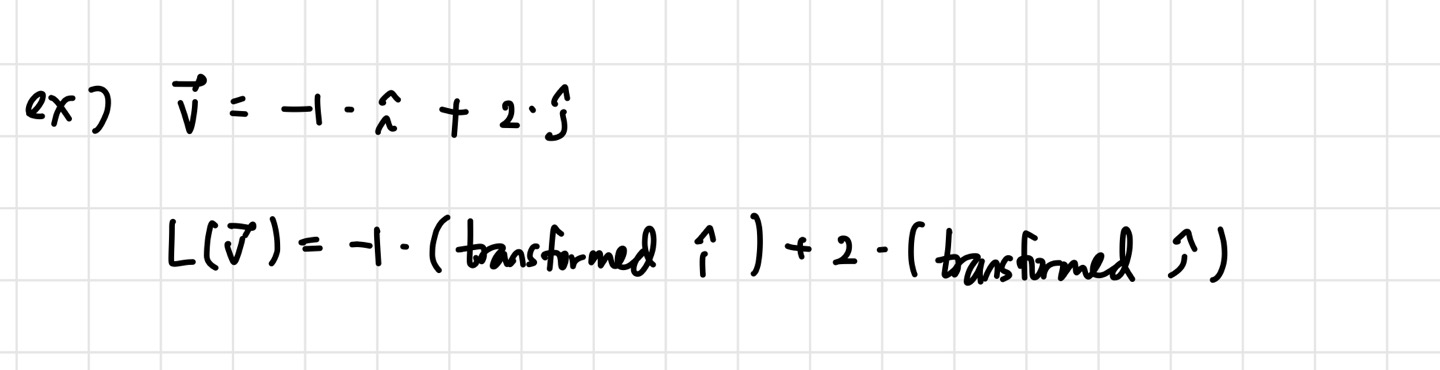

4.Jacobian Matrix

이번에는 cs231n 4강을 복습하다가 모르는 내용이 나와서 정리를 해보려고 한다. Jacobian matrix는 backpropagation에서 많이 사용되는 내용이다. 각 변수에 대한 partial derivative를 알려주기 때문에 유용하게 사용할 수 있다.

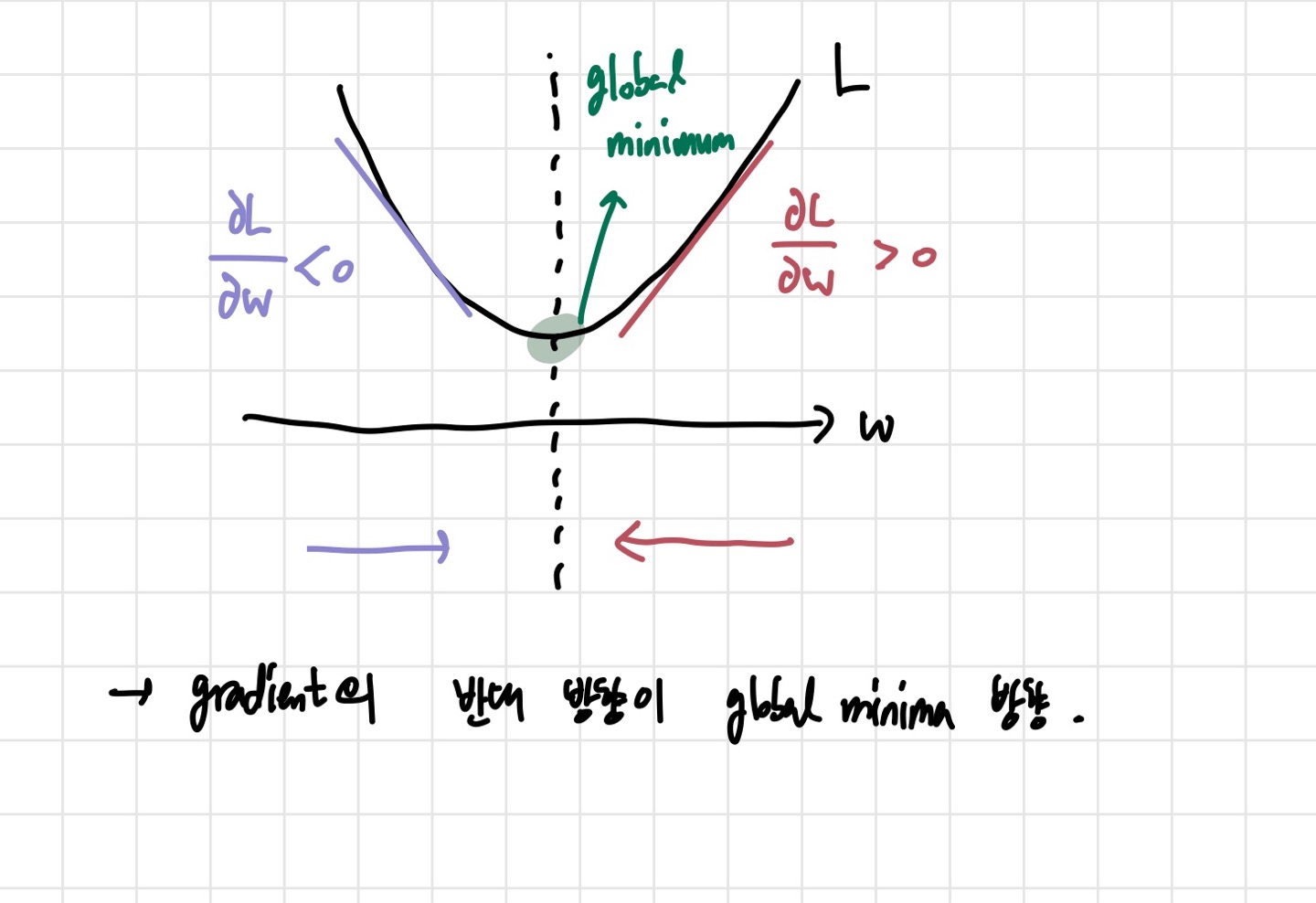

5.SGD vs GD vs Mini batch SGD

이번 글은 SGD, GD, Mini batch SGD를 제대로 정리하기 위해 쓴다. 굉장히 자주 나오는데 머리 속에서 정리가 제대로 안돼서 개념을 한 번 짚고 넘어가야 할 것 같다.일단, SGD는 Stochastic Gradient Descent, GD는 Gradi

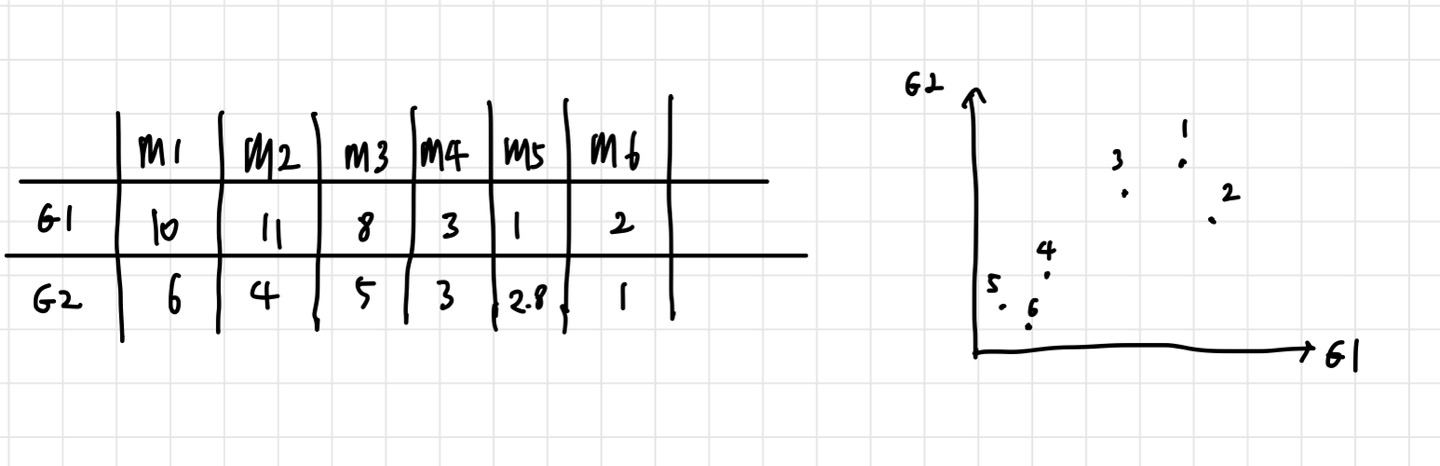

6.PCA(Principal Component Analysis)

이번 글은 PCA(주성분 분석)을 다뤄보려고 한다. 선형대수에 나오는 개념이라고 하는데, 우리 학교 수업에서는 다루지 않아 아주 안타깝다. 인공지능 공부를 하다보면 많이 쓰인다고 하진 않지만, 머신러닝 쪽에서는 많이 쓰이는 것 같아 정리할 필요성을 느꼈다. PCA

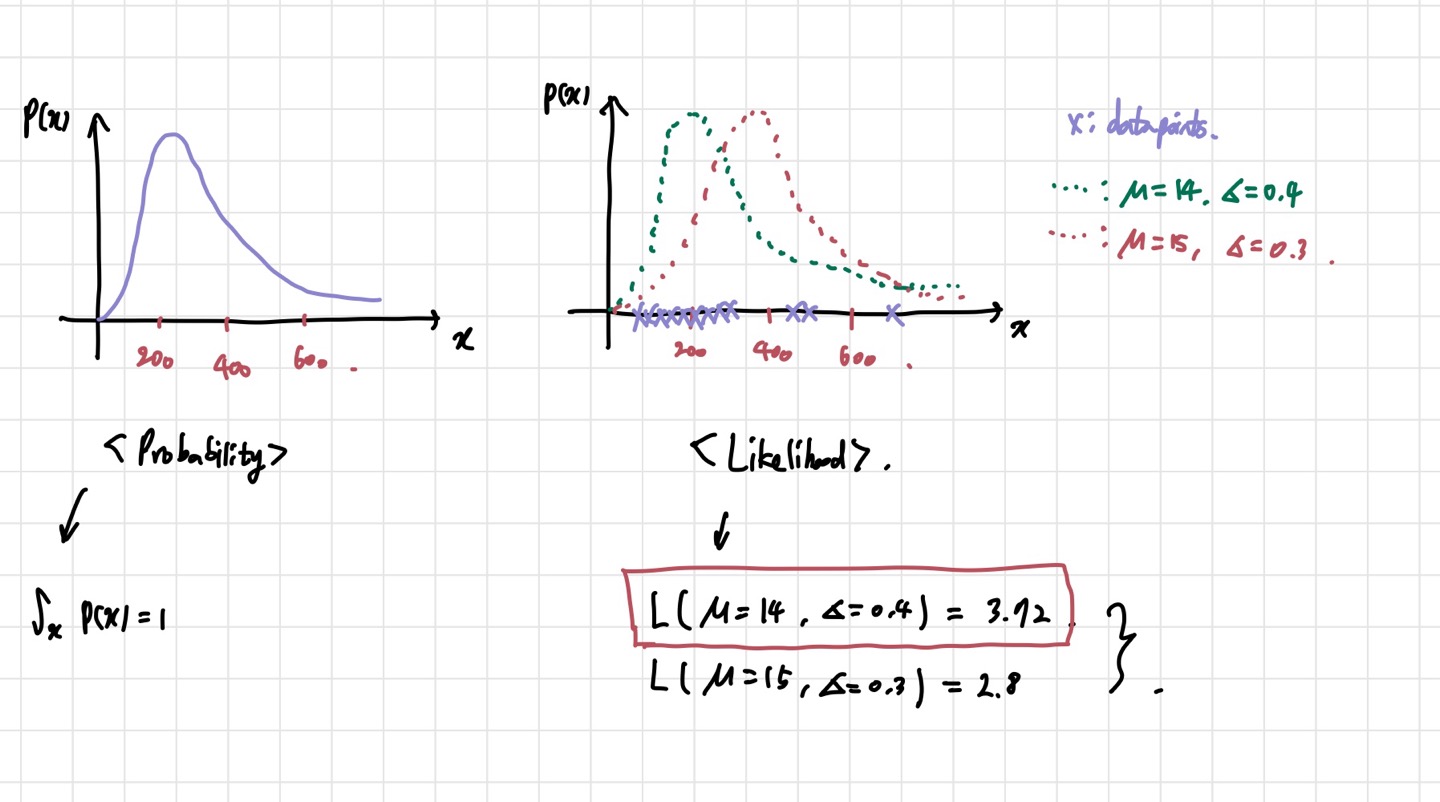

7.Likelihood/ MLE

cs231n 3강을 복습하며 정리할 마지막 글이다. 정확히 아는게 없어서 현타가 온다...ㅋㅋㅋㅋㅋ 하여튼 이번에 정리할 개념은 우도. 최대우도법이다. 영어로는 Likelihood, MLE(Maximum Likelihood Estimation)이다. 가장 헷갈리고