[NLP]

1.[NLP] NLP 소개

NLP(자연어 처리) : 인공지능의 한 분야로써 사람의 언어를 컴퓨터가 알아듣도록 처리하는 인터페이스 최종 목표 : 컴퓨터가 사람의 언어를 이해하고 여러가지 문제를 수행할 수 있도록 하는 것 대표적인 task : \-Sentimental Analysis (감성

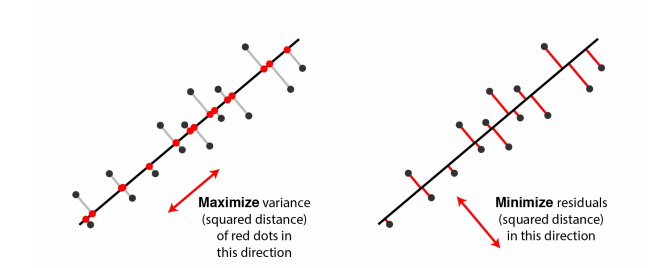

2.[NLP] Word Embedding

자연어처리에서는 각 단어가 갖는 의미가 서로 연관성이 있을 때도 있지만, 형태가 다른 경우 겉으로 보이는 형태만으로는 파악하기 어렵다. 따라서, 단어나 문장, 문서 전체를 벡터로 나타내는 것은 불가피하다. 이러한 이유로 자연어를 벡터로 mapping 해주는 함수를 만드

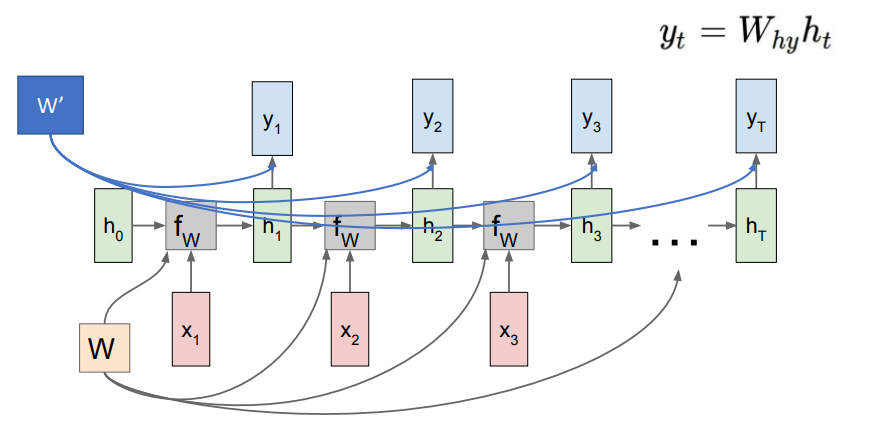

3.[NLP] RNN

Vanilla neural network 참조 [1] 김기현의 자연어 처리 딥러닝 캠프(파이토치 편)

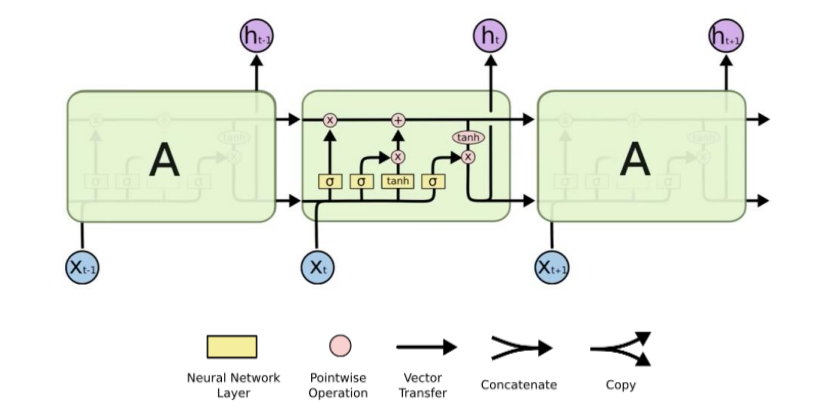

4.[NLP] LSTM

RNN은 time-step이 커지게 되면 gradient vanishing 문제가 발생한다. 이러한 단점을 보완하여 제시된 모델이 LSTM이다. 먼저, LSTM의 구조는 아래와 같다.LSTM 구조LSTM은 기존 RNN의 hidden state외에도 별도의 cell st

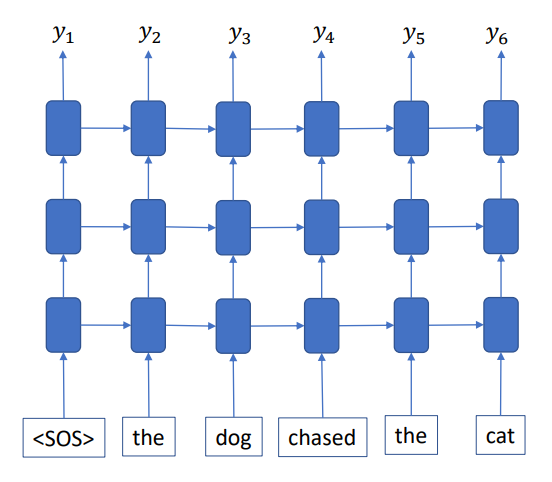

5.[NLP] Language Modeling

Language Modeling은 문장의 확률을 나타내는 모델이다. 즉, 언어 모델을 통해 문장의 출현 확률을 예측하거나, 이전 단어가 주어졌을 때 다음 단어를 예측할 수 있고, 결과적으로 주어진 문장이 얼마나 자연스럽고 유창한 표현인지 계산할 수 있다. 언어 모델을

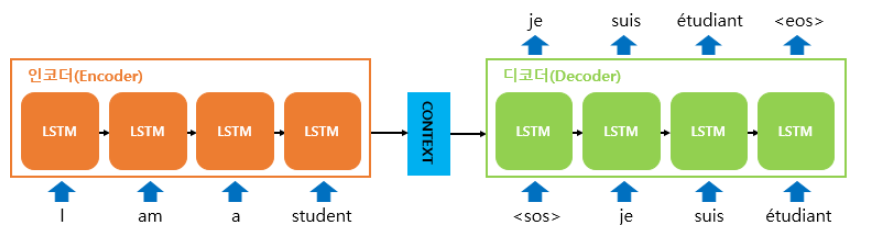

6.[NLP] Machine Translation

Translation(번역)의 궁극적 목표는 어떤 언어의 문장이 주어졌을 때, 가능한 언어의 번역 중에서 최대 확률을 갖는 언어의 번역을 찾아내는 것이다. Rule-Based Machine Translation(RBMT)는 주어진 문장의 구조를 분석하고, 규칙을 세우고

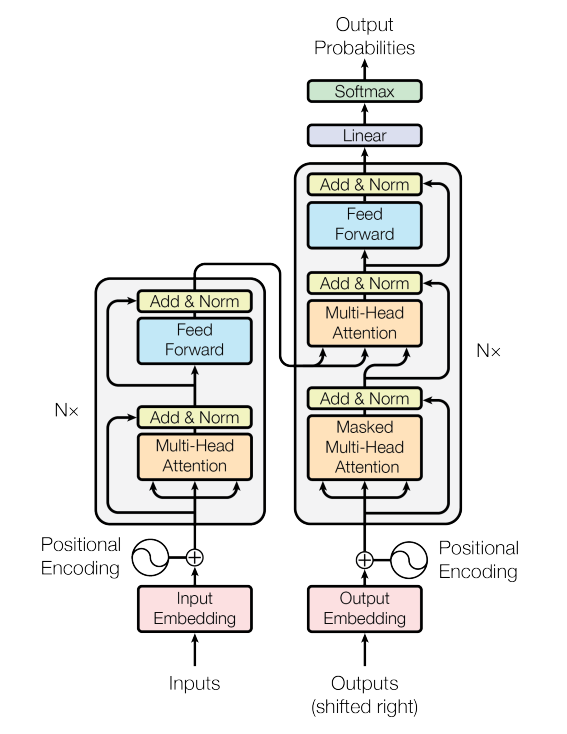

7.[NLP] Transformer

Transformer은 Google이 발표한 [Attention is all you need]에서 제시된 모델이다. 이 논문은 기존의 attention을 활용하여 seq2seq를 구현하면서 성능과 속도의 개선을 보였다. 먼저 transformer의 구조는 아래와 같다

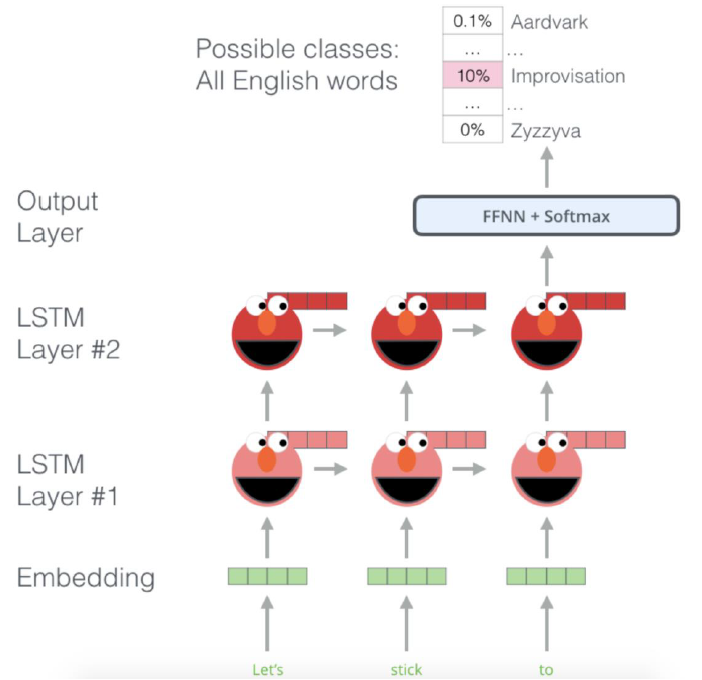

8.[NLP] Pre-trained Methods (ELMo, GPT, BERT)

2017년 transformer 논문이 게재된 후 다양한 pre-trained model들이 제시되었다. 그 중 이번 글에서는 대표적인 pre-training method인 ElMo, GPT, BERT를 짧게 소개하려고 한다. ELMo ELMo는