PaperReview

1.DeepAR Paper Review + DeepLearning Foundation

이번 블로그는 원래 ARIMA SARIMA를 올려야 하는데 논문 작성에 필요한 내용들을 다시한번 정리할겸 해서 순서를 조정하기로 했습니다 혹시나 ARIMA나 SARIMA의 내용을 알고 싶은 분들은 dsd0919@naver.com 으로 메일 주신다면 궁금하신 내용 공유하

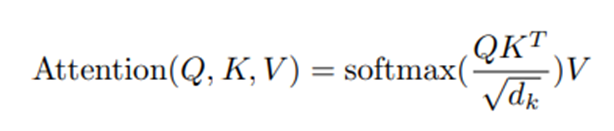

2.Transformer Paper Review

오늘은 Transformer Paper Review와 덧붙여 관련 얘기를 해볼 것이다. 우선 Transformer는 자연어 처리에 더욱 적합하게 탄생한 모델인 것 같다는 내 생각을 밝히면서 시작하겠다 논문에 Introduction에서 언어모델과 관련된 얘기를 하는 것으

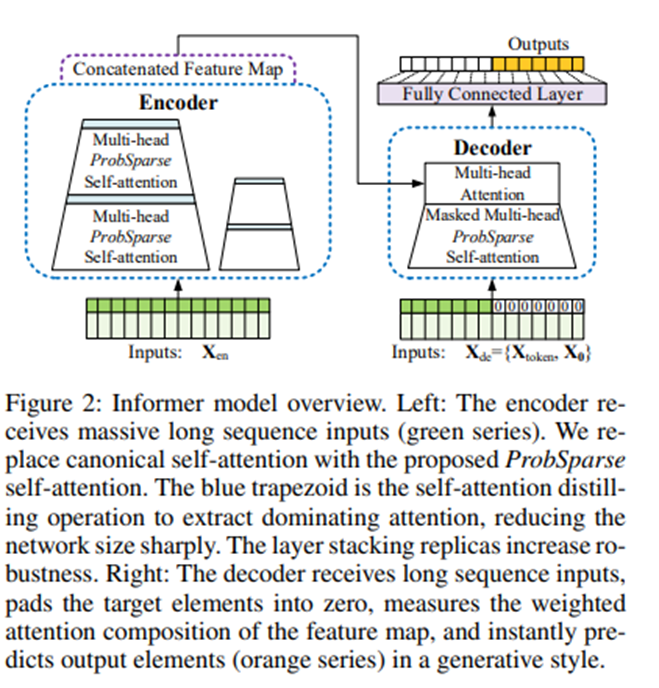

3.Informer: Beyond Efficient Transformer for Long Sequence Time-Series Forecasting

22년 11월에 읽었던 논문을 거의 1년이 지나가서야 블로그에 업로드 하게 됐다. 이미 word로 정리는 해뒀지만 때를 놓쳤다가 복습할겸해서 업로드를 한다. 이 논문 말고도 쌓여있는 논문이 너무 많다. Abstract Long Sequence Time-Series Fo

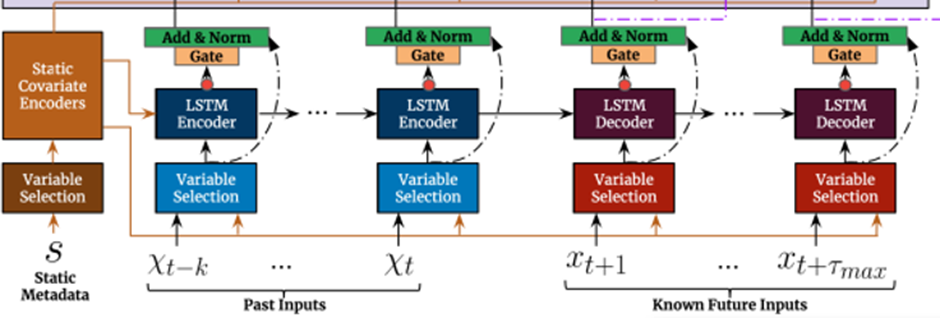

4.Temporal Fusion Transformers for Interpretable Multi-horizon Time Series Forecasting

Abstract Multi-Horizon Forecasting은 보통 정적인 변수, 알고 있는 미래의 input, 다양한 Covariates, 과거에 대해서만 관찰된 exogenous Time Series까지 이와 같이 다양한 Input들이 복잡하게 섞인 형태의 inp

5.Are Transformers Effective for Time Series Forecasting?

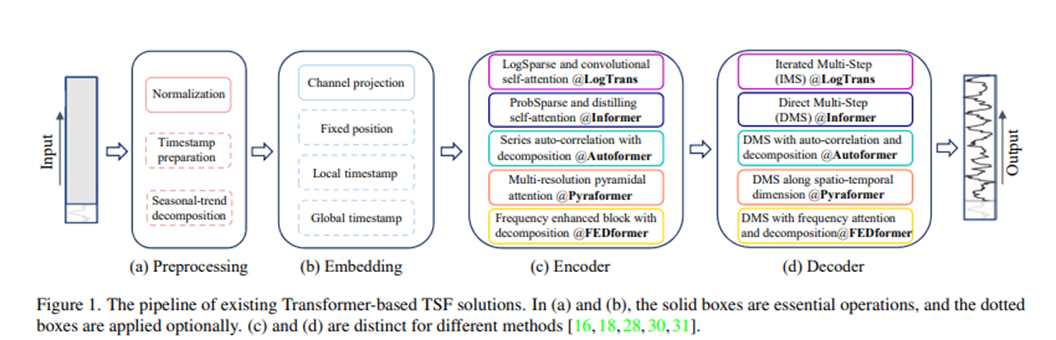

여태까지 했던 주제(Informer TFT)와 매우 상반되는 주제이다. 사실 이전까지 했던 Transformer 기반의 TimeSeriesForecasting은 Attention에 기반을 두면서, LSTF에 강점이 있었다.이번 포스팅에서는 이러한 기존의 Transfor

6.DeepLearning개요와DeepAR_[Updated]

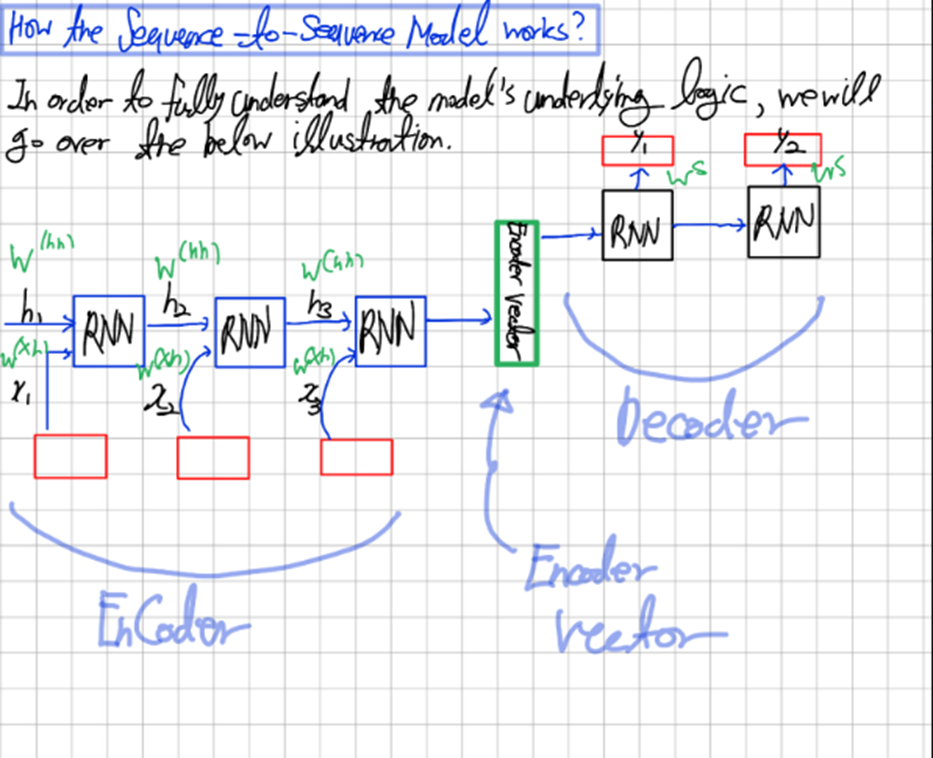

딥러닝 Basic딥러닝 학습과정활성화 함수목적함수Optimizer 와 Gradient DescentBackPropagation for matrix computing딥러닝 모델RNNTBPTTLSTMEncoder-Decoder구조Deep AR 논문 review다음과 같은

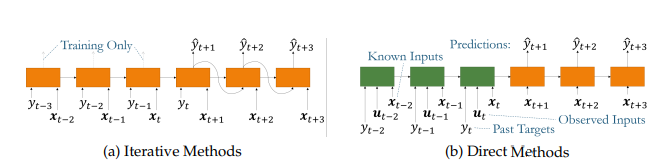

7.Iterative Method vs Direct Method

Iterative Method:이전 시간의 값을 재귀적으로 넣어서 시계열의 예측을 수행하는 것이다.따라서 이전의 모든 시간에 대한 정보가 필요하다.예를 들어서, t시점에서 f(t+h)를 예측하는데 f(t+h-1),f(t+h-2),..의 값들이 필요한 것을 말하고, “T